拒绝DNN过拟合,谷歌准确预测训练集与测试集泛化差异,还开源了数据集 | ICLR 2019

鱼羊 发自 凹非寺

量子位 报道 | 公众号 QbitAI

深度神经网络(DNN)如今已经无处不在,从下围棋到打星际,DNN已经渗透到图像识别、图像分割、机器翻译等各种领域,并且总是表现惊艳。

然而,深度神经网络到底是怎样工作的,至今仍困扰着广大研究者。

黑盒子总是让人诟病,为了让AI更好地服务于人类,更深入地理解AI是必要的。

谷歌AI的研究人员们正致力于此,他们在ICLR 2019的一篇论文中提出用边缘分布来预测深度神经网络的泛化间隙,以便更有原则地设计DNN。

边缘分布成泛化预测因子

想要理解泛化,就要了解一个重要的概念泛化间隙(generalization gap),即模型在训练集上的准确率与在测试集上的准确率之间的差异。

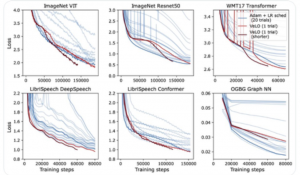

谷歌AI的研究者建议在网络层上使用归一化的边缘分布来预测泛化间隙。他们进行了实验统计,发现在对距离进行适当的归一化之后,边缘分布的一些基础统计可以准确地预测出模型的泛化间隙。

上面的三张图分别对应在CIFAR-10上训练过的三个卷积神经网络,它们的分类准确率分别是55%、71%和85%,从左到右,泛化能力越来越强。

y轴表示归一化边缘分布(x轴)在模型的4层网络中的概率密度,很显然,边缘分布和测试准确率具有很强的关联性。

这里他们采用了一个名为Deep Model Generalization(DEMOGEN)的数据集,这个数据集由756个训练过的深度模型组成,囊括了这些模型在CIFAR-10和CIFAR-100数据集上的训练及测试表现。数据集现已开源。

实验结果

如果边缘分布的统计数据真实地预测了泛化性能,那么简单的预测方案应该就能够建立起对应关系。于是研究者们选择了线性回归的方案。

研究者在CIFAR-10数据集上训练了216个九层卷积网络,测试集的准确率范围在60%-90.5%之间,泛化间隙在1%到35%之间。

作者表示,Bartlett在2017年发表的研究提供了目前最佳的深度网络泛化界限之一,将其作为基线方法进行对比,完整的20维特征空间的对数空间回归模型预测效果提升明显。

而在CIFAR-100数据集上,研究者训练了324个ResNet-32网络,测试准确率范围在12%-73%之间,泛化间隙范围在1%-75%之间。

在CIFAR-100+ResNet-32上预测的泛化间隙已经非常符合真实值了。泛化间隙和边缘分布的对数变换统计之间的关系几乎是完全线性的。

专家评价

对于这项研究,评审专家们褒贬不一,但他们大都承认把边缘分布引入深度学习框架是一个有趣的想法。

赞赏这项研究的专家认为这是一篇很好的实证论文,结论令人鼓舞:

这篇文章没有尝试提出另一个“空洞的”泛化界限,而是令人信服地说明了边缘统计和泛化间隙之间存在着有趣的联系,这对于帮助人们了解深层神经网络的泛化很有帮助。

但也有专家指出,这篇论文展示了丰富的实验结果,但却没有提供更多的理论验证。

OMT

论文一作是本科毕业于伯克利的谷歌AI程序猿Yiding Jiang。

论文合作者中还有和图灵奖得主Yoshua Bengio一起被誉为“AI兄弟”的Samy Bengio。

Yoshua Bengio同样开展过有关深度学习泛化问题的研究,他的团队提出了一个深度学习泛化保障方案(《Generalization in Deep Learning》),这篇ICLR 2019的论文里也引用了他们的文章。

传送门

Google AI博客:

https://ai.googleblog.com/2019/07/predicting-generalization-gap-in-deep.html

论文地址:

https://openreview.net/forum?id=HJlQfnCqKX

DEMOGEN数据集:

https://github.com/google-research/google-research/tree/master/demogen

— 完 —

- 那个用半成品刷爆SOTA的Qwen3超大杯推理版,现在正式上线2026-01-26

- “DeepSeek-V3基于我们的架构打造”,欧版OpenAI CEO逆天发言被喷了2026-01-26

- 斯坦福「返老还童」新研究:无需干细胞,逆转关节损伤和老化2026-01-25

- 微软谷歌正在大力招「电工」2026-01-16