只要你的AI算法能比小白鼠聪明,DeepMind的这20万奖金请拿走

贾浩楠 发自 凹非寺

量子位 报道 | 公众号 QbitAI

用你的AI算法和小白鼠一较高下,还能赢得3万美元(20万元)奖金。

稳赚?快别这么想。

实际情况是,机器学习算法一般都是在给定条件的任务中有较好的表现,但现实情况则要复杂很多。举例来说,一个老鼠在迷宫中或有遮挡的环境中寻找食物的表现要比一个AI好得多。

DeepMind就以动物认知测试为基础开发了一套强化学习任务集Animal-AI,用来供开发者测试自己的AI模型实用性。

前两天,Animal-AI2.0版本上线,并且在Github开源。

AI算法:我不如狗

游戏环境经常被用来评估AI的“能力”。

一般都是给定状态转移概率( state transferring probability)和奖励函数,在这样的条件下来测试模型表现。

那真实的世界真的是这样的吗?

当然不是,真实的世界要复杂地多,在面对复杂任务时,动物的表现往往优于AI。

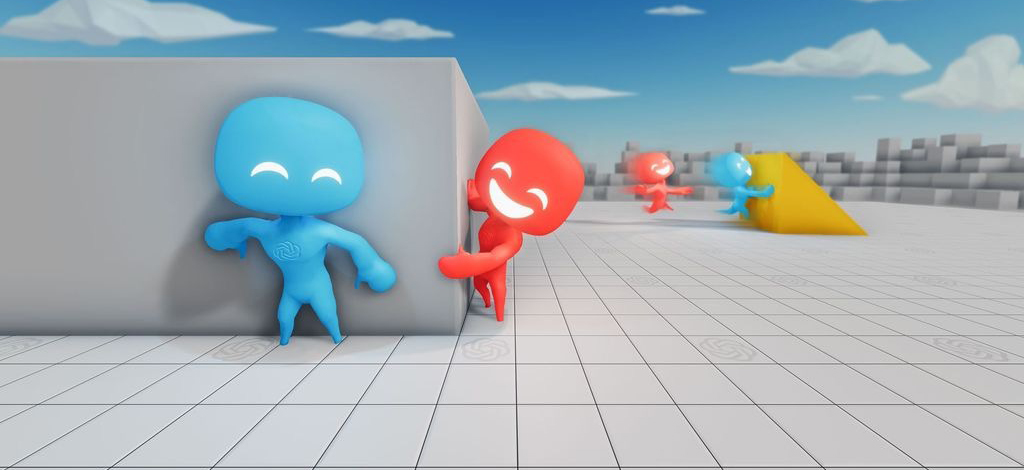

比如下图,简单的把食放在一个透明管中,狗能明白把头伸进管子里就能获得食物,而一个强化学习AI完全懵了。

DeepMind研究人员基于动物认知的研究开发了这个测试环境,旨在让强化学习算法的开发者,通过动物的行为模式中获得启发,改善算法性能。

这个项目包含了训练环境、训练库以及900个测试和/或训练任务。900个任务由浅入深,被分为不同的类别,以反映不同的认知能力。

该环境使用Unity ml-agent建立。其中包含一个固定大小的竞技场,和一个已经训练好的模型。

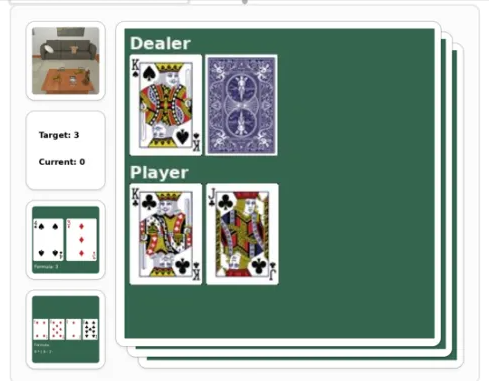

竞技场中包含各种物体,包括正负奖励(绿色、黄色和红色球体)、障碍物、雷区、不同的地形等。你的AI任务是在场地中收集正激励(黄绿球)。

安装教程

Animal-AI可以在Mac、Linux、Windows上运行,要求Python3。

首先安装必要运行环境,Github项目主页提供了不同系统的环境下载:

将安装包解压到examples/env文件夹下。Linux系统可能需要先运行一行代码:

chmod +x env/AnimalAI.x86_64Animal-AI包里面是一个Unity环境交互应用接口,包括一个gym环境、一个扩展Unity ml-agent环境。通过以下代码安装:

pip install animalai项目还提供一个可以用来训练模型的包,通过以下代码安装:

pip install animalai-train环境配置好以后,在examples路径下运行:

pip install -r requirements.txt启动jupyter notebook并运行environment和training。

测试实例

这里测试的算法是在2019年Animal-AI Olympic大赛中获得第一名的算法。

一个简单的寻找食物的任务:

更进一步,在一个有静止负激励的复杂环境中寻找食物,AI面对复杂环境时直接卡死在场地右下角:

让红色的球(负面激励)动起来,AI需要在动态环境中寻找食物:

再增加难度,使环境更复杂,可以看到AI直接卡死在角落里了:

一个Y型迷宫:

工具使用(这个任务中,AI必须使用跷跷板才能收集到食物):

这种复杂的任务绝大部分AI都无法完成,不是围绕红区直至时间耗尽,就是直接卡死在墙角。

可以看到,低等级的动物行为测试任务,一般的AI都能完成,而稍微加大难度,AI就会「无所适从」,直接卡死,这一系列任务让不少满怀信心的AI开发者铩羽而归。

项目的开发者发起了Animal-AI Olympics,征集全世界的强化学习AI才挑战这些任务,奖金高达3万美元,2019年的比赛已经结束。

可以看到,第一名平均分也只有43.7,在复杂决策,比如避障、因果推理等项目上得分都很低。

组织者还计划在2021年举行第二届大赛,你是否准备好用自己的强化学习算法去赢取这3万美元了呢?

传送门

项目地址:https://github.com/beyretb/AnimalAI-Olympics

Animal-AI Olympics比赛详细信息:http://animalaiolympics.com/AAI/2019

- 11.77亿资本押注卡车新势力一哥,L2升维路线率先在商用车跑通!2026-01-27

- 黄仁勋预言落地,物理AI开年第一枪竟是中国公司打响2026-01-28

- 轻舟智航重回高端局: L2+量产超百万,城市NOA量产下放10万级2026-01-23

- 一只大头机器狗供不应求,打响了消费级具身智能第一枪2025-12-26