AlphaZero黑箱终于被打开!登顶5年后,人类揭开它学会下棋的奥秘

科学家敲开了它的脑壳看了看。

詹士 发自 凹非寺

量子位 | 公众号 QbitAI

AI如何学到知识的?科学家敲开了它的脑壳看了看。

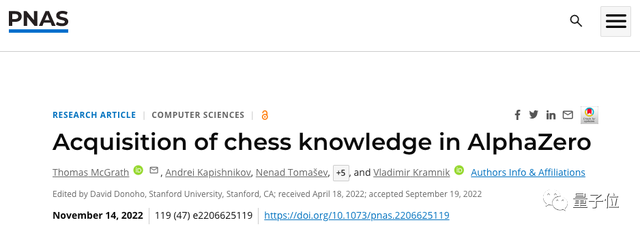

这两天,DeepMind及谷歌大脑一篇文章被《美国国家科学院院刊》(PNAS)收录,其内容正是以5年前发布的AlphaZero为例,研究神经网络如何获取并理解国际象棋知识。

在内容中,研究者重点关注了「神经网络是如何学习的」「知识又如何被量化表示」等问题。

有意思的是,他们发现:

在没有人类对弈指导下,AlphaZero仍形成了一套类似专业棋手才懂的概念体系。研究者还进一步探寻了这些概念何时何处形成。

此外,他们还对比了AlphaZero与人类开局棋风的不同。

有网友感慨,这是个影响深远的工作:

也有人感慨,AlphaZero能计算任何人类行为特征了?!

欲知更多观察结果,往下看。

掀起了神经网络的头盖骨

AlphaZero于2017年由DeepMind发布并一鸣惊人。

这是一种神经网络驱动的强化学习器,专精于棋类,内部包含了残差网络(ResNet)骨干网及分离的策略及价值heads。

其输出函数可表示如下,z为国际象棋排布情况:

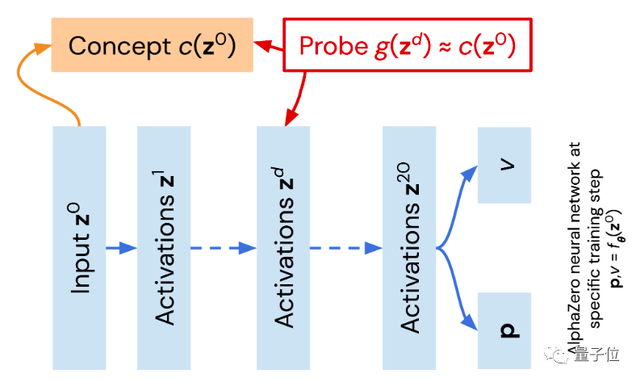

为研究AlphaZero如何「学习」的,研究者构建了一个人类理解国际象棋的函数c(z0)。其中,z0为一个象棋特定排布概念,c(z0)以专业国际象棋引擎Stockfish 8评估分数作为参考。

再从AlphaZero角度,设一个广义线性函数g(zd),作为在不同层取值的探针。训练设定下,g(zd)将不断趋近(0),研究者通过观察g(zd)与(0)近似情况,以确认系统是否理解相关概念。

接着,研究团队随机抽取了10万盘游戏作为训练集,观察AlphaZero表现。

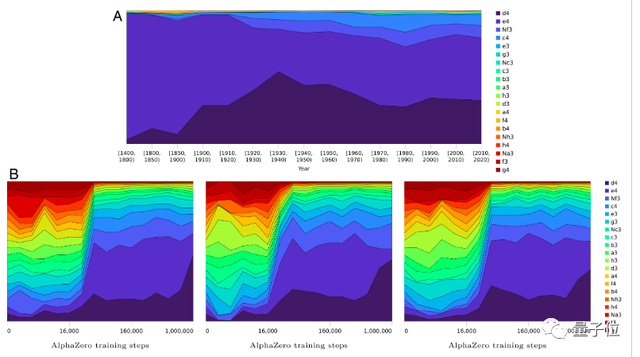

情况如下图,结果显示,随着训练步数(step)及ResNet网络块数(block)越来越多,AlphaZero表现出来的分数越来越高(图A),对弈过程中,每一步对敌方威胁性的也随之增加(图C)。

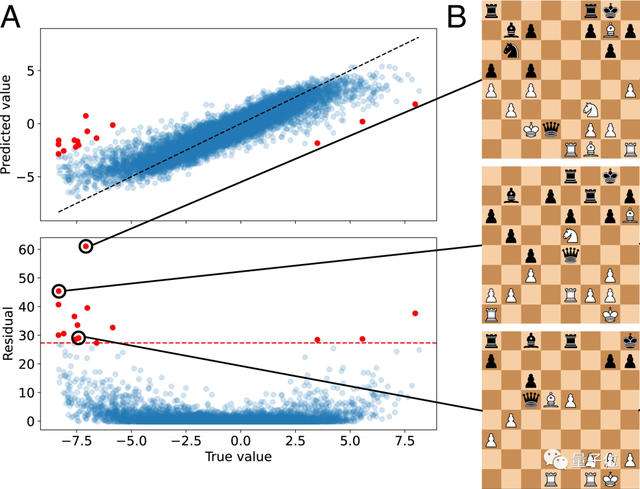

由于实验中出现了异常值,研究者探讨了其背后的潜在语义。

如下图,少数红色点位置远离主流分布,残差值也在红虚线之上,说明人类对棋局判断c函数与g函数有明显差异。

研究团队发现,这些值对应棋局中,人类判断为白方有利,同时,黑方皇后都能在兑子(exchange)过程中被进一步吃掉。

研究者推断认为,这是源于AlphaZero的Value Head与参考评价函数编码方式与参考系统的不同。

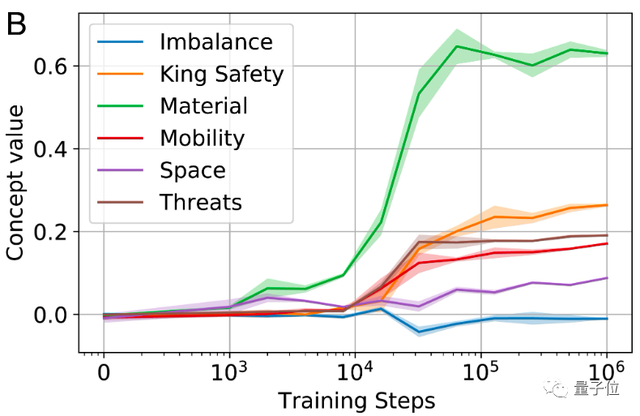

此外,研究者还观察了人类棋手及国际象棋编程所看重的重要参数,随训练过程的变化,其中包括:国王安全度(King Safety)、一方棋子总战力(Material)、机动性(Mobility)、走棋威胁性(Threats)等。

结果显示,它们在初始情况下几乎为零,但随着训练不断往下进行,以国王安全度(King Safety)、一方棋子总战力(Material)为代表,部分参数在模型中的权重明显上升。

这让研究者相信,通过训练过程,AlphaZero已经逐渐掌握了原本没有教给它的相关重要概念或者说知识。

最后,研究者还着重看了看开局演变与下棋风格,发现AlphaZero随时间推移,下棋路径选择范围在缩小,而人类下棋偏好和路径在变多。

科研人员表示,目前原因尚不清楚,但它反应了人与机器神经网络之间的根本差异。

关于后续研究方向,作者提出,下一步希望能探索AI模型能否超越人类的认知概念范围,去掌握学会新的东西。

团队介绍

本文一作Thomas McGrath 来自DeepMind,博士毕业于伦敦帝国学院,主要研究领域包括ML、人工智能安全及可解释性。

二作Andrei Kapishnikov,来自Google Brain,主攻人工智能应用领域,早前曾在VMware及Oracle从事技术工作。

值得一提的是,国际象棋大师Vladimir Kramnik也参与了该项目的研究。

参考链接:

[1]https://twitter.com/weballergy/status/1461281358324588544

[2]https://www.pnas.org/doi/10.1073/pnas.2206625119

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

- 大数据已死!从业10年老哥爆文抨击:这套唬不住客户了2023-02-14

- ChatGPT五分钟写完插件,功能完善,还可加需求改BUG2023-02-09

- 谷歌创始人亲自下场改代码,ChatGPT让谷歌真慌了2023-02-03

- 谷歌加紧测试ChatGPT竞品,靠对话可搜最新信息2023-02-02