MLPerf放榜!大模型时代算力领域“潜力股”浮出水面:梅开二度拿下世界第一,今年获双料冠军

用12nm战胜4nm

金磊 明敏 发自 凹非寺

量子位 | 公众号 QbitAI

后ChatGPT时代下的大模型“算力难”问题,“快、好、省”的解法,又来了一个。

就在今天,享有“AI界奥运会”之称的全球权威AI基准评测MLPerf Inference v3.0,公布了最新结果——

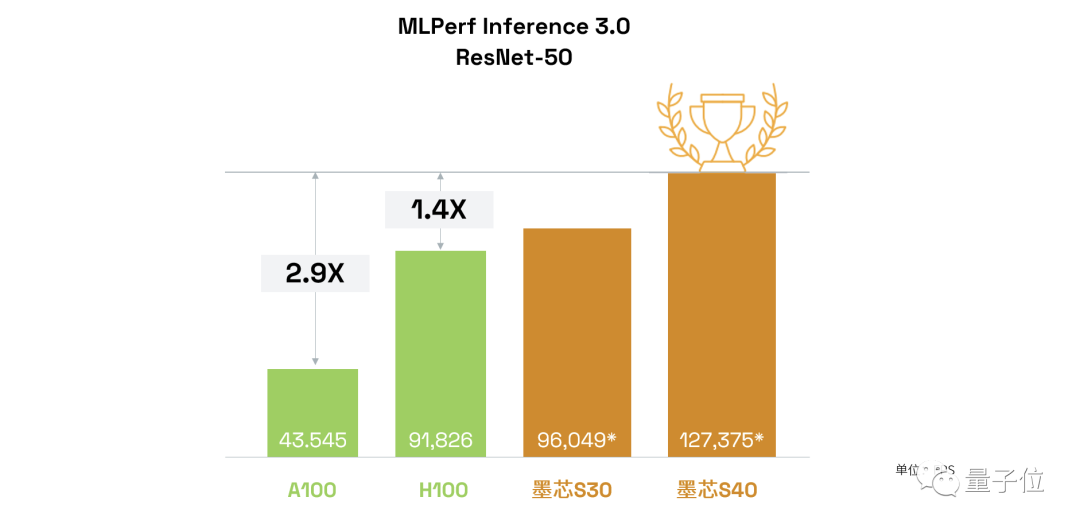

来自中国的AI芯片公司,墨芯人工智能(下文简称“墨芯”),在最激烈的ResNet50模型比拼中夺冠!

而且在此成绩背后,墨芯给大模型时代下的智能算力问题,提供了一个非常具有价值的方向——

它夺冠所凭借的稀疏计算,堪称是大模型时代最不容忽视的算力“潜力股”。

不仅如此,墨芯此次还是斩获了开放任务分区“双料冠军”的那种:

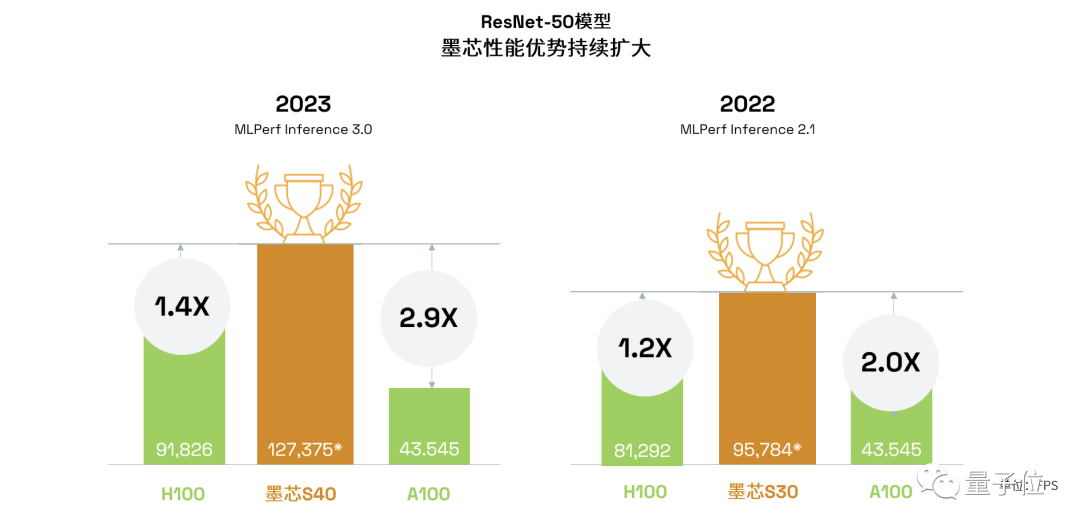

- 墨芯S40计算卡,以127,375 FPS,获得单卡算力全球第一;

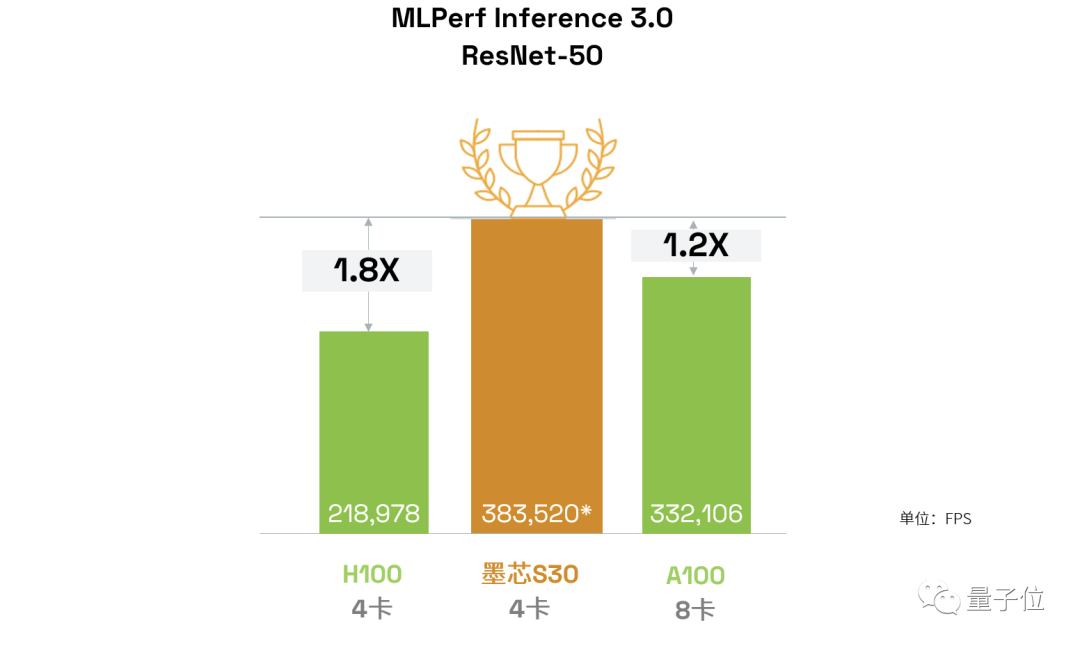

- 墨芯S30计算卡,以383,520 FPS算力,获整机4卡算力全球第一。

而且墨芯靠着这套打法,在制程方面更是用首颗稀疏计算芯片12nm的AntoumⓇ打败了4nm。

不得不提的是,这次对于墨芯而言,还是“梅开二度”;因为它在上一届MLPerf,凭借S30同样是拿下了冠军。

在与GPT-3参数相当的开源LLM——1760亿参数的BLOOM上,4张墨芯S30计算卡在仅采用中低倍稀疏率的情况下,就能实现25 tokens/s的内容生成速度,超过8张A100。

那么稀疏计算为什么对大模型有这般良效?

算力纪录再度被刷新

我们不妨先来看下,墨芯所刷新的纪录到底是怎样的一个水平。

以墨芯S40为例,在MLPerf数据中心的图像任务主流模型ResNet-50上,且在相同数据集、相同精度条件下,算力达127,375 FPS。

这个“分数”是老牌玩家英伟达H100、A100的1.4倍和2.9倍!

(△1、评测条件:MLPerf相同条件、数据集、精度;2、A100单卡算力数据选择近两届MLPerf最佳成绩;3、“*”代表稀疏等效算力。)

而墨芯S30计算卡,正如我们刚才提到的,获得了ResNet-50模型“整机4卡”冠军,其算力383,520 FPS;是英伟达H100的4卡成绩的1.8倍,并且超过英伟达A100的8卡成绩。

△1、评测条件:MLPerf相同模型、数据集、精度;2、“*”代表稀疏等效算力。

再从自身对比角度来看,墨芯S40计算卡比上届冠军S30计算卡的算力增幅达33%。

并且与上一次MLPerf相比,墨芯产品相较H100和A100的算力优势分别扩大了20%和90%。

(△1、评测条件:MLPerf相同条件、数据集、精度;2、A100单卡算力数据选择近两届MLPerf最佳成绩;3、“*”代表稀疏等效算力。)

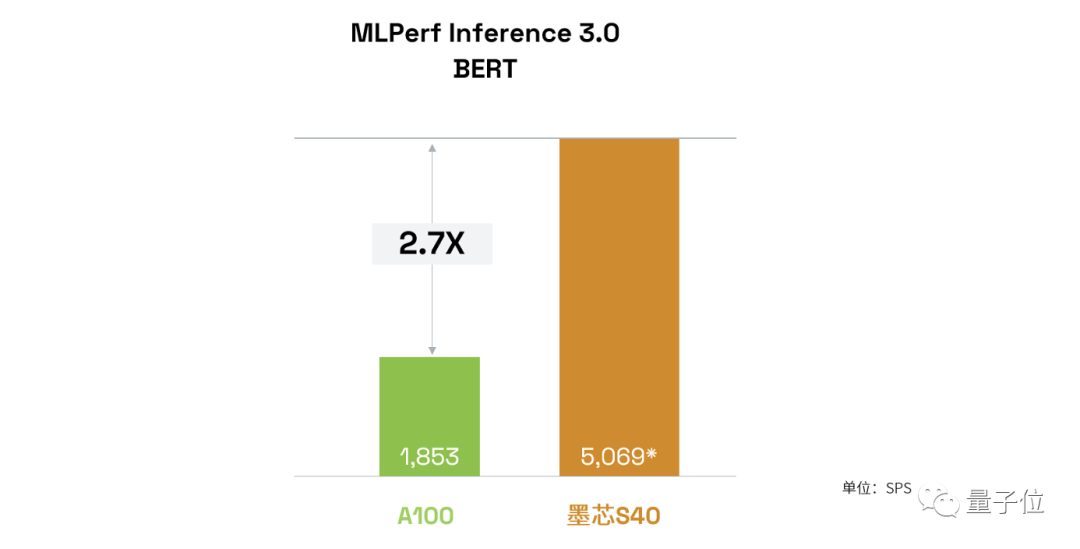

在NLP模型BERT上,墨芯S40计算卡算力5,069 SPS达到英伟达提交的A100算力的2.7倍。

△1、评测条件:MLPerf相同模型、数据集、精度;2、“*”代表稀疏等效算力。

更重要的一点是,随着AIGC的大爆发,加速推理速度、可以在线实时交互,成为了亟待解决的需求,而这也是大模型落地的一大痛点。

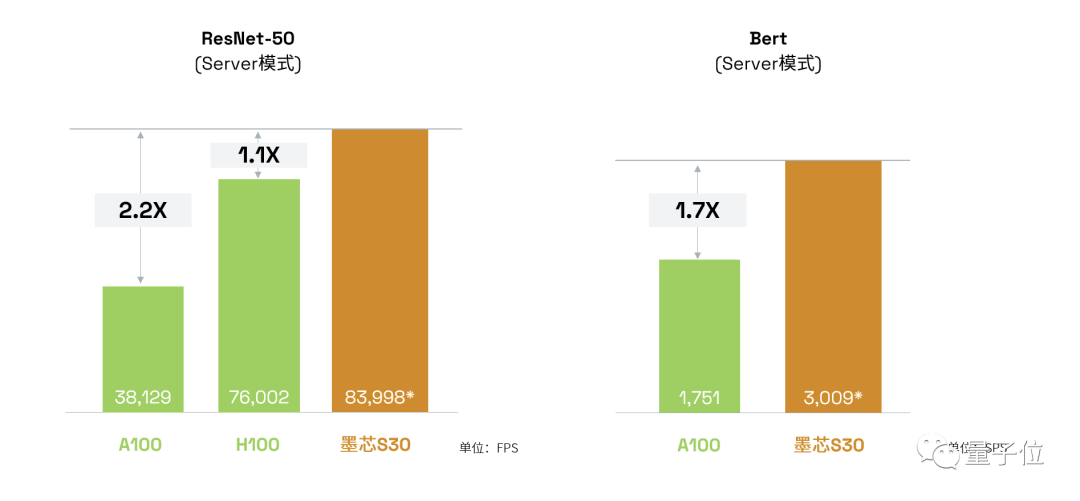

而在本次MLPerf中,墨芯S30与S10计算卡在离线(Offline)与在线(Server)两种模式下,均展现出了优异的表现。

△1、评测条件:MLPerf相同模型、数据集、精度;2、“*”代表稀疏等效算力。

这一点,便证明了稀疏计算是具备同时兼顾高吞吐、低延时的独特优势的。

为什么稀疏计算会成为正解?

简单理解,稀疏化就是一种聪明的数据处理和模型压缩方式,它让神经网络在计算时,能够仅启用所需的神经元。

而稀疏计算就是将原有AI计算的大量矩阵运算中,含有零元素或无效元素的部分剔除,以加快计算速度,由此也能进一步降低模型训练成本。

自从Transformers掀起大模型浪潮后,稀疏计算也成为了大厂关注的重点方向。

2021年,谷歌研究和OpenAI就罕见合作论文《Sparse is Enough in Scaling Transformers》,力证稀疏计算能为大模型带来数十倍加速。

而更早以前,2017年OpenAI就发布了稀疏计算内核,实现了在同等计算开销的情况下,能计算更深的神经网络。

谷歌这几年也密集发布了稀疏计算方面的多项工作,包括Pathways、PaLM、MoE、GLaM等。

其中Pathways架构是稀疏计算领域的一项重要工作。谷歌在当初发布时将其称为“下一代人工智能架构”,其技术博客由谷歌大脑负责人Jeff Dean亲自操刀撰写。

由此可见谷歌对Pathways架构及稀疏计算的重视。

这篇博客中写道,当今的模型是稠密、低效的,Pathways能将它们变得稀疏、高效。

Pathways能做的事,就是实现训练一个模型,完成成千上万件事情。

其核心原理在于稀疏计算,即在执行任务时仅稀疏激活模型的特定部分,计算真正有用的元素。

并且在该架构发布没几天后,谷歌就跟进了稀疏计算领域的另一项重要工作:发布基于Pathways架构的5400亿参数大模型PaLM。

之后,谷歌还提出了首个多模态稀疏化模型LIMoE,它在降低模型计算量上的优势非常突出。

因为采用了稀疏计算,可以实现执行一次任务只调用模型中的一个子模型,那么这次任务的成本将会和标准Transformer差不多。比如LIMoE-H/14总共有5.6B参数,但是通过稀疏化,它只会使用每个token的675M参数。

就在今年ChatGPT大火后,稀疏化GPT方法也被提出,能够实现不降低模型效果的情况下,将大模型权重降低一半。

除了在算法架构方面以外,硬件计算侧对于稀疏化的关注也在提升。

比如英伟达就在其Ampere架构中首次支持2倍稀疏计算。

Ampere架构为英伟达A 100带来了第三代Tensor Core核心,使其可以充分利用网络权值下的细粒度稀疏化优势。

相较于稠密数学计算(dense math),能够在不牺牲深度学习矩阵乘法累加任务精度的情况下,将最大吞吐量提高了2倍。

以上大厂的动作,无疑都印证了稀疏计算会是大模型时代下AI计算的有效解之一。

由此也就不难理解,为什么墨芯会押中稀疏计算这一方向,并取得最新战绩。

一方面是很早洞察到了行业的发展趋势;另一方面也是自身快速准确做出了定位和判断。

墨芯创始人兼CEO王维表示,他们从2018、2019年就看到了稀疏计算给AI计算带来了数量级上的性能提升。

与此同时,Transformers开启了大模型时代,让AI从1.0时代步入2.0,推动了AI在应用场景、算力需求等方面的改变。

尤其是算力方面,王维认为已经产生了质变:

“小模型时代,用场景数据训练小模型,研发和部署周期短,对算力的需求主要是通用性、易用性。到了大模型时代,大模型主要基于Transformers模型架构,更追求计算速度和算力成本。”

而做稀疏计算,不只是墨芯一家想到了,前面提到英伟达也在推进这方面进展,不过王维表示,这对于GPU公司而言可能是“意外收获”,但如果专注稀疏计算的话,需要做的是十倍甚至百倍加速。

因此,墨芯选择的路线是从算法提升上升到软硬协同层面。

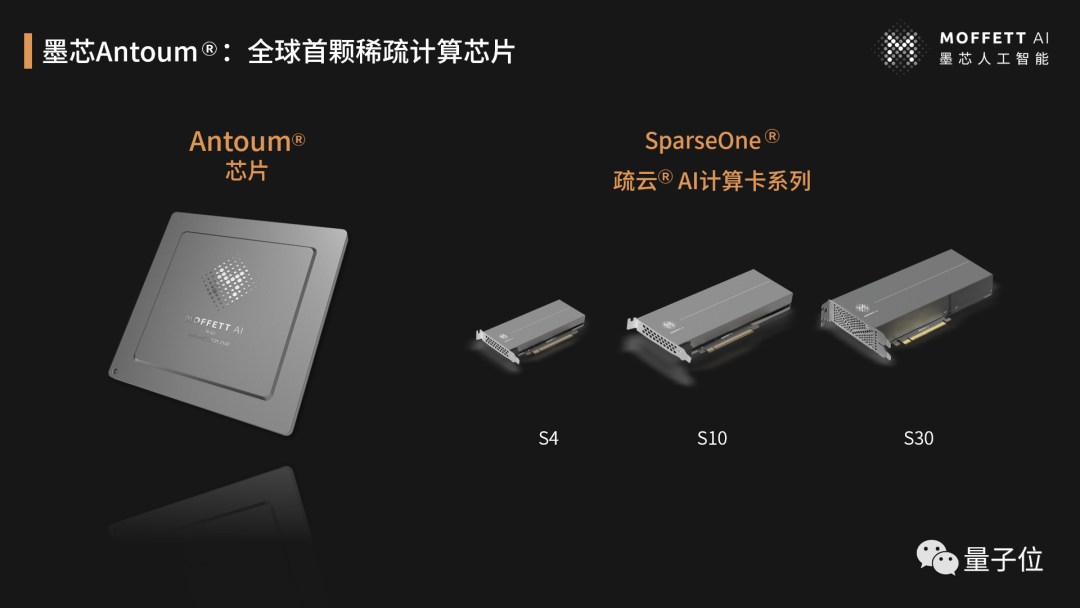

2022年,墨芯发布首颗高稀疏倍率芯片AntoumⓇ,能够支持32倍稀疏,大幅降低大模型所需的计算量。

墨芯在MLPerf中开放分区的提交结果刷新记录,也是对这一路线的进一步印证。

据透露,不仅在MLPerf上表现出色,墨芯的产品商业落地上也进展迅速。

墨芯AI计算卡发布数月就已实现量产,在互联网等领域成单落地。ChatGPT走红后墨芯也收到大量客户问询,了解稀疏计算在大模型上的算力优势与潜力。

如今,ChatGPT开启新一轮AI浪潮,大模型领域开启竞速赛、算力需求空前暴增。

如微软为训练ChatGPT打造了一台超算——由上万张英伟达A100芯片打造,甚至专门为此调整了服务器架构,只为给ChatGPT和新必应AI提供更好的算力。还在Azure的60多个数据中心部署了几十万张GPU,用于ChatGPT的推理。

毕竟,只有充足的算力支持,才能推动模型更快迭代升级。

怪不得行业内有声音说,这轮趋势,英伟达当属最大幕后赢家。

但与此同时,摩尔定律式微也是事实,单纯堆硬件已经无法满足当下算力需求,由此这也推动了算力行业迎来更新一轮机遇和变革。可以看到,近两年并行计算等加速方案愈发火热,这就是已经发生的变化。

而ChatGPT的火热,无疑加速了这一变革。在真实需求的推动下,算力领域硬件软件创新突破也会更快发生,模型会重新定义算法,算法会重新定义芯片。

你觉得呢?

- 这么哇塞的世界模型,竟然是开源的!2026-01-29

- 机器人看不清,蚂蚁给治好了2026-01-27

- 蚂蚁具身智能明牌了:做大脑,和宇树们错位竞争2026-01-28

- 曦望发布推理GPU S3:All-in推理的国产GPU,开始算单位Token成本2026-01-27