后GPT时代,多模态是最大的机会

“未来的通用人工智能一定是多模态智能。”

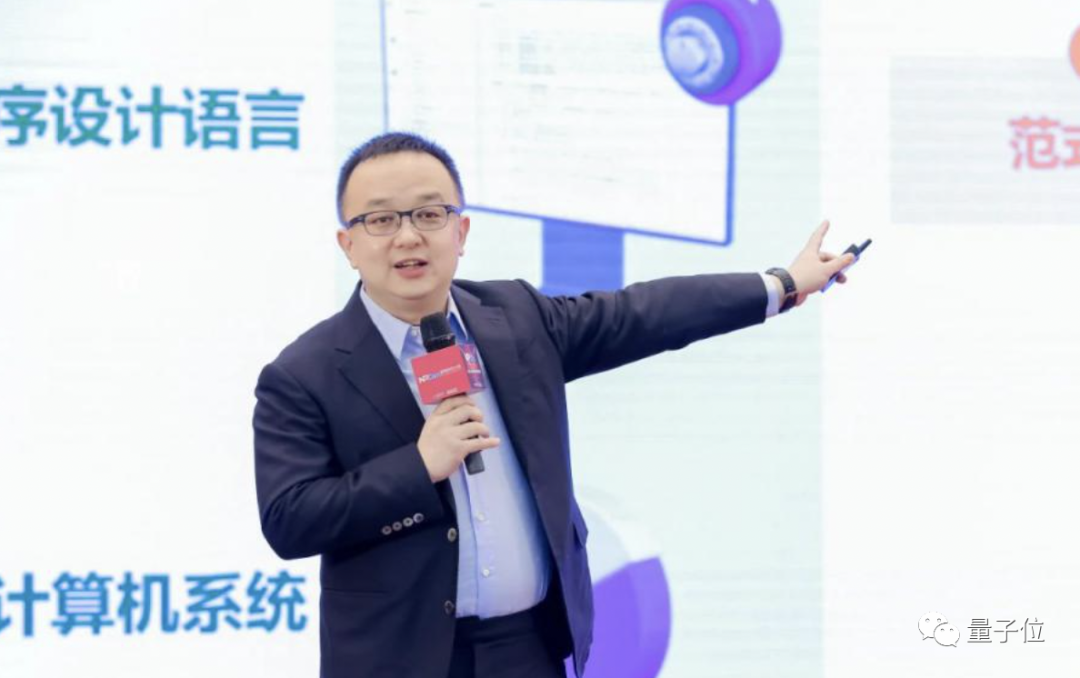

作者:王咏刚,SeedV实验室创始人/CEO,创新工场AI工程院执行院长

编者按:ChatGPT/GPT-4的横空出世,已经彻底改变了NLP领域的研究态势,并以其多模态的潜能,点燃了人们心中通往AGI的第一簇火花。

AI 2.0时代因此而至。但新时代的技术列车将通往何方?全新的商业机会又埋藏在何处?SeedV实验室创始人/CEO、创新工场AI工程院执行院长王咏刚认为:多模态算法正处在“寒武纪大爆发”的早期。

以下为王咏刚的笔记全文分享。

△王咏刚

我既是软件工程师,也是投资人和创业者。我曾参与多个成功AI项目的创建、孵化或投资。

今天,ChatGPT开启了崭新的AI 2.0时代,我个人也全力投入到一个3D+AI的全新创业历程中。在我的创业团队,大家最关心的AI核心技术是跨文本、图像、视频、3D、动画序列等信息的多模态AI。

此前一段时间,我将我们团队在这个领域的思考整理成多份笔记。本文是这些笔记的汇总和归纳。童超、潘昊等SeedV实验室成员直接为本文贡献了重要的技术实验、思考结论或参考信息,在此表示特别感谢。

目录

- 核心观点

- 大语言模型的“垄断”与“白菜化”

- 多模态AI的广阔天地

- 多模态技术处于大爆发早期

- 多模态AI为什么这么难

- 大语言模型本身的多模态能力

- 另一个“大力出奇迹”的结局?

- 多模态应用的创新“蓝海”

- 参考资料

核心观点

一、未来的通用智能一定是多模态智能;

二、GPT-4代表的大语言模型具备某些多模态潜能;

三、多模态算法正处在“寒武纪大爆发”的早期;

四、多模态算法很可能再次收敛到某种“大力出奇迹”的超级大模型;

五、多模态是大模型科研与工程领域最好的弯道超车机会;

六、GPT让AI平民化,应用开发者很难建立核心技术壁垒;

七、但在多模态领域,三至五年内仍有修建“技术护城河”的大量机会;

八、多模态领域的应用创新、模式创新机会远多于单模态领域。

大语言模型的“垄断”与“白菜化”

我做过很多年自然语言处理(NLP)相关的工程研发。不夸张地说,GPT终结了大多数独立存在的NLP上下游任务。不仅大量科研方向被GPT超越,无数自然语言生成、对话、交互相关的应用问题也一夜之间得以解决。

好消息是,人人都能用GPT API攒出点儿效果惊艳的应用产品,不懂编程的人还能雇佣AI帮忙编程序;坏消息是,NLP技术彻底失去了神秘感,所有应用开发团队的NLP水平被强行拉齐,大家可以拼产品、拼运营,但要在应用侧建立NLP相关的技术护城河,就显得特别困难了。

一方面,OpenAI的ChatGPT、GPT API、ChatGPT Plugin核心生态已初具规模,LangChain、AutoGPT、HuggingGPT等外围生态方兴未艾。未来无论中美,只要是面向消费者的,线上的,不需要私有部署或不涉及敏感数据的应用,大都可以直接连接大厂大模型。与搜索引擎时代的搜索和广告产品类似,这个领域必将是赢者通吃、大厂垄断的模式。中美市场里,大概各自有两三个超级AI大模型一起吃掉通用智能计算的全部份额。

另一方面,在企业级客户、政府客户那边,有体量巨大的私有部署、私域数据、敏感数据、定制开发等专有智能计算的需求。这些需求限于数据无法充分交换,不能用大厂大模型或通用方案解决。幸好,以LLaMA为发端,“羊驼家族”为流变,层出不穷的小模型(可以在终端设备甚至浏览器中运行)、中模型(数十亿到数百亿参数)、大模型(千亿参数或以上)以开源模式杀入市场。只要原始许可协议支持,开发者就能基于这些开源模型迅速完成定制、领域对齐和封装、部署,为企业或政府客户提供智能应用产品。

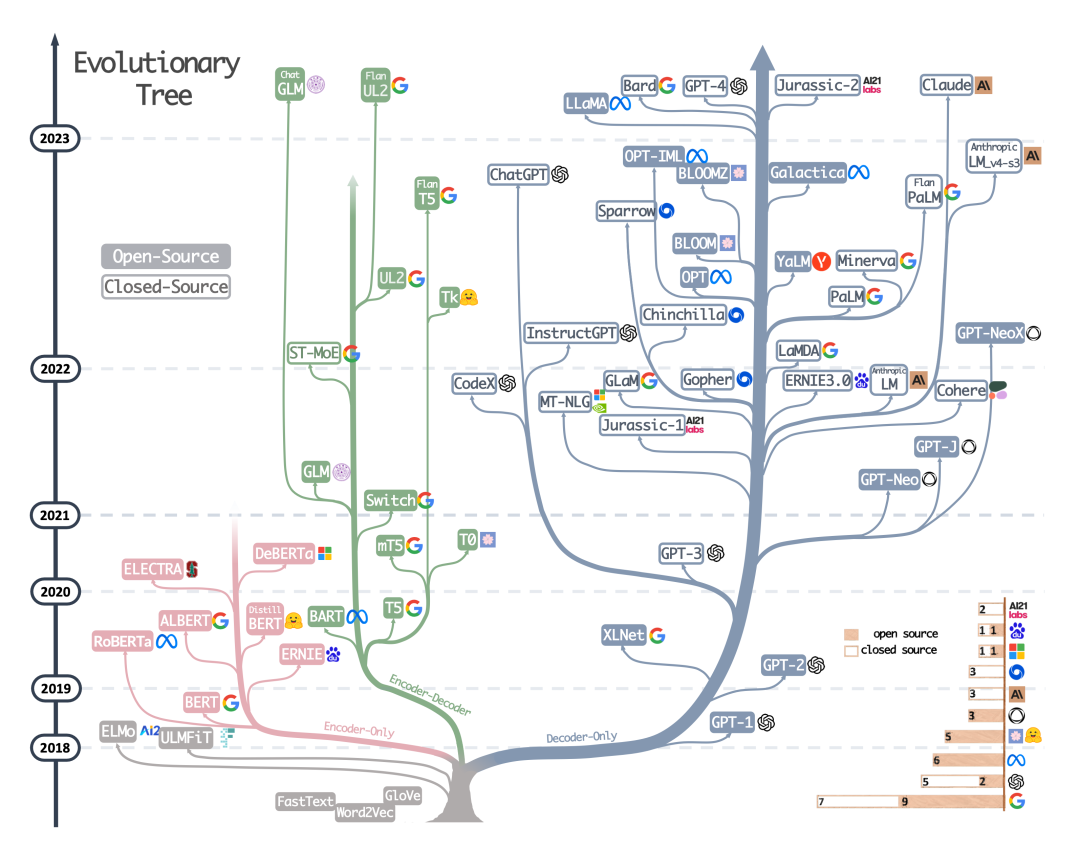

上图来自Yang, JF et al., Harnessing the Power of LLMs in Practice: A Survey on ChatGPT and Beyond。

态势很明显,在通用智能计算领域,垄断会是未来的基本形态;在专有智能计算领域,基于开源模型简单封装的解决方案将迅速实用化,并在开发和部署成本上实现“白菜价”。

大语言模型(还可以算上多模态领域里已经开源和普及的Stable Diffusion套装)会迅速像此前的人脸识别技术一样,发展为人人可用的“白菜化”解决方案。

大语言模型和相关技术仍在发展,但上述超级平台和开源生态齐头并进的态势在事实上消弭了AI产品之间的技术差异。除了少数几家超级平台类的产品公司和少量处在开源生态核心地位的技术公司外,其他所有科技公司、创业者都很难在大语言模型这个领域建立起真正意义上的“技术护城河”。对用户来说,新一代AI技术的平民化肯定是大好事。但对行业竞争的参与者来说,未来比拼的可能就不是技术,而是资源、平台、流量、模式、运营能力、产品迭代速度这些老生常谈的市场要素了。

当然了,信仰技术驱动型创新的创业者也不用失望;我觉得,三至五年内还有一片拼技术的蓝海可以供大家冲浪——与大语言模型相比,多模态AI在技术上远未收敛,无论在科研、工程还是应用层面,都是一片广阔天地,大有可为。

多模态AI的广阔天地

概念上,多模态AI指的是能够执行一种或多种跨模态/多模态任务的AI算法。典型的跨模态/多模态任务(科研上,“跨模态”与“多模态”有不同的内涵,本文不做详细说明)包括:

- 跨模态的生成任务,如文生图;

- 输出多模态信息的生成任务,如根据文字描述,自动输出混合了图、文、视频内容的展示文稿;

- 跨模态的理解任务,如自动为视频编配语义字幕;

- 跨模态的逻辑推理任务,如根据输入的几何图形,给出有关定理的文字证明;

- 多模态的逻辑推理任务,如请AI玩密室逃脱——这需要AI根据密室空间结构,文字信息,图片信息等推理出最优解决方案;

- ……

GPT-4展示出强大的通用问题解决能力后,为什么我们还需要在多模态领域进一步提升AI的认知效率?

其实,我们还没有弄清人类智能和机器智能之间的所有关联,甚至难以深入揭示二者的运行规律(可解释性)。不过,一些非常朴素的,形而上的经验认知,还是能帮助我们廓清大语言模型与多模态模型之间的互补关系:

- GPT-4的确拥有非常明显的初级AGI能力(参见微软Spark of AGI论文),而且,这部分初级的AGI能力是由GPT主要通过阅读和统计人类语言文字信息获取的;

- 另一方面,人类的生存环境和思考过程肯定是多模态的(图、文、声、光、电、影……);

- 即便在语言文字出现前,人类的祖先也能胜任不同类型的智慧任务——这应该是多模态学习或思考的功劳;

- 虽然语言文字这样的符号化系统可以间接存储其他模态的信息或知识,但,为什么计算机不能从其他模态数据中直接学习呢?

- 如果单纯依赖语言文字,AI真的能学到这个多模态世界的所有知识吗?

- ……

无疑,真正的AGI必须能像人类一样即时、高效、准确、符合逻辑地处理这个世界上所有模态的信息,完成各类跨模态或多模态任务。但通向这个终极目标的技术路径可能是多样的,或需要探索和尝试的。从结论上,我个人会倾向于:

- 未来真正的AGI必然是与人类相仿的,高效的多模态智能处理机;

- 单纯从语言文字中学习大概率无法获得完整的世界认知;

- 真正的AGI需要同时从所有模态信息中学习知识、经验、逻辑、方法。

GPT-4拥有初步的图像语义理解能力(参见GPT-4 Technical Report)。文生图模型Stable Diffusion与ControlNet,LoRA等条件控制和微调技术结合后,也能输出优异和可控的结果。不过,与我们真正需要的全部多模态能力相比,今天的GPT-4和Stable Diffustion在多模态能力上最多只是幼儿园水平。

试想,如果AI可以像人类一样通过视觉、听觉、嗅觉、味觉、触觉等多模态传感器收集并有效处理这个世界的各类信息,我们肯定不会满足于简单的文生图功能。假如多模态AI能尽早成熟,我特别愿意憧憬下面这些极具诱惑力的应用场景:

- 机器人仅凭视觉系统,对现场环境快速准确的还原。这里的“还原”包括但不限于精准的3D重建,光场重建,材质重建,运动参数重建等等。

- 上一条有关机器人的需求,如果换到自动驾驶领域,就必然意味着一部与人类司机拥有同等级别感知能力、判断能力,能够获得上路许可的新一代自动驾驶汽车。

- AI可以通过观察一只小狗的生活影像,像Pixar的艺术家那样为一只3D建模的玩具狗赋予动作、表情、体态、情感、性格甚至虚拟生命。

- 动画片导演用文字描述的拍摄思路,可以由AI解释和转换为场景设计、分镜设计、建模设计、光照设计、材质和渲染设计、动画设计、摄像机控制等一系列专业任务。

- 小朋友向AI描述自己幻想中的童趣世界,多模态AI利用虚拟现实技术帮助小朋友圆梦。

- 任何一个人都可以成为未来世界的游戏设计师。人类用户只需要笼统定义游戏场景、游戏角色和游戏规则,剩下的专业工作都可以交给未来的多模态AI。

- 多模态AI成熟后,聊天机器人可以迅速演变成能够在视频聊天里“察言观色”或用“肢体语言”来帮助自己提高表达能力的换代产品。

- AI程序有可能第一次具备与情感相关的功能属性——想象一个懂得眼泪的不同含义的AI助理;或者,想象一套深入理解人类情感的虚拟心理咨询师。

- AI有可能轻易掌握人类在艺术创作中常用的“通感”技巧:因为看见风起云涌的海岬,创作出节奏与情绪层层递进的高水准交响乐;因为欣赏白鹤的曼妙舞姿,创作出仙风道骨的飘逸舞蹈…

多模态技术处于大爆发早期

个人观点:今天多模态AI的技术进展状态,像极了2017年前后的NLP领域。

2017年是Google提出Transformer技术的时间,也是NLP科研领域百花齐放,多路径同时迭代,上下游任务各自突破的时代。在自然语言处理顶级学术会议ACL 2017年的论文列表(https://aclanthology.org/events/acl-2017/)中,我们可以找到那个时代科研人员最关心的技术话题。

2017年,文本分类、语义解析(Semantic Parsing)、向量编码、机器翻译、文本生成、阅读理解、知识问答、主题模型、方面提取(Aspect Extraction)等等上下游任务与Attention、RNN、CNN、Sequence-to-sequence、Sequence-to-Dependency等不同技术路线之间以各种方式排列组合,让人目不暇给。即便是进入了2018年的BERT时代,科研圈的很多人还是在反复争论到底哪一种路线才是通往“人工智能圣杯”的最优路径。

拿我自己来说,至少在GPT-3出现之前,我作为有多年NLP经验的工程师,是完全没有预料到AGI的曙光会离我们这么近的。

今天的多模态AI在科研领域几乎与2017年时的NLP科研一模一样,所有需要研究的上下游任务与所有可能的技术路线之间,正在上演各种形式的排列组合游戏。CVPR 2023年已接收的论文列表(https://cvpr2023.thecvf.com/Conferences/2023/AcceptedPapers)可以真实地反映出这种强烈的“拼接感”。

仅拿3D生成方面的研究为例,近两年所有text-to-3D,image-to-3D,video-to-3D以及更加基础一些的3D-representation方面的论文,绝大多数属于对不同技术模式的拼接、组合、尝试、探索。其中涉及的可拼接要素包括不同的3D表示方法,不同的多模态信息对齐和混合编码方式,不同的3D重建管线等等。

简单归纳一下,为了生成3D对象或场景,最基本的3D表示或编码方式可以从以下候选项中选择使用(包括组合使用多个选型;下列某些选项之间也存在互相覆盖的内涵):

- 三维网格(Mesh)

- 八叉树(Octree)

- 三维体元(Voxels,也称体素)

- 隐函数(Implicit Function)

- 点云(Point Cloud)

- 神经场(Neural Field),或神经辐射场(NeRF)

- 三平面(Tri-plane)

- ……

而整个生成算法或网络结构(Structure),则可以在以下几大技术脉络或他们的进一步组合、变化中尝试最优方案(下列选项之间并非严格并列关系,而是大家在3D生成模型中常用的技术手段;不同选项在生成网络中的地位并不都是可对应替换的):

- 生成对抗网络(GAN):GAN在2D图片生成领域完败给扩散模型(Diffusion Model),但在今天的3D生成科研中,GAN仍是热门候选技术之一;

- 变分自编码器(VAE):在生成类任务中经常与GAN相提并论,但较少作为独立的主干网络结构设计。可以在实际算法中演变成专用于特定模态的各类自编码器;

- 扩散模型(Diffusion Model):扩散模型在2D文生图任务中取得巨大成功,自然会被3D生成借鉴;这个方向上,还可以算上OpenAI新近提出并开源的一致性模型(Consistency Model);

- Transformer模型:在文本领域大放异彩,但在3D生成领域的使用还相对有限;

- 神经辐射场(NeRF):既可以把NeRF看成一种生成模型内部使用的3D表示或编码方法,也完全可以将其视作3D生成模型的一种典型框架设计(以NeRF表示为中介,围绕可微的3D函数做插值或反解);

- 参数化(Parameterization):AI模型或子模块的输出结果是另一个或多个成熟子系统的输入参数。参数化更多指的是一种技术模块之间的衔接思路,而不是一种网络架构设计;

- 基于对比学习的多模态预训练(CLIP):这通常也被视为一种模态之间、模块之间的连接思路。这项由OpenAI发明的图文混合训练技术已极其广泛地应用到各种不同模态的组合训练中。在多模态领域,无论如何重视CLIP的“连接”力量都不为过;任何多模态信息混合编码、对齐和训练的管线里,几乎都可以找到CLIP原始设计的影子。

- ……

举一些直观的例子吧(这里引述的论文仅用给出典型技术路线和模型架构的设计案例,既不是综述性质的列表,也不是基于论文价值的推荐):

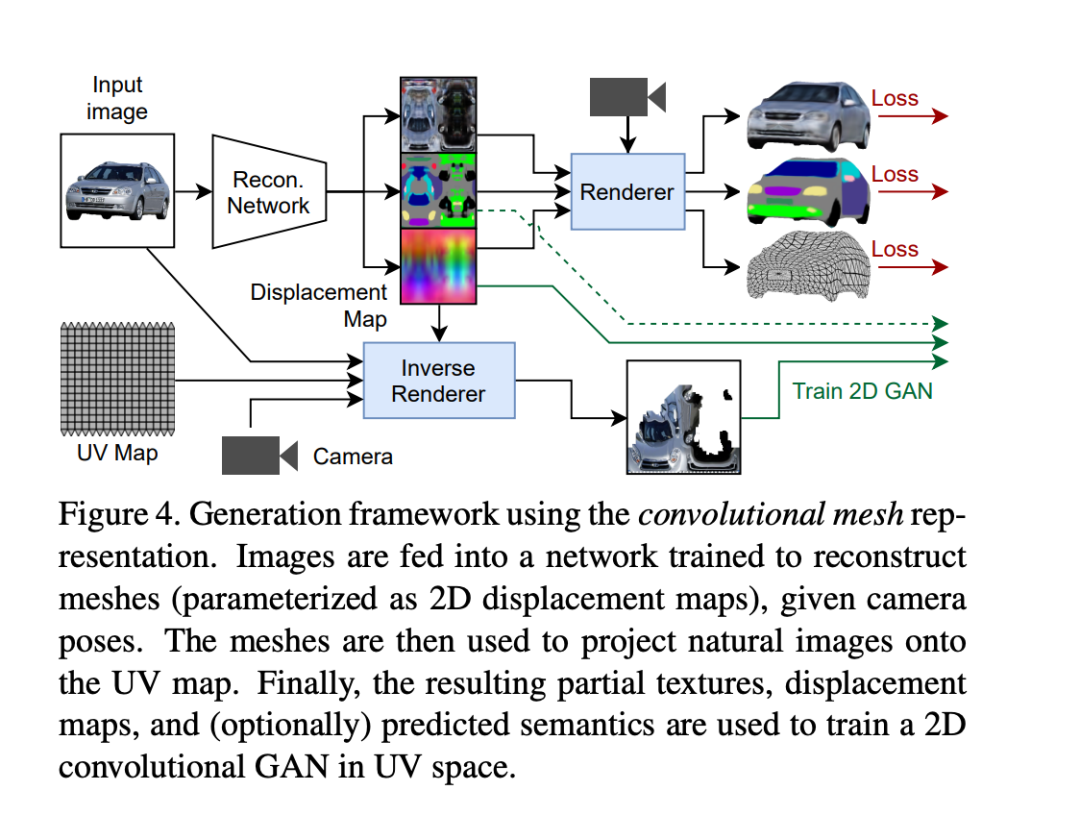

Textured-3d-GAN(https://arxiv.org/pdf/2103.15627.pdf)是典型的利用3D Mesh表示3D知识,使用GAN完成生成任务的算法设计。

输入图片与3D Mesh之间的关联,是基于3D管线里常用的UV映射,材质贴图(Texture),置换贴图(Displacement Map)等2D形式完成的——这个关联本身其实也是一种将3D建模参数化的设计范式。

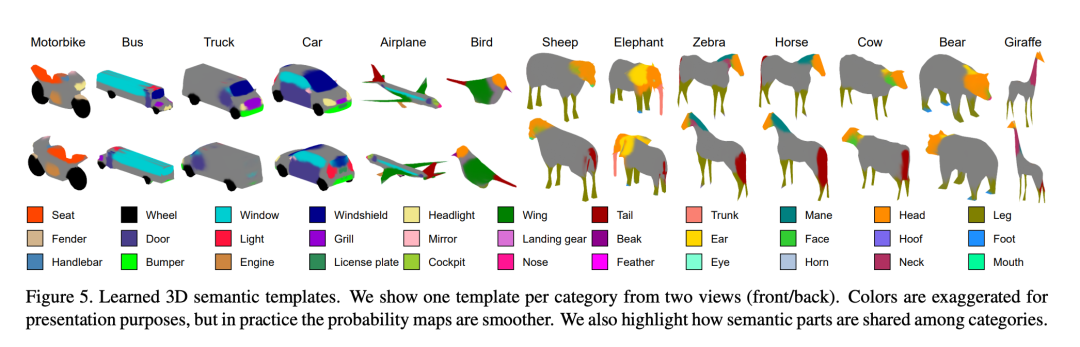

因为直接基于3D Mesh来编码多模态信息,Textured-3d-GAN容易得到直观的3D语义分割图示:

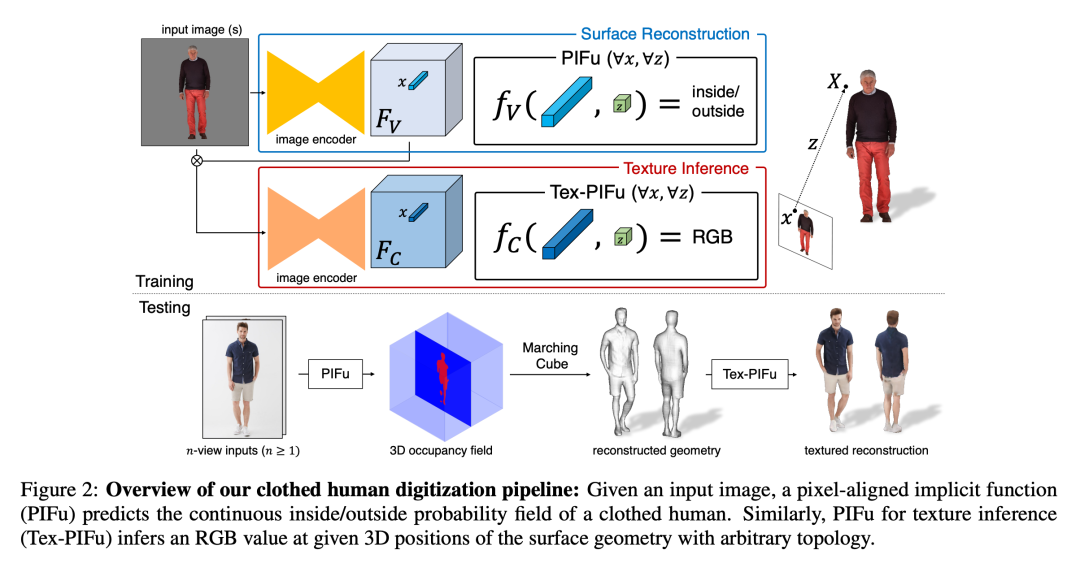

PIFuHD(https://arxiv.org/pdf/2004.00452.pdf)及其前身PIFu(https://arxiv.org/pdf/1905.05172.pdf)利用隐函数来表示生成过程里的3D空间知识:

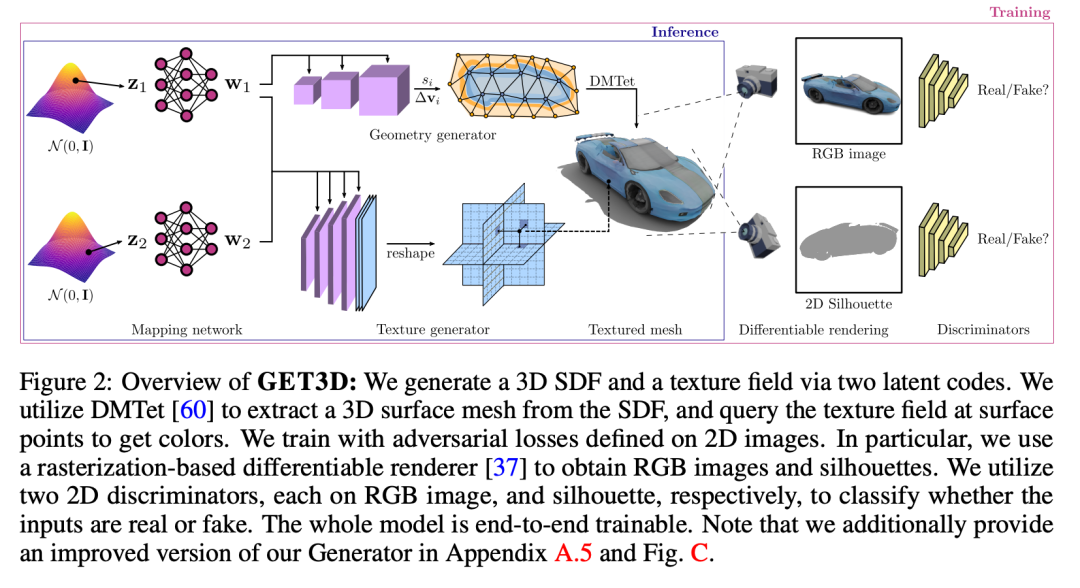

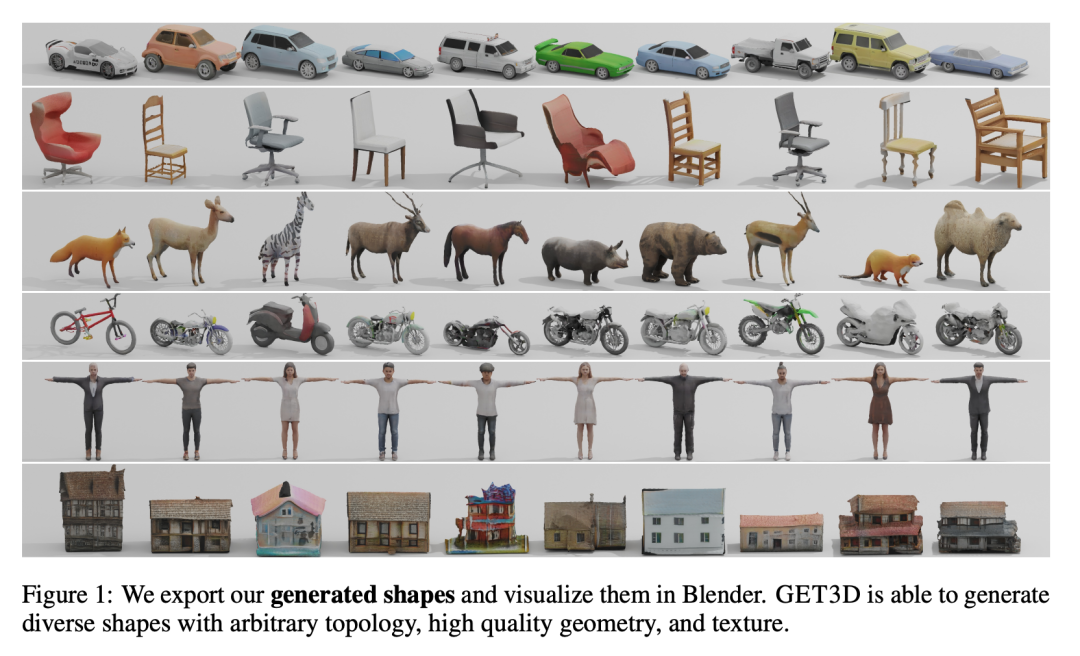

GET3D(https://nv-tlabs.github.io/GET3D/assets/paper.pdf)是Textured-3D-GAN设计思路的发展或升级。整体上仍使用GAN生成网络的基本结构。生成器内部利用3D知识,将被生成对象分成有向距离场(SDF)表示的3D结构,以及纹理贴图两条生成管线,并基于3D知识将二者关联在一起。

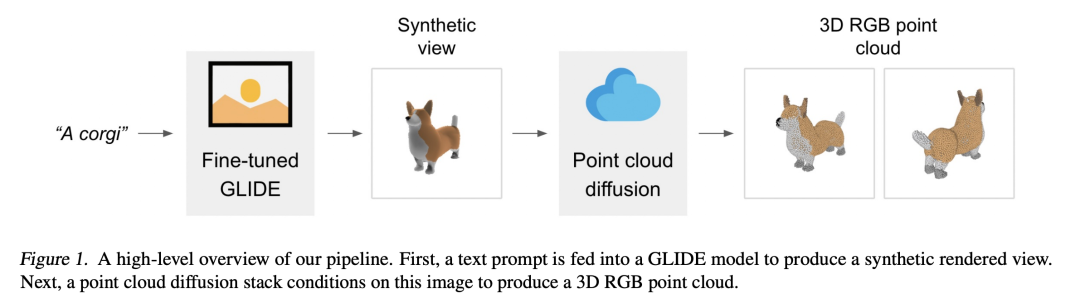

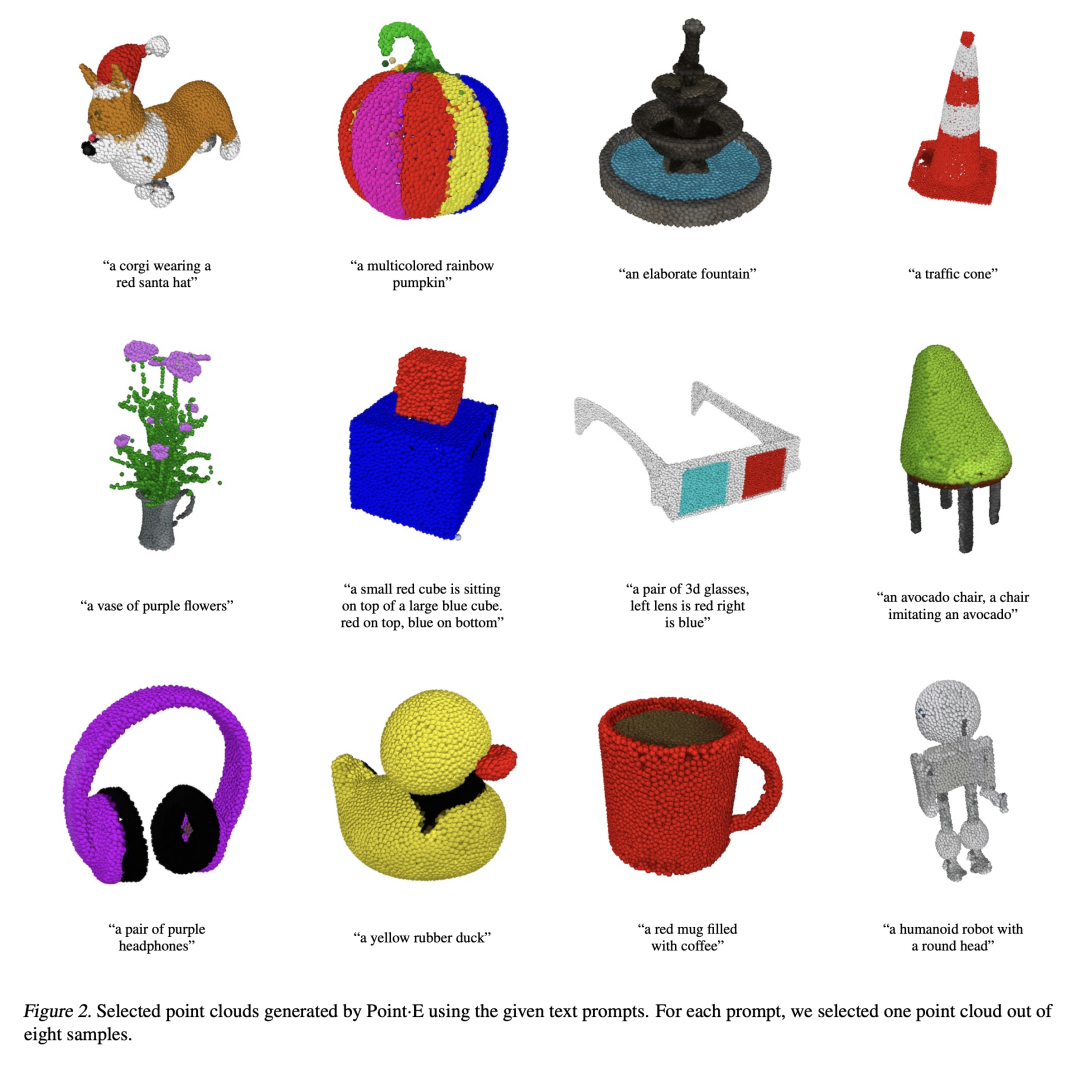

OpenAI的Point-E(https://arxiv.org/pdf/2212.08751.pdf)是点云和扩散模型的组合体;OpenAI擅长的CLIP预训练模型和Transformer模型也在整个网络结构中扮演了重要角色:

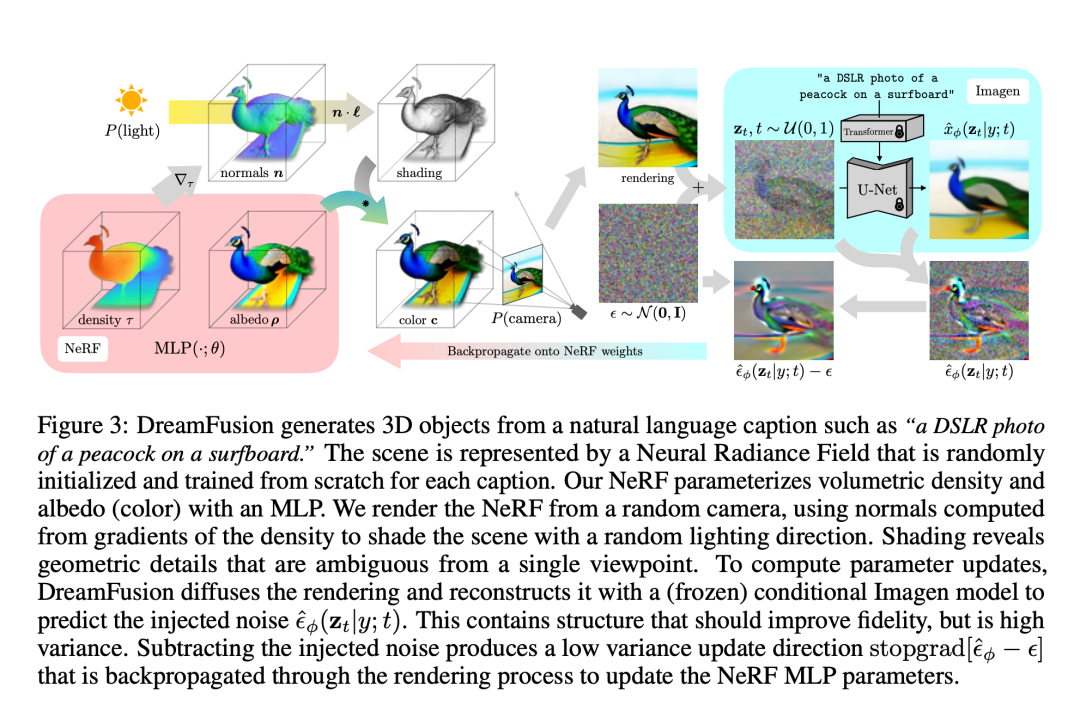

DreamFusion(https://arxiv.org/pdf/2209.14988.pdf)是NeRF方法在3D生成领域的代表算法,整体框架同样使用了扩散模型由随机噪音到目标对象的基本思路:

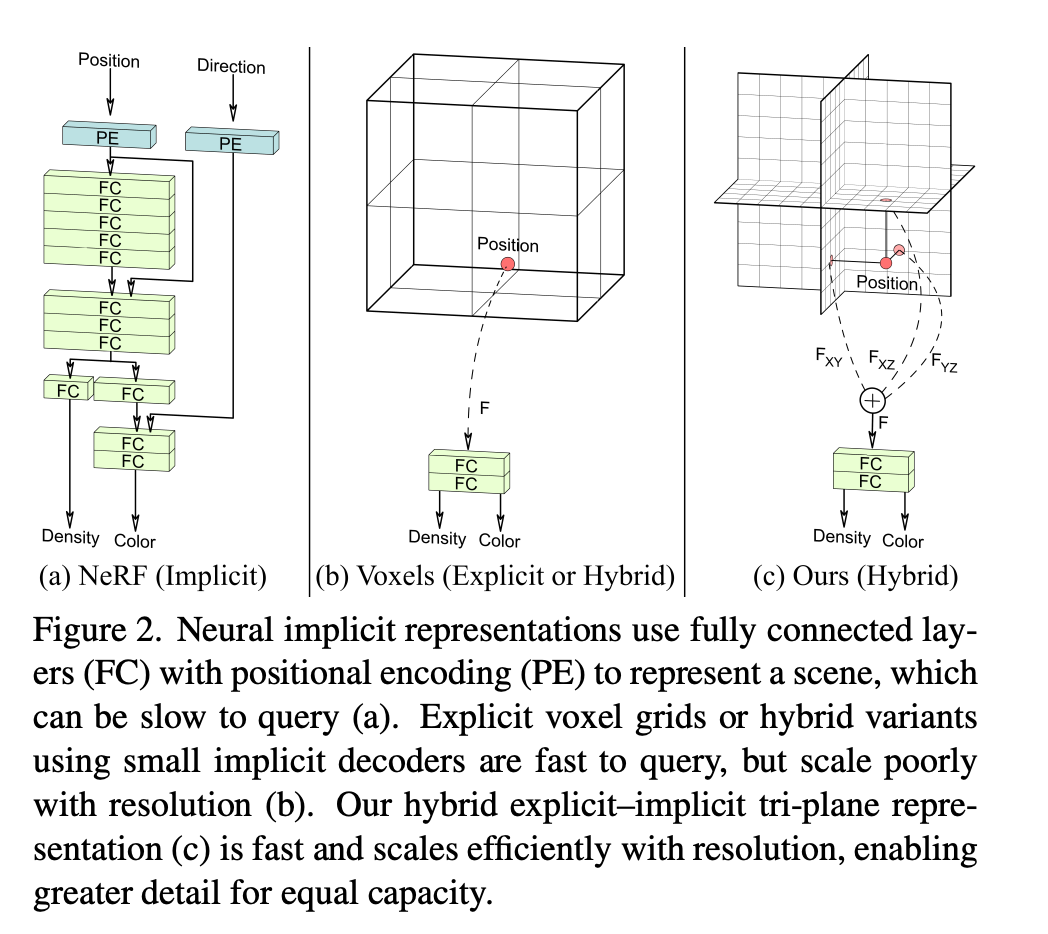

EG3D(https://nvlabs.github.io/eg3d/media/eg3d.pdf)在训练框架上选择了GAN,却在3D信息表示上,使用了有趣的三平面(Tri-plane)表示法:

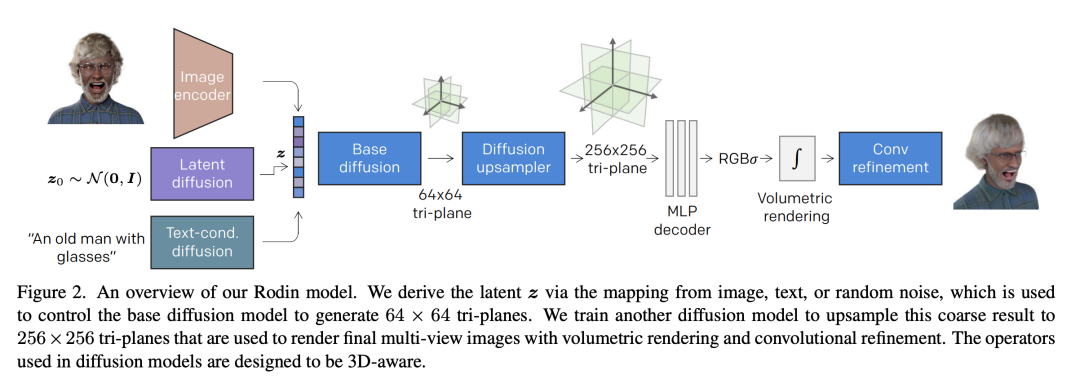

EG3D的三平面表示法直接启发了微软前些时发布的效果出众的虚拟人头部重建算法——Rodin(https://arxiv.org/pdf/2212.06135.pdf):

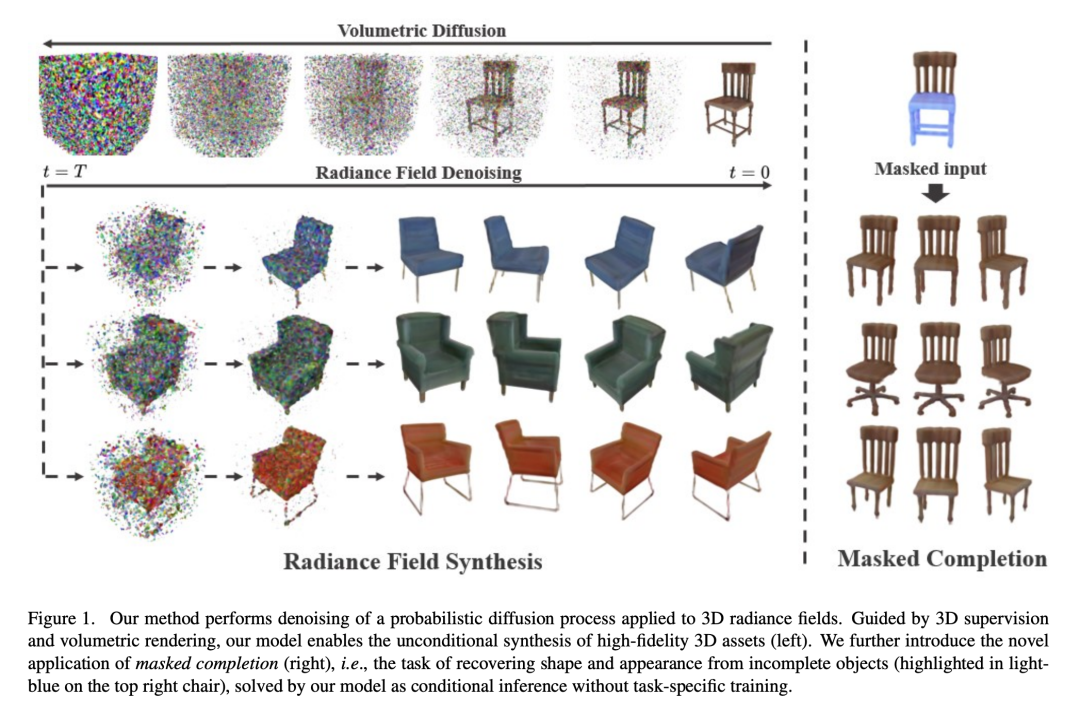

DiffRF(https://sirwyver.github.io/DiffRF/)可以看成是神经辐射场(NeRF)与扩散模型(Diffusion Model)的一种新的组合形态:

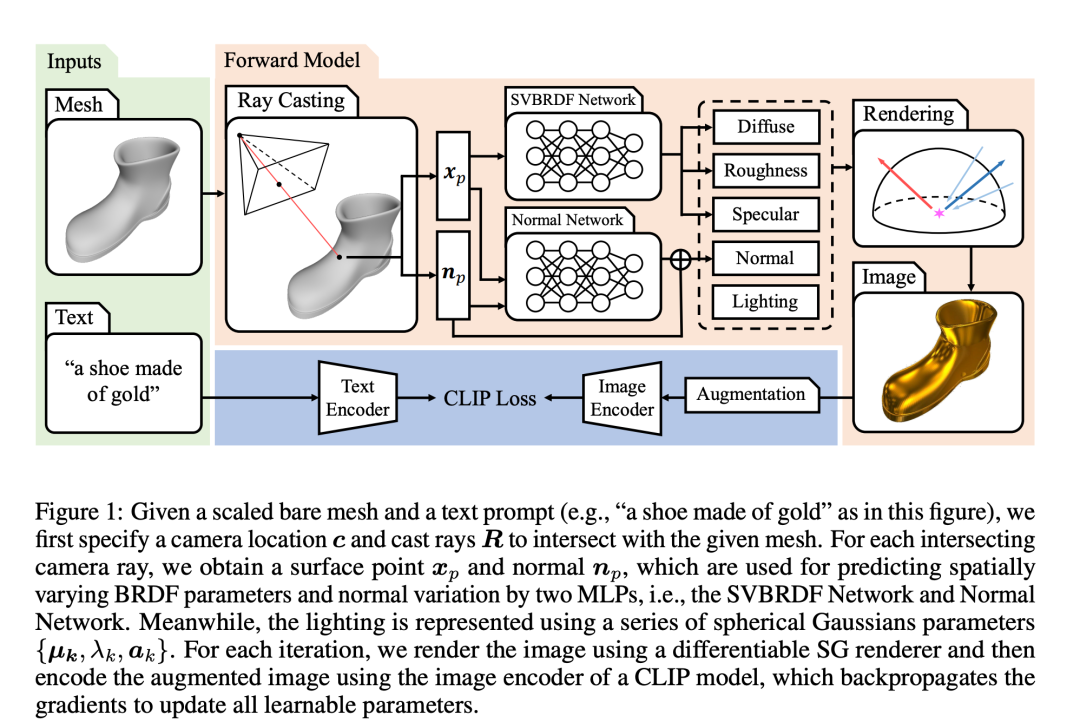

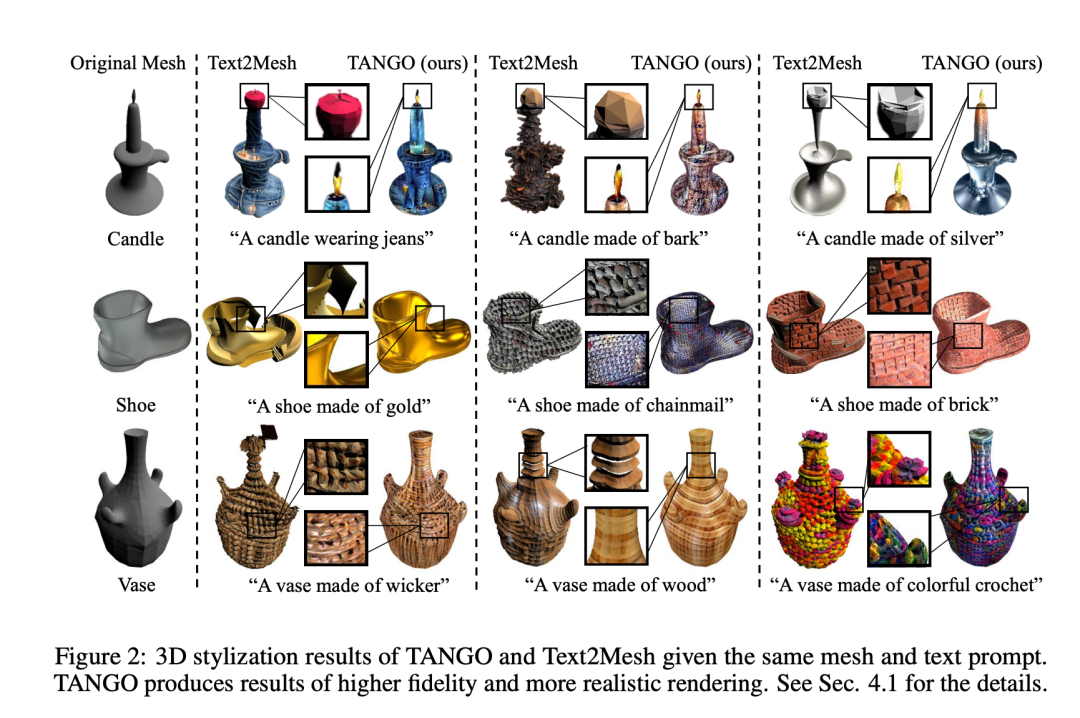

TANGO(https://arxiv.org/pdf/2210.11277.pdf)将CLIP的跨模态训练模式与3D世界多种任务的参数化方法结合,根据提示文本生成3D渲染需要的各类参数(材质、法线、光照等):

管中窥豹——上面几个例子,已足以看出今天3D生成领域科研的基本态势:

- 科研势头火热;

- 科研方向处于探索和发散阶段;

- 3D生成的整体效果目前还无法满足用户需求;

- 在一些限定领域或风格的应用场景,SOTA模型可以很好地完成任务。

从2017到2022,NLP领域经历了科研大爆发到GPT-4等超级大模型一统江湖的演进过程。

今天,在形态组合上层出不穷的多模态AI算法,会不会催生出另一种类型的超级大模型呢?

多模态AI为什么这么难

多模态的生成、语义理解、逻辑推理等任务肯定比单纯的NLP任务难。

文生图这样最基础的跨模态任务,今天许多人认为已经完美解决。Stable Diffusion + ControlNet + LoRA的组合看上去无懈可击,Midjourney工具用起来也似乎得心应手。

但真实情况是,基于扩散模型的文生图算法在娱乐和大众传播领域非常受欢迎,但想融入专业制作流程或取代职业美术师,还是有相当难度。

《CG大佬暴击AI现场》(https://zhuanlan.zhihu.com/p/623967958)记录了人类专业美术师挑战AI绘画的一个具体案例。从这个案例看,人类对创意和细节的掌控力暂时还是远强于AI的。ControlNet所做的事情,本质上还是用人类的控制力来弥补AI作画容易发散、难受控制的缺陷——这从另一个角度证明了人类高水平画师在当前时间节点的不可替代性。

文生图尚如此,文生视频,文生3D,文生动画,图文混合逻辑推理等更难的任务,今天确实还处在非常早期的阶段。这里面的根本原因是——多模态AI特别难。

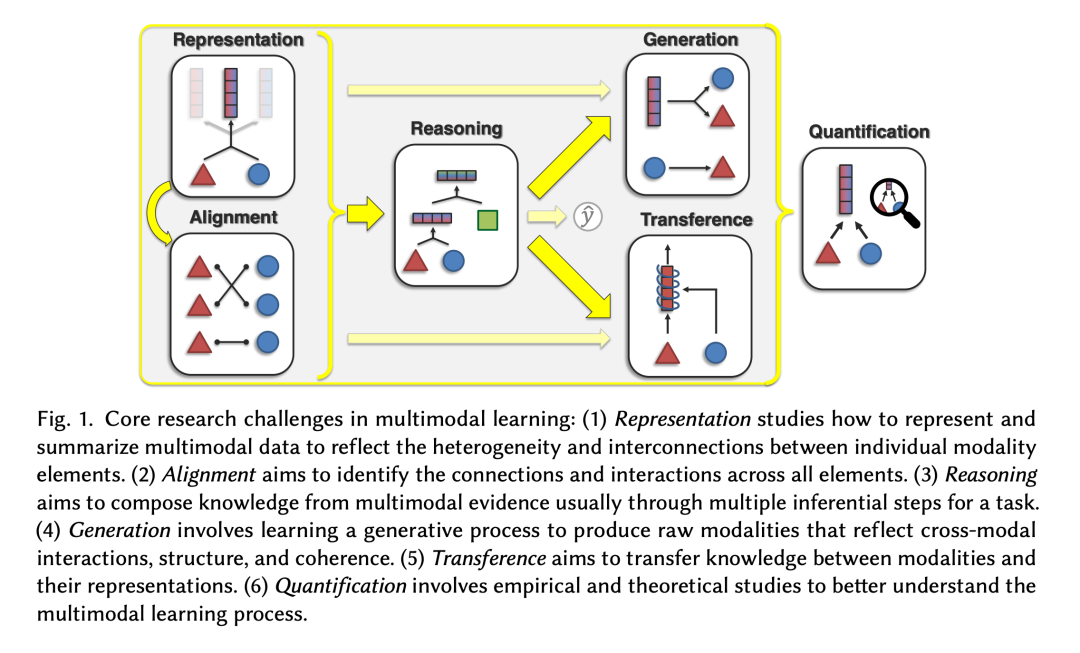

卡内基梅隆大学发表的Foundations & Trends in Multimodal Machine Learning: Principles, Challenges, and Open Questions将多模态AI科研面临的挑战归纳为以下六点:

第一,表示(Representation):文本、图片领域的信息表示方法相对稳定,视频、动画、3D等领域仍在实验各种新的表示方法。没有好的表示方法,AI就无法学习到高质量的知识。

第二,对齐(Alignment):CLIP提供了不同模态之间相互对齐的框架思路,但真到处理多模态对齐的时候,还是要反复实验,寻找最优方案。

第三,推理(Reasoning):前两条解决不好的话,模型的推理能力肯定无法提高;即便单独考虑推理,也涉及到认知空间里的信息连接关系,模型网络结构,模型规模等大量细节。

第四,生成(Generation):生成部分包含多模态信息抽取,跨模态信息翻译,多模态信息创建三个阶段。与单纯的文本生成任务相比,这三件事在多模态任务中的复杂度都直线上升。

第五,知识迁移(Transference):很多领域的知识天然存在于不同模态的信息中,但如何在多模态信息之间互通有无,相互补全缺失的知识呢?更重要的是,一些模态(如3D)的训练数据极度匮乏,而训练数据相对丰富的图片、视频领域其实包含了大量3D知识。这时,如何做好知识迁移就成了必须回答的关键问题。

第六,量化分析(Quantification):这个困难在所有深度学习模型中都存在。如何定量评估模型网络结构的优缺点,如何在持续迭代中改进模型中最薄弱的环节,如何甄别模型中是否学习到了偏见,如何测试模型的鲁棒性等等,都是深度学习理论界的老大难问题。

还是以3D场景或对象的自动生成为例,多模态AI面临的科研或工程挑战在3D生成领域会转化为以下这些非常棘手的问题:

- 数据匮乏:与随处可见的高质量图像数据集相比,高质量的3D数据集屈指可数。常用的科研图像数据集通常都包含上亿或更多图片,而很多质量较高,可用于科研的3D数据集只有数千或数万个3D模型。

- 知识迁移困难:目前的科研还在全力拆解单张或多张图像中包含的3D信息,要精确还原或对齐文本、视频、动画序列中包含的3D信息,就更加困难。

- 技术选型困难:以3D场景或对象的表示方法为例,可选的方法有好多种,新方法也在持续涌现。连输入端的信息如何表示都难成定论,又如何去要求模型的输出质量呢?

- 大算力依赖:未来,训练一个多模态超级大模型需要的算力,可能会远远超过训练GPT-4需要的算力。

- 缺少“模型训练→产品应用→用户反馈→改进模型训练”的正循环:因为3D生成难度大,3D生成类的产品较难解决普通用户的实际问题,就难以得到更多用户数据和用户反馈,更无法借助用户反馈迭代和改进模型质量。

多模态AI的技术挑战真实存在,但有挑战就意味着有机会;通过技术突破、技术创新在多模态AI领域大步前进,目前正是最好的时机。

大语言模型本身的多模态能力

一方面,多模态AI有相当多技术挑战要解决;另一方面,GPT等大语言模型其实已经学到了人类语言文字中记录的一部分多模态知识(GPT-4中也编码了图像语义,可同时接受文、图两种模态的输入;这方面的信息可参考GPT-4论文,本节不再讨论)。我们能否利用大语言模型学习到的多模态知识来加速多模态AI的科研与应用开发呢?

这是一条超级有趣的技术路径,值得我们深入探索。

例如,拿我们团队关心的3D创建和控制类任务来说,从GPT-4开放使用界面和接口的时刻起,我们就一直在测试GPT-4有关三维空间的知识储备与逻辑推理能力。

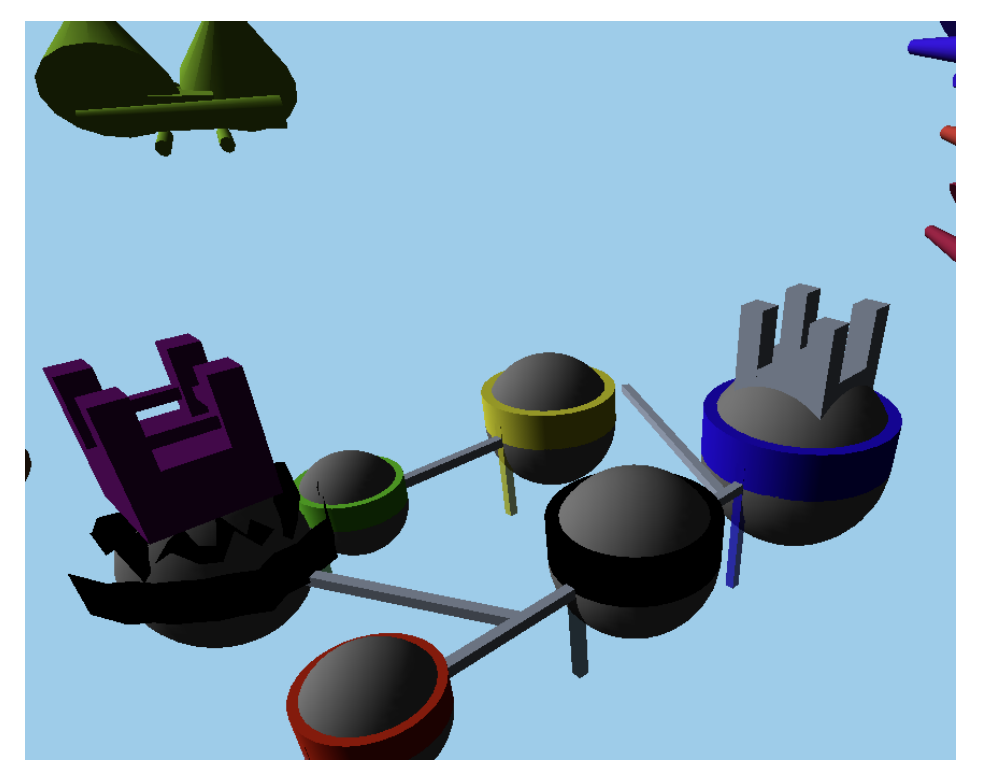

微软Spark of AI的论文中提到了一小部分GPT-4的3D能力。在一项实验中,研究员要求GPT-4使用JavaScript创建“一个拥有浮动岛屿,瀑布,桥梁的奇幻世界,一条龙从空中飞过,一座城堡坐落在最大的岛屿上”(实际实验过程包含多轮次的指令或提示信息),GPT-4通过JavaScript编程创建出的3D世界如下图所示——虽然简陋如幼童作品,但基本从语义上还原了提示要求:

考虑到GPT-4从来没有直接学习过任何3D模态的信息,仅从人类语言文字中获取有关3D世界、3D建模、3D编程的知识,这样的输出结果是非常惊艳的。

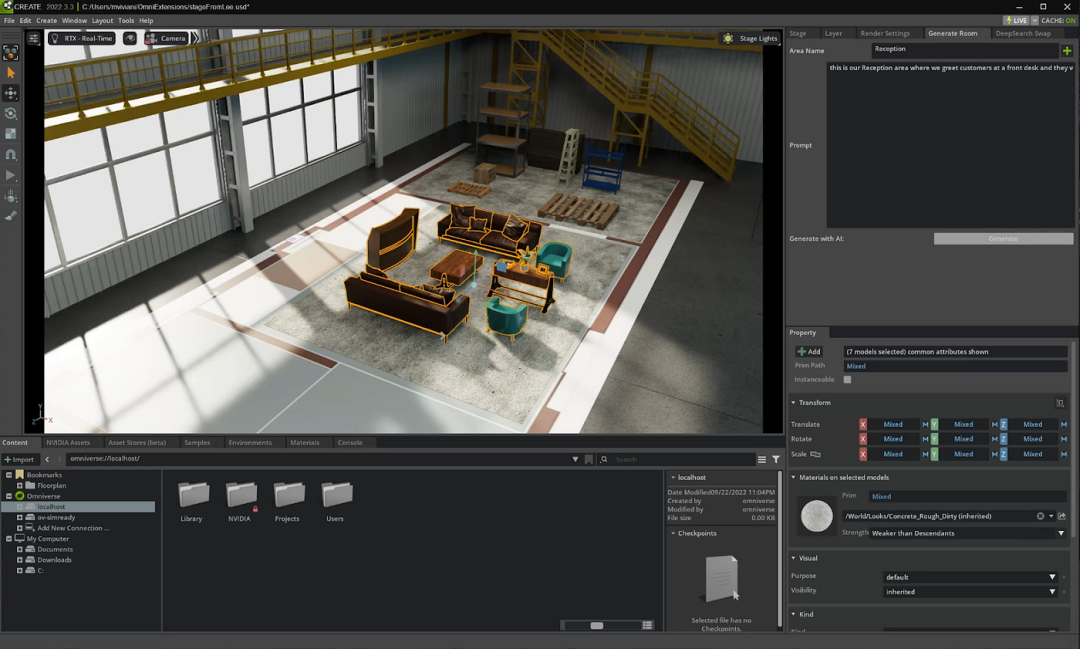

NVIDIA Omniverse团队利用ChatGPT和GPT-4完成了另一项3D内容创建实验,同样有趣地展示了GPT-4与3D工具的编程接口连接后,可以达到怎样的创造力与控制力(参见文章How ChatGPT and GPT-4 Can Be Used for 3D Content Generation):

与微软和NVIDIA的研究团队不同,我们团队更希望深入调研GPT-4对3D空间基本构成元素的认知到底有多透彻。我们期待GPT-4理解并操控的基本空间元素包括:

- 坐标系

- 空间方位

- 几何体的三维构成

- 几何体的形式化表示

- 几何体的空间关系

- 几何体的空间运动

我们做了大量相关实验,结果是令人震撼的:GPT-4在3D空间认知和操控上的“智力水平“,与一个正在拼搭积木的2~3岁小朋友近似;GPT-4可以像幼童一样准确理解最基本的空间方位,懂得几何形体的基本构型,同时也像幼童一样总是”笨手笨脚“,难以精细化控制空间元素的细节。

在开展具体实验前,我们希望GPT-4自己推荐一组可以在有限文本长度内描述空间对象的形式化方法。GPT-4完全明白,直接使用(x, y, z)坐标系统及3D网格(Mesh)的精确表达方式肯定没办法在数千个语义符号(Token)的窗口内描述一个3D物体。它推荐我们使用下面几种精简的形式化方法:

- 使用八叉树(Octree)来编码对象的空间结构;

- 使用构造实体几何法(Constructive Solid Geometry),利用基本形状或自定义网格组合成复杂形状;

- 使用低多边形(Low-poly)方法简化3D网格;

- 使用行程编码(RLE)来压缩3D形状的形式化表达;

- 使用参数化(Parametric)或过程式(Procedural)建模方法;

- 在不同分辨率的空间层级使用不同精度的表达系统。

很显然,GPT-4从3D图形学书籍或文章中很好地汲取了形式化描述3D对象的主流方法。我们就使用GPT-4推荐的方法,进一步测试GPT-4在3D任务中的实战能力。

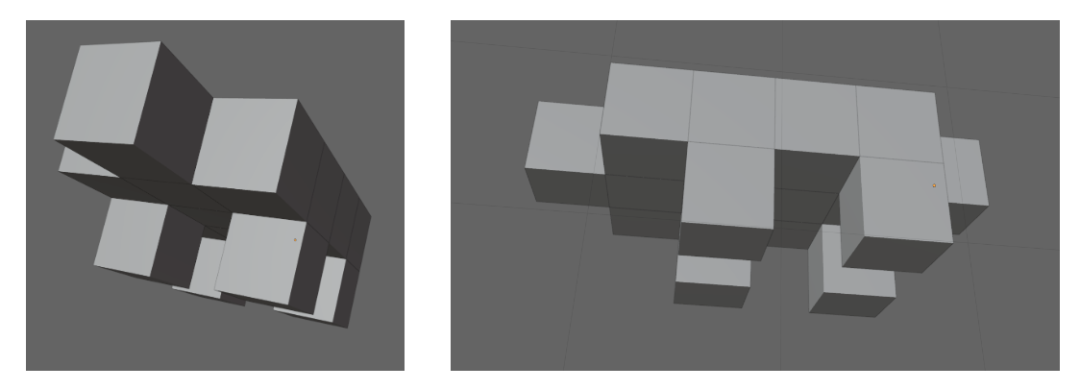

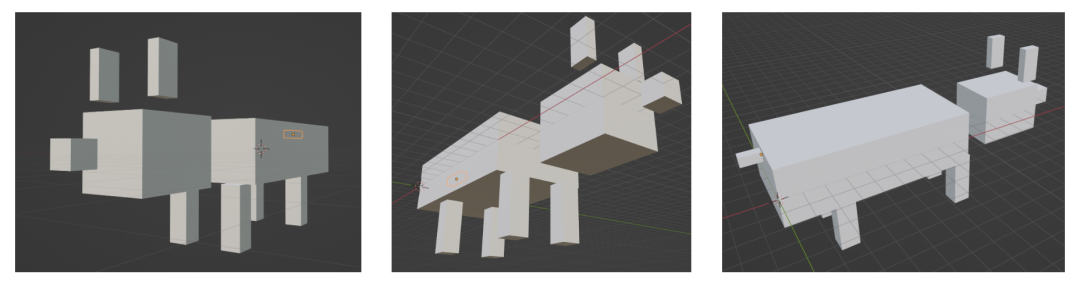

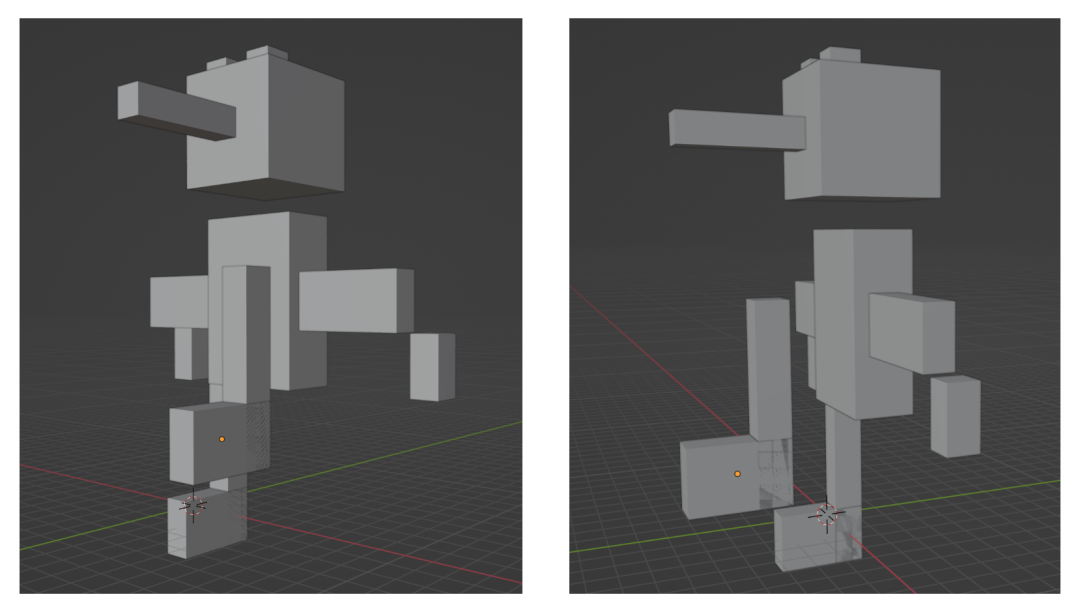

基于构造实体几何(Constructive Solid Geometry)的思路,我们请GPT-4利用1x1x1的单元积木块,在一块给定范围的小空间内,拼搭一只“粗线条”的积木小狗,并输出每个单元积木块所在的单元格坐标或序号。我们用一个Blender插件将GPT-4的输出结果直接渲染成3D场景。

GPT-4根据“一只积木小狗”的提示,拼搭出的积木对象如下:

我们通过追加提示请GPT-4为小狗增加细节,特别是增加小狗的两只耳朵。GPT-4出色地完成了任务:

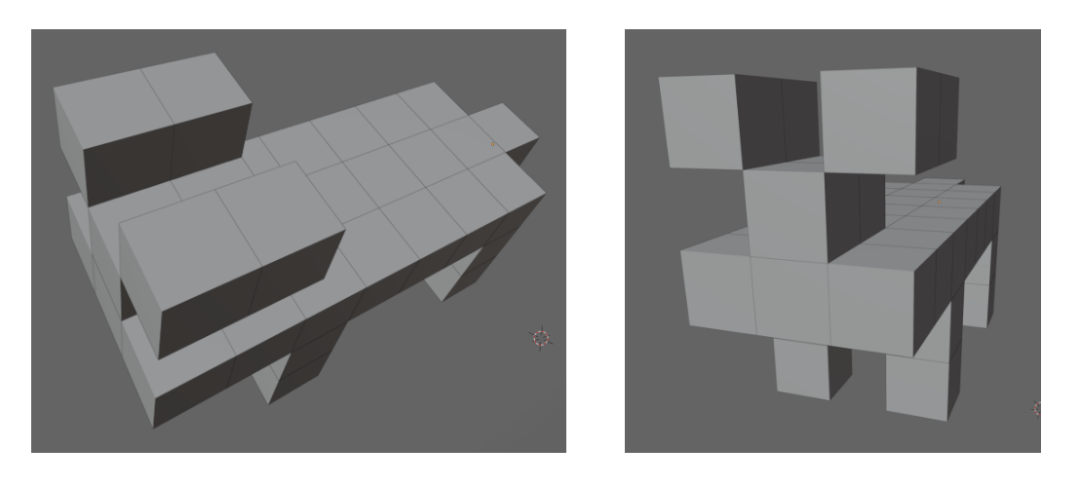

当我们请GPT-4自我发挥,搭建一所它认为漂亮的,包含一扇门和一扇窗的小房子时,GPT-4创建的积木结构同样非常有趣:

在未经提示时,GPT-4似乎不会用“镂空”的方式留出门窗的孔洞,而是在门窗所在位置重叠摆放了表示门和窗的积木块。为了在视觉上有所区分,我们用蓝色渲染出GPT-4认为是门窗的积木块(生成过程中,GPT-4会很细致地分步骤解释每一组积木的用途)。

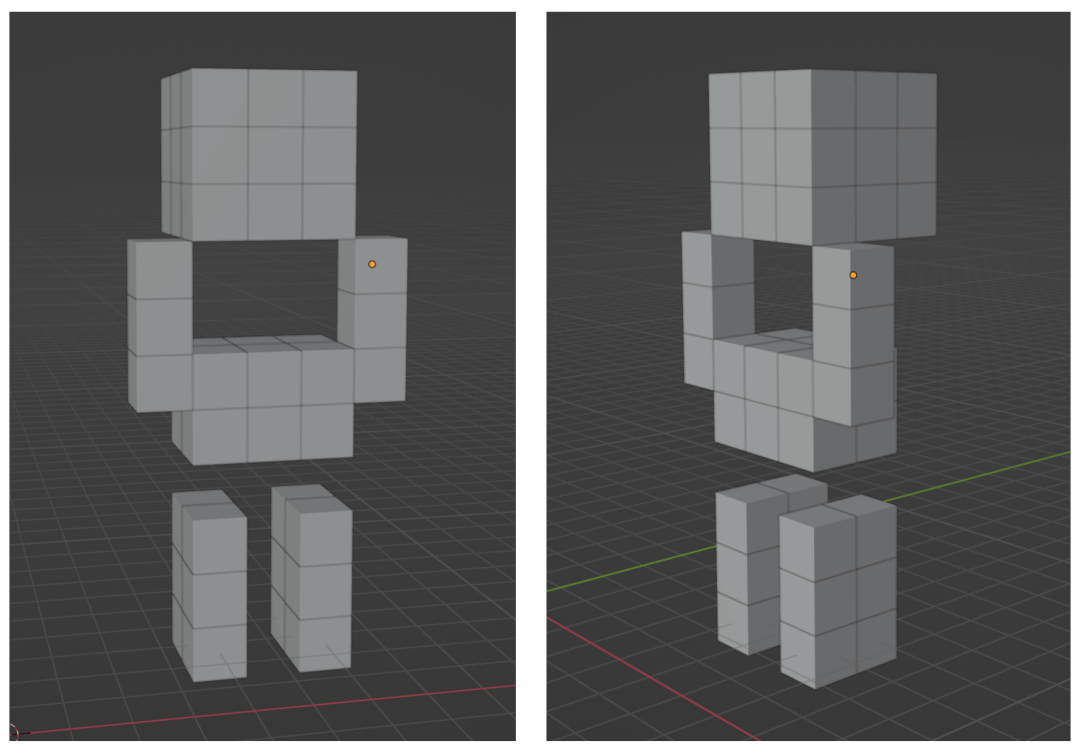

接下来,当我们要求GPT-4用积木拼搭有手有脚的积木小人,且同时给出了Minecraft风格的限定提示时,GPT-4创作的积木小人简明而准确:

特别有趣的是,当我们要求GPT-4将积木小人的左手向前伸出时,GPT-4准确做出了一只手臂向前伸出的动作,但很遗憾搞错了左右,下图中的小人向前平伸的手不是左手而是右手:

这是一个在类似实验中反复出现的有趣现象:GPT-4通常可以准确认知或定位3D空间中的上与下、前与后,却经常把左和右搞反。在我们的实验里,如果不在提示词中强调哪个方向为左哪个方向为右,GPT-4混淆左右的概率就远高于正确处理左右的概率。两三岁的小孩子好像也经常搞不清左右——莫非GPT-4已经具备了某种“生命特征”?

经团队顾问提醒,这种混淆左右的现象其实不难解释:在所有语言文字类的3D场景描述中,大多数讲者都是站在第三人称观察者的视角来描述3D空间里的方位信息的。假如观察者面对3D空间中一个虚拟人物的正面,观察者左侧对应的一定是虚拟人物形象的右手,观察者右侧对应的一定是虚拟人物形象的左手。因为只通过语言文字材料学习3D知识,GPT-4形成左右方向相反的“观察者偏见“就在所难免了。

这种左右颠倒的现象似乎进一步说明:仅仅从语言文字中学习世界知识,并不足以建立完整、准确的多模态认知。未来的AI大概率还是需要直接从多模态传感器、影像资料、3D场景、动画序列中直接学习知识。

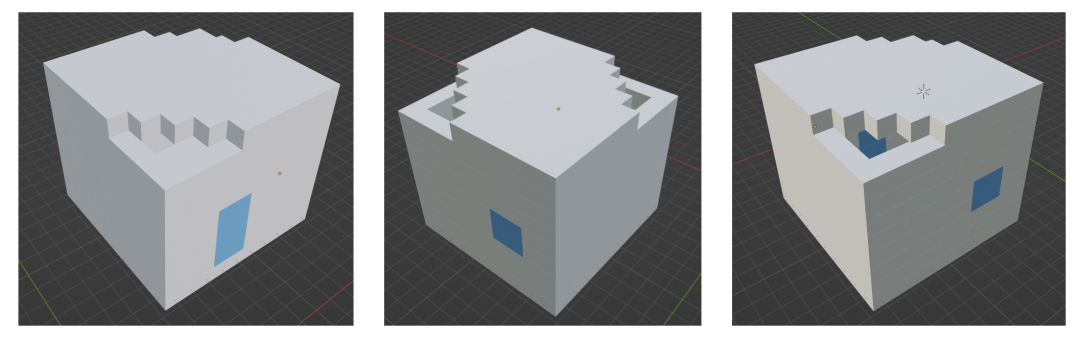

如果允许GPT-4使用任意形状的六面体积木,就必须将GPT-4每一轮次的输出限定为每块积木的空间位置(x, y, z)和空间大小(w, h, d),然后同步修改我们的Blender插件。

下图是GPT-4自行选择积木大小后,重新拼搭出的积木小狗:

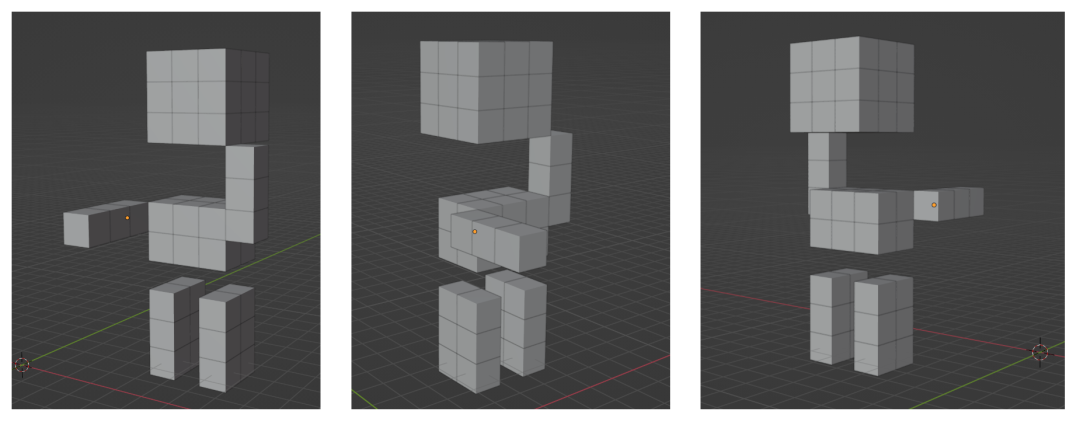

下图是根据“类似匹诺曹的木偶小人”的提示,GPT-4用自选形状积木搭建出的作品(“长鼻子”的视觉意像,应该是GPT-4从“匹诺曹”的提示中领悟得到的):

注意上图中,GPT-4将木偶小人的两只眼睛摆在了头顶偏前的位置。为了解决这个空间方位错误,我们又使用了好几轮提示,才“教会”GPT-4如何将两只眼睛挪动到面部上方。

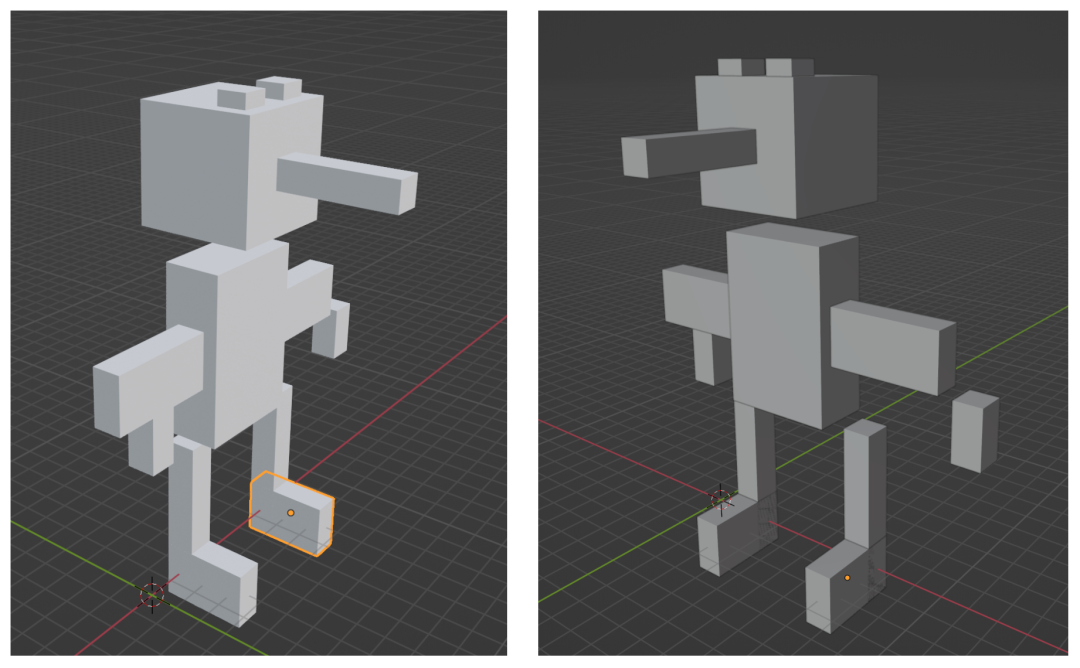

接下来,我们期望GPT-4生成连续的动画关键帧,让木偶小人在动画中逐渐抬起一条腿。GPT-4可以准确理解我们的意图,也能将“抬起一条腿”的动作映射到空间中的对象结构。只不过,六面体积木的表达能力有限(我们与GPT-4约定的形式语言甚至缺少积木旋转角度的表达),GPT-4所能做到的最好的视觉效果,也就是下图这样了:

除了上述这些简单而有趣的结果,我们还做了大量更加细致、深入的实验,包括:

- 在八叉树、基本几何体的布尔组合等方向上深入探索GPT-4的空间表达能力;

- 在几何体UV贴图的方向,探索GPT-4将渲染效果与空间位置关联的能力;

- 探索GPT-4根据指令(如“典型的摄影工作室的三灯照明设计”)控制场景内光照的能力;

- 实验GPT-4对动画关键帧的理解和控制能力;

- ……

后续,我们可能会用专门的文章,系统性发布这些实验结果以及从中观察到的规律性知识。

我们团队做的系列实验,不断逼近GPT-4在3D模态任务上的认知极限。愈是深入实验,愈是感觉GPT-4在这个领域的行为特征上与两三岁小孩子搭积木极为近似。所谓“AGI的曙光”,大概也可以从这个方向来理解吧。

另一个“大力出奇迹”的结局?

今天的多模态AI仍处在技术方向发散的大探索、大发展阶段。

多模态AI会不会像NLP任务那样,被一个“大力出奇迹”的超级大模型全面取代呢?

个人认为,这个结局的可能性极大;但到达这个结局的路径可能会很漫长。

首先,OpenAI或Google之类的AI大厂已经在发力研发下一代多模态混合的预训练模型了。文、图甚至文、图、视频混合训练出来的通用大模型,应该会在不久的将来展示出远超GPT-4的多模态能力。按照经验认知,OpenAI在多模态超级大模型的竞争中再次胜出,一定是个大概率事件。

其次,如前文所述,文、图以外的多模态领域,仍存在相当大的变数——训练数据极度匮乏,3D等复杂多模态信息的表示和对齐缺少公认的最优解,多模态训练对算力要求远高于纯文本数据等等技术挑战,像天堑一样横亘在所有研究者和开发者面前。

本质上,文字是在一维时间序列上编码语义信息,图像是典型的二维空间信息,视频可以理解为二维空间信息与时间序列的组合(三维信息),而3D动画则升级为三个空间维度与时间序列的组合(四维信息)。理论上,3D动画是对真实时空的终极映射;文本、图像甚至视频,只是真实时空在更低维度上的投影。

GPT等大语言模型建立起一种有可能通向AGI的智能范式。但将这种智能范式扩展到三维、四维的时空范围,复杂度的增长是指数级别的。因此,在视频、3D、动画序列等较文、图更复杂的多模态领域,技术迭代并收敛到一个大一统方法的时间周期可能会相当长,三至五年只是我的保守估计。

也许必须采用新算法设计来解决复杂度爆炸的问题。或者,因为模态间知识迁移的可能性,让AI更加深入理解训练数据丰富的低维度文、图信息,一定可以帮助AI更快地从高维度信息中学习知识。另外,基于今天较早期的多模态技术快速推出实用产品,然后通过平台级、工具级的产品建立用户场景、数据、工程、科研之间的联动关系,这也是加速技术迭代的好思路。

简单讲,好消息和坏消息同时存在,多模态AI的发展趋势极难预测。本文有关未来的预测并非基于严格的数学建模,肯定不准确。回顾过去数十年的AI技术发展,也根本没有谁能准确预测AI科研何时巅峰,何时低谷。

一切都取决于我们这些从业者的努力工作。

多模态应用的创新“蓝海”

GPT等大语言模型开启了应用创新的新时代。生机勃勃的多模态AI则会把这一轮应用创新推到最高潮。

与单纯通过自然语言进行交互或输入输出相比,多模态应用显然具备更强的可感知、可交互、可“通感”等天然属性。目前Midjourney在文生图领域的应用模式创新,我相信只是未来多模态应用世界的冰山一角。

简单罗列一些我非常看好的未来多模态应用吧:

- 跨多模态语义的知识检索与数据提取;

- 新一代的多模态数据库;

- 跨模态的知识挖掘,典型如医药领域(跨病历,医疗影像,基因序列,分子结构等)的知识挖掘;

- 多模态信息展示(如产品、年报、课程、演讲)的自动生成;

- 多模态广告的自动生成;

- 多模态网页或小程序的自动生成;

- 自动视频编辑;

- 自动视频生成;

- 混合了多模态创建能力的下一代用户原创内容(UGC)工具或平台;

- 电商平台内的虚拟导购;

- 自动生成可交互的电商货架;

- 教育领域里的虚拟课程,虚拟老师;

- 各种类型的虚拟角色;

- AI表情或肢体语言;

- AI虚拟情感;

- AI创作音乐和歌舞;

- AI为核心的新一代动画设计工具;

- 自动游戏开发;

- 增强了多模态感知和决策能力的新一代的机器人技术;

- 增强了多模态感知和决策能力的新一代自动驾驶技术;

- 虚拟现实和混合现实中的自动内容创建;

- 多模态社交应用的自动生成;

- 多模态小游戏的自动生成;

- ……

今天的大量AI应用还局限在既有存量市场、既有应用模式下的渐进式创新;上面这些多模态的应用创新机会里,不少都属于有可能创造一个增量市场或平台产品的变革式创新。

为什么多模态领域容易诞生变革式创新?

以UGC的工具和平台为例:20年前,普通用户在互联网上创建的原创内容以文字为主;进入移动互联网时代后,图片和长视频在用户原创内容中的占比明显升高;最近几年,短视频工具和平台一跃成为UGC世界的核心流量……但用户的创造欲已经被完全满足了吗?要知道,普通用户的想象力是无穷无尽的。只要有更好的表达方式和更简单的工具,用户就一定能再次创造数字内容的新风潮。

根本矛盾在于,目前的技术工具无法满足用户旺盛的创造需求。例如,专业的影视、3D动画、游戏等团队擅长创建各类精彩内容或超凡用户体验,但普通用户很难效法。类似Final Cut Pro、After Effects、Blender、Cinema 4D、Unity之类的专业工具从设计理念上就将绝大多数普通用户排除在外,它们无一例外拥有非常陡峭的学习曲线,追求极致的专业控制力,还必须满足专业工作流、工具链的整合需要。

新一代的多模态AI技术显然有重新定义内容创建工具的极大机会。一个“草根用户”如果计划在虚拟世界里构建脑洞大开的发明创造(参考手工耿的实体作品),是不是可以直接用自然语言指导AI完成任务,而不是从头学习专业工具软件的使用方法?一个孩子创造了天才的游戏玩法,但苦于缺少游戏开发的专业经验,未来的多模态AI是不是可以大显身手?

AI赋能的智能工具迟早会抛开“专业”的包袱,将普通用户从陡峭的学习曲线中解放出来。每个内容创建者都可以专注于创意本身,而不是复杂的工具软件交互。到那时,下一代UGC平台还会停留在文、图、短视频这些简单形态上吗?

多模态应用有广阔的想象空间。即便假定多模态AI已经成熟,在应用层级也还需要探索和迭代大量工程技术问题。例如:

- AI生成的元素如何与传统的影视、3D、动画、游戏等工作流完美结合?

- 多模态场景中,自然语言主导的人机交互该如何设计才最高效?

- 未来的计算机、手机或新一代个人计算设备如何连接不同模态的传感器?

- 操作系统或应用程序如何用更好的多模态形式展示计算结果?

- 苹果公司即将推出的VR/AR设备会如何改变多模态应用市场的竞争格局?

- AI辅助编程如何更好地提高多模态应用的开发和部署效率?

- ……

我个人相信,在后GPT时代里,多模态是最大的科研、工程与应用研发机会。水平有限,这个基本观点连同以上思考内容,肯定不会完全正确。整理并发表出来,仅供大家参考。

参考资料:

[1]Harnessing the Power of LLMs in Practice: A Survey on ChatGPT and Beyond, https://www.researchgate.net/publication/370224758_Harnessing_the_Power_of_LLMs_in_Practice_A_Survey_on_ChatGPT_and_Beyond

[2]Sparks of Artificial General Intelligence: Early experiments with GPT-4, https://arxiv.org/abs/2303.12712

[3]GPT-4 Technical Report, https://arxiv.org/abs/2303.08774

[4]Foundations and Trends in Multimodal Machine Learning: Principles, Challenges, and Open Questions, https://arxiv.org/abs/2209.03430

[5]How ChatGPT and GPT-4 Can Be Used for 3D Content Generation, https://medium.com/@nvidiaomniverse/chatgpt-and-gpt-4-for-3d-content-generation-9cbe5d17ec15

— 完 —

- 马斯克冲刺机器人量产,果断停产特斯拉豪华车型!2026年资本支出将“非常大”2026-01-29

- 那个用半成品刷爆SOTA的Qwen3超大杯推理版,现在正式上线2026-01-26

- “DeepSeek-V3基于我们的架构打造”,欧版OpenAI CEO逆天发言被喷了2026-01-26

- 斯坦福「返老还童」新研究:无需干细胞,逆转关节损伤和老化2026-01-25