南科大黑科技:一键消除视频人物,特效师的救星来了!

克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

来自南方科技大学的这款视频分割模型,可以追踪视频中的任意事物。

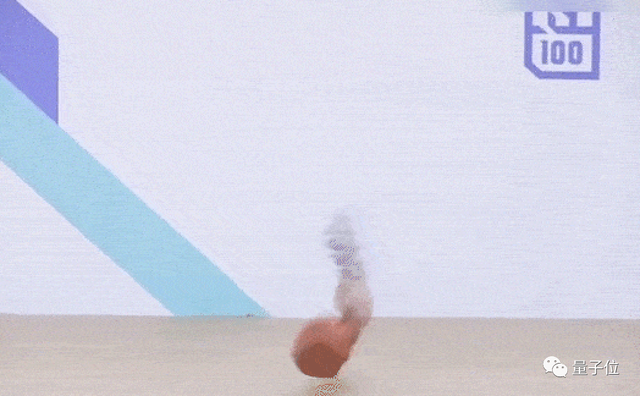

不仅会“看”,还会“剪”,从视频中去掉个人,对它来说也是轻轻松松的事。

而操作上,你唯一需要做的就是点几下鼠标。

这位特效艺术家看到消息后仿佛找到了救星,直言这一产品将改变CGI行业的游戏规则。

这款模型叫做TAM(Track Anything Model),是不是和Meta的图像分割模型SAM名字很像?

的确,TAM就是将SAM扩展到了视频领域,点亮了动态物体追踪的技能树。

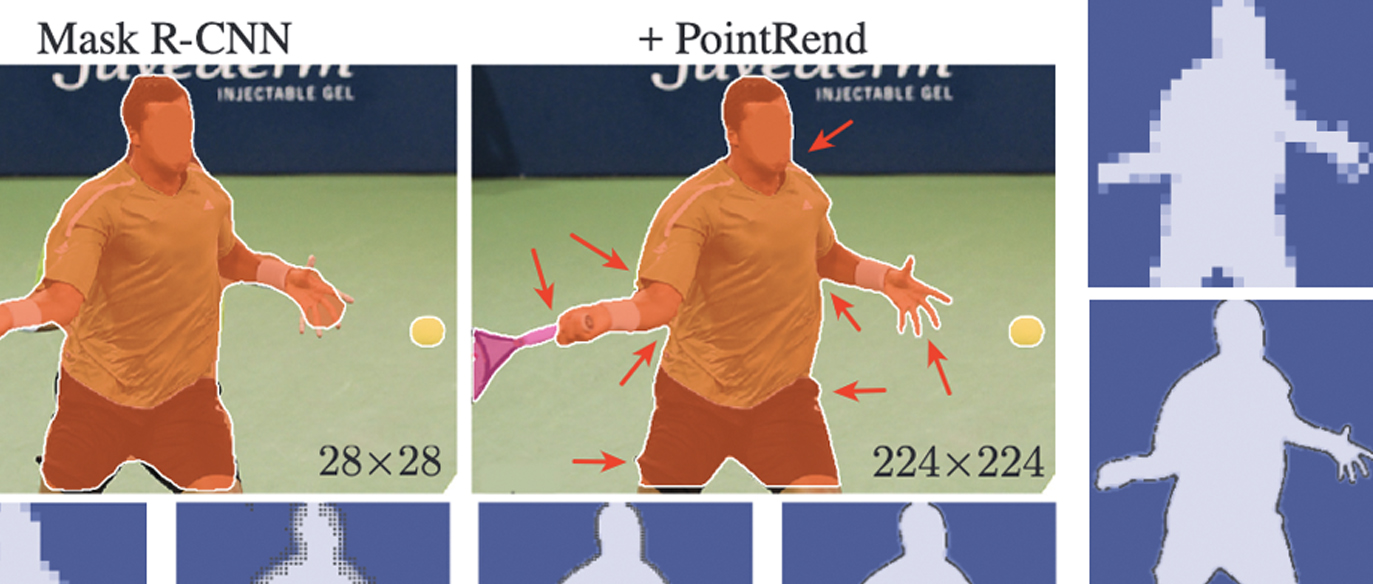

视频分割模型其实不是新技术了,但传统的分割模型并没有减轻人类的工作。

这些模型使用的训练数据全部需要人工标注,甚至在使用时还需要先用特定物体的遮罩参数进行初始化。

SAM的出现为解决这一问题提供了前提——至少初始化数据不再需要人工获取。

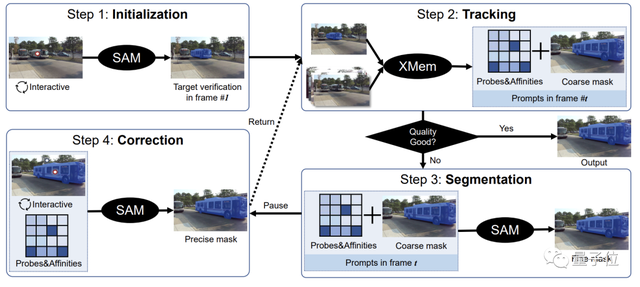

当然,TAM也并不是逐帧使用SAM再叠加,还需要构建对应的时空关系。

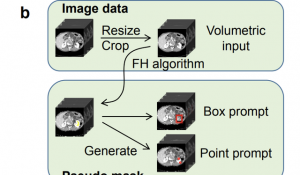

团队将SAM与名为XMem的记忆模块进行了集成。

只需要在第一帧中用SAM生成初始参数,XMem便可以指导接下来的追踪过程。

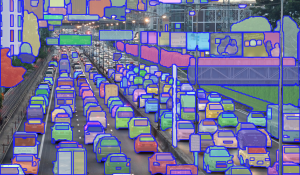

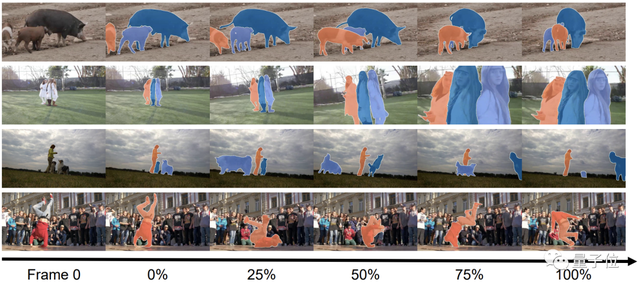

追踪的目标还可以是很多个,比如下面的清明上河图:

甚至场景发生改变,也不影响TAM的表现:

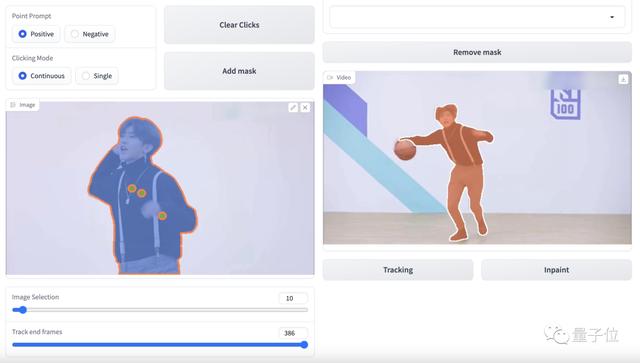

我们体验了一番发现,TAM采用了交互式用户界面,操作上十分简单友好。

硬实力方面,TAM的追踪效果的确也不错:

但是,消除功能在一些细节上的精确度还有待提高。

从SAM到TAM

前文已经提到,TAM是在SAM的基础之上结合记忆能力建立时空关联实现的。

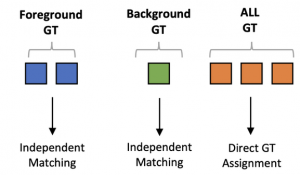

具体而言,第一步是借助SAM的静态图像分割能力对模型进行初始化。

只需一次点击,SAM就能生成目标物体的初始化遮罩参数,代替了传统分割模型中的复杂初始化过程。

有了初始参数,团队就可以将它交给XMem,进行半人工干预训练,大大减少了人类工作量。

在这一过程中,会有一些人工预测结果被用于和XMem的输出进行比较。

实际过程中,随着时间的增长,得到准确的分割结果对XMem变得越来越困难。

当结果与预期差距过大时,将进入再分割环节,这一步还是由SAM完成。

经过SAM的再优化,大部分输出结果已比较准确,但还有一部分需要人工再调整。

TAM的训练过程大致就是这样,而开头提到的物体消除的技能是TAM与E2FGVI结合形成的。

E2FGVI本身也是一个视频元素消除工具,在TAM精准分割的加持下,其工作更加有的放矢。

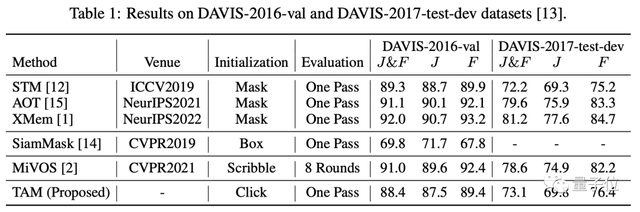

为了测试TAM,团队使用了DAVIS-16和DAVIS-17数据集对其进行了评估。

直观感受还是很不错的,从数据上看也的确如此。

TAM虽然无需手工设置遮罩参数,但其J(区域相似度)和F(边界准确度)两项指标已十分接近手工模型。

甚至在DAVIS-2017数据集上的表现还略胜于其中的STM。

其他初始化方式中,SiamMask的表现根本无法和TAM相提并论;

另一种名为MiVOS方法虽然表现好于TAM,但毕竟已经进化了8轮……

团队简介

TAM来自南方科技大学视觉智能与感知(VIP)实验室。

该实验室研究方向包括文本-图像-声音多模型学习、多模型感知、强化学习和视觉缺陷检测等。

目前团队已发表论文30余篇,获得专利5项。

团队领导人是南方科技大学郑锋副教授,博士毕业于英国谢菲尔德大学,先后供职于中科院深研院、腾讯优图等机构,于2018年进入南科大,2021年晋升为副教授。

论文地址:

https://arxiv.org/abs/2304.11968

GitHub页面:

https://github.com/gaomingqi/Track-Anything

参考链接:

https://twitter.com/bilawalsidhu/status/1650710123399233536?s=20

- 智谱新模型也用DeepSeek的MLA,苹果M5就能跑2026-01-20

- 钉钉上线AI差旅:企业免垫资,员工免报销,AI帮比价2026-01-20

- 45年数论猜想被GPT-5.2 Pro独立完成证明,陶哲轩:没犯任何错误2026-01-19

- Claude版Manus只用10天搓出,代码全AI写的!网友:小扎140亿并购像冤大头2026-01-14