沈向洋马毅牵头搞新AI会议:不要「大力」要「简约」,首届在香港大学举办,征稿中

大型机器学习会议变味儿了?

鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

大模型时代,有人要来唱唱“大力出奇迹”的反调了。

沈向洋和UC伯克利&香港大学教授马毅牵头,搞了一个新的学术会议,CPAL(Conference on Parsimony and Learning),即简约学习会议。

官网信息显示,这一会议专注于解决机器学习、信号处理、优化等领域普遍存在的简约、低维结构。

对理论、算法、应用程序、硬件和系统以及简约学习的科学基础感兴趣。

马毅本人也做了“定向”推荐:

厌倦了包罗万象的大型机器学习会议?CPAL会成为一个专注于理论和计算基础的高标准会议。

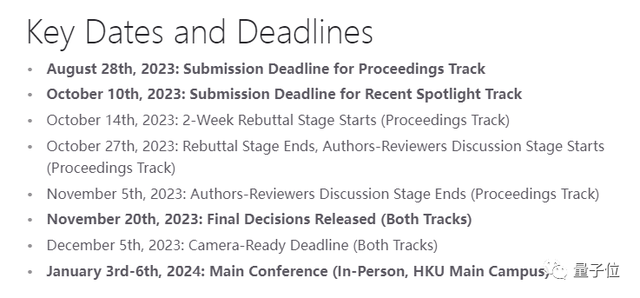

首届会议,将于2024年1月3日-6日,在香港大学数据科学研究院举办。论文的提交截止日期为今年8月28日。

CPAL详情

具体时间表如下:

会议主席,除了前文提到的沈向洋和马毅,还有慕尼黑大学的Gitta Kutyniok,和宾夕法尼亚大学的René Vidal。

另外,组织团队中,还有来自CMU、香港大学等高校,以及谷歌、Meta的专家学者。

此前,马毅、沈向洋和神经科学家曹颖曾合作发表过一篇论文:On the Principles of Parsimoy and Self-Consistency for the Emergence of Intelligence。

此次的CPAL会议,核心思想与这篇论文一脉相承:强调人工智能的两个基本原则,简约性和自洽性。

以下附CPAL会议愿景全文:

智能或科学存在甚至产生的最基本原因之一,是世界并非完全随机,而是具有高度的结构性和可预测性。因此,智能或科学的一个基本目的和功能就是通过大量感知世界的数据,学习简洁的模型(或法则)来理解这种可预见的结构。

在过去的十年中,机器学习和大规模计算的出现,极大地改变了我们在工程和科学中处理、解释和预测数据的方式。传统的算法设计方法,基于特定信号和测量结构的参数模型,比如稀疏和低秩模型,以及相关的优化工具集,现在已经被丰富的数据驱动的学习技术所补充,这些技术通过大规模网络的预训练和适应各种特定任务。然而,现代数据驱动和经典模型基础范例的成功,都严重依赖于正确识别现实世界数据中存在的低维结构,以至于我们认为学习和压缩数据处理算法的角色——无论是显式还是隐式,如深度网络——是不可分割的。

在过去的十年左右的时间里,包括理论、计算和实践在内的多个研究领域,探讨了学习和压缩之间的相互作用。一些作品探讨了深度学习时代信号模型的作用,试图理解深度网络和非线性、多模态数据结构之间的相互作用。其他人则将这些洞察应用于原则上设计深度架构,将数据中所需的结构融入学习过程中。还有其他人把通用深度网络视为他们自己的首要任务,探索如何压缩和稀疏模型以提高效率,这通常伴随着硬件或系统意识的共同设计。在这些环境中,理论工作以低维建模为基础,开始解释深度架构和有效学习的基础,尽管存在”超参数化”和其他阻碍。最近,基础模型的出现使一些人认为,简洁和压缩本身是智能系统学习目标的一个基本部分,与神经科学中关于压缩作为大脑代表世界感知数据的指导原则的观点相连接。

总的来说,这些工作线路到目前为止在一定程度上是相互孤立发展的,尽管它们共享同一基础并且以简洁和学习为目的。我们组织这个会议的意图就是要解决这个问题并且更进一步:我们设想这个会议作为一个一般的科学论坛,其中机器学习、应用数学、信号处理、优化、智能系统,以及所有相关的科学和工程领域的研究人员可以聚集,分享洞察,最终朝着一个共同的现代理论和计算框架努力,从简约学习的视角理解智能和科学。

如果你对此感兴趣,这里奉上官网,可以关注起来了:

https://cpal.cc/

— 完 —

- 马斯克冲刺机器人量产,果断停产特斯拉豪华车型!2026年资本支出将“非常大”2026-01-29

- 那个用半成品刷爆SOTA的Qwen3超大杯推理版,现在正式上线2026-01-26

- “DeepSeek-V3基于我们的架构打造”,欧版OpenAI CEO逆天发言被喷了2026-01-26

- 斯坦福「返老还童」新研究:无需干细胞,逆转关节损伤和老化2026-01-25