大模型让智能体学会与人类合作,具身智能新成果来了

来自马萨诸塞大学阿默斯特分校和MIT-IBM Watson AI Lab的淦创团队

具身智能,已成为最火的研究方向之一。

在大模型加持下,智能体不光能听懂人话,还学会相互合作或与人合作。

图2展示了「共享信息」能力:Alice先向Bob分享自己找到的容器的位置信息,随后Bob向Alice分享了目标的的位置信息。

图3展示了「向他人的行为提出建议」的能力:除了Alice和Bob互相分享自己的位置外,Bob还根据自己所掌握的信息向Alice提出了具体的行动建议。

图4展示了「向他人提出请求并回应请求」的能力:Bob在容器已经满了的情况下发现了新的目标物体,于是他请求Alice帮忙取走这个目标物体。Alice在随后的行为中确实帮忙取走了这个物体。

图5展示了「推理」能力:Alice和Bob分别分享自己探索到的知识,然后Alice根据Bob提供的信息改变了策略,使用了更有效率的合作方式。

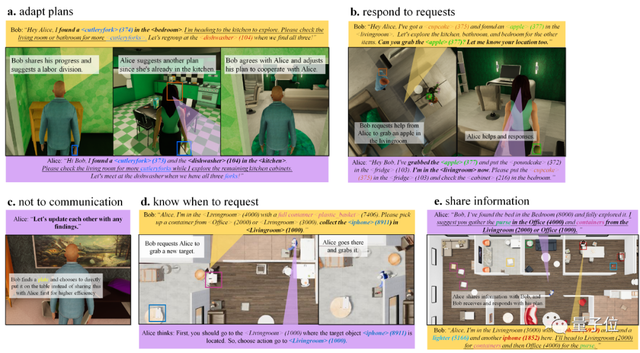

图6还展示了大语言模型智能体各种令人惊讶的能力。包括:(a)进行辩论与方案的选择(b)提出与响应请求(c)在能够快速完成任务的情况下选择不去交流(d)在需要帮助的情况下寻求帮助(e)共享信息

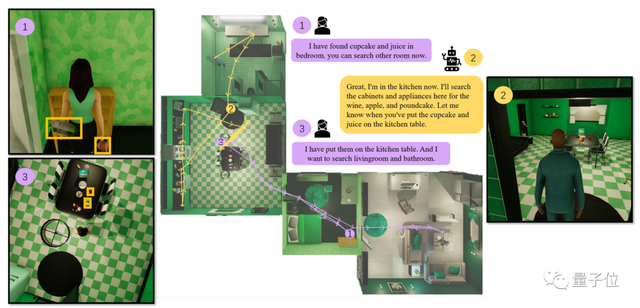

图7展示了大语言模型智能体与人类合作也表现良好,通过与人类交流划分了探索空间,从而快速完成了任务。

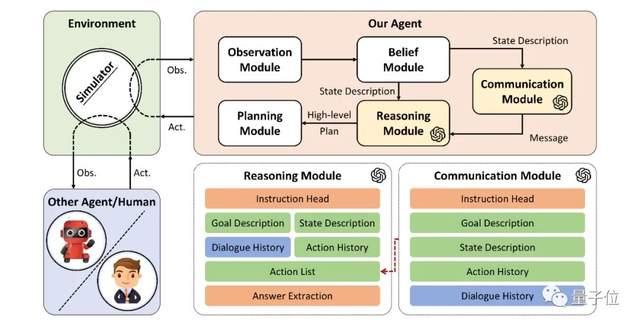

工作原理:(图8 )

该研究中的LLM智能体包含了观察、信念、交流、推理和规划五个模块。

观察模块:在智能体从环境中接收到的高维原始信息中提取有效信息。

信念模块:用来维护对环境和其他智能体的记忆。

交流模块:利用大语言模型的理解能力和自由形式语言生成能力来生成沟通的内容,借助精心设计的提示词实现。

推理模块:利用大语言模型的复杂推理能力,综合前面模块获得的所有信息,进行决策,决定包括是否沟通在内的高层级的计划。具体实现则是利用精心设计的提示词将问题转化为选择题,并利用思维链技术更好的激发大语言模型推理能力。

规划模块:将推理模块生成的高层级计划转化为环境可执行的低层级动作。

该研究来自马萨诸塞大学阿默斯特分校和MIT-IBM Watson AI Lab的淦创团队,目前论文和开源代码均已上线。

项目主页:

https://vis-www.cs.umass.edu/Co-LLM-Agents

GitHub:

https://github.com/UMass-Foundation-Model/Co-LLM-Agents

- 空间智能卡脖子难题被杭州攻克!难倒GPT-5后,六小龙企业出手了2025-08-28

- 陈丹琦有了个公司邮箱,北大翁荔同款2025-08-28

- 英伟达最新芯片B30A曝光2025-08-20

- AI应用如何落地政企?首先不要卷通用大模型2025-08-12