过去一年,ChatGPT出圈,AI for Science概念流行,AIGC成为行业内最高频的词汇。走在北京五道口地区,方圆几公里内,就坐落着近10个大模型创业公司。据最新媒体统计报道显示,我国目前已有超百个大模型问世发布。可以说,以深度学习为代表的新一代人工智能和以大模型为代表的通用人工智能将成为智能产业的根技术和智能经济的基础设施。

众所周知,在这场名副其实的“百团大战”背后,是大量看不见的计算力竞争。在ChatGPT的研发上,微软就曾在Azure的六十多个数据中心部署了几十万张GPU,为OpenAI单独使用。但与此同时,在基于海量数据进行的训练与优化过程中,还有一个性能同样至关重要,那就是数据存储。

AIGC创新升级 亟需“工事利器”为训练加速

算力是生产力,数据是核心生产要素,作为数据的载体,存储成为AI大模型的关键基础设施,只有实现存算协同优化,才能在良好的“地基”上稳建“高楼”。但目前行业企业在大模型开发及训练过程中仍然面临诸多难题,而这些难题大部分来自于存储挑战。

其中,最重要的问题还是根本上的存储技术挑战。AI大模型相比以往深度学习系统,模型参数与训练数据大幅提升,模型训练便需要使用GPU本地存储之外的外部存储,如果外部存储中的数据加载速度慢,就会极大地影响训练时间。此外,随着算力的大规模部署及模型参数的频繁调优,因主动或其他意外导致被动的训练中断会频繁发生,每天都会面临训练过程的中断。因此,checkpoint等参数信息的保存及快速加载便极为重要,高价值的信息与数据只有被更好的存储,才能被最好的利用。

XDS首创问世 率先构建数据交互高速通路

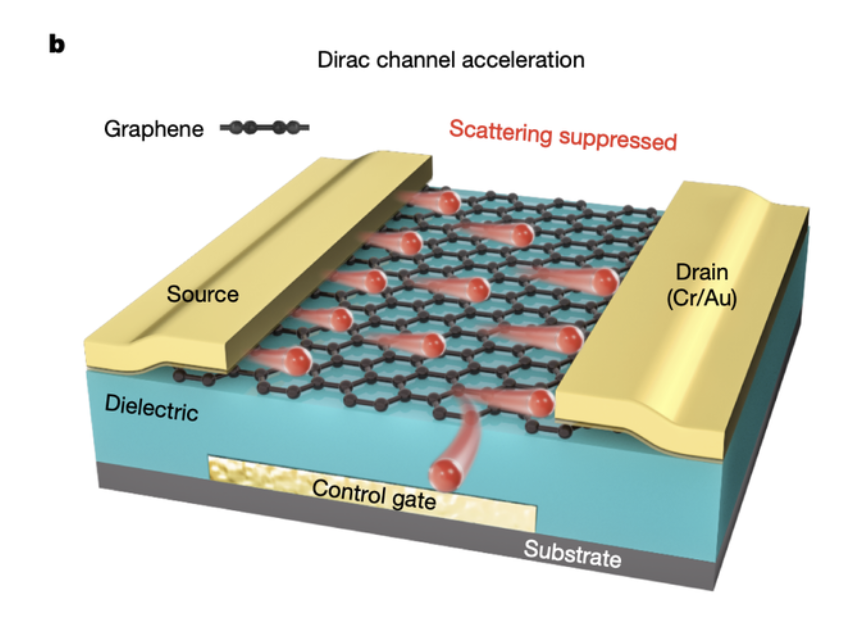

面对AI时代下行业对先进存力的呼唤,部分优秀的存储企业已率先发力。近日,曙光存储面向数据集加载效率及稳定性提升等存储需求,发布高端分布式存储系统ParaStor300S最新迭代升级方案,提供基于算力和存力端的多级智能加速技术,可高效发挥算力与存力的协同,保证算力能够快速抵达存力,打通数据通路最后一公里,保证AI算力效率的最大化。其中包括算力端的XDS(NPU/GPU/Direct Storage)和客户端MEM-Based加速,以及存力端的ParaBuffer引擎和存储节点内嵌NVMe SSD-Based加速能力。

最值得一提的是,XDS是国内解决方案中可率先实现主流厂商的智能芯片到存储之间数据快速交互的技术。基于该技术,训练数据能够以Storage Direct的方式直接加载到智能芯片中,避免在IO过程中使用CPU缓存做copy转发,提高训练过程中数据集的加载及处理速度。以往提到相关技术,行业中普遍意义上是指GDS(GPU Direct Storage),但此次曙光存储所发布的最新XDS技术,以“X”代表多种不同的可行性,包括算力端支持业界多款AI芯片与存储的直接访问、算力端内存/固态硬盘加速及存力端的高效加速节点ParaBuffer和NVMe SSD缓存加速技术。在未来持续的智能应用创新中,具备多重的加速能力与更广泛的通用性,可以预见训练效率在这种更直接的传输技术下,无疑将实现几何倍数提升。

此外,针对目前存储中诸如多样性协议管理、数据智能分级生命周期管理及数据安全等其他存储难题,曙光ParaStor300S也拥有对应解决方案。通过多协议访问、热温冷数据智能分级流动存储及全栈自研的安全大模型平台,为企业提供先进存力支撑。

目前,曙光先进存力已为国内某人工智能新经济独角兽大模型平台提供PB级全闪高性能存储资源池。针对客户端众多操作系统类型,快速定制开发统一的POSIX软件包,让每个客户端性能不掉队。同时,曙光存储还为该客户提供包含慢盘、坏块、磨损度、延迟、丢包率和误码率等多维度检测能力。最后,通过全局磨损均衡、实时状态监控与逆磨损均衡等功能,可大幅提升全闪分布式存储固态硬盘耐久性,保证业务连续性与系统安全,充分支持大模型训练与迭代。此外,在智能制造领域,曙光存储也持续深耕,正在加速多场景产业应用落地。

— 完 —