智源发布超3亿对面向中英文语义向量模型训练数据集

BGE语义向量模型更新了

链接大模型与外部知识,通用语义向量模型是决定大模型性能的关键组件。由“关联文本”为基本元素的优质训练数据,是生产通用语义向量模型的核心要素。

智源研究院发布大规模文本对训练数据集MTP(massive text pairs),开放热门语义向量模型BGE训练所用的超3亿条中英文数据,以规模巨大、主题丰富、数据质量高为特点,推动语义向量模型训练高质量发展。

智源BGE中英文语义向量模型

开源可商用,自发布以来,即凭借优秀的中英文语义检索精度与整体语义表征能力成为广受社区欢迎的语义向量模型:

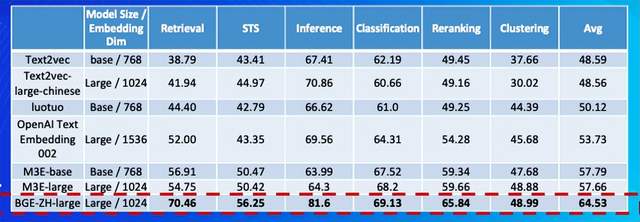

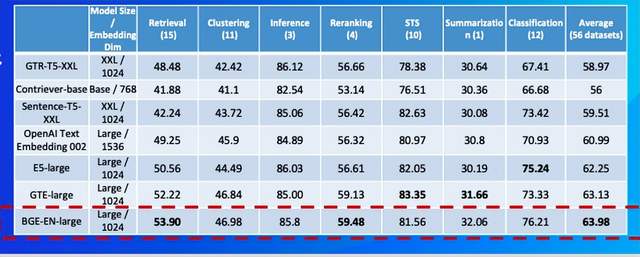

– 大规模向量模型权威排行榜 MTEB上排名稳居第一

– Hugging Face 累计下载量达到数十万

– 被LangChain, LangChain-Chatchat, llama_index 等多个知名开源项目集成

与此同时,BGE模型回应社区反馈、快速迭代,带来一系列升级更新。

MTP数据集链接:

https://data.baai.ac.cn/details/BAAI-MTP

BGE 模型链接:

https://huggingface.co/BAAI

BGE 代码仓库:

https://github.com/FlagOpen/FlagEmbedding

秉承 BAAI 数据集开源传统,3亿中英向量模型训练数据开放

数据在大模型训练中至关重要,构建高质量开源数据集,特别是用于训练基础模型的开源数据集对大模型发展意义重大,然而中文社区却鲜少数据开源贡献者。

本次发布的全球最大语义向量模型训练数据MTP,具备如下特征:

- 规模巨大:3亿文本对,中文1亿,英文2亿。

- 主题丰富:源自海量优质文本数据,涉及搜索、社区问答、百科常识、科技文献等多种主题。

- 数据质量高:数据经过必要的采样、抽取、过滤获得;由该数据训练得到的语义向量模型BGE (BAAI General Embedding)性能大幅领先同类别模型。

详情参见MTP数据集:

https://data.baai.ac.cn/details/BAAI-MTP

建设高质量中文数据集、推动数据资源开源开放是智源来持续贡献的方向。

- 2021年,智源推出全球最大语料库WUDAO copora ,开放200GB高质量低风险中文语料,由400余个产学研单位合作,已有770多个研发团队申请,为微软、哈佛大学、斯坦福大学、华为、阿里巴巴、腾讯、鹏城实验室等提供数据服务,有效支撑全球大模型相关研究。

- 今年开放的最大规模、可商用、持续更新的中文开源指令数据集COIG,由来自全球40余个机构的100多名工程师共同参与,创造了跨越国界、紧密合作的全球数据开源动人故事。

目前,智源亦在推动各方共建大规模高质量中文数据库,以盘活我国高质量中文数据资源,加快数据处理相关标准、技术、工具和支撑平台研发,提高数据处理效率。

下载达数十万,被LangChain集成,广受欢迎的BGE模型升级更新

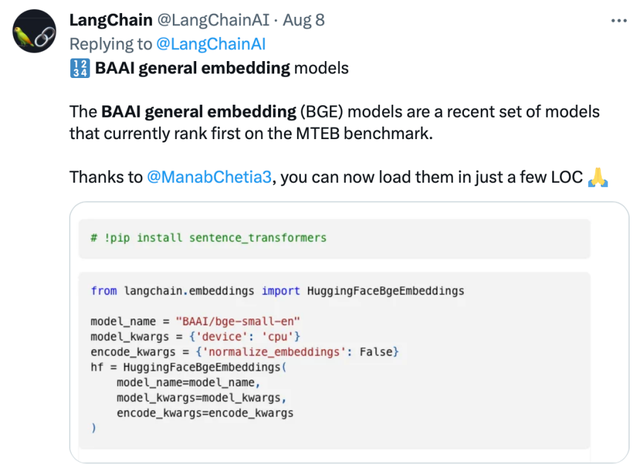

BGE 语义向量模型一经发布就备受大模型开发者社区关注,目前Hugging Face累计下载量达到数十万,且已被LangChain, LangChain-Chatchat, llama_index 等知名开源项目集成。

了解更多:

《链接大模型与外部知识,智源开源最强语义向量模型BGE 》

中文语义向量模型评测(C-MTEB)

英文语义向量模型评测榜(MTEB)

Langchain官方推文:“BGE模型在MTEB基准上排名第一”。

LangChain联合创始人兼首席执行官Harrison Chase推荐

Deep trading 创始人Yam Peleg 表示:“BGE在(推出)不到一周时间超越了之前的领先模型,创下新纪录”。

基于社区反馈,BGE进一步优化更新,表现更加稳健、出色。具体升级如下:

- 模型更新。BGE-*-zh-v1.5缓解了相似度分布问题,通过对训练数据进行过滤,删除低质量数据,提高训练时温度系数temperature至0.02,使得相似度数值更加平稳 。

- 新增模型。开源BGE-reranker 交叉编码器模型,可更加精准找到相关文本,支持中英双语。不同于向量模型需要输出向量,BGE-reranker直接文本对输出相似度,排序准确度更高,可用于对向量召回结果的重新排序,提升最终结果的相关性。

- 新增功能。BGE1.1增加难负样本挖掘脚本,难负样本可有效提升微调后检索的效果;在微调代码中增加在微调中增加指令的功能;模型保存也将自动转成 sentence transformer 格式,更方便模型加载。

值得一提的是,日前智源联合Hugging Face发布了一篇技术报告,报告提出用C-Pack增强中文通用语义向量模型。

《C-Pack: Packaged Resources To Advance General Chinese Embedding》:

https://arxiv.org/abs/2309.07597

- 这么哇塞的世界模型,竟然是开源的!2026-01-29

- 机器人看不清,蚂蚁给治好了2026-01-27

- 蚂蚁具身智能明牌了:做大脑,和宇树们错位竞争2026-01-28

- 曦望发布推理GPU S3:All-in推理的国产GPU,开始算单位Token成本2026-01-27