360人工智能研究院发布中文原生AI绘画模型BDM:解决当前中文AI绘画两大核心痛点

已上线360智脑平台

360人工智能研究院(隶属于360集团技术中台)于近日公开了中文原生AI绘画模型BDM,同时解决了当前中文绘画的两大核心痛点:即AI绘画模型的无法精准生成中文概念的问题,以及难以和英文社区成果兼容的问题。既往的中文AI模型技术路线均无法兼顾二者。360人工智能研究院自研的BDM模型,利用“主干-旁支”网络结构,不仅可以精确的生成中文语义图片,同时又保持了和英文社区之间的互通性。相关技术成果通过论文发布[1],并已上线360智脑平台(https://tu.360.cn/)。

2022年基于扩散模型的图像生成技术的突破,迅速引发了一场全球性的图像AIGC研发热潮和应用变革,包括Stable Diffusion(以下简称SD模型)、DALLE-2以及Midjourney。当前中文绘画模型仍处于追赶阶段,并且多数技术路线为基于主流开源英文模型的微调、甚至仅做翻译,其中主要的原因是大规模算力及训练数据的投入使得从头使用中文训练的成本极高:以SD2.1为例,根据公开资料[2]: SD2.1仅base模型的训练就动用了256块A100 GPU,训练折算20万卡时,共28.7亿的图文样本训练量。

但是,以SD为代表的英文AI绘画模型,包括且不限于SD1.4/1.5/2.1以及DALLE-2[3]、Midjourney[4]等都普遍带有明显的英文世界偏见问题。该问题包括两个方面:第一,中文概念无法被英文AI模型理解和准确生成,例如之前遭到网友们调侃的“车水马龙”、“红烧狮子头”[5]等现象;第二,人物形象偏白人、男性,物品、建筑、车辆、服饰、标志等等都普遍更像是西方世界场景。

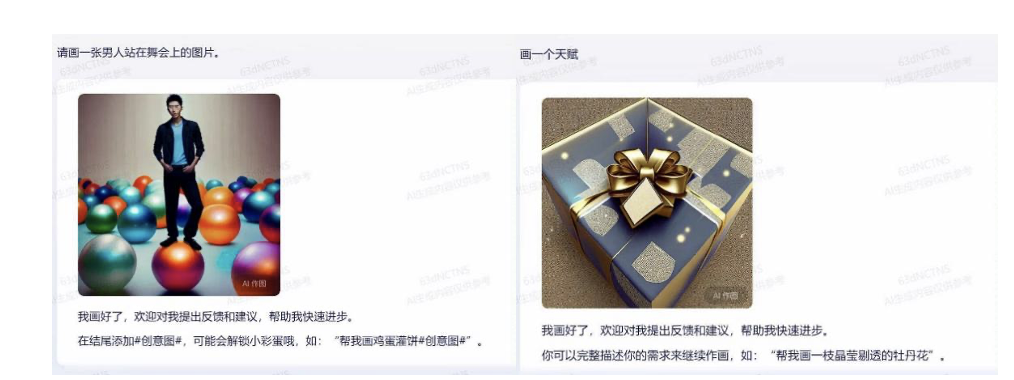

图1 国内友商B*最新版本的模型仍存在隐式翻译带来的英文多义词绘制混淆问题[6]

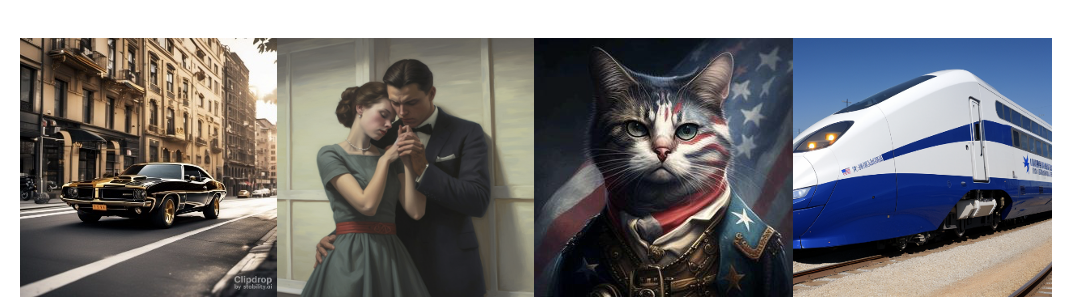

图2 英文AI绘画模型的世界观偏见示例,生成的车辆、建筑、人物、旗帜、标志等都具有明显的英文世界偏向。从左到右分别是:SDXL,Midjourney,国内友商B*,国内友商V*

基于SD等成熟模型进行中文模型开发的好处,是可以复用开源社区日新月异的已有成果:以开源模型Stable Diffusion为例,众多开源开发者和AI绘画爱好者已经形成了众多庞大的AI绘画社区,如Civitai,Stable Diffusion Online等等,并在这些社区中不断推出各种衍生工具和模型,形成推动AI绘画技术进步的重要力量。完全抛弃英文绘画模型,意味着放弃开源社区这一座“金矿”。

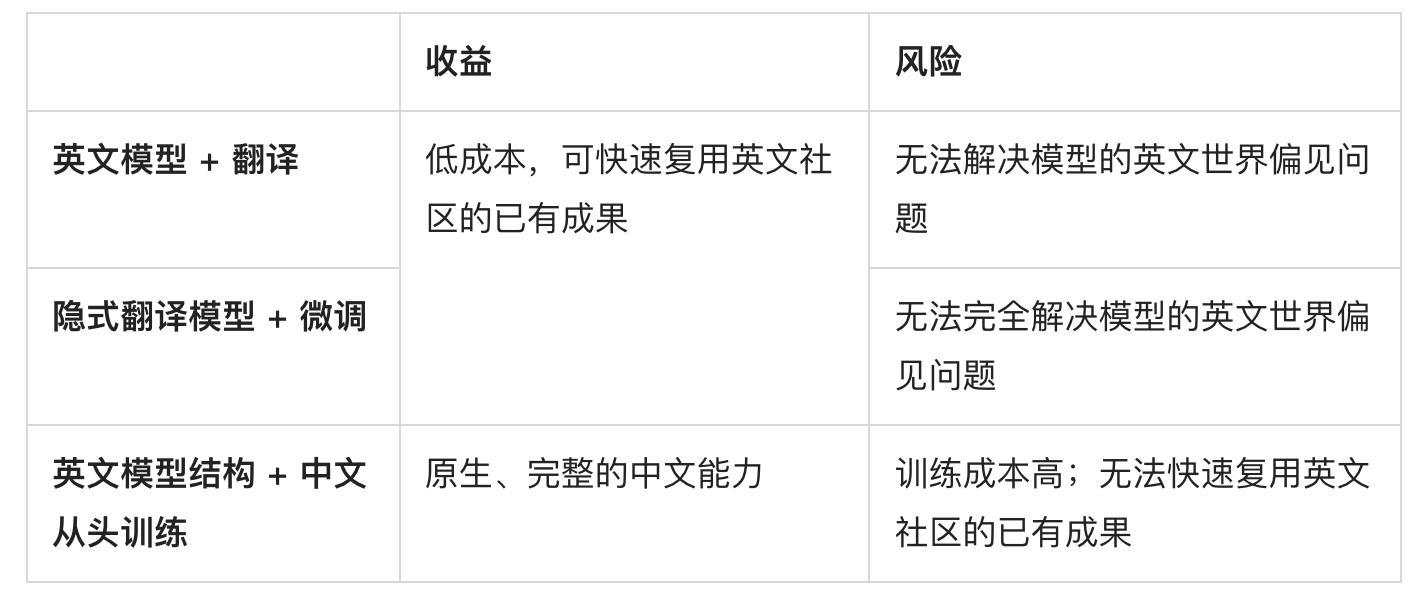

当前中文AI绘画模型的研发从易到难当前有如下的几种方式:① 英文模型 + 翻译、② 隐式翻译模型(中英平行语料训练翻译text encoder) + 微调、③ 仅保留英文模型结构 + 中文从头训练。各自的优缺点比较如下:

表1 当前中文AI绘画模型的不同路线选择及其优缺点比较

可以看到,这三种路线要么保证低成本、但无法保证中文能力或中文世界观;要么在高成本保证“中文原生”,但无法和日新月异的社区兼容。中文AI绘画模型似乎走到了一个两难的境地。

面对这个难题,360人工智能研究院提出了现有条件下的最优解。经过近半年的技术攻关,360人工智能研究院提出了一种新的扩散模型结构,称为“Bridge Diffusion Model”(BDM),以解决上述的困境。BDM不仅解决了英文模型的世界偏见问题,可以精确生成符合中国国情的中文语义图片,同时保持了和英文社区之间的互通性,无缝兼容各种英文SD社区插件——这也是命名中“Bridge”的由来。BDM通过类似ControlNet[7]的“主干-旁支”的架构结合原始英文模型,并使用360内部12亿中文图文数据训练。BDM本身采用SD1.5作为主干网络,并且可以兼容其它底模、LoRA模型及社区插件。基于BDM1.0能力开发的中文AI绘画产品“360鸿图”也已于9月21日公开上线,正式向公众开放,体验入口:https://tu.360.cn/。

此外,众所周知的,当前AI绘画模型对文本prompt的理解能力仍然存在非常显著的缺陷,要想得到好的生成结果,prompt指令更多的是各种关键词/魔法词的堆砌,与人类交流中使用的自然语言仍相去甚远。提升AI绘画模型对prompt指令的遵循能力,也是360人工智能研究院目前在多模态大模型SEEChat(开源地址:https://github.com/360CVGroup/SEEChat)与AIGC结合方面着力的重点。

BDM模型详细介绍:

1) 模型框架

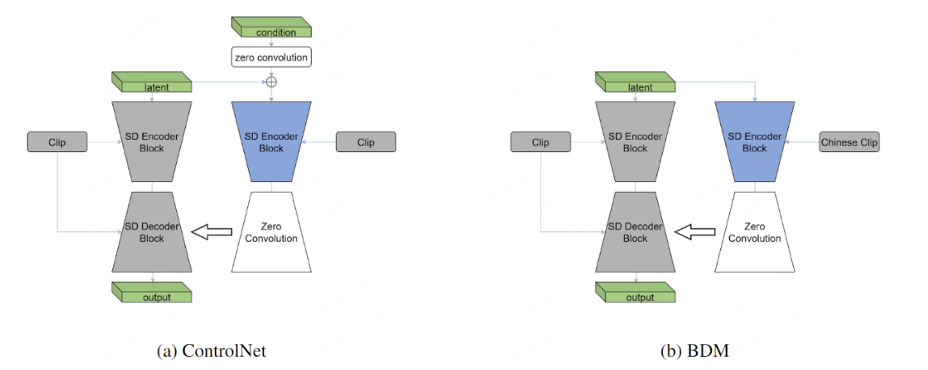

BDM采用类似ControlNet[8]的主干-旁支网络结构,如图3(b)所示。其中主干网络采用Stable Diffusion 1.5的结构并使用其预训练参数进行初始化,旁支网络则是由主干网络派生出来的可学习副本构成。与ControlNet相比,BDM在结构上的不同之处在于不存在旁支中的条件图像卷积层,这是因为在BDM中,中文prompt是通过旁支网络而非主干网络进行处理。

我们选择了Chinese CLIP text encoder[9]做为中文的文本编码器。主干网络的英文text encoder可以去掉只通过旁支网络支持中文prompt,或者也可以保留从而实现中英双语的支持。在我们的实现中我们选择保留英文text encoder,因此BDM同时具备中英双语绘画的能力。BDM网络结构的一个关键优点在于,主干网络包含了完整的英文SD结构并在训练中冻结,因此BDM的隐空间与英文SD模型保持一致,从而可以无缝兼容各种适配于英文SD模型的社区插件。

图3 ControlNet和BDM的网络结构图,左图是ControlNet,右图是BDM

2) 训练策略

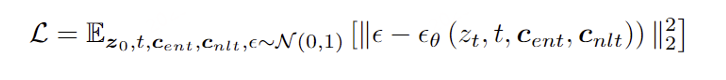

BDM的整体训练loss如图4所示,扩散模型[10]算法学习一个网络εθ,以根据一组条件来预测添加到带噪图像zt中的噪声,这些条件包括时间步长t,用于主干的文本输入cent以及用于旁支的文本输入cnlt。

然而仅有这样的网络结构和训练目标是不够的,因为在训练过程中同时将语义信息注入到主干和旁支并不可行,这是由于经过预训练的主干已经包含了强大的英文语义信息,这会阻碍旁支的中文语义学习。因此,BDM使用了一个关键的训练策略——训练阶段主干的文本输入始终为空字符串,即cent始终为“”。这是因为在SD1.5训练过程中,文本输入有10%的概率置为空,因此可以认为空字符串对应的隐空间是SD1.5生成图像整体的平均隐空间。对于BDM,主干提供英文模型的平均隐空间,同时旁支在这个空间中学习中文语义,寻找中文语义在英文空间中的偏移,这样就真正将BDM中文原生模型和英文社区有机的结合在了一起,使得BDM可以无缝接入英文社区。

图4 BDM训练loss

3) 推理策略

在训练阶段,主干参数始终锁死,主干文本输入也始终为空字符串,但在推理阶段可以有很多不同的选择。

首先我们可以将主干的正/负文本输入都设置为空字符串,这和训练阶段保持一致,只用中文正/负输入来注入语义。我们观察到,对于训练早期的BDM模型,推理阶段在主干使用通用的正/负文本输入显著改善了图像质量;然而对于训练末期的BDM模型,中文旁支已经得到了充分训练,英文正/负输入对图像质量的影响就很小了。当然,为了实现更好的生成效果,中文和英文的正/负输入都可以根据用户的需求进行自适应调整。

BDM也可以和英文社区的各种插件无缝结合。当结合LoRA[11]时,将LoRA模型嵌入到BDM主干结构中即可,和常规的英文模型嵌入LoRA方式相同,然后从旁支输入所需中文提示即可。如果LoRA包含触发词,那么推理时候需要将触发词输入到主干中。同样,当结合ControlNet时,可以将ControlNet分支嵌入到BDM主干上,这样就形成了主干—双旁支结构。当结合checkpoint或者Dreambooth[12]时,把BDM主干从SD1.5切换到对应的底模即可。结合Textual Inversion[13]时,可以直接把对应的embedding加载到主干的文本输入中即可。以上操作可以根据需求任意组合。

4) 效果展示

如图5是BDM使用SD1.5和realisticVisionV51[14]分别作为主干来生成中文概念,可以看到中文独有概念以及英文多义词概念都生成的很合理。

图5 中文概念生成事例

如图6是BDM分别用不同风格的checkpoint[15][16][17][18]作为主干进行生成,由于不同模型生成特定风格所需条件不同,比如有的需要触发词,有的需要风格词,推理时候中/英文正/负输入会根据风格条件进行微调,以达到更好的效果;但可以肯定的是,微调的文本只涉及触发词或者风格词,具体图像内容只会从中文文本来输入。

图6 不同风格checkpoint效果

如图7是BDM分别结合不同LoRA[19][20][21]进行生成

图7 不同风格LoRA效果

如图8是BDM结合ControlNet[22]的生成

图8 结合ControlNet效果

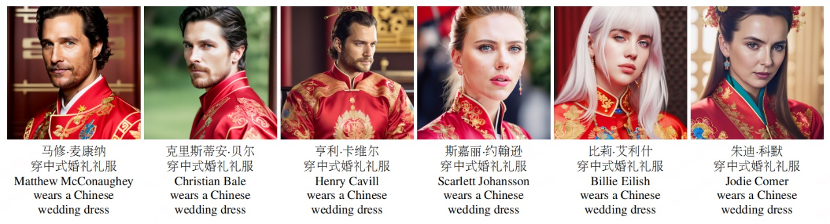

如图9是BDM结合不同Dreambooth的生成,使用了6个名人的底模[23]。

图9 不同Dreambooth效果

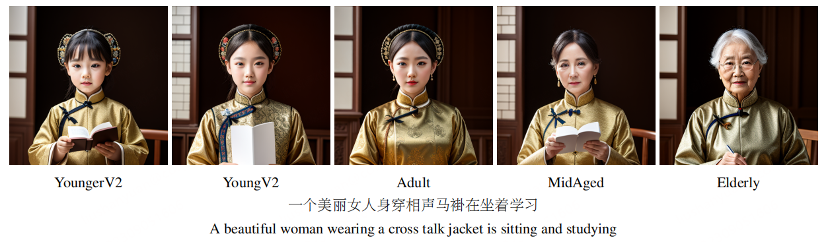

如图10是BDM结合Textual Inversion[24]的生成,使用了年龄调节Textual Inversion。

图10 不同Textual Inversion效果

360人工智能研究院简介

360 人工智能研究院隶属于 360 技术中台,自 2015 年成立以来积累了大量人工智能与机器学习前沿能力,多次荣获 AI 相关比赛冠军 / 提名奖项,发表顶会、顶刊论文数十篇。研究院提供智能安全大数据、互联网信息分发、企业数字化、AIoT等360 集团全量业务场景支持,支持千万级硬件设备,亿级用户,产生千亿规模数据量。2023 年着重攻坚大语言模型、CV 大模型和多模态大模型,为 360 集团和行业 AIGC 技术发展应用提供底层技术支撑。

- 商汤开源 SenseNova-MARS,突破多模态搜索推理天花板2026-01-30

- 千问C端应用团队一口气四篇论文入选ICLR 2026国际顶会!2026-01-30

- 腾讯混元再引强将,庞天宇即将入职多模态模型团队负责强化学习前沿算法探索2026-01-30

- 让世界模型直接控制机器人动作,蚂蚁灵波开源具身世界模型LingBot-VA2026-01-30