提示工程夭折?MIT斯坦福让大模型主动提问,自己搞懂你想要什么

AI反向提示人类

明敏 发自 凹非寺

量子位 | 公众号 QbitAI

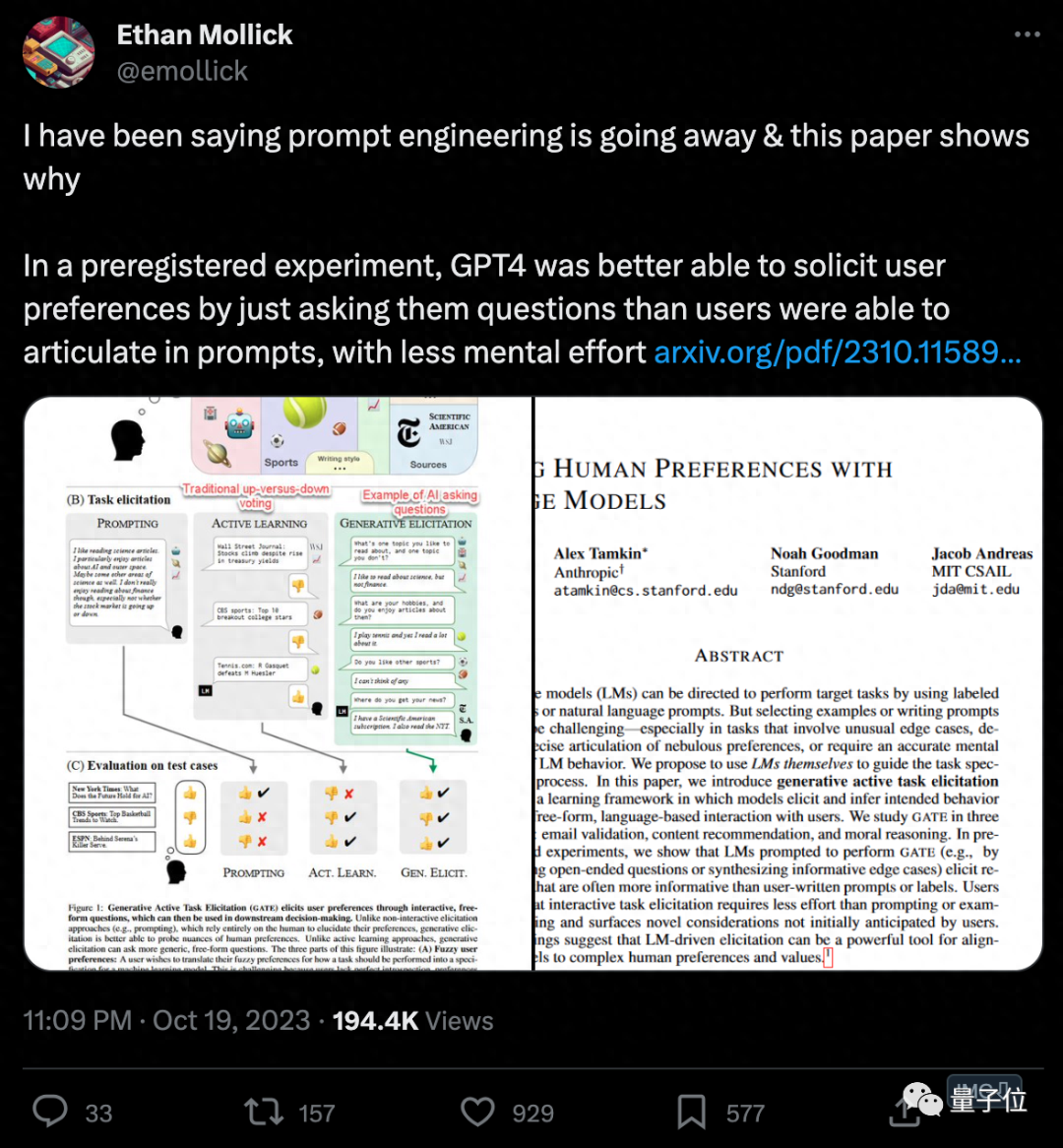

我就说嘛,提示工程正在消失,这篇新研究即可解释原因。

AI圈百万粉丝大V的一条推特,可把大家给惊到了。

要知道,提示工程可是ChatGPT趋势中的大热词。由它衍生出的新岗位提示工程师年薪可高达几十万美元,“未来人人都要学会提示工程”的观点更是引发热议……

结果现在,提示工程就开始消失了???

而且有理有据。

博主伊森·莫利克提到的这篇论文,由MIT、斯坦福和Anthropic(Claude2打造者)共同提出。

论文提出了一种新型的机器学习框架,能让大模型学会主动向人类提问,自己搞明白用户的偏好。

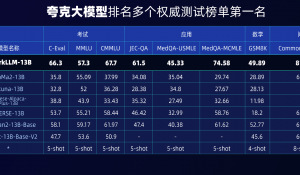

他们使用GPT-4进行实验,结果发现和提示工程、监督学习等方法比,在这个框架的辅助下GPT-4在多个任务上更懂人类了。

如果大模型能更容易揣度出人类想啥,也就意味着人类自己不用绞尽脑汁表达自己的想法了。

所以伊森·莫利克觉得,这不就不用每个人都去学习提示工程了么?

有网友补充说,这是不是说某种程度上,我们未来是不是可以不用语言和LLM进行交流。让大模型通过提问来弄清楚我们在想什么,这真是一个巨大的进步。

让AI来提示你

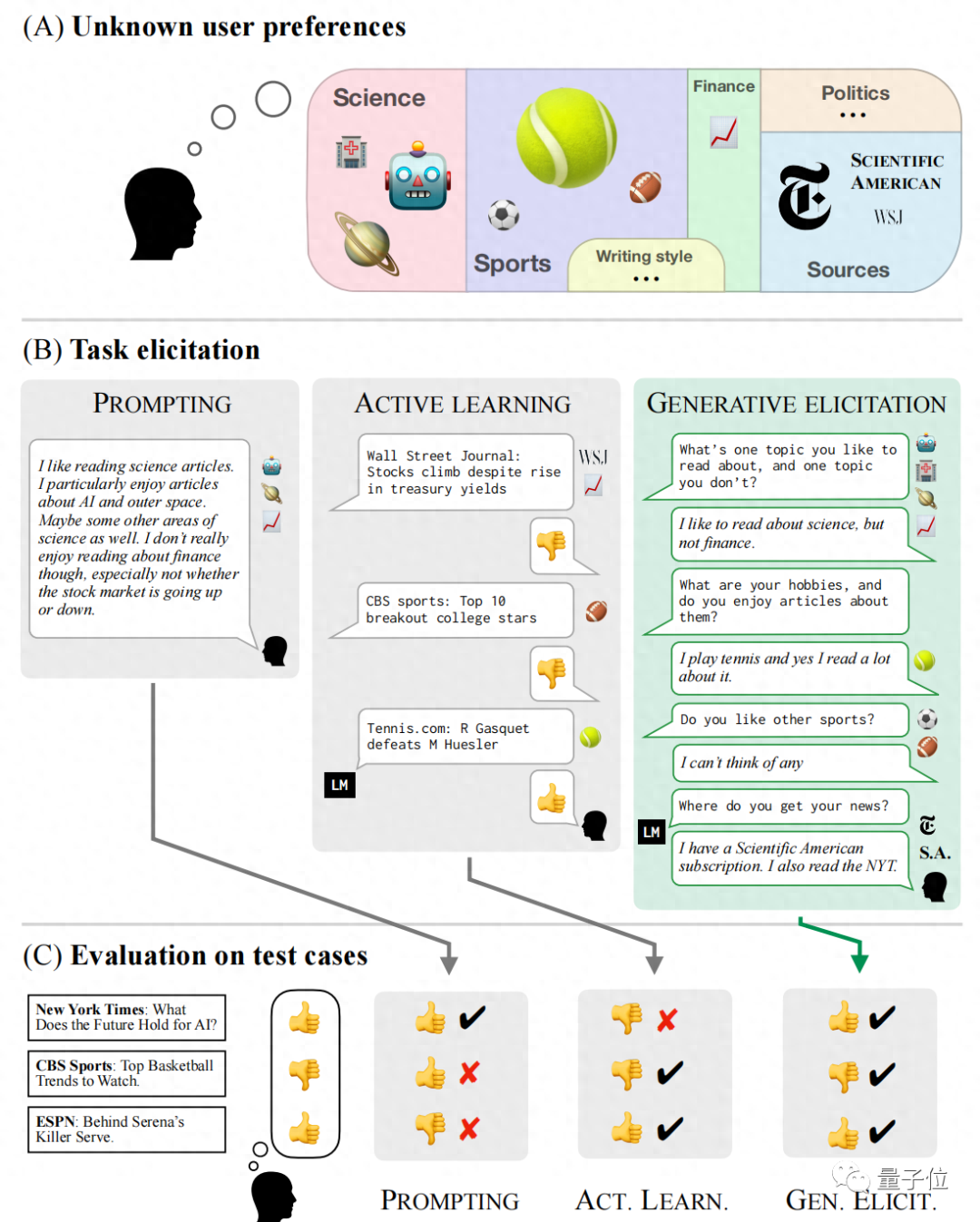

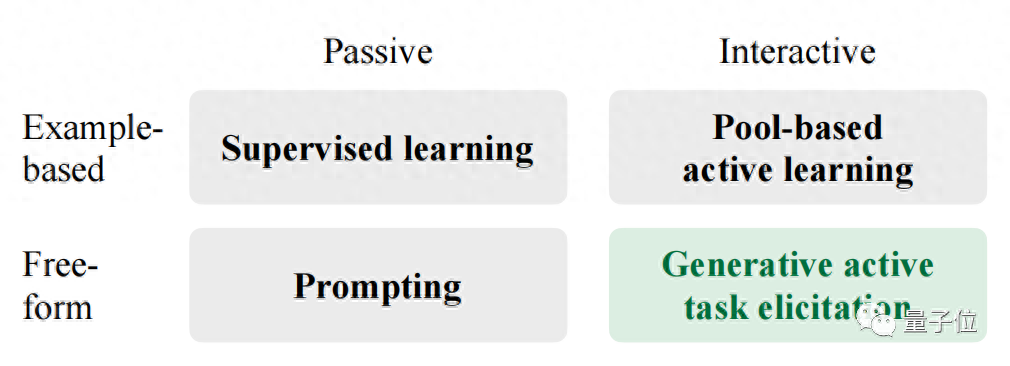

具体来看,这项研究提出了一种新型学习框架GATE(Generative active task elicitation)。

它能基于大模型本身的能力,来引出、推理人类用户的喜好。

研究团队将这称为一种更主动的方式,具体表现形式就是让大模型来对用户提问,以让人类的偏好想法能更加明确地被表达出来。

对应来看,监督学习和提示工程都属于被动的方式,监督学习和少量主动学习还要基于示例。

为什么要“反客为主”提示人类?

因为人类给出的提示存在局限性,不一定能准确完整表达出自己的喜好。

比如很多人都不懂提示工程;或者在提示过程中提供了存在误导性的资料……这些都会导致大模型表现变差。

论文中列举了一个例子。假如一个用户说自己很喜欢读网球相关的文章,对网球巡回赛、发球技术感兴趣。但是从他提供的文章参考里,无法判断他是否对网球方面的其他话题感兴趣。

所以,如果大模型能学会一些提问技巧,就能将用户的偏好锁定在更小范围内。

本项研究让大模型尝试了多种提问方式,比如主动生成用户标注的样本、是非类提问、开放式提问等。

主要测试的任务为内容推荐、道德推理和邮箱验证。

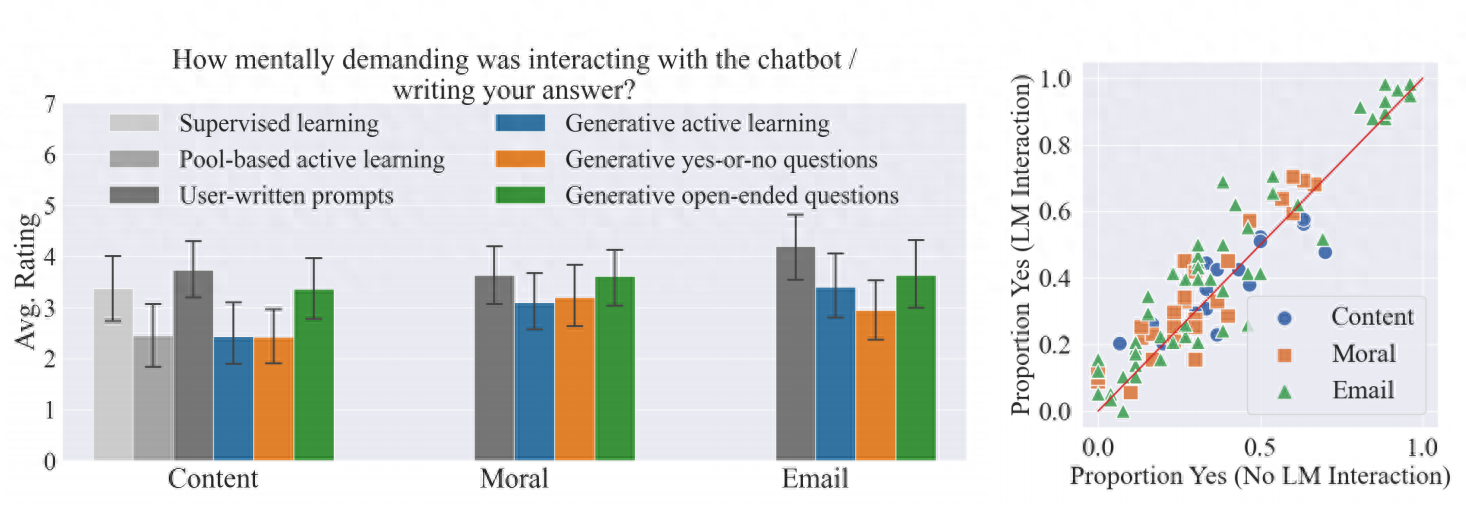

结果显示,在三项任务中,GATE包含的办法效果都优于其他方法。

使用这一框架的大模型,使用起来也不那么“烧脑”了(如下左图)。

以及这种方法的引入也不会影响人类用户本来的偏好(如下右图)。

作者认为更大的模型可能是更好的引导者,实验中他们使用的是GPT-4。

如医疗、法律等需要做出复杂决策的领域,会是GATE框架未来拓展的方向。

本项工作由MIT、Anthropic和斯坦福学者联合推出。

“我们现在仍依赖提示工程”

而以这篇研究为核心,也引发了一波关于提示工程的讨论。

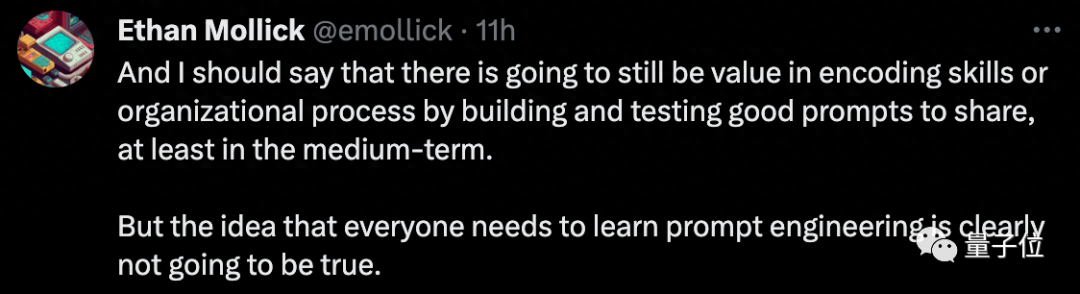

并不是所有人都赞同“提示工程正在消失”这一观点。

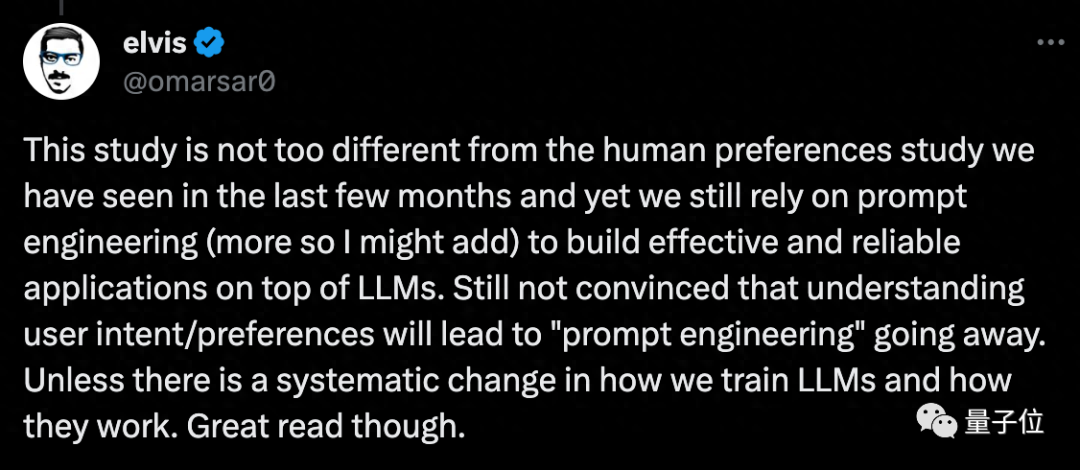

另一位AI圈大V elvis就表示,这篇研究和之前那些研究人类偏好的工作没有太大不同,我们现在还是要依赖提示工程。

我不认为“理解人类意图/喜好”会导致提示工程消失,除非LLM训练和工作的方式发生系统性变化。

也有人觉得提示工程只是会从前端消失,形式上发生改变。

还有人提问,要是提示工程消失了,那花重金雇佣提示工程师的人可咋办?

不过回到研究本身,的确提示工程对于很多人来说还是有难度,有网友觉得,这是阻碍很多人拥抱ChatGPT的一大原因。

你觉得呢?

论文地址:

https://arxiv.org/abs/2310.11589

参考链接:

[1]https://twitter.com/emollick/status/1715022305925984296?s=20

[2]https://twitter.com/iScienceLuvr/status/1714947314375372999?s=20

- DeepSeek-V3.2-Exp第一时间上线华为云2025-09-29

- 你的AI助手更万能了!天禧合作字节扣子,解锁无限新功能2025-09-26

- 你的最快安卓芯片发布了!全面为Agent铺路2025-09-26

- 任少卿在中科大招生了!硕博都可,推免学生下周一紧急面试2025-09-20