Stable Video Diffusion问世!3D合成功能引关注,网友:进步太快

代码权重已上线

西风 发自 凹非寺

量子位 | 公众号 QbitAI

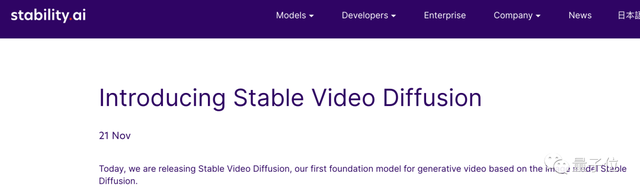

Stable Diffusion官方终于对视频下手了——

发布生成式视频模型Stable Video Diffusion(SVD)。

Stability AI官方博客显示,全新SVD支持文本到视频、图像到视频生成:

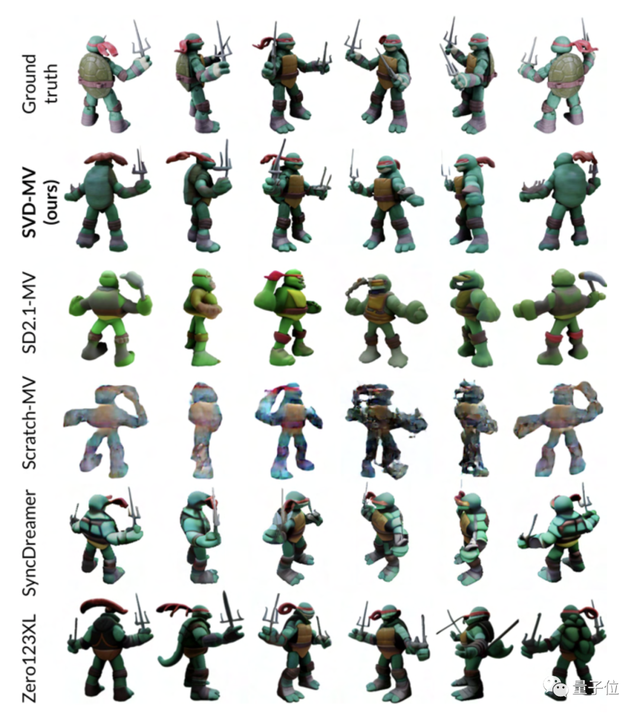

并且还支持物体从单一视角到多视角的转化,也就是3D合成:

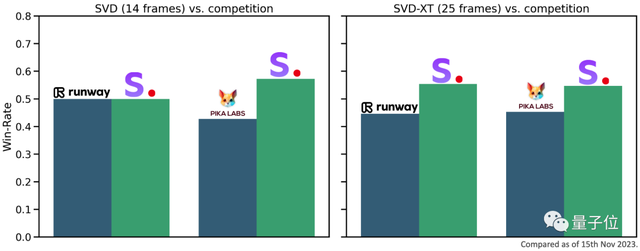

根据外部评估,官方宣称SVD甚至比runway和Pika的视频生成AI更受用户欢迎。

虽然目前只发布了基础模型,但官方透露“正计划继续扩展,建立类似于Stable Diffusion的生态系统”。

目前论文代码权重已上线。

最近视频生成领域不断出现新玩法,这次轮到Stable Diffusion下场,以至于网友们的第一反应就是“快”,进步太快!

但仅从Demo效果来说,更多网友们表示并没有感到很惊喜。

虽然我喜欢SD,而且这些Demo也很棒……但也存在一些缺陷,光影不对、而且整体不连贯(视频帧与帧之间闪烁)。

总归来说这是个开始,网友对SVD的3D合成功能还满是看好:

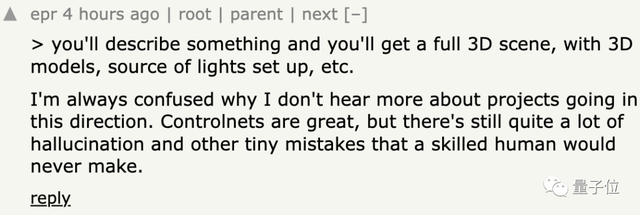

我敢打赌,很快就会有更好的东西出来,到时候只要描述一下,就会得到一个完整的3D场景。

SD视频官方版来袭

除了上面展示的,官方还发布了更多Demo,先来看一波:

太空漫步也安排上:

背景不动,只让两只鸟动也可以:

SVD的研究论文目前也已发布,据介绍SVD基于Stable Diffusion 2.1,用约6亿个样本的视频数据集预训练了基础模型。

可轻松适应各种下游任务,包括通过对多视图数据集进行微调从单个图像进行多视图合成。

微调后,官方公布的是两种图像到视频模型,可以以每秒3到30帧之间的自定义帧速率生成14(SVD)和25帧(SVD-XT)的视频:

之后又微调了多视角视频生成模型,叫做SVD-MV:

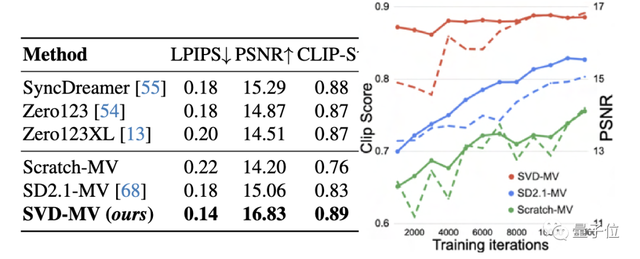

根据测试结果,在GSO数据集上,SVD-MV得分优于多视角生成模型Zero123、Zero123XL、SyncDreamer:

值得一提的是,Stability AI表示SVD目前仅限于研究,不适用于实际或商业应用。SVD目前也不是所有人都可以使用,但已开放用户候补名单注册。

视频生成大爆发

最近视频生成领域呈现出一种“混战”的局面。

前有PikaLabs开发的文生视频AI:

后又有号称“史上最强大的视频生成AIMoonvalley推出:

最近Gen-2的“运动笔刷”功能也正式上线,指哪画哪:

这不现在SVD又出现了,又有要卷3D视频生成的可能。

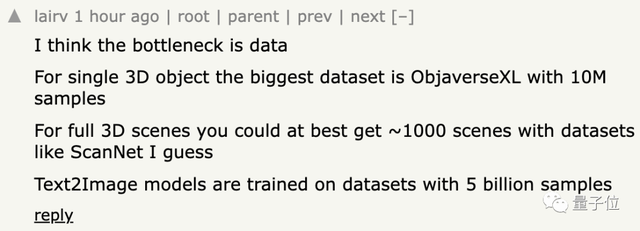

但文本到3D生成方面好像还没有太多进展,网友对这一现象也很是困惑。

有人认为数据是阻碍发展的瓶颈:

还有网友表示原因在于强化学习还不够强:

家人们对这方面的最新进展有了解吗?欢迎评论区分享~

论文链接:https://static1.squarespace.com/static/6213c340453c3f502425776e/t/655ce779b9d47d342a93c890/1700587395994/stable_video_diffusion.pdf

参考链接:

[1]https://stability.ai/news/stable-video-diffusion-open-ai-video-model

[2]https://news.ycombinator.com/item?id=38368287

- Moltbot作者被Claude刁难后:MiniMax M2.1是最优秀的开源模型2026-01-29

- 爆火Clawdbot被Claude公司强制要求改名2026-01-28

- 3D版Nano Banana来了!AI修模成为现实,3D生成进入可编辑时代2026-01-27

- 成立两年半登顶全球AI创作社区,背后是中国团队在“卖情绪”??2026-01-22