英伟达成立最壕AI实验室:Jim Fan领衔,专攻具身智能

“资金足够一次性解决难题”

金磊 发自 凹非寺

量子位 | 公众号 QbitAI

英伟达最新大动作来了——通用具身智能体。

这则消息是由英伟达高级科学家Jim Fan透露,他表示:

我将和老队友Yuke Zhu一起,在英伟达内部组建一个新研究小组——GEAR,通用具身智能体研究。

我们相信,在未来,每一台移动的机器都将是自主的,机器人和模拟智能体将像iPhone一样无处不在。

我们正在构建基础智能体:一个具有通用能力的AI,可以在许多虚拟和现实的世界中学习如何熟练地行动。

Jim Fan还强调,2024年将是属于机器人、游戏AI和模拟的一年。

而随着这两天英伟达市值暴涨,Jim Fan还补充了一条X说道:

我们有足够的资金一次性解决机器人基础模型、游戏基础模型和生成式模拟。

我们团队可能是全球最有钱的具身智能实验室。

嗯,有钱,很壕。

相关成果展示

Jim Fan在发布这条职业履新消息之际,也顺带把英伟达此前在具身智能所做的相关工作盘点了一波。

例如被评为“2023年英伟达十大项目”之一的Eureka——

用GPT-4生成奖励函数,教会机器人完成了三十多个复杂任务:比如,快速转个笔,打开抽屉和柜子、抛球和接球。

使用GPU加速的物理模拟进行训练,速度比实时快1000倍!

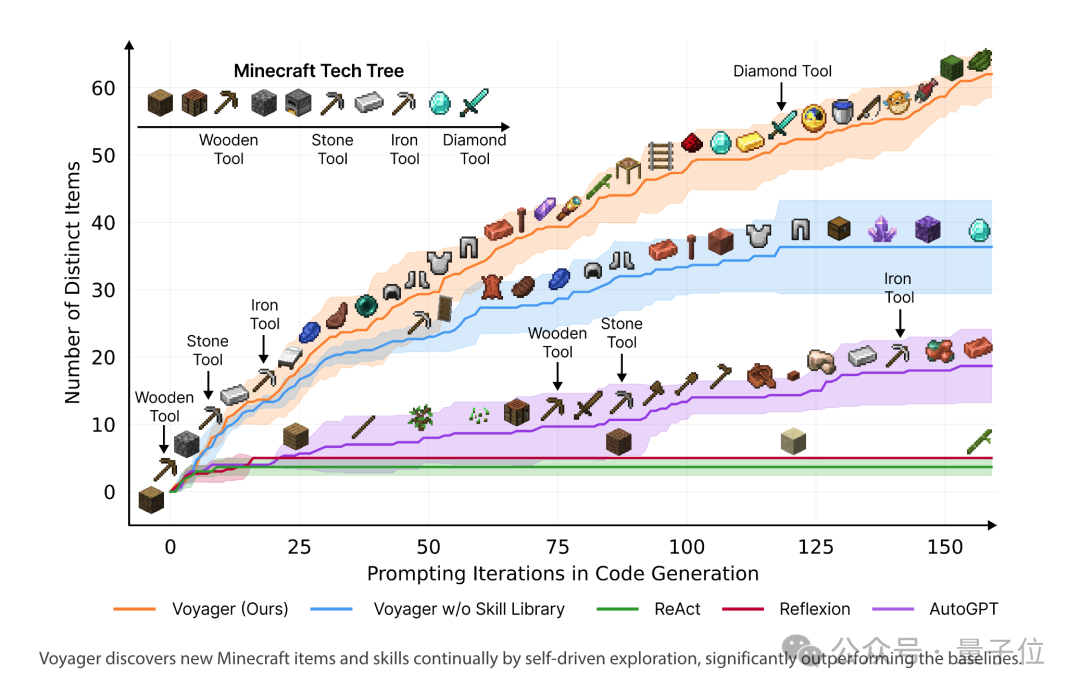

再如Voyager,把GPT-4放进《我的世界》——

在游戏中点亮科技树的速度是此前方法的15.3倍,同时获得的独特物品是此前的3.3倍,探索范围是2.3倍。

更关键的是,Voyager完全借助游戏画面推理,一切操作与反馈通过文本和游戏的Javascript API进行。

它也是第一个LLM驱动、能熟练玩《我的世界》的智能体。

除此之外,还包括斩获了NeurIPS 2022最佳论文的MineDojo。

这项研究提出一个由3个智能体组成的“具身GPT-3”,可以感知无限世界并在其中行动。

MineDojo是一个将《我的世界》变成 AGI 研究游乐场的开放框架。

团队收集了100000个 YouTube 视频、Wiki页面和Reddit帖子,用于训练《我的世界》智能体。

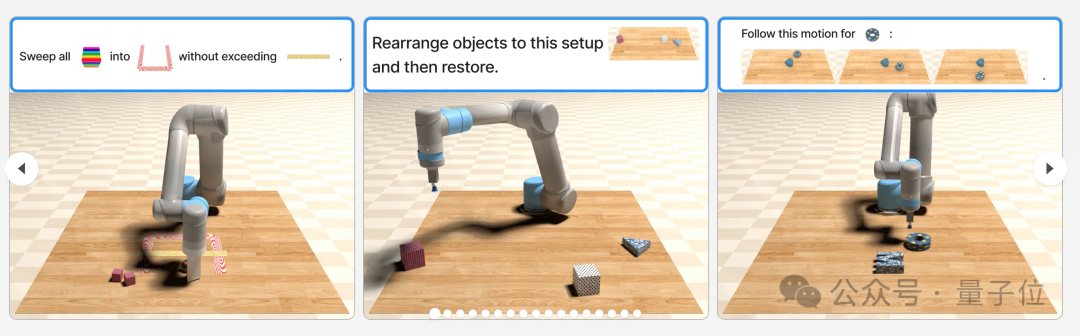

还有像VIMA这样的研究:第一个带有机械臂的多模态LLM,为机器人学习引入了“多模态提示”。

更多相关成果盘点,可以戳文末链接。

被黄仁勋带火的具身智能

其实Jim Fan领队搞通用具身智能体并不是非常意外的一件事情。

早在去年,黄仁勋便公开表达他对下一代人工智能的观点:

这种新型的人工智能叫做具身智能(Embodied AI),即能理解、推理和与物理世界互动的智能系统。

而从去年至今,无论是高校还是产业,具身智能相关的研究可谓是层出不穷。

最为典型的便是斯坦福大学的家务机器人,惊呆了一众网友。

那么Jim Fan团队将在今年再带来什么成果,是值得期待一波了。

参考链接:

[1]https://twitter.com/DrJimFan/status/1761052023821369639

[2]https://research.nvidia.com/labs/gear/

[3]https://twitter.com/DrJimFan/status/1761099207920992688

- 这么哇塞的世界模型,竟然是开源的!2026-01-29

- 机器人看不清,蚂蚁给治好了2026-01-27

- 蚂蚁具身智能明牌了:做大脑,和宇树们错位竞争2026-01-28

- 曦望发布推理GPU S3:All-in推理的国产GPU,开始算单位Token成本2026-01-27