大疆车载负责人新论文:摄像头激光雷达惯导一起上,实时渲染精准3D场景

多项指标实现新SOTA

曹原 发自 副驾寺

智能车参考|公众号AI4Auto

大疆车载负责人沈邵劼,带队发了一篇新论文。

随着高阶智驾开城进展加快,这给系统的高精定位、实时建图能力带来不小的考验。

在这样的背景下,来自香港大学、港科大、上交和北理的沈邵劼团队,基于摄像头、激光雷达和IMU,带来一种新方式:LIV-GaussMap。

通过这种方案实时构建出的地图,精度可以和照片媲美:

更重要的是,这种方法需要的硬件、软件还有团队收集的数据集,全部开源。

高精定位技术路线

以自动驾驶系统为例,模块化通常可分为三部分:感知、定位和规控。

经常提到的“重感知、轻地图”路线,这里的地图指的就是定位模块。

而自动驾驶等级越高,对于定位的精度要求也会越高。

因为精度越高,系统对周围环境了解越清楚,车道线、红绿灯等等都“一目了然”,才能更方便系统做出驾驶决策,并且是正确的决策。

一般来说,高精定位技术路线有三种,卫星信号定位(GNSS+RTK)、惯性导航定位(INS/IMU)和环境特征匹配定位。

并且由于三种技术方案各自都有优缺点,实际通常会采用多种方案融合的方式。

比如最常见的卫星定位和惯性导航,可通过松耦合,紧耦合或深耦合的方式进行定位,也就是俗称的卫惯组合。

卫星可修正惯导系统的误差,提高精度;惯导则可以防止卫星信号被遮挡或干扰的情况下,车辆无法获得定位信息。

不过,即使用多种方案融合,在城市工况中卫星被严重遮挡(隧道、高架桥),甚至是地下停车场这种完全“丢星”的情况,就又回到了单一技术方案:只依赖惯导。

而惯导系统如果长时间没有外部信息修正,误差会不断积累,导致无法给出准确的定位结果。

因此就诞生了解耦卫惯,引入其他传感器等信息的新方式。比如利用惯导和摄像头的视觉惯性里程计测距(Visual Inertial Odometry,VIO),类似的还有使用激光雷达的LIO。

而本篇论文的团队,选择同时引入摄像头和激光雷达信息,提出了一种新解法。

LIV-GaussMap:实时生成照片级地图

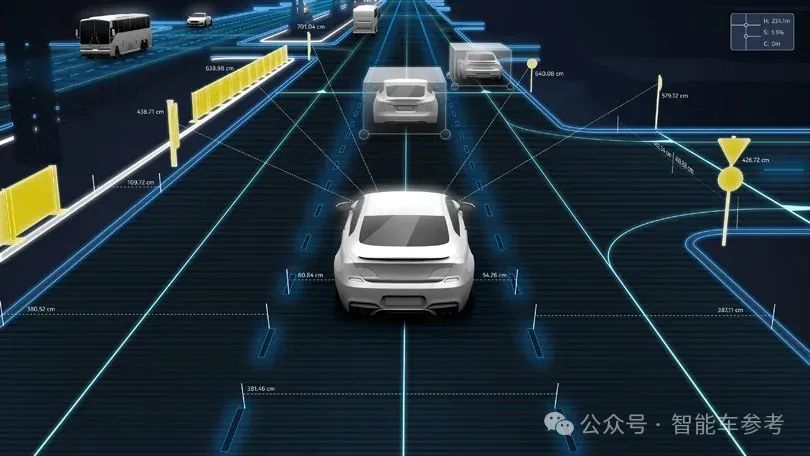

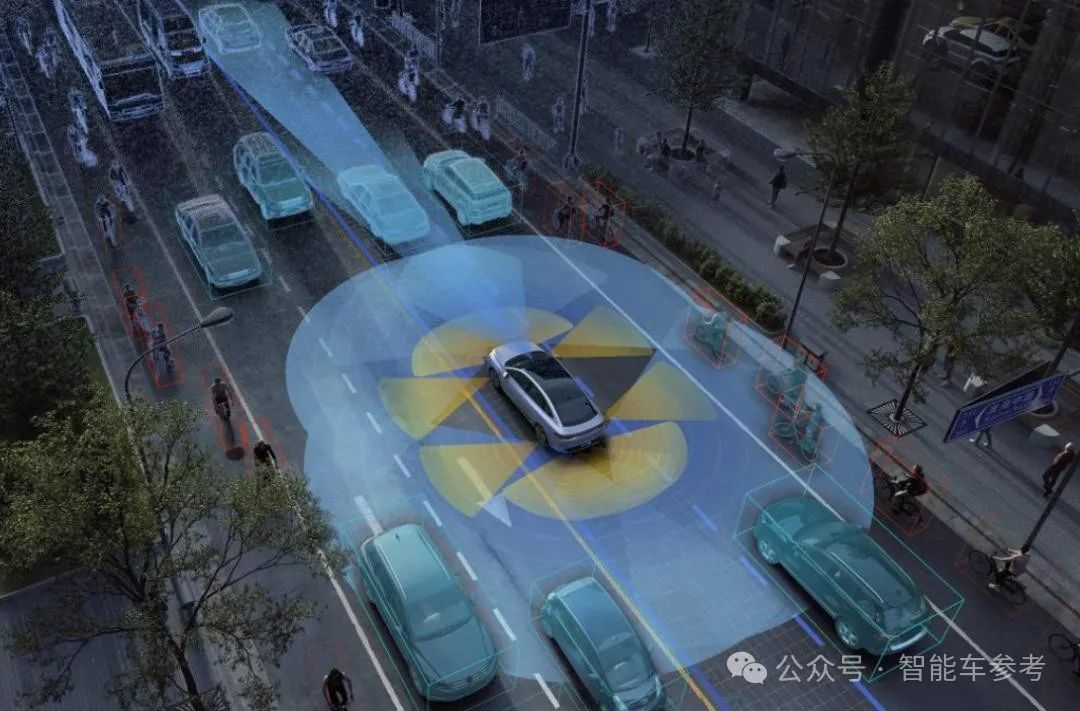

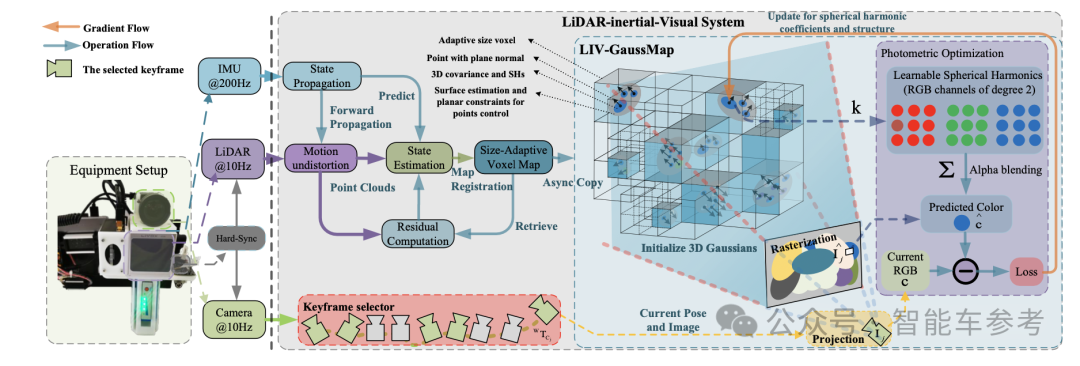

LIV-GaussMap系统集成激光雷达(LiDAR)、惯性测量单元(IMU)和摄像头(Visual)的信息,进行多模态的传感器融合,能实时生成3D辐射场地图,是一种新方式生成的紧耦合地图。

这种方法生成的地图,无论是小范围场景(a)还是大范围场景(b),精度明显提升,并且不会产生奇怪的虚影。

这又是怎么做到的?

系统首先进行硬件同步,也就是摄像头产生的图像和激光雷达生成的点云之间实现精确时间对齐,为数据融合做准备。

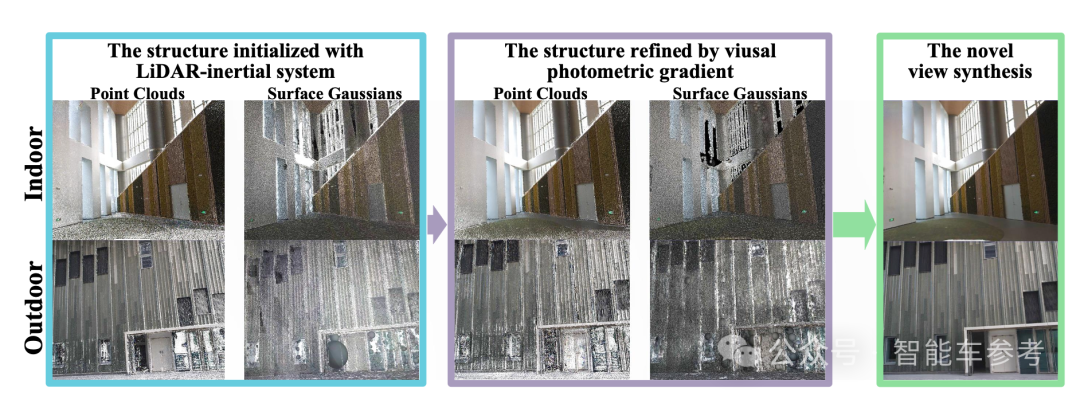

随后,系统利用激光雷达和IMU融合的系统进行实时定位和地图构建,基于迭代误差状态卡尔曼滤波(IESKF)提供场景初步的高斯结构,和初始点云数据。

接下来,系统使用图像亮度梯度优化高斯结构和球面谐波系数,用优化后的结果得到表面高斯模型。

最后用光度插值和外推来合成新的视图,并且系统能做到自适应控制,根据点云的分布和密度,动态调整地图的结构,确保生成的是有细节、没有任何间隙的地图。

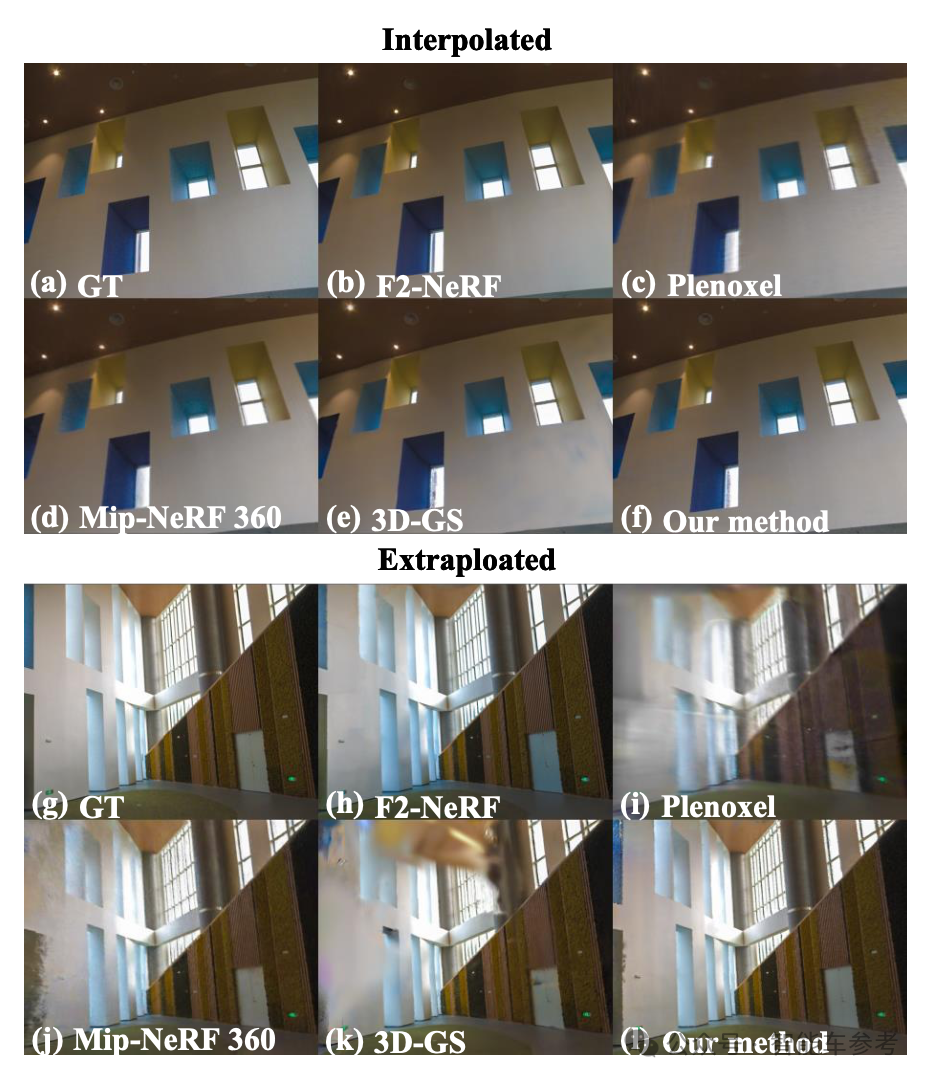

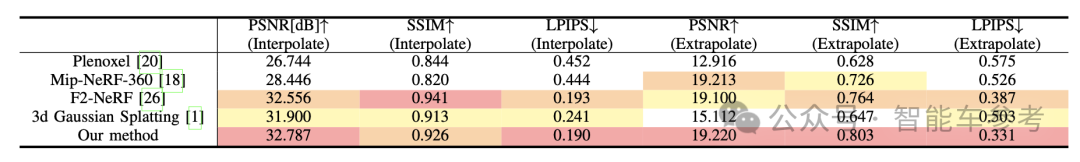

基于真实数据集,和其他最先进算法相比,比如Plenoxel、F2-NeRF、3D-GS等,LIV-GaussMap生成的效果更真实、精度更高。

从得分来看,LIV-GaussMap的多项成绩也均优于其它方式。比如能够衡量图像质量的指标PSNR,以及基于深度学习的图像相似性度量LPIPS,无论是内插还是外插,LIV-GaussMap效果都是最优的。

实时3D建图,不止于车

从实际的生成效果来看,LIV-GaussMap最大特点就是能够准确还原各类物体的表面特征和几何结构,可以构建详细地图。

而从图像引入的亮度梯度数据,可以帮助解决激光雷达点云分布不合理或者测量不准确的问题。

同时,LIV-GaussMap系统对于激光雷达类型没有要求,无论是固态还是机械的激光雷达,同时支持重复和非重复扫描模式。

并且,虽然SLAM这种能够实时构建高精地图的能力,对于高阶智能驾驶来说不可或缺,但LIV-GaussMap也能应用在数字孪生、虚拟现实、机器人等需要实时渲染3D场景的领域。

从论文团队的背景来看,也都来自多个专业。

作者Sheng Hong和Junjie He对本文有同等贡献,其中Sheng Hong来自香港科技大学计算机电子工程系,是机器人研究所-空中机器人组博士生。

Junjie He则和作者之一Xinhu Zheng,都来自香港科技大学(广州)系统枢纽平台(System hub)。

△Xinhu Zheng

△Xinhu Zheng作者之一Chunran Zheng来自香港大学,本科毕业于西安交通大学自动化专业,目前在香港大学MaRS实验室攻读博士学位。

本文的其他作者则都是美国电气电子工程师学会(IEEE)的会员,包括来自上海交通大学自动化系教授Hesheng Wang,已经在国内外期刊和学术会议上发表论文超过150篇,SCI引用超过200次,谷歌学术被引次数超过1400次,曾多次担任IEEE会议主席,还是多份机器人相关期刊副主编。

还有来自北京理工大学自动化学院的方浩教授,2002年获得西安交通大学博士学位,曾参与多项国防预研项目,公开发表学术论文超过40篇。

本文的通讯作者是刘康丞教授,来自香港科技大学(广州),博士就读于香港中文大学,主动机器人和3D视觉方向,曾担任20余种国际会议程序会议主席,和10余种国际顶级期刊的程序委员会委员或审稿人。

最后一位作者就是沈劭劼,是港科大计算机电子工程学系副教授,以及港科大-大疆联合创新实验室(HDJI Lab)主任,同时还是大疆车载负责人。

沈劭劼拥有宾夕法尼亚大学电气与系统工程博士学位,研究领域包括机器人和无人机的状态估计、传感器融合、定位和地图绘制等,不仅多次担任国际机器人会议和期刊的主席、高级编辑等职务,还多次获得AI 2000最具影响力学者奖。

目前,LIV-GaussMap的硬件、软件,还有团队收集的数据集将在github上开源,感兴趣的可以等等看~

论文传送门:

https://arxiv.org/abs/2401.14857

github传送门:

https://github.com/sheng00125/LIV-GaussMap

- 哪吒冲刺港交所IPO,上市起点碾压蔚小理,然而一步慢步步慢2024-06-28

- 注意,北京无人车接送机不免费了2024-06-28

- 广东造车新势力,爆雷了2024-06-25

- 百亿造车新势力破产清算!市值缩水超99%,欠债超10亿,债权人还吵起来了2024-06-24