谷歌通用AI智能体发布,3D游戏玩法要变天了

10秒内完成简单任务

西风 发自 凹非寺

量子位 | 公众号 QbitAI

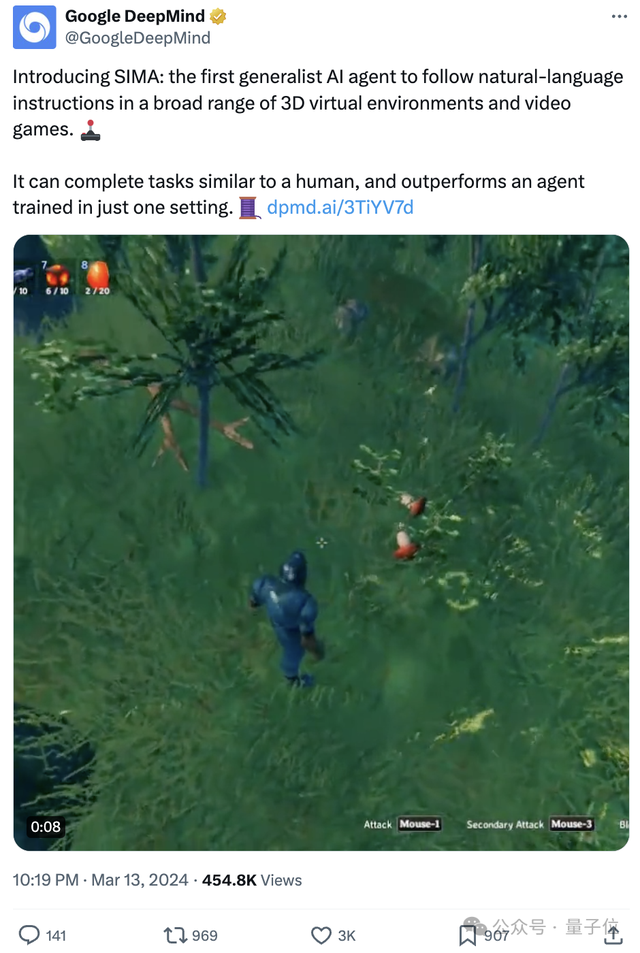

谷歌DeepMind号称打造出了首个能在广泛3D虚拟环境和视频游戏中遵循自然语言指令的通用AI智能体。

名为SIMA,不是NPC,是可以成为玩家拍档,帮忙干活打杂的那种。

比如,在《模拟山羊3》(Goat Simulator 3)中当司机开开车:

在《幸福工厂》(Satisfactory)中挖矿石:

在《瓦尔海姆》(Valheim)中寻找水源:

在《无人深空》中(No Man’s Sky)驾驶宇宙飞船射击小行星收集资源:

……

SIMA全称Scalable Instructable Multiworld Agent,顾名思义可扩展、可指导、多世界。

之前,谷歌DeepMind在AI+游戏方面也做过许多工作,比如推出能和人类玩家打PK、会玩《星际争霸II》的AlphaStar系统。

而SIMA被DeepMind称作是一个“新的里程碑”,主打从适用单一游戏转向通用多种游戏,且可遵循语言指令。

SIMA一公开,网友们也是讨论热烈。

让它们替我完成无聊繁琐的任务,这样我就可以直接做有趣的部分,而不必花几个小时培育chocobos获取随机召唤。

嗯…《最终幻想》(Final Fantasy)玩家无疑了。

专业《模拟山羊》玩家在此刻也懵了:

最近这一连串的AI进展也是整的网友们措不及防,直呼“慢一点”:

10秒内完成的简单任务

接下来再来看一波SIMA的表现。

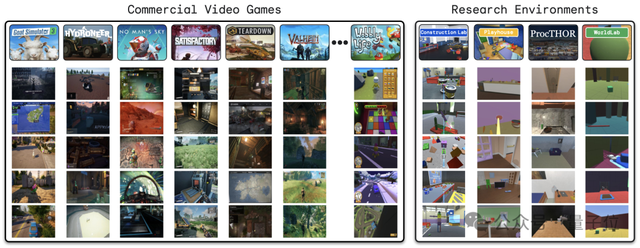

为了让SIMA接触到更多游戏环境,开发团队表示目前已与八家游戏工作室合作,在九款不同的视频游戏上训练和测试了SIMA。

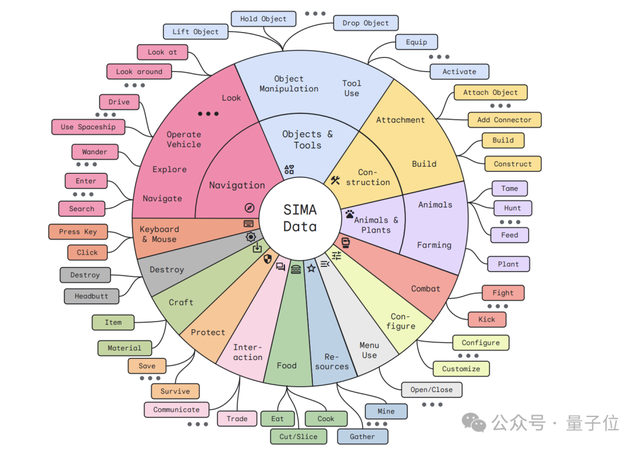

当前的SIMA已在600个基本技能上进行了评估。

基本操作、交互、使用菜单都会:

简单的任务,10秒内可完成。

各种场景都能适应:

除此外,谷歌DeepMind还发布了一份技术报告,一起来看看里面都有啥。

未见过的游戏也会玩

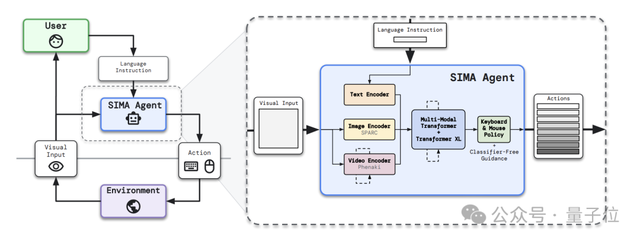

SIMA的整体架构是将预训练视觉模型与自监督学习的Transformer相结合。

从用户那里接收语言指令,并从环境中获取图像观察结果,然后将它们映射为键盘和鼠标动作。

具体架构如下图:

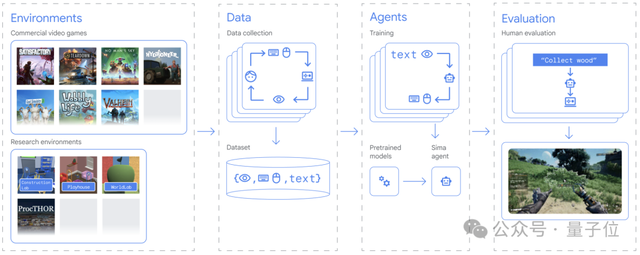

开发人员收集了一个既包括精选研究环境又包括商业视频游戏的大型多样化游戏数据集。

此外,他们还用Unity创建的一个新环境,名为“the Construction Lab”。在这个环境中,智能体需要使用积木构建雕塑,这考验了它们对物体的操纵能力和对物理世界的理解。

数据收集包含多种方法,比如让不同成对的人类玩家的互动,其中一名玩家观察并指导另一名玩家,以此来捕获语言指令;让玩家自由玩游戏,观察他们的操作,并记录下可能导致其游戏行为的指令。

通过在不同的游戏世界中学习,SIMA能够将语言与游戏行为相结合。

不需要访问游戏源代码,也不需要定制API,仅需要两个输入:屏幕上的图像和用户提供的简单的自然语言指令。

然后SIMA就会使用键盘和鼠标输出来控制游戏角色以执行这些指令,这一操作与人类类似,也就意味着SIMA有潜力与任何虚拟环境互动。

在评估测试中,研究人员表示SIMA在九个3D游戏集上接受训练,表现显著优于仅在单个游戏上专门训练的智能体。

而且SIMA在未训练过的游戏中的表现和专门使用该游戏数据集训练过的智能体表现一样好。

也就是说,SIMA在全新环境中具备泛化能力。

此外测试结果还显示,SIMA的性能依赖于语言。在一个控制测试中,智能体没有接受任何语言训练或指令,它就会出现无目的的操作,不遵循指令。

而且,和人类玩家相比较,SIMA水平还是差一点。

更多细节,感兴趣的家人们可以查看技术报告。

参考链接:

[1]https://deepmind.google/discover/blog/sima-generalist-ai-agent-for-3d-virtual-environments/

[2]https://storage.googleapis.com/deepmind-media/DeepMind.com/Blog/sima-generalist-ai-agent-for-3d-virtual-environments/Scaling%20Instructable%20Agents%20Across%20Many%20Simulated%20Worlds.pdf

- Moltbot作者被Claude刁难后:MiniMax M2.1是最优秀的开源模型2026-01-29

- 爆火Clawdbot被Claude公司强制要求改名2026-01-28

- 3D版Nano Banana来了!AI修模成为现实,3D生成进入可编辑时代2026-01-27

- 成立两年半登顶全球AI创作社区,背后是中国团队在“卖情绪”??2026-01-22