鹅厂革新大模型工具全链条!5分钟开发AI助手,河南学生已用上

大模型开发门口再降亿点点

明敏 鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

大模型的风,吹进中小学了。

在河南,十几所中小学的学生老师,都已经用上专用大模型辅助学习和教课。

而且是熟读新课标教材的那种,解答习题正确率达到95%。

但开发难度并不高,无需拿着海量数据从头训练一个模型,甚至都不一定需要懂编程,大幅降低大模型应用落地门槛。

这就是腾讯云刚刚公开的大模型商业化新进展。

在腾讯云生成式AI产业应用峰会上,鹅厂一口气发布腾讯混元大模型最新进展、三大引擎工具、以及全面升级的腾讯云TI平台等。

他们共同将大模型应用落地全流程链条进行大幅革新。

比如开头提到的教育行业落地案例,就是基于腾讯云最新发布的大模型知识引擎实现。仅需5分钟,该引擎即可帮助用户生成“企业级”的AI问答应用。

透过如上实际落地案例,腾讯云究竟如何理解生成式AI产业应用?有了更明确解答。

5分钟,做一个大模型问答应用

腾讯云提出的知识引擎是一个基于LLM+RAG模式的知识应用构建平台。

它整合了腾讯混元大模型以及行业特定大模型能力,并结合文档技术,可以向用户提供大模型企业只是服务应用模板,以及文档解析、向量检索、多轮改写等原子能力。

在河南中小学实际落地的豫教大模型就是在混元的基础上,通过知识引擎构建、引入海量教育领域数据,微调之后的行业大模型。

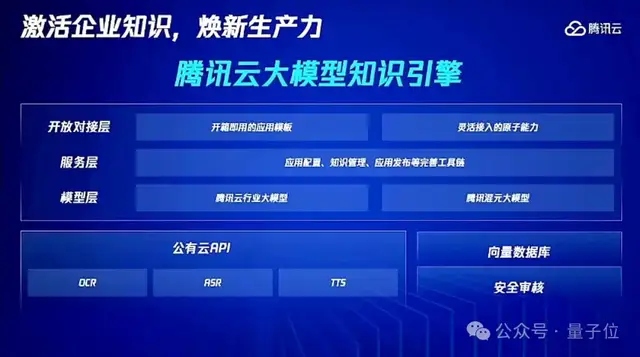

从技术架构来看,知识引擎分为3层:

- 大模型底座层

- 平台层

- 应用层

其中,大模型底座是基础设施,关键组件为大模型推理与解析引擎,它通过高度优化的模型推理能力处理复杂数据解析和理解任务,确保信息提取的精确性和效率。

平台层涵盖知识问答系统(含任务导向型应用)。中间层负责整合大模型底座能力,提供问答、信息检索等服务,通过标准化接口实现与不同业务场景灵活对接。

应用层包括控制台界面和开放API接口,面向终端用户和开发者,能够让大模型能力轻松被嵌入到各类外部系统中。

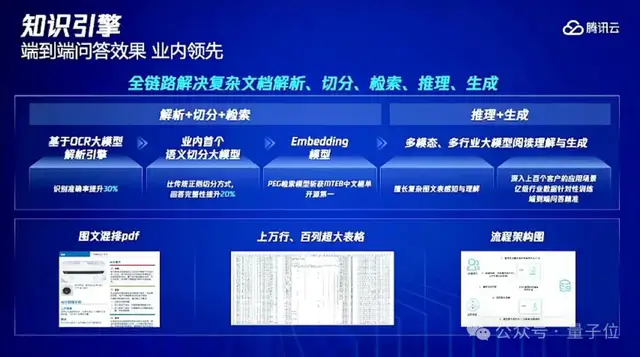

为了能够达到更好的应用效果,腾讯云知识引擎在底层算法方面进行了一系列创新:

- 自研TRAG技术架构

- 集成OCR解析大模型和多模态阅读理解大模型

- 业内首个基于语义判断的知识切分模型

- 多元检索和增强型检索

首先,知识引擎使用腾讯自研的TRAG技术,不局限于向量化和检索增强,对全流程每个环节进行优化,包括文档处理、检索、理解和生成等。

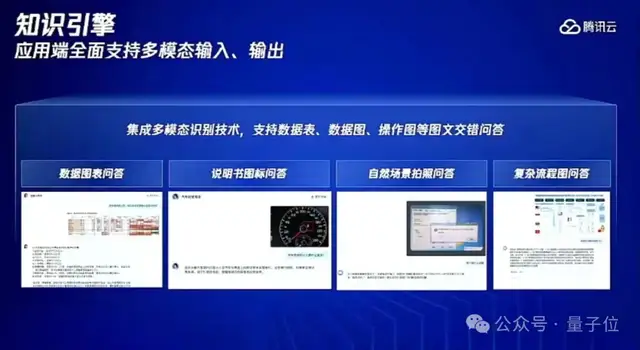

其次,OCR解析大模型能够直接端到端分析各种复杂文档,比如文档元素多样(包括段落、图、表、子图等)排版复杂(如横纵向多栏、图/图注群组等)的Word。通过将复杂文档图片表格转换成可编辑的Markdown文本,它可以准确识别图表等关键元素,并且按照人类阅读顺序理解文档,整体准确率提升25%。处理复杂图文PDF、PPT方面,腾讯云知识引擎还开发了混合图文的多模态阅读理解大模型。

然后,RAG能够精确检索的前提是做好知识切分,如何保证整个信息块的语义完整一直是业内难题。腾讯云采用了一种“暴力解法”,提出业内首个基于语义判断的知识切分模型,用大模型的方式直接对每个文本做语义级别的切分,然后对多个段落去做更准确拆分,确保每个切片在长度可控的情况下语义是最完整的,没有缺字、断章取义的情况。

最后在检索方面,腾讯云智慧引擎通过长文档embedding模型,将检索最大长度提升至4k字符,远高于业内平均水平(通常512字),并采用混合检索、text2sql表格检索等策略,进一步提高复杂知识的检索精度,可以处理上万行超大表格的精确筛选。

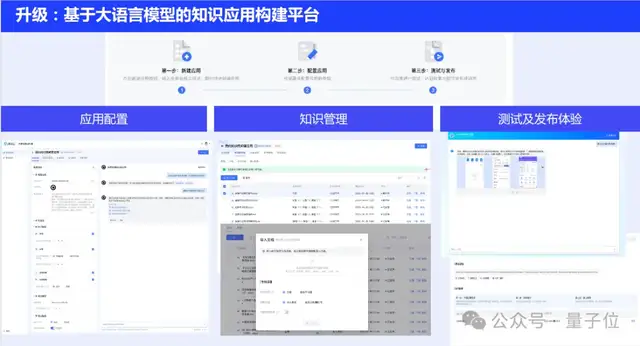

在提升平台专业性的同时,腾讯云知识引擎还保障了易用性。

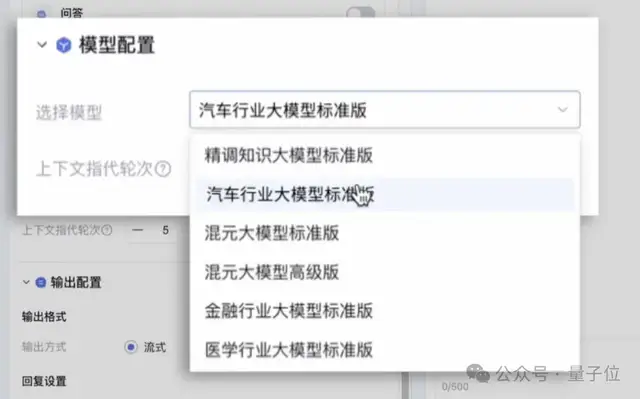

它提供开箱可用的应用模板和可被集成的原子能力API,低代码/无代码即可快速创建大模型应用。并构建了完善工具链,支持用户自定义模型选择、角色设定、提示词自动优化、知识库管理及维护等,同时支持对话测试-修正-发布-反馈增强的一站式处理。

实际应用流程只需4步,短至5分钟即可搞定。

第一步,一键导入企业专属知识。

第二步,填写基础配置。也就是你想要一个怎样的大模型助手,比如汽车售后专家、保险销售、理财顾问等。

然后选择相应的底层模型。

第三步,测试发布。

第四步就能接入应用了。

通过API调用,快速接入智能客服、内部只是问答、数字人等产品,一个企业级的知识问答应用就答应好了。

此外,基于腾讯自研的高性能向量数据库(可支持百万级QPS及毫秒级查询延迟)以及相关加速技术,腾讯云知识引擎能在保障精度的前提下进一步提升模型推理性能。实际演示中,每次回答完成基本耗时在5秒左右。

总结一下,腾讯云知识引擎集成更先进的技术,同时还降低使用门槛,主要面向编程小白or非专业人士,能推进大模型应用更快走向千行百业。

这不仅给当下RAG需求市场提供了一个新选择,同时也是生成式AI应用落地的一个范式参考。

而这还只是腾讯云生成式AI产业应用峰会新发布内容的冰山一角。

一同亮相的,还有腾讯混元最新进展和腾讯云TI平台全面升级。

0门槛应用开发、定制化大模型全覆盖

最新发布中,腾讯全面升级混元大模型能力。

提供万亿参数hunyuan-pro、千亿参数hunyuan-standard、百亿参数hunyuan-lite等多种尺寸模型,通过腾讯云面向企业、开发者全量开放。其中hunyuan-standard支持256K上下文,具备单次处理超过38万字符的超长文本能力。

升级后的腾讯混元,模型总体性能相比上一代提升50%,部分中文能力已追平GPT-4。在多模态能力方面,支持生图、生视频、生3D,比如视频方面,支持 16s 视频生成。

基于最新混元大模型底座,这一次腾讯面向AIGC应用落地趋势、面向产业带来的,可以说是一波全方位无死角的更新。

除了知识引擎以外,腾讯云大模型图像创作引擎具备高质量AI图像生成和编辑能力,可提供AI写真、线稿生图、图像风格化等能力;腾讯云大模型视频创作引擎可生成、编辑高质量视频,提供视频转译、视频风格化、画布拓展等功能。

它们更多面向有应用场景,欠缺开发能力的B端用户,提供大模型应用浪潮下的低门槛工具链。

但这还不够,腾讯云还发布“腾讯元器”,进一步拓宽了大模型应用的落地范围——

即使是缺少数据、工程能力的普通人,也可以一句话打造专属智能体,让创意这个大模型时代的重要资源分分钟“变现”。

具体来说,通过提示词、插件、工作流、AI辅助等创作能力,用户能低门槛在该平台上创建AI智能体。

更关键的是,还能将这些智能体发布到QQ、微信等腾讯App上,享受腾讯全域分发渠道。

另一方面,面向更专业用户打造行业大模型的需求,腾讯云TI平台也完成了全面升级。

腾讯云TI平台是一个全栈式人工智能开发服务平台,简单来说,就是从数据获取、数据处理,到算法构建、模型训练、模型评估、模型部署,再到AI应用开发的大模型落地全链路,这个平台都能一站式打包搞定。

在自家的混元大模型之外,TI平台还内置了Llama3、Llama2、Baichuan2、Qwen等一系列主流大模型。基于TI平台,用户只需要少量算力+领域专业数据,就能高效构建出专属行业大模型。

此番TI平台的升级,主要集中在三个方面,以解决企业实际遇到的应用难题:

- 大规模数据处理耗时长

- 工程化迭代大模型算力利用率低、训练周期长

- 从模型到应用落地难度高

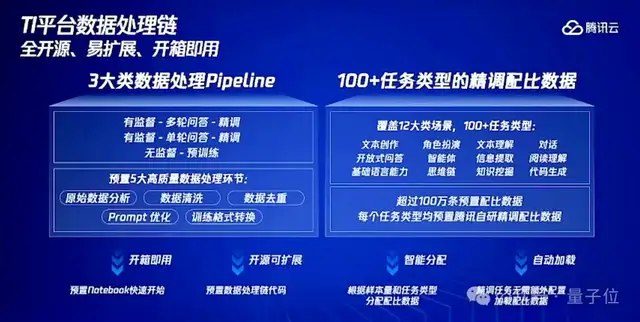

首先,是发布了全新数据处理链,并且是全开源、易扩展、开箱即用的那种。

具体来说,腾讯云TI平台提供了三大类数据处理pipeline,包括100多种任务类型的精调配比数据,支持知识问答、有监督的多轮和单轮问答以及无监督的预训练等。

此外,还提供原始数据分析、数据清洗、数据去重等功能,并拥有超过100万条的预置配比数据。

通过Prompt优化和训练格式生成,TI平台能够根据精调任务类型智能分配配比数据,无需额外配置就能自动加载配比数据,快速开始精调任务,并且在Notebook中提供了预置的数据处理链代码,方便用户快速上手。

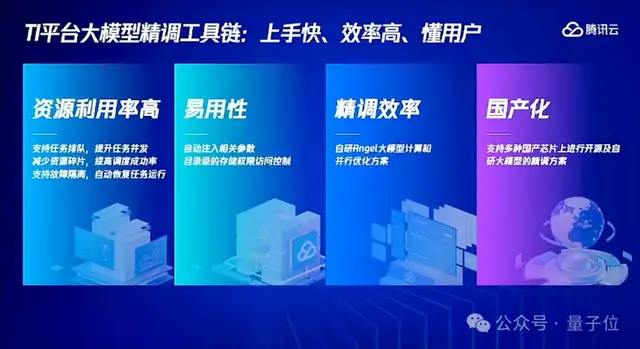

其次,是上新了大模型精调工具链。

该工具链支持任务排队以提升并发处理能力,采用自研的Angel大模型计算和并行优化方案以提高效率,同时具备故障隔离和自动恢复功能以增强稳定性。

值得一提的是,该工具链支持国产化硬件,比如昇腾系列芯片。

最后,TI平台通过与知识引擎的强强联合,提供了一种边迭代边测评的机制,使用户能够及时了解并优化大模型的业务效果。

平台支持客观和主观两种测评方式,可以结合业务中的实际难题和知识库,进行端到端效果评测。

△精调前后对比

目前,广东工业大学、腾讯云和中国大熊猫保护研究中心已经基于TI平台+知识引擎展开了AI大熊猫保护的探索。

项目组在一阶段打造了全球首个大熊猫智能行为识别模型及智慧系统,能识别大熊猫进食、喝水、睡觉等日常行为,准确率超过80%。

有意思的是,就在腾讯云生成式AI产业应用峰会现场,Gartner还联合腾讯发布了一份《生成式AI产业落地路径研究报告》。

其中提到,目前生成式AI的落地路线主要分为三种:

- 标准软件路线,即直接采购基于大模型能力的成熟应用

- 标准模型能力增强路线,即调用大模型API或通过提示工程对模型能力进行增强

- 定制化模型精调训练路线,即结合企业专属数据定制大模型

结果上看,腾讯云的这一波生成式AI重磅更新,可以说是全面覆盖了这三条路线。

生成式AI迈入产业落地阶段

伴随着2024而来,业界越来越强烈的共识是,大模型的最新关键词之一,就是“应用”。

无论是Sora掀起的科技圈新风暴,还是OpenAI、谷歌在多模态智能助手方面轮番上演肌肉秀,背后指向的趋势都是:

生成式AI进入第二阶段,场上玩家们正在从卷基础模型的研发,迈入到应用落地探索的新阶段。

在这一浪潮之中,其实不仅仅是AIGC产品的开发厂商,越来越多的传统企业也已经被卷入实践的第一线。

值此之时,如何结合自身AIGC场景,选择合适的落地路线,将成为越来越多企业需要思考的问题。

腾讯云此番交卷,其实也在释放一种信号:

对于平台厂商而言,如何与产业相结合,真正把大模型应用的门槛全方位降到更低,已成为新阶段的竞争关键。

作为旁观者,值得期待的是,这些具体实际的落地脚步,或许就是趋势变革连点成线的关键。

- DeepSeek-V3.2-Exp第一时间上线华为云2025-09-29

- 你的AI助手更万能了!天禧合作字节扣子,解锁无限新功能2025-09-26

- 你的最快安卓芯片发布了!全面为Agent铺路2025-09-26

- 任少卿在中科大招生了!硕博都可,推免学生下周一紧急面试2025-09-20