快手版Sora「可灵」开放测试:生成超120s视频,更懂物理,复杂运动也能精准建模

已在快影APP开启邀测

克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

什么?疯狂动物城被国产AI搬进现实了?

与视频一同曝光的,是一款名为「可灵」全新国产视频生成大模型。

它采用了Sora相似的技术路线,结合多项自研技术创新,生成的视频不仅运动幅度大且合理,还能模拟物理世界特性,具备强大的概念组合能力和想象力。

数据上看,可灵支持生成长达2分钟的30fps的超长视频,分辨率高达1080p,且支持多种宽高比。

另外再划个重点,可灵不是实验室放出的Demo或者视频结果演示,而是短视频领域头部玩家快手推出的产品级应用。

而且主打一个务实,不开空头支票、发布即上线,可灵大模型已在快影APP中正式开启邀测。

话不多说,接下来就带大家欣赏一下可灵的大作~

更懂世界规律,复杂运动也能准确刻画

相信通过开头的视频,大家已经感受到了可灵丰富的想象力。

可灵不但在想象上天马行空,在描绘运动时又能做到符合真实的运动规律,复杂、大幅度的时空运动也能准确刻画。

比如这个在公路上高速奔跑的老虎,不仅画面连贯,随镜头角度的变化合理,老虎四肢的动作协调,而且还把奔跑过程中躯干部分的抖动也展现得淋漓尽致。

还有宇航员在月球上奔跑的画面,动作流畅,步态和影子的运动合理恰当,太绝了。

除了运动,可灵大模型还能模拟真实物理世界特性,生成的视频更符合物理规律。

在这段倒牛奶的视频中,力学方面的重力规律、液面的上升都符合现实,连倒液体时泡沫一直在最上层的特性也考虑到了:

还有光学上的反射规律也考虑到了,注意看这只弹钢琴的猫猫,光滑表面上影子里的猫爪和琴键,都在随着本体同步变化。

另外,与真实物理世界的交互,也能被真实反映——下面视频中小男孩吃汉堡的生成视频中,一口咬下去,齿印一直都在,小男孩享受吃汉堡的享受过程宛如就在眼前。

要知道,符合物理规律对于大模型来说还是相当困难的事,连Sora也不能完全做好。

比如同样是吃汉堡这个场景,Sora生成的视频不仅有人手只有三根手指这样的槽点,咬合位置与汉堡上的咬痕也并不匹配……

不仅仅是真实世界中的物理规律和运动,对于想象力的场景,可灵也是信手拈来。

比如这只戴着眼镜的兔子边喝咖啡,边看报纸,悠闲自得。

同时,可灵对细节的刻画也很到位,比如两朵缓慢绽放的花,可以看到花瓣和花蕊的细节。

而且,可灵不仅生成的视频更加真实,生成的视频分辨率高达1080p,时长高达2分钟(帧率30fps),且支持自由的宽高比。

其中也包括竖版视频,可以说是和快手的短视频生态相当匹配了。

画面中,一列火车向前方行驶,窗外的风景走过了春夏秋冬四季,整个两分多钟的画面都十分连贯。

到这里,相信效果展示得已经够多了,如果还意犹未尽的话,可以前往可灵官网平台(传送门见文末),看更多神奇的AI视频吧!

(注:本文中的视频有压缩,高清及最新效果以官方网页为准)

那么在可灵的这些视频背后,都运用了哪些独特的技术呢?

原生的视频生成技术路线

整体上,可灵大模型的采用了原生的文生视频技术路线,替代了图像生成+时序模块的组合,这也是可灵生成时间长、帧率高,能准确处理复杂运动的核心奥义。

具体来看,快手大模型团队认为,一个优秀的视频生成模型,需要考虑四大核心要素——模型设计、数据保障、计算效率,以及模型能力的扩展。

类Sora模型架构,scaling law得到验证

先从模型的设计说起,这当中主要应当考虑两方面的因素,一是足够强的拟合能力,二是足够多的参数容量。

架构的选择方面,可灵整体框架采用了类Sora的DiT结构,用Transformer代替了传统扩散模型中基于卷积网络的U-Net。

Transformer的处理能力和生成能力更强大,扩展能力更强、收敛效率更好,解决了U-Net在处理复杂任务时冗余过大、感受野和定位精度不可兼得的局限。

在此基础之上,快手大模型团队还对模型中的隐空间编/解码、时序建模等模块进行了升维。

目前,在隐空间编/解码上,主流的视频生成模型通常沿用Stable Diffusion的2D VAE进行空间压缩,但这对于视频而言存在明显的信息冗余。

因此,快手大模型团队自研了3D VAE网络,实现时空同步压缩,获得了较高的重建质量,在训练性能和效果取得了最佳平衡。

另外在时序信息建模上,快手大模型团队设计了一款计算高效的全注意力机制(3D Attention)作为时空建模模块。

该方法可以更准确地建模复杂时空运动,同时还能兼顾具运算成本,有效提升了模型的建模能力。

当然,除了模型自身的能力,用户输入的文本提示词也对最终生成的效果有着重要影响。

为此,团队专门设计了专用的语言模型,可以对用户输入的提示词进行高质量扩充及优化。

数据如何构建?自建高质量数据筛选方案

说完了模型的设计,数据对于模型的表现同样至关重要。

事实上,训练数据的规模和质量不足,也正是许多视频生成模型研发者所面临的棘手问题。

网上视频普遍质量低、难以满足训练需求。快手大模型团队构建了较为完备的标签体系,可以精细化的筛选训练数据,或对训练数据的分布进行调整。

该体系从视频基础质量、美学、自然度等多个维度对视频数据质量进行刻画,并针对每一个维度设计多种定制化的标签特征。

在训练视频生成模型时,需要同时把视频及对应文本描述喂给模型。视频本身质量也有了保证,其对应文本描述,应该如何获得?

开发团队专门研发了视频描述模型,可以生成精确、详尽、结构化的视频描述。显著提升视频生成模型的文本指令响应能力。

纵使模型天赋异禀,亦离不开勤学苦练

模型和数据都有了,运算效率也要跟得上,如此才能在有限的时间内完成海量规模数据训练,看到显著的效果。

为了获得更高的运算效率,可灵大模型并没有采用当前行业主流的DDPM方案,而是使用了传输路径更短的flow模型作为扩散模型基座。

从另一层面上看,算力的不足也是不少AI从业者面临的难题,即使像OpenAI这样的大模型巨头,所拥有的算力资源同样紧缺。

这一问题在短时间内可能无法彻底解决,但可以做的是,在总体硬件资源有限的条件下,尽可能地提高算力的运用效率。

快手大模型团队便使用了分布式训练集群,并通过算子优化、重算策略优化等手段,大幅提升了可灵大模型的硬件利用率。

在训练过程当中,可灵也没有选择一步到位,而是采取分阶段训练策略来逐步提升分辨率:

在初期的低分辨率阶段,主要是以数量取胜,通过大量数据增强模型对概念多样性的理解和建模能力;

在随后的高分辨率阶段,数据的质量开始变成更重要的考量因素,目的是进一步提高模型性能,并加强在细节上的表现。

采取这样的策略,有效结合了量与质的优势,确保了模型在训练的各个阶段均能得到优化提升。

需求千变万化,模型游刃有余

在基础模型的研发工作之上,快手大模型团队也从长宽比等多个维度上对其能力进行了扩展。

在长宽比上,可灵同样没有采用主流模型在固定分辨率上进行训练的方式。

因为传统方法在面对长宽比多变的真实数据时,通常会引入前处理逻辑,破坏了原始数据的构图,导致生成结果构图较差。

相比之下,快手大模型团队的方案可以使模型直接处理不同长宽比的数据,保留原始数据的构图。

为了应对未来数分钟甚至更长的视频生成需求,团队也研发了基于自回归的视频时序拓展方案,且不会出现明显的效果退化。

除了文本输入外,可灵还支持多种控制信息输入,如相机运镜、帧率、边缘/关键点/深度等,为用户提供了丰富的内容控制能力。

不做“画饼”大模型,应用才是硬道理

大模型行业“卷”到今天,我们见证了太多技术的高光时刻,但技术突破的初心仍然还是应用。

快手可灵视频生成模型,诞生于短视频头部厂商,也持续面向应用在探索。非常值得一提的是,可灵大模型是发布即上线,不画饼!不画饼!不画饼!

可灵的文生视频模型,已在快影APP中正式开启邀测,目前开放的版本支持720P视频生成,竖版视频生成能力也即将开放。

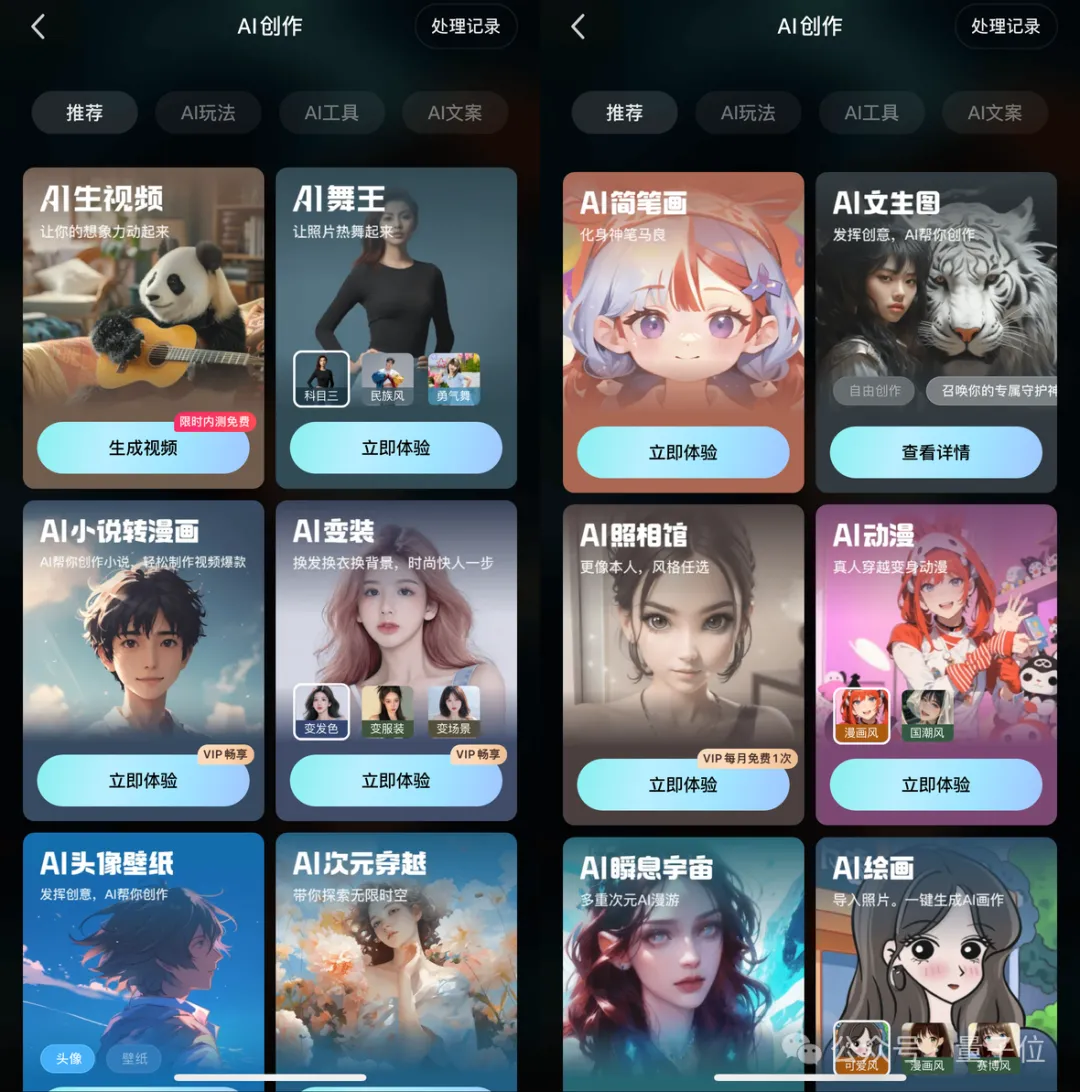

除了文生视频,快手还基于可灵大模型推出了其他应用,如“AI舞王”已在快手和快影APP中上线。

无论是科目三还是二人转,只要上传一张全身照,都能分分钟让人物跟着音乐优雅地跳动,甚至兵马俑也能跳起最炫民族风。

除了视频生成模块,快手大模型团队还向其中加入了自研3D人脸重建技术,以及背景稳定性和重定向模块,更生动地展现表情和运动效果。

而且,更新一些的“AI唱跳”技术也迎来了首发,在跳舞的同时,也能让人物张嘴唱歌了。

顺便再做个剧透,基于可灵大模型的图生视频功能,也将于近期与用户见面。

实际上,作为头部视频厂商,快手在大模型热潮之中也动作迅速,此前就曾相继推出语言模型和文生图模型。

基于这些模型,AI文案、AI生图,AI生视频,以及更多AI创作功能,都已相继在快手和快影APP中上线。

在视频生成上,快手也曾与多个高校或科研机构联手,陆续发布可控运动的视频生成算法Direct-a-Video、多模态生成算法Video-LaVIT、图生视频算法I2V-Adapter、多模态美学评价模型UNIAA等关键技术,为可灵大模型积累了深厚的技术沉淀。

现在,快手完整的文生视频功能终于华丽登场,我们期待快手作为一家拥有独特场景优势和广泛应用场景的短视频赛道巨头,能够率先把视频生成能力在短视频场景中落地生花。

如果你对AI视频创作感兴趣,不妨到快影APP中一探究竟。

传送门:

http://kling.kuaishou.com/

- “开源版贾维斯”一夜席卷硅谷!Mac mini因它卖爆2026-01-26

- 微软打包收购OpenAI?就差一点!2026-01-21

- MiniMax把自家“实习生”放出来了!2026-01-20

- 763亿港元,大模型公司最大规模IPO!MiniMax登陆港交所,开盘前大涨50%2026-01-09