Dexmal原力灵机提出ManiAgent,用多智能体协作重构机器人操控

包含四个核心智能体,形成“感知-推理-控制”的闭环

在机器人操控领域,Vision-Language-Action (VLA) 模型曾被视为通往通用机器人的“圣杯”。当前,它却面临着严重的瓶颈问题:

- 数据饥渴与分布外(OOD)失效:VLA 很依赖大规模、高质量的演示数据;一旦遇到训练数据分布之外的场景,或者数据量稍有不足,性能明显下降。

- 模型容量与推理能力互斥:为了让模型学会动作控制而进行的微调,会破坏 LLM 原本拥有的高层语义理解和推理能力。这导致模型变成了“有手无脑”的模仿者——能执行动作,但听不懂复杂的间接指令,更无法进行长序列任务的规划。

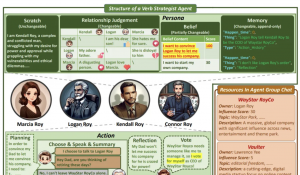

图 1:ManiAgent 把做一道 “Menemen 菜” 的模糊指令,层层拆解为“识别鸡蛋”、“抓取鸡蛋”、“放入盘子”等具体步骤

为此,Dexmal 原力灵机作者团队提出多智能体协作系统 ManiAgent;它放弃了通过海量数据“喂养”一个巨大黑盒模型的路径,转而采用 Agentic(智能体化) 的思路——与其让一个模型同时负责“看、想、做”,不如将任务层层分解。

ManiAgent 作者团队利用现有 LLM 强大的通用推理能力,设计了一个 Training-free 框架,通过多个智能体对特定工具的调用,直接将自然语言指令转化为机器人动作;这种设计不仅规避了高昂的数据采集成本,还保留了 LLM 在处理复杂逻辑和常识推理上的原始优势。

方法框架

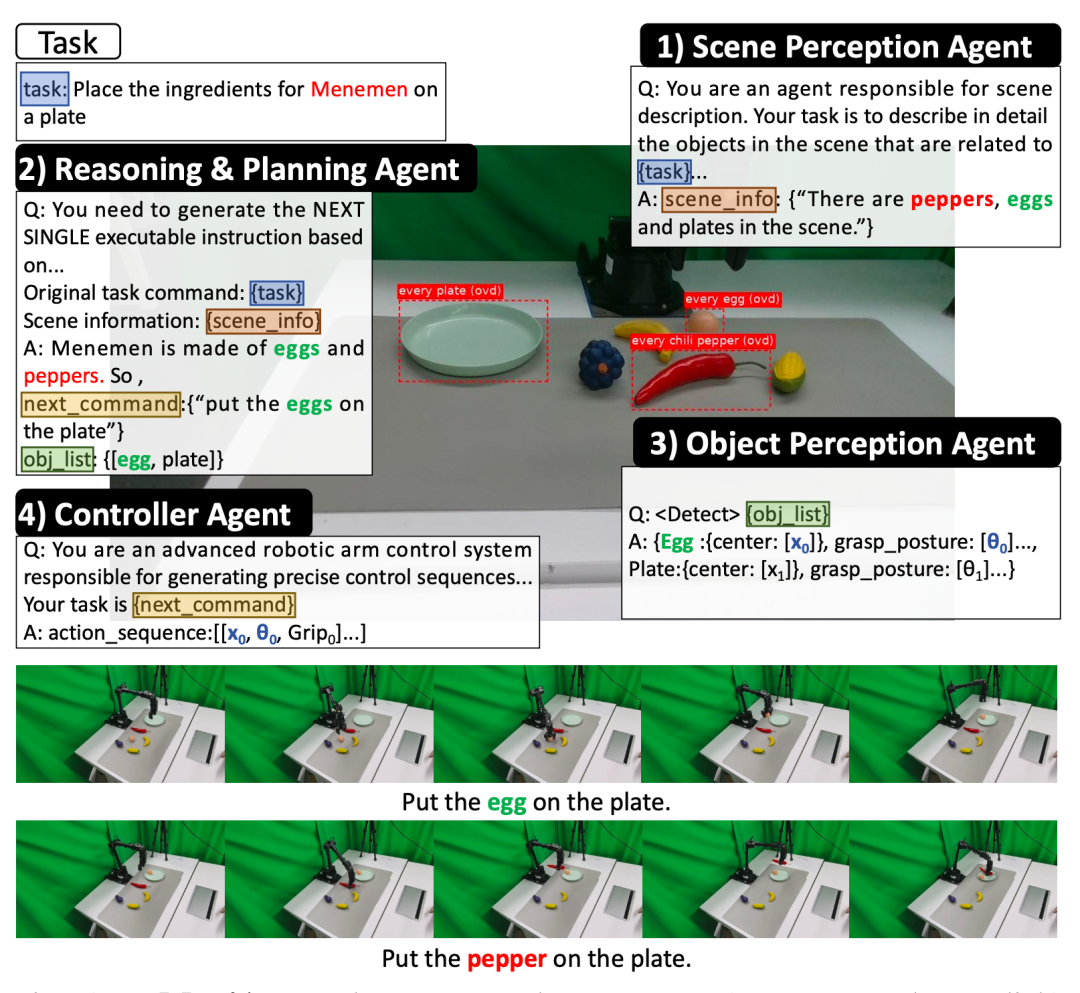

图 2:ManiAgent 框架示意图

ManiAgent 核心逻辑在于模拟人类解决复杂物理任务时的认知过程:感知环境 -> 拆解任务 -> 规划细节 -> 执行动作。为实现这一过程,作者团队构建了一个“感知-推理-控制”的闭环 Pipeline,通过内部通信机制,让智能体各司其职;这一架构设计有两个本质上的突破:

- 降维打击复杂场景:通过把长序列任务拆解为一个个原子级的子任务,系统把一个复杂的操控问题“降维”成了多个简单的执行问题。

- 无需特定任务微调:实现更通用的操控。它不需要针对特定任务进行微调,而是依靠各个智能体的通用能力组合来应对未知任务。

ManiAgent 设计了精密的内部通信机制,让四个智能体紧密配合;不仅在 SimplerEnv 上实现 86.8% 的高成功率,更证明了在缺乏大规模机器人数据的情况下,利用现有的通用大模型(GPT-4o、GPT-5、Claude-3.5 等)的推理能力,可以驱动机器人完成高难度的物理任务。

场景感知 Agent

该智能体接收 RGB 图片和任务指令,利用视觉语言模型(VLM)生成文本化的场景描述。

- 关键技术:为保证描述精度,作者团队通过优化 Prompt 来平衡召回率与相关性。首先确保场景中所有与任务相关的物体都被提及(高召回),然后过滤掉无关的背景噪音(高相关)。

- 深度感知:对于 VLM 无法精准定位的物体,智能体会调用检测模型结合相机标定参数,将像素坐标转化为 3D 空间坐标,为后续步骤提供物理锚点。

推理与规划 Agent

该智能体接收场景描述,利用 LLM 的物理常识和逻辑推理能力,将宏大的任务目标拆解为可执行的子任务。

- 增量式拆解:它不是一次性把所有步骤规划完,而是根据当前状态一步步生成下一个子任务,避免了长序列规划中常见的累积误差。

- 记忆机制:为防止机器人陷入死循环,该智能体拥有记忆功能,存储历史子任务以指导当前决策。

物体感知 Agent

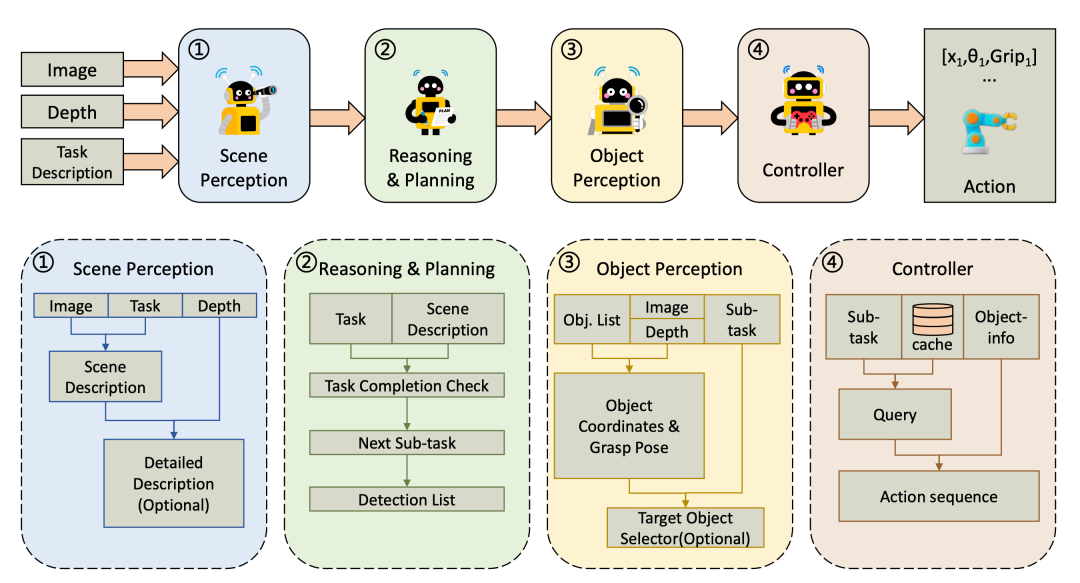

图 3:ManiAgent 物体感知智能体模块示意图

具体的子任务下达之后,该智能体负责锁定目标。

- 开放词汇检测:利用 VLM 的开放词汇检测能力,根据子任务中的关键词定位物体中心点。

- 多实例消歧:这是一个非常巧妙的细节。如果场景里有三个辣椒,VLM 会被要求通过特定的 Prompt 来筛选出唯一的目标物体,解决了传统检测器无法理解相对语义的问题。

- 抓取姿态生成:集成 AnyGrasp 等算法,计算出最优的 6-DoF 抓取姿态。

控制器 Agent

当前的 Agent 方案大多数采用 api 调用的方式进行机械臂的控制,这种方式一定程度上限制了智能体框架发展的上限。因此,作者团队使控制器 Agent 时直接输出可执行的动作序列,极大减少了人为定义 api 的工作量,也充分利用了场景中离散物体坐标的空间信息。

- 动作生成:通过 LLM 将离散的物体坐标和抓取姿态组装成有序的动作流。

- 缓存机制:为解决 LLM 推理延迟高的问题,作者团队设计了一个“动作缓存”。如果当前的子任务与之前执行过的任务相似,系统会直接调用缓存中的参数化动作序列,大幅提升了执行效率。

实验结果

ManiAgent 的实际表现支持了“Agentic 优于 End-to-End”的论点。

仿真环境测试结果

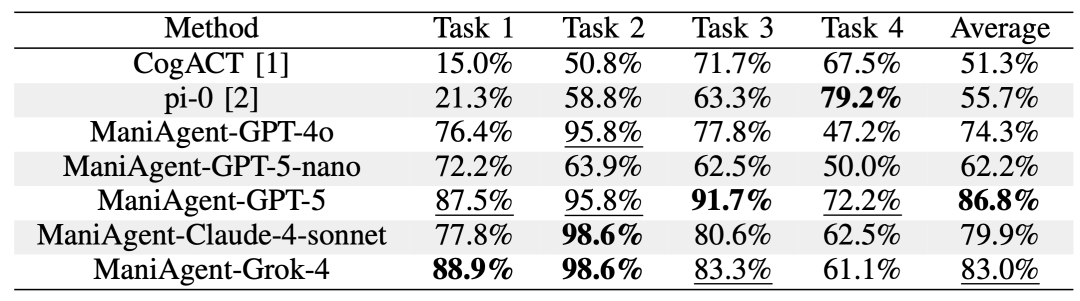

表1:ManiAgent 的仿真实验结果

在标准的 SimplerEnv 基准测试中,ManiAgent 表现出色。相较于 Pi0 (55.7%) 和 CogACT (51.3%),搭载 GPT-5 的 ManiAgent 取得了 86.8% 的平均成功率。即使是稍微弱一些的 GPT-4o 版本,成功率也达到 74.3%,依然大幅领先于传统的 VLA 模型。这直接证明了将高层推理与底层控制解耦的有效性。

真机环境测试结果

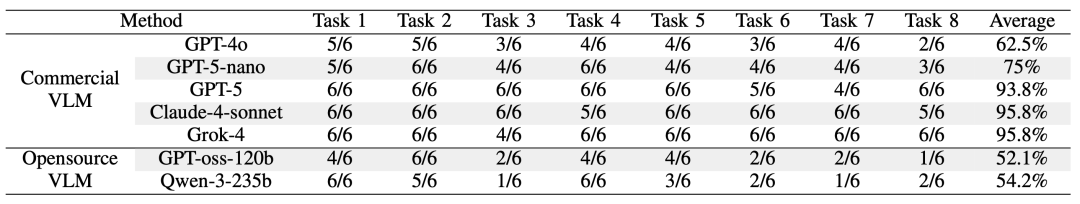

表 3:ManiAgent 在真机环境中的主要结果

在真实世界的测试中,作者团队设计了 8 个涵盖不同难度的任务,包括模糊指令推理(“我想写东西” -> “把桌子上的笔放到人手上”)、相对位置感知(“把中间的辣椒放盘子里”)以及长序列规划。

- 成功率:使用 Claude-4-Sonnet 或 Grok-4 作为基座模型时,真机任务的平均成功率高达 95.8%。

- 复杂推理:在“摆放餐具”的任务中,模型甚至需要利用常识知识库,遵循“左叉右刀”的西餐礼仪来摆放物体。这种包含文化常识的物理操作,是目前单纯依赖模仿学习的 VLA 模型难以企及的。

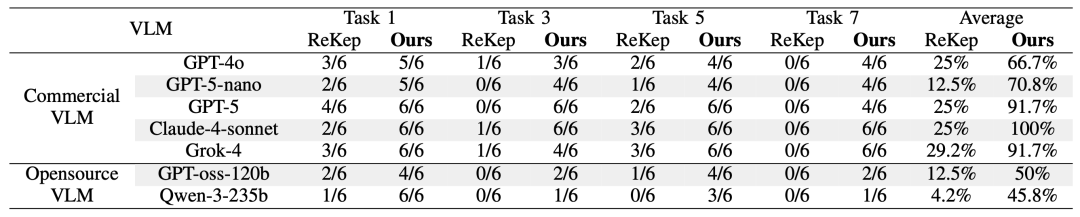

- 对比 ReKep:在与基于关键点的 ReKep 框架对比中,ManiAgent 在长序列和复杂场景下表现出明显优势。比如在复杂的桌面整理任务中,ReKep 成功率仅为 0%,ManiAgent 达到 100%。

表 4:ManiAgent 与 ReKep 在物理场景中的性能对比

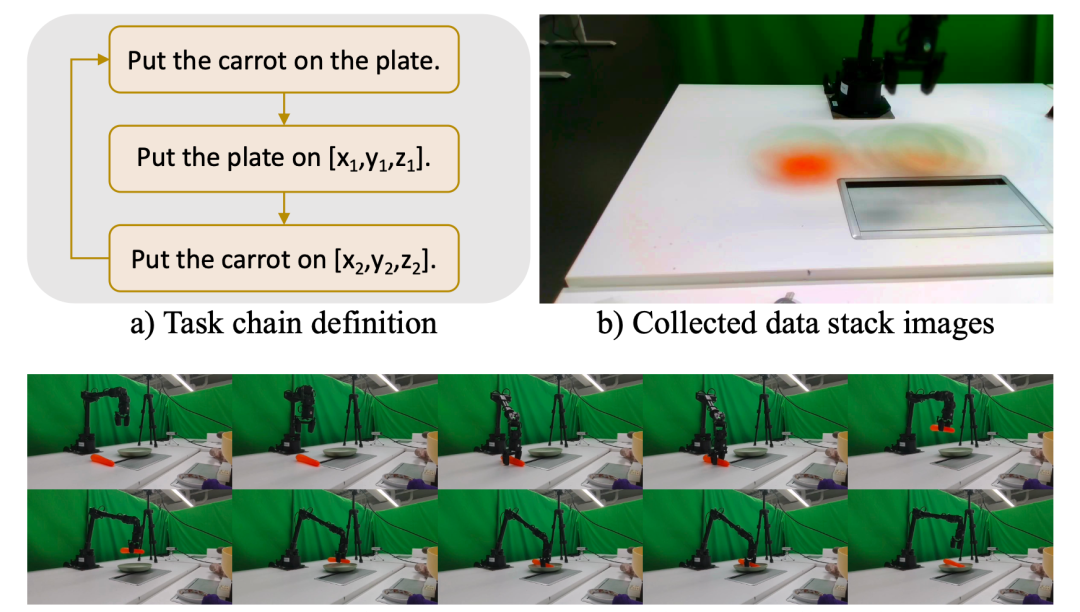

自动数据生成

ManiAgent 最大的贡献可能不仅仅是一个高性能的操控框架,而是一个高效的自动化数据工厂。作者团队展示了一个令人兴奋的闭环逻辑:

- 自动生成数据:利用 ManiAgent 在真机上的高成功率,结合随机生成或基于规则的目标坐标,机器人可以日以继夜地自动执行任务并收集数据。在“胡萝卜放盘子”的测试中,系统自动运行了 19.5 小时,收集了 551 条轨迹,仅需每 46 分钟进行一次人工干预。

- 反哺 VLA 模型:更关键的是,作者团队用 ManiAgent 自动生成的数据训练了一个小型的 CogACT 模型。结果显示,用这些“机器生成数据”训练出的 VLA 模型,其效果与通过人类手动采集数据训练的模型相当。

图 6:ManiAgent 自动数据生成示意图

这意味着数据飞轮成为可能。既然 ManiAgent 不需要训练就能跑通(虽然推理慢一点),那就可以让它先当“老师”,不知疲倦地生成海量的高质量轨迹数据;然后用这些数据去喂养更轻量、更快速的端到端 VLA 模型。这样既解决了 VLA 的数据饥渴,又解决了 Agentic 方案推理延迟高、部署成本高的问题。

结论

在本文中,作者团队提出 ManiAgent,这是一个将通用操作任务分解为四个阶段的框架,通过使用专门的智能体分别负责感知、推理和控制来完成机器人操作。实验结果表明,ManiAgent 在仿真环境中表现优于大多数 VLA 模型,实现了 86.8% 的成功率;且在搭载高性能 VLM 时,在真实世界任务中达到了 95.8% 的平均成功率。

此外,ManiAgent 在通用操纵任务中的高成功率使其成为一种有效的自动数据收集工具,能够以较低的成本生成用于 VLA 训练的高质量数据集。未来的工作将集中在增强实时反馈、将应用扩展到机械臂以外的多种平台,以及探索人机交互方面。

参考文献

[1] Yang, Y., Gu, K., Wen, Y., Li, H., Zhao, Y., Wang, T., & Liu, X. (2025). ManiAgent: An Agentic Framework for General Robotic Manipulation. In arXiv.org: Vol. abs/2510.11660. https://doi.org/10.48550/arXiv.2510.11660

[2] Fang, H., Wang, C., Fang, H., Gou, M., Liu, J., Yan, H., Liu, W., Xie, Y., & Lu, C. (2023). AnyGrasp: Robust and Efficient Grasp Perception in Spatial and Temporal Domains. In IEEE Transactions on Robotics (Vol. 39, Issue 5, pp. 3929–3945). https://doi.org/10.1109/TRO.2023.3281153

[3] Xiao, B., Wu, H., Xu, W., Dai, X., Hu, H., Lu, Y., Zeng, M., Liu, C., & Yuan, L. (2024). Florence-2: Advancing a Unified Representation for a Variety of Vision Tasks. IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). https://doi.org/10.48550/arXiv.2311.06242

[4] Huang, W., Wang, C., Li, Y., Zhang, R., & Fei-Fei, L. (2024). ReKep: Spatio-Temporal Reasoning of Relational Keypoint Constraints for Robotic Manipulation. 8th Annual Conference on Robot Learning.

[5] Li, Q., Liang, Y., Wang, Z., Luo, L., Chen, X., Liao, M., Wei, F., Deng, Y., Xu, S., Zhang, Y., Wang, X., Liu, B., Fu, J., Bao, J., Chen, D., Shi, Y., Yang, J., & Guo, B. (2024). CogACT: A Foundational Vision-Language-Action Model for Synergizing Cognition and Action in Robotic Manipulation. In arXiv.org: Vol. abs/2411.19650. https://doi.org/10.48550/arXiv.2411.19650

[6] Black, K., Brown, N., Driess, D., Esmail, A., Equi, M., Finn, C., Fusai, N., Groom, L., Hausman, K., Ichter, B., Jakubczak, S., Jones, T., Ke, L., Levine, S., Li-Bell, A., Mothukuri, M., Nair, S., Pertsch, K., Shi, L., … Zhilinsky, U. (2025). π₀: A Vision-Language-Action Flow Model for General Robot Control. Robotics: Science and Systems XXI, abs/2410.24164. https://doi.org/10.48550/arXiv.2410.24164

[7] Li, X., Hsu, K., Gu, J., Pertsch, K., Mees, O., Walke, H. R., Fu, C., Lunawat, I., Sieh, I., Kirmani, S., Levine, S., Wu, J., Finn, C., Su, H., Vuong, Q., & Xiao, T. (2024). Evaluating Real-World Robot Manipulation Policies in Simulation. RSS 2024 Workshop: Data Generation for Robotics, abs/2405.05941.

- 商汤开源 SenseNova-MARS,突破多模态搜索推理天花板2026-01-30

- 千问C端应用团队一口气四篇论文入选ICLR 2026国际顶会!2026-01-30

- 腾讯混元再引强将,庞天宇即将入职多模态模型团队负责强化学习前沿算法探索2026-01-30

- 让世界模型直接控制机器人动作,蚂蚁灵波开源具身世界模型LingBot-VA2026-01-30