具身开源模型新王!千寻Spirit v1.5模型登顶 RoboChallenge,终结 Pi0.5领跑时代

首个在RoboChallenge上成功率超过50%的具身智能模型

henry 发自 凹非寺

量子位 | 公众号 QbitAI

事情开始变得有趣起来了。

刚刚,来自千寻智能的具身智能基础模型Spirit v1.5,在RoboChallenge真机评测榜上,以总分66.09,成功率50.33%的成绩,超越美国明星公司Physical Intelligence的Pi0.5 (π0.5),登顶榜首。

基于多样化的预训练数据采集范式,Spirit v1.5在插花、把水果放进篮子、挂牙刷杯等多项任务中,拿下第一,刷新榜单纪录。

经此一役,Spirit v1.5不仅是RoboChallenge自去年10月上线以来,首个击败baseline模型Pi0.5的国产具身模型,同时也是首个在RoboChallenge上成功率超过50%的具身智能模型。

在此之前,RoboChallenge榜单上,模型间的竞争已逐渐进入白热化阶段,Pi系列基线模型不断被逼近。

而现在,Spirit v1.5直接越过Pi0.5,拿下榜首。

这种密集、连续的刷榜节奏,多少有点让人想起当年AlexNet、VGG、GoogLeNet、ResNet刷新ImageNet的那段时间——

基准在被不断打破,模型天花板被一再抬高。

也正如当年CV的开源景象,Spirit v1.5同步开源了基模权重、推理代码以及使用样例,方便后续的研究者复现和进一步探索。

而正是在这被誉为具身智能「ImageNet」的RoboChallenge上,开源模型正以可验证、可复现的方式,持续推动具身能力向前发展。

开源具身模型能力,全球领先

截至2026年1月12日,Spirit v1.5在RoboChallenge上取得了当前最优的性能,超越了Pi0.5等之前的全球领先开源模型。

在RoboChallenge的Table30任务中,Spirit v1.5表现堪称 “碾压级”,不仅在下列多项任务中夺得第一:

- 插花(arrange flowers)

- 水果入篮(arrange fruits in basket)

- 挂牙刷杯(hang toothbrush cup)

- 薯条倒碗(pour fries into plate)

- 开瓶器入抽屉(put opener in drawer)

- 笔入笔盒(put pen into pencilcase)

- 寻找绿盒(search green boxes)

- 浇花(water potted plant)

- ……

还在贴胶带(stick tape to box)、清扫垃圾(sweep the rubbish)、开关灯(turn on light switch)等任务上实现绝对领先。

其中 “寻找绿盒” 任务堪称高光时刻——Spirit v1.5直接将成功率拉至90%。

演示画面中,它能快速从一堆彩色方块中锁定绿色目标,稳稳放入指定篮子,整个过程干脆利落,没有丝毫拖泥带水。

在水果入篮任务中,Spirit v1.5更是以80%的成功率,领先Pi0.5整整一倍。

在演示中,Spirit v1.5能够轻松地拿起香蕉,放进篮子(下图经5倍加速)。

而在插花任务中,虽然两款模型成功率均 50%,但实际执行中,Spirit v1.5的稳定性碾压Pi0.5,没有出现极端的失败案例。

在演示中,Spirit v1.5基本上可以稳稳地将鲜花放入花瓶。

而Pi0.5有时则会出现突然卡死的情况,从而导致任务中断。

在最考验技术功底的贴胶带任务中,即便Spirit v1.5 20%的成功率不算特别突出,但对比Pi0.5仅10%的表现,仍实现了翻倍领先。

贴胶带属于典型的闭环触觉接触任务(机器人手指 / 夹爪间隙极小),对机械臂协同与触觉感知要求极高,机器人经常会出现空抓的现象。

在演示中,Spirit v1.5凭借双机械臂精准配合,能流畅完成撕胶、贴盒全流程。

而相比之下,Pi0.5虽然能很快的定位到胶带的位置,但却难以感知到是否撕到胶带,频频出现了空贴的现象。

透过上述任务我们不难看出,Spirit v1.5在复杂长指令任务中的稳定发挥,意味着其已经进化为一个具备出色逻辑推理与空间感知能力的“具身大脑”。

而这份实力的认证,正来自具身智能领域的标杆级 “试炼场”——RoboChallenge。

RoboChallenge由Dexmal原力灵机联合Hugging Face发起,是首个在真实物理环境中,由真实机器人执行操作的大规模、多任务基准测试。

它的Table30任务集,通过30个高频桌面及周边日常场景,从VLA难点、机器人形态、任务流程与物体属性等维度考察模型真实世界通用操作能力。

考试机型覆盖ARX5、UR5e、ALOHA、Franka、UR5等;测试任务涵盖抓取、放置、堆叠、打开、按压、分类等复杂动作。

除上述任务设置外,RoboChallenge它的核心创新,在于Remote Robot Paradigm(远程机器人范式):

参赛者在本地运行模型,只需通过HTTP接口向机器人发送控制指令,机器人被视作一个可远程调用的“外设”。

这一设计显著降低了参赛门槛,同时避免了复杂环境配置带来的不确定性,使不同团队的算法能够在同一套真实硬件条件下接受统一评测。

所有参赛者均可通过官方页面查看比赛实况,全程保障赛事的公平与透明。

不过,由于推理发生在用户侧,模型的具体实现仍主要依赖参赛者自律与社区共识——

例如是否始终保持与所声明方案的一致性,是否在多任务通用型模型(multi-task generalist model)的设定下,避免针对单一任务的特殊化调优。

(注:RoboChallenge区分任务特定与通用型两种训练协议:前者针对单一任务单独训练,后者用少量混合数据训练一个多任务统一模型。榜单中带有/multi 后缀的模型,如Pi0.5/multi,遵循的正是这一更具挑战性的通用型设定。)

也正是在这一背景下,Spirit v1.5此次选择同步开源,其意义不仅在于成绩本身,也契合了RoboChallenge鼓励通过可复现、可验证的方式,共同推动具身智能基准向前发展的初衷。

那么,Spirit v1.5具体是怎么做到的呢?

数据多样性成制胜法宝

Spirit v1.5的核心创新,主要体现在预训练阶段的数据策略上。

它将具身模型的预训练数据,从高度精选、强控制的「干净数据」,转向多样化、开放式、弱控制的数据采集范式。

这里所说的「干净数据」,通常指动作模式相对单一、物体摆放位置与视角高度固定的精选数据集。

例如Open X-Embodiment 、Agibot和RoboCOIN等具身模型训练的主流数据集。

△Open X-Embodiment

这类数据的优势在于:数采成本低、学习难度可控;

但代价同样明显——动作模式的多样性被显著压缩,模型对真实世界不确定性的适应能力因此受限。

针对这一问题,Spirit v1.5采取了相反的策略。

在数据采集阶段,它鼓励数采员只围绕任务目标行动,而不强制遵循固定的动作流程。

例如,在为假人头部化妆时,采集员并不会严格复现某一套标准操作,而是以更接近真实人类行为的方式自由完成任务。

这样做的结果是采集来的数据不再是单任务、单目标的单成功轨迹。

而是在自然执行过程中,连续覆盖了抓取、插入、整理、双臂协作、异常处理等大量原子技能,并以真实世界的时序关系串联在一起。

这种开放式采集显著扩大了动作分布,使模型在预训练阶段“见过更多可能性”,从而具备更强的迁移与泛化能力。

在工程层面,这一策略同样带来了可观收益:人均有效采集时长提升约 200%,对算法专家深度介入的需求降低约60%。

而在实验验证中,这种以多样性为核心的数据策略,同样得到了印证。

一方面,在RoboChallenge Table30的真机评测中,Spirit v1.5已经在整体能力层面证明了该范式是成立的(相关结果已在前文展开)。

另一方面,在消融实验中,研究团队在预训练数据规模完全一致的前提下,对比了两种策略:

- 基于脚本化任务演示的预训练;

- 基于多样化、开放式采集的预训练。

结果显示,多样化预训练的模型在新任务上的微调效率显著更高:在达到相同性能时,所需迭代次数减少约40%。

进一步扩大多样化数据规模后,模型的验证误差仍在持续下降,并未出现明显的早期饱和现象。

这些发现表明,对具身模型而言,任务多样性比单一任务的演示数量更为关键。

模型真正学到的,并非某个任务的最优动作序列,而是一套可迁移的通用策略,使其能够用更少的步骤适应新任务。

由此,使用高多样性、弱控制的数据进行预训练不仅可行,而且显著优于文献中常见的利用“干净”数据的做法。

也正因为并非针对单一任务优化,Spirit v1.5更适合作为一个通用具身智能的基础模型被复用。

对学界而言,它提供了一条不同于Pi系列且更优的开源技术路径。

对产业团队而言,这种以真实世界多样性为起点的预训练方式,显著降低了新场景的迁移与适配成本。

随着模型权重与代码同步开源,Spirit v1.5在RoboChallenge上的成绩不再只是一次展示,而成为一个可验证、可复现、可继续推进的起点。

Spirit v1.5背后的团队:千寻智能在做什么

最后,再把视角拉回到Spirit v1.5背后的团队——千寻智能(Spirit AI)。

成立于2024年1月的千寻智能,是一支非常“年轻”的队伍,却已经成长为国内少数具备AI+机器人全栈、生产力级技术能力的具身智能公司。

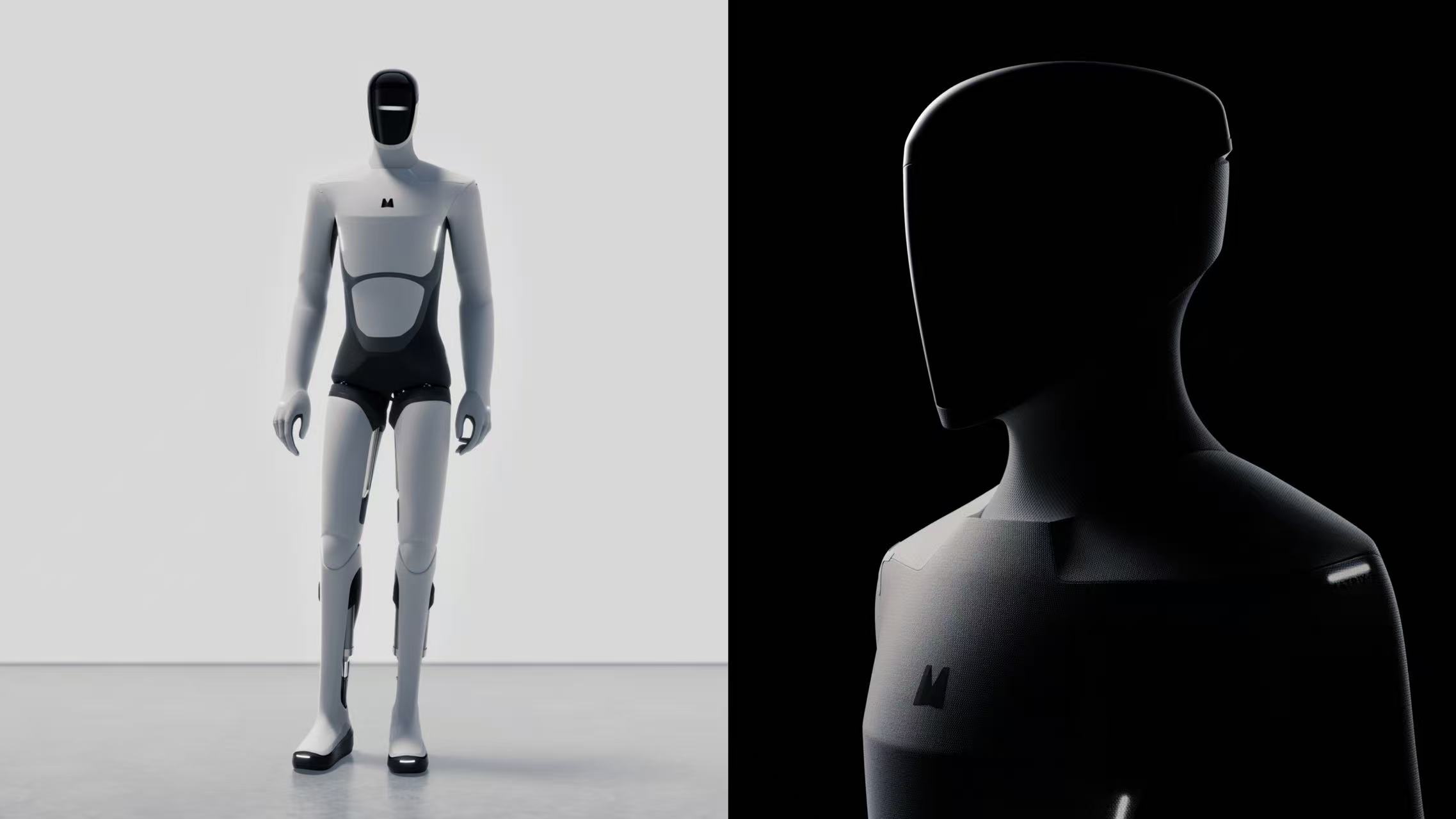

简单概括,千寻的路线非常明确——通用人形机器人+具身大模型(VLA)一体推进,因此常被外界称为“中国版 Figure”。

创始人兼CEO韩峰涛:机器人行业连续创业者,曾任珞石机器人联合创始人兼CTO,在机器人行业拥有十余年经验,主导交付过超2万台工业机器人。

联合创始人兼首席科学家高阳:清华交叉信息研究院助理教授,“伯克利归国四子之一”,师从具身智能权威学者Pieter Abbeel,其提出的ViLa算法被Figure采用。

在融资方面,2025年千寻智能狂揽超15亿元融资,6月PreA+轮由京东领投6亿元,浙江省科创母基金、华泰紫金等新势力跟投,顺为资本、华控基金等老股东更是继续跟投。

在商业落地方面,其通用人形机器人 “小墨”(Moz1)已于2025年底在宁德时代电池产线规模化落地,精细作业成功率突破99%,用工业级场景完成了一次硬核验证。

而在技术路径上,从Spirit v1攻克柔性物体长程操作,到开源「边想边做」的OneTwoVLA,再到如今基于多样化真实数据采集的Spirit v1.5——

千寻始终在做一件事:把具身智能从“实验效果”,推进到“可复现、可量产、可落地”的工程体系中。

而这次Spirit v1.5在RoboChallenge上的登顶,并不仅仅意味着一次榜单上的领先。

它更像是千寻具身智能模型快速迭代周期中,一次在同一公开基准下完成的、具有标志意义的性能对标:

在真实机器人、真实任务、统一评测条件下,对现有的技术路线进行了一次阶段性验证。

从结果来看,Spirit v1.5在泛化性、稳定性与鲁棒性等系统层面的能力,已经出现了整体跃迁,而不仅是单点任务的“刷分”。

更重要的是,这一成绩并未停留在展示层面。

Spirit v1.5同步开源模型权重、推理代码和使用样例,使得这一结果可以被复现、被检验、也可以被后续研究继续推进。

正如当年ImageNet之于计算机视觉,只有在一个可复现、公正、开放的基准之上,模型能力的进步才具备真正的参考价值。

而模型的开源也进一步方便后续研究者的快速迭代优化与创新探索。

在被不少研究者视作具身智能「ImageNet」的RoboChallenge上,这次登顶既是一次能力确认,也是一种明确表态——

千寻选择将技术进展放入开源体系之中,与社区一起,把具身智能的天花板持续往前推。

正如千寻首席科学家高阳针对Spirit v1.5在开源模型赛道斩获全球第一时说所的:

它不仅是一次技术上的突破,也意味着我们在追寻智能的道路上,再次站到了当下人类智能所能企及的高度之一。更重要的是,这个模型是开源的。我们选择把它交到更多人手中,让大家一起使用、一起验证、一起推进这条路。智能不应该被少数人垄断,而应该被共同建设。

开源地址:

Code: https://github.com/Spirit-AI-Team/spirit-v1.5

Model: https://huggingface.co/Spirit-AI-robotics/Spirit-v1.5

Blog:https://www.spirit-ai.com/en/blog/spirit-v1-5

- 具身智能开年最大融资,字节红杉领投10亿2026-01-12

- Hinton的亿万富豪博士生2026-01-10

- 吴恩达:图灵测试不够用了,我会设计一个AGI专用版2026-01-10

- 起猛了,追觅的扫地机、割草机、洗护机器人在CES成精了!2026-01-09