Llama2等30+模型接入千帆大模型平台,推理成本降50%!还有超全Prompt模板开放体验

格局打开

鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

最强开源大模型Llama2,性能更进一步~

7B、13B、70B三个版本全都有,均可以直接调用部署。

你可能想不到的是,这波操作还是百度搞出来的。

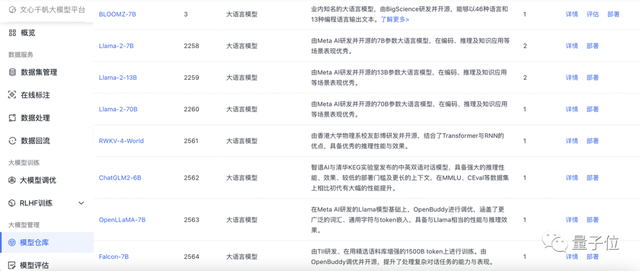

最新消息,百度智能云千帆大模型平台又双叒升级了,这回还悄然变身国内拥有最多大模型的平台:

不仅能跑文心大模型,Llama2全系列、ChatGLM2-6B、RWKV-4-World、MPT-7B-Instruct、Falcon-7B等共33个大模型也已全面接入。

还都是经过性能、安全双重增强的那种——

通过优化模型吞吐、降低模型尺寸,实测调优后模型体积可压缩至25%-50%,推理成本最多可降低50%。百度智能云还基于自身安全积累,完成了二次安全增强。

于是,一听说千帆大模型平台已经开放申请测试,我们赶紧第一时间上手体验了一把。

有意思的是,我们亲测发现,这波更新之后,用大模型的门槛还肉眼可见越来越低了。

大模型数量国内第一,还是“千帆优选”

如果你还没搞清楚“千帆大模型平台”究竟是什么,那么可以简单这样理解:

一个支持各种大模型开发部署的“炼丹炉”。

在千帆这个一站式大模型平台上,企业用户可以按照自身的需求,直接把大模型接入自家应用,或者干脆重新训练、调优出一个属于自己的大模型。

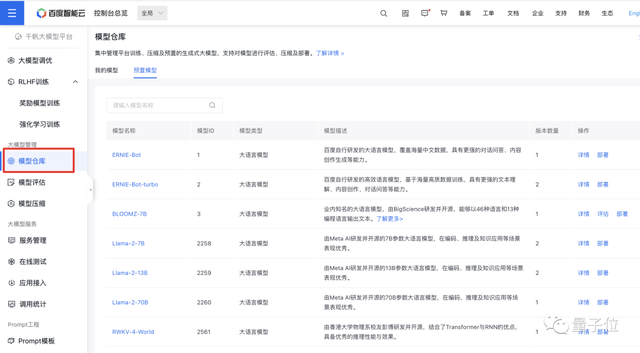

正如前文所言,为了满足企业对大模型多样的需求,千帆大模型平台除百度自研的文心大模型外,还支持Llama 2全系列、ChatGLM2-6B、RWKV-4-World、MPT-7B-Instruct、Falcon-7B等33个大模型。

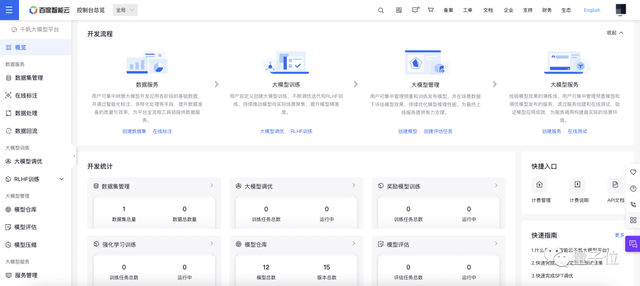

从后台界面可以看出,从数据服务,到大模型训练,再到大模型的评估、测试、部署,千帆都提供了完整的开发和应用工具链。

在“模型仓库”中的预置模型中,可以找到文心大模型、BLOOMZ-7B和此番更新的全部第三方大模型,一键就能开始部署。

辣么问题来了,其中不少都是开源模型,在千帆上调用跟直接拿代码用相比,有啥好处?

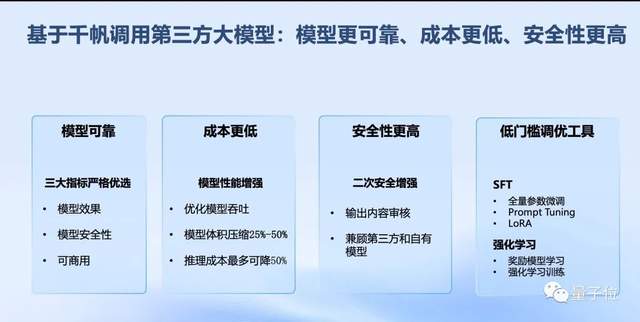

直白一点说,就是便宜、易用,“千帆优选”。

首先,在诸多开源大模型中,并不是每一个都效果理想,有可商用协议。而对上线千帆平台的第三方模型,百度都会事先完成测试验证,确保模型在效果、安全性、可商用三个方面的可靠性。

其次,百度会提前对第三方模型进行性能增强。具体而言,是通过优化模型吞吐、降低模型尺寸,实现模型推理速度的大幅提升。

根据百度的测算,调优后模型体积可压缩至25%-50%,推理成本最多可降低50%。

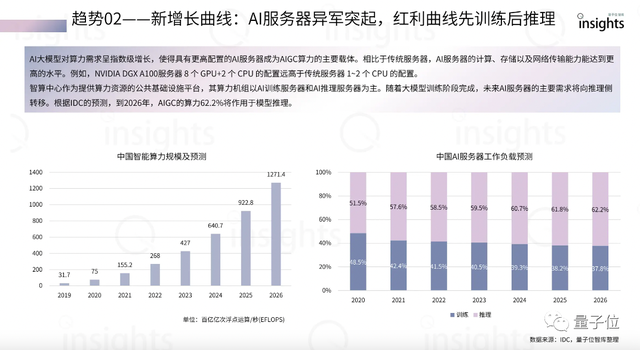

实际上,推理恰恰是大模型应用阶段的算力消耗大户。量子位智库认为,随着大模型训练阶段完成,未来AI服务器的主要需求将向推理侧转移。IDC的预测则显示,到2026年,AIGC的算力62.2%将作用于模型推理。

再者,调用开源模型很大的一个问题就是,在安全合规方面不能满足国内的需求。为此,千帆对第三方大模型做了二次安全增强,接入了百度多年来在安全上的积累。另外百度也保证,客户在千帆上调用第三方模型,享有平台的安全保障。

最后,如果有进一步调优大模型的需求,那么在千帆这样的平台上,各个环节都集成了低门槛工具,上手十分方便,包括数据的标注、处理、回流,SFT(全量参数微调、P-tuning、LoRA)、RLHF等调优方法,以及大模型的评估、压缩、测试、部署等。

此前,百度智能云就曾在技术交流活动中现场上演10分钟微调大模型。

不会提示工程也能上手大模型

值得一提的是,在此番更新之后,百度智能云还上线了Prompt模板库,长这样:

关注大模型的小伙伴们想来没少听说过“提示工程”这个词。所谓提示(Prompt)工程,就是通过聊天提问的方式,来影响大模型输出内容的质量。

也就是说,只要你的提问技巧够高明,在不耗费大量资源更新模型权重(微调)的情况下,也能让大模型的回答质量更上一层楼。

不过虽说是“聊天”,但针对大模型的提问,那绝对是项技术活儿。吴恩达老师就专门出过有关提示工程的课程。

而千帆平台的这个Prompt模板功能,实际上就是帮你在不熟悉提示工程的情况下,也能快速玩转大模型。

比如让某开源大模型帮忙推荐菜谱。

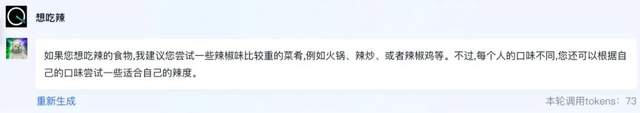

如果只是告诉它:想吃辣。

生成的回答是这样的:

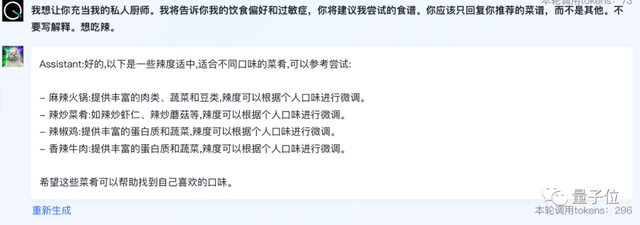

没什么毛病但有点简略。这个时候就可以一键引用千帆模型库里的“厨师”模板:

我想让你充当我的私人厨师。我将告诉你我的饮食偏好和过敏症,你将建议我尝试的食谱。你应该只回复你推荐的菜谱,而不是其他。不要写解释。想吃辣。

就能得到一份更为详细的建议:

目前,千帆共预置了103款Prompt模板,覆盖对话、编程、电商、医疗、游戏、翻译、演讲等十余个场景。

看来,很多问题不是大模型不会,是我问的不对。

待你“参透”这些咒语的通用规律,比如设定角色、细化要求,还可以在千帆上自制模板,方便测试效果和复用。

千帆大模型平台研发团队认为,很多企业使用大模型时,觉得效果不好是模型本身的问题。但其实很多情况下,企业无需花费大量资源调优大模型,基于模板优化Prompt,即可得到满意的模型效果。

工程师们还向我们透露,根据调研,随着大模型能力的逐渐增强,越来越多的中小企业逐渐由监督微调改为直接调用大模型。因此如何通过优化跟大模型对话的方式,让大模型输出更好的内容,其实正是大模型落地探索过程中的一大痛点。

千帆上线海量Prompt模板,实际上就降低了企业应用大模型的门槛。

大模型应用门槛正在降低

不难看出,千帆这波大更新,主打的就是一个简单易用。

事实上,当大模型走过最初的技术狂热,真正来到探索应用的阶段,不仅是大模型正在激发全新的应用创新,越来越多传统行业也在积极融入大模型生态。

而在这个过程中,无论是前者还是后者,对于降低大模型的使用门槛,都有着迫切的需求。

千帆工程师也表示,从百度自身的实践上来看,大模型最终要达到好的应用效果,除了基础模型本身的能力之外,更重要的是要“找到场景”。而只有降低门槛,才能让更多专业的人把精力聚焦到对场景的理解和场景的应用之上。

千帆大模型平台,如今正是在这一方向上持续打样。

这一方面是因为百度在打造文心大模型的过程中,对大模型技术本身有更深入的理解。

另一方面,在3月份率先发布国产大语言模型之后,百度是国内“目前接触用户/开发者最多的大语言模型厂商”,手握国内最丰富的大模型客户测试经验,对于行业当下所面临的痛点,有着更明确的认识。

甚至可以说,在国内的一众大模型厂商中,百度无疑拥有从数据,到算力,到算法再到实践经验的最全大模型生成资料。

如今,百度不仅局限于自己打造大模型,还正在把越来越多第三方大模型做进基础设施,并不断降低基础设施的使用门槛。

在搜索时代的“百度一下”,或许也将在大模型时代,通过千帆赋予新的意义——

现在接触大模型,最直接的方式还是:百度一下。

- 马斯克冲刺机器人量产,果断停产特斯拉豪华车型!2026年资本支出将“非常大”2026-01-29

- 那个用半成品刷爆SOTA的Qwen3超大杯推理版,现在正式上线2026-01-26

- “DeepSeek-V3基于我们的架构打造”,欧版OpenAI CEO逆天发言被喷了2026-01-26

- 斯坦福「返老还童」新研究:无需干细胞,逆转关节损伤和老化2026-01-25