CPU也支持AI加速,英特尔发布第3代至强处理器,推理速度提升80%,阿里腾讯云都在用

引入全新BF16浮点数类型

晓查 发自 凹非寺

量子位 报道 | 公众号 QbitAI

AI时代,英特尔最担心的是什么?当然是自家的CPU被GPU、TPU等AI硬件的冲击。现在英特尔的新一代CPU也带来了全新的AI加速能力。

今天,英特尔发布了三款硬件产品,都是为了AI而准备:第三代至强(Xeon)可扩展处理器、新一代的傲腾(Optane)存储器以及Stratix AI FPGA。

至强可扩展CPU

首先,英特尔发布了Cooper Lake至强可扩展处理器,也就是英特尔的第三代至强可扩展服务器CPU。

在英特尔的路线图中,还有Ice Lake至强处理器将在今年晚些时候推出,也属于第三代,只是支持的CPU数量比Cooper Lake更少,应该是一款面向中低端的产品。

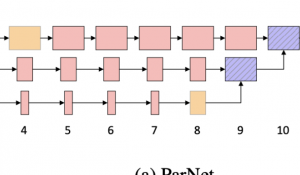

对于Cooper Lake平台,英特尔加入了一项重要更新,增加了基于AVX-512的BF16指令,引入了全新的BF16数字格式。

现在,用于“深度学习增强”(DL Boost)的AVX-512指令集也支持全新的BF16数据类型。

过去,英特尔在CPU上的AI训练主推INT8整数格式,在精度要求不高的模型中,使用INT8还是可以的。但是许多高精度模型需要使用FP32浮点数格式。

新一代的至强CPU加入了对16位浮点数支持,不过此16位浮点并非常见的FP16,而是英特尔称之为bfloat16(BF16)的格式。

BF16将FP32模型的位宽减少一半,除了加速处理速度外,更重要的是,它将模型保留在内存中所需的空间减少了一半。

△ 图片来自AnandTech

BF16可以执行许多通常在FP32或FP16中实现的AI任务,它只是比FP32的范围稍低,但是却能有与FP16几乎相同的吞吐量。

国内的阿里云、腾讯云都已经在其数据集上使用了支持BF16的CPU,实现了1.6倍左右的吞吐量加速和1.8倍左右的推理加速。

英特尔还对Cooper Lake处理器之间的互连进行了升级。

至强处理器使用超路径互连(UPI)将多个CPU连接在一起。在Cooper Lake中,每个CPU到CPU的连接现在都包含两个UPI链接,链接速度达到了20.8GT/s。

傲腾SSD和Stratix FPGA

英特尔还宣布了新一代的傲腾(Optane)“持久内存” 200系列,带宽相比前代提升了25%。

200系列傲腾提供128 GB、256 GB和512 GB三个不同存储容量,并且将以与DDR4-2666内存相同的速度运行。

该系列为每个插槽提供高达4.5TB的内存支持,以更好地处理数据密集型的AI工作负载。

最后,英特尔发布了Stratix 10 NX FPGA,这是英特尔第一个针对AI优化的FPGA。

Stratix 10 NX FPGA加入了为AI设计的张量模块,在INT8数据类型上,相比现在的Stratix 10 MX FPGA带来了15倍的运算加速。

参考链接:

https://www.anandtech.com/show/15862/intel-launches-cooper-lake-3rd-generation-xeon-scalable-for-4p8p-servers

- 脑机接口走向现实,11张PPT看懂中国脑机接口产业现状|量子位智库2021-08-10

- 张朝阳开课手推E=mc²,李永乐现场狂做笔记2022-03-11

- 阿里数学竞赛可以报名了!奖金增加到400万元,题目面向大众公开征集2022-03-14

- 英伟达遭黑客最后通牒:今天必须开源GPU驱动,否则公布1TB机密数据2022-03-05