阿里洛神云网络这局妥了!集齐“软硬结合、创新NFV、智能管理”三张牌

晶少 发自 凹非寺

量子位 报道 | 公众号 QbitAI

导语:在云网络风靡的今天,洛神云网络作为阿里云飞天的虚拟网络系统核心,目前在软硬一体、NFV平台创新以及智能性方面究竟有何新意?对用户与开发者的影响作用如何?更多了解云网络涉及的技术细节,或许这篇文章可以帮助你!

洛神,乃中国先秦神话中司掌洛河的地方水神,无上尊崇。

取同名,洛神云网络平台,作为阿里云飞天操作系统的三大核心之一,至关重要。

与神龙、盘古齐名,基于网络虚拟化技术,洛神云网络平台通过对超大规模租户、超大规模虚拟机的高性能云网络支撑,达成了借古时河运的四通八达隐喻云上网络连通万事万物,异曲同工。

掐指一算,洛神云网络平台伴随飞天演进已有十年之久,其网络产品的推进时间与企业上云的时间大致无异。

最初只是提供一些AVS、SLB等单实例,但伴随基础上云之后云上云下相结合的高速通道、专线以及智能接入网关等迫切需求,系统不断演进,以后的技术升级大部分基于云上架构需求以及用户业务支撑等因素。

这一点就像,最初在1.0时代,洛神云网络平台的职责仅仅是高效支撑超大规模以及多租户网络,可以被称为从无到有。

但随着云上业务的快速增长,2.0升级版的洛神云网络平台也同时迈向更高性能、更大弹性、越发智能化的存在。

例如针对VPC的基础组件做了全链路的软硬一体化设计;通过硬件化让vSwitch的性能对比软转发提升了10倍以上,大幅降低延迟。

开放弹性的云网络NFV平台,加强通用的资源池化、弹性扩缩容、故障隔离、服务链编排等通用管控能力并带来友好生态等。

所以洛神云网络的技术关键词,即性能、弹性与智能,不但是其创新迭代的主要内容,也是未来该平台技术演进的终极方向。

软硬兼收,转发性能高达千万PPS

谈及洛神云网络的技术架构,可以被认为由三部分组成, 分别是数据平面,控制平面和管理平面。

其中数据平面主要负责云网络中数据包的处理,简单说就是帮助数据包以高频率低延迟的方式从发送端口到目的地。

可想而知,数据平面必然包含很多不同角色的组件,用来支撑不同种类的虚拟化交换机以及混合云网关等。

量子位获悉,为了提高这些组件的转发性能,平台不仅使用了软转发,还对软硬件一体化甚至纯硬件的技术升级做了深入研究。

洛神云网络平台的2.0升级版就是如此。

其实云网络的发展才是这几年的事儿,无论是业务还是需求都在飞速变化中,因为标准的缺乏,按需定制成为主流。

深入到技术层面,目前云网络的各种业务转发差不多都是基于CPU做软转发。

但其中却有一些不可规避的问题,比方说由于CPU的单core性能瓶颈,在大流量以及攻击场景下十分容易被打爆,从而导致故障。

此外由于摩尔定律逐渐失效的现实情况,CPU在频率以及核数提升方面的空间一直被压缩,如果仅仅依靠CPU来完成进一步的性能提升难度较大。

对此很多相关技术从业者都比较困惑。

所以为了提升云网络的性能与稳定,并同时满足业务需求,洛神云网络平台2.0升级版就对数据平面的VPC基础组件做了全链路的软硬一体化设计。

其中包括Gateway以超大流量+百万表项为目标,vSwitch以超大表项+百Gbps为目标等。

在追求性能极致的实践中,阿里云智能网络产品高级技术专家云州透露,将软件灵活性与硬件的性能特点相结合才会更加容易获得网络的高性价比。

此外由于洛神云网络平台本身由很多网络设备组成,在架构上可以分为虚拟交换机AVS与各种网关设备两类。

其中AVS主要负责ECS的虚拟网络接入,而网关设备则主要提供了丰富的网络功能与服务。

升级中,AVS和基础网关设备都已成功实现了硬件加速,使转发性能显著提升,单核问题和水位问题不复存在。

值得提及的一点,AVS 基于软硬件一体化方式,使用神龙架构实现快速转发,转发性能相比之前提升数倍,已经达到千万 PPS。

更重要的是,由于平台的数据面深入包含了软硬件结合的转发技术和架构,这就意味着网络不会因为维护而中断,所有组件都果断支持热升级。

当然除了更低成本与更高性能的具体驱动外,云州表示,软硬结合的技术升级会在后续的网络架构迭代过程中进一步提升系统发展速度。

做到更迅速基于虚拟化的方式,在全球范围内为用户搭建更多虚拟网云,用户使用起来也会更加顺畅。

正如洛神云网络平台所做的“既硬又软”的技术尝试,随着云计算承载的业务规模越发庞大,软硬件的结合早已成为刚需,不单单局限在云网络技术中。

可以肯定的一点,软硬结合除了在本身性能上带来提升外,更重要的是伴随发展,可以帮助云计算的开发者与使用者更好提升资源利用率,获得更具性价比的服务,例如更大带宽、更低延时与更加可靠的网络连接等,何乐而不为?

100G+转发/弹性伸缩,智创NFV平台来一套

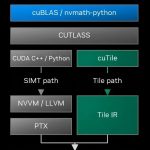

除了“硬件福利+软件灵活”的高效利用外,洛神云网络平台2.0还在转发网元方面有了更加丰富的贡献,其中既包括神龙云服务器架构,还有专用可编程芯片以及通用 ECS等。

总体来看,系统的弹性升级主要聚焦在架构的控制平面上。

作为平台的业务大脑,控制平面是一个层次性鲜明的分布式控制系统,除了最底层的设备控制器用来控制各种组件之外,在每个区域还有一个虚拟网络控制器实现区域内的云网络调度。

而基于虚拟网络控制器和全局路由控制器之上的则是NFV控制器,用来完成虚拟网络高级功能等。

据悉,目前为止大部分的网关网源类产品主要还是用X86软转发,但洛神云网络平台2.0则是通过创新构建了一个NFV平台,让支持业务的网元不再单独依赖传统X86服务器。

毕竟基于x86物理机软转发架构会出现单核性能瓶颈、物理机扩容周期长,弹性不足,无法按需扩缩容等诸多问题。

我们可以将此理解为,拥抱云原生,将网元逻辑部署在通用的ECS上,以此提供弹性与开放能力,更好弥补硬件灵活性不足。

据悉,结合ECS的弹性和NFV架构的水平伸缩能力,能分钟级交付单客户100G+的转发,提升效果显著。

或许你可能了解,NFV平台的定位就是构建通用、灵活的平台能力,由NFV转发和NFV管控两部分组成。

主要包括虚拟网络的调度能力和NFV资源池的抽象管理能力,从而降低业务网元NFV化的门槛和成本,提高产品能效。

除了可以做到基于ECS构建资源池,提供分钟级交付和弹性伸缩能力之外,还支持多租户模式,提供通用的负载均衡、故障隔离等基础能力。

此外,适配网络功能的服务链编排,将网络产品和安全产品串接成解决方案,并同时支持第三方生态接入。

据了解,作为洛神云网络平台2.0的重要一部分,目前PrivateLink、NAT、SLB等网元产品已经演进到了新一代NFV架构,后续也会有更多产品基于NFV架构进行构建和演进。

的确,网络功能虚拟化 (NFV)确实可以帮助企业降低设备与运维的消耗。

原理在于将一系列的网络功能打包成单独的动作,由于部署在最外层根本不需担心其对新功能的影响。

以阿里云为例,通过NFV平台,第三方厂商可以将其应用移到该云上,和云服务商自建网元一样获取弹性和调度能力,形成一个非常好的生态系统,丰富云上用户以及开发者的选择。

但在使用过程中针对网络功能处理性能下降、网络流量数据隐私暴露、软件攻击面扩大等问题解决起来仍很棘手。

未来,为了让NFV平台达到实际网络环境的性能需求,其性能优化仍很关键,主要包括VNF运行环境性能优化和VNF处理性能优化两个部分。

当然其中还涉及到负载均衡和状态管理、资源分配和调度策略等很多层面的创新迭代,发展的空间比较大。

VTrace汇集百万VFD日志,智能管理如此简单

或许你已经留意到,洛神云网络平台2.0中,其实还有一个智能网络分析系统。

换句话讲,超大规模的洛神云网络平台,确实在运营、持续升级、创新迭代等方面需要一个系统加以把控。

作为网络运维和运营的中枢,它管理着海量的网元以及用户,比方说千万级虚拟机和百万级网元。

例如,怎样从网络全局看实际的运营状态?

当用户业务部署在阿里云上时,如果网络发生波动或者故障,如何快速排查并发现?

为了能够做到这些,管理平台主要基于大数据以及机器学习技术,对网络中产生的海量数据进行了实时/离线计算,数据建模等工作,来驱动网络资源的提前规划,系统的日常维护以及产品的智能运营等。

以运营的核心生产资料为例,数据能够高效利用其实并不简单。

首先数据来源多样,内在还包括海量、异构以及高性能计算等诸多问题;其次数据与运营场景的结合也是个难点,例如怎样把网络维护好?怎样把网络产品管理好?怎样把网络用户服务好?

此外对于用户来说,在使用具体的网络服务时,资源优化与控制开销等细节,也需要相应的数据指标加以衡量指导,维度的复杂性可想而知。”智能运维首先要找清楚你所解决的问题和场景,因为问题和场景很重要。”

据量子位了解,其实在过去的几年中,洛神云网络平台在网络运维和异常分析上投入了很多精力,涉及综合建立多种网络故障模式以及后续快速恢复等诸多方向,为满足该领域的业务需求以及开发者指导做了不少功课。

毕竟整体的智能运维涉及到的功能技术繁多复杂,未来包括流量预测,算法与体系相融合等都会成为亟待突破的要点。

谈及不久之前“SIGCOMM 2020 公布了今年的入选论文,洛神云网络的 “VTrace: Automatic Diagnostic System for Persistent Packet Loss in Cloud-Scale Overlay Network” 作为国内历年来唯一一篇云网络方向的入选论文”的新闻,云州透露说,之所以入选,是因为用特殊的方式解决了云网络业界困扰已久的问题。

就像在现实生活中,驾车拥堵会造成预定的事情被错过;同样在云网络的世界,当某个设备出现阻塞或者事故,也一样会给使用中的APP带来卡顿甚至异常。

如今云网络拓扑日益复杂,承载的业务需求不断增多,往往要求频繁更新来满足用户的业务变化。

该过程中,哪怕物理网络在转发策略中出现任何一个小问题都可能导致用户在云网络中的数据包丢失。

而传统工具,例如 traceroute等,无法在云网络中使用;反之,人为抓包的方式又呈现效率极低,排查过程相对繁琐耗时。

基于此,无论对于用户还是云网络供应商来说,都急需一个可以在高负载、复杂拓扑的云网络下能够实现快速响应、自动化的丢包问题排查工具。

换句话说,云网络需要一个疏导交通的“信号灯”。

而 VTrace 作为一款解决云网络持续性丢包问题的自动化诊断系统,也就合理充当了这样的角色。

不但能够基于数据丢包的用户现场进行分析,还在具体部署和使用中不影响正常的网络功能,亦能够做到支持不同用户的并发使用需求等。

举个例子来说,在“如何解决多网元节点的数据采集和汇聚”的问题时,采集层面上,VTrace使用了成熟的日志服务产品(SLS),无需开发就能快捷完成日志数据采集、消费等功能。

透过强大的采集能力,将数百万的 VFD(虚拟转发设备)日志汇聚到各地域中心,便于后续的分析处理。

在解决分布式数据采集的时序问题时,VTraceApp 和 Jstorm 之间通过设计一个三次握手过程,建立了“任务-染色-转发-采集-分析”的体系,保障大量分布式数据采集的正确性和时效性,有效解决“日志分散各地、时序无法保障”的问题,这一点对于开发者成功实践以及用户体验上都会有很积极的导向。

一路走来,平台从经典网络阶段的公网带宽进入VPC阶段,再到解决如何更好管理超大规模网络的问题,将云企业网和云连接网作为当下平台的两个主要特性。

如今,通过虚拟化的技术方式更好地作用在超大的实际环境中,性能的持续优化、NFV平台的弹性能力升级,包括以部署便捷为代表的智能化延展等工作都在火热进行中。

毕竟这些都是未来洛神云网络平台发展的终极目标着眼点,为的就是让用户更多关心网络畅通,而不是具体组件的性能,化繁为简就是这个道理。

附:采访嘉宾简介

- 滴滴副总裁叶杰平离职,他是出行巨头的AI掌门人,战胜Uber中国的关键科学家2020-09-07

- 董明珠的格力空调卖不动了:上半年营收同比腰斩,24年来首次被美的反超2020-09-01

- 手机配件市场上的“隐形巨头”:80后长沙夫妻创办,IPO首日市值逼近600亿2020-08-31

- 寒武纪半年报:每天亏百万,销售力度提升营收反降11%,上市高峰市值跌去40%2020-08-30