二次元妹子五官画风都能改,周博磊团队用无监督方法控制GAN | CVPR 2021

让GAN的元素为你所控

晓查 发自 凹非寺 量子位 报道 | 公众号 QbitAI

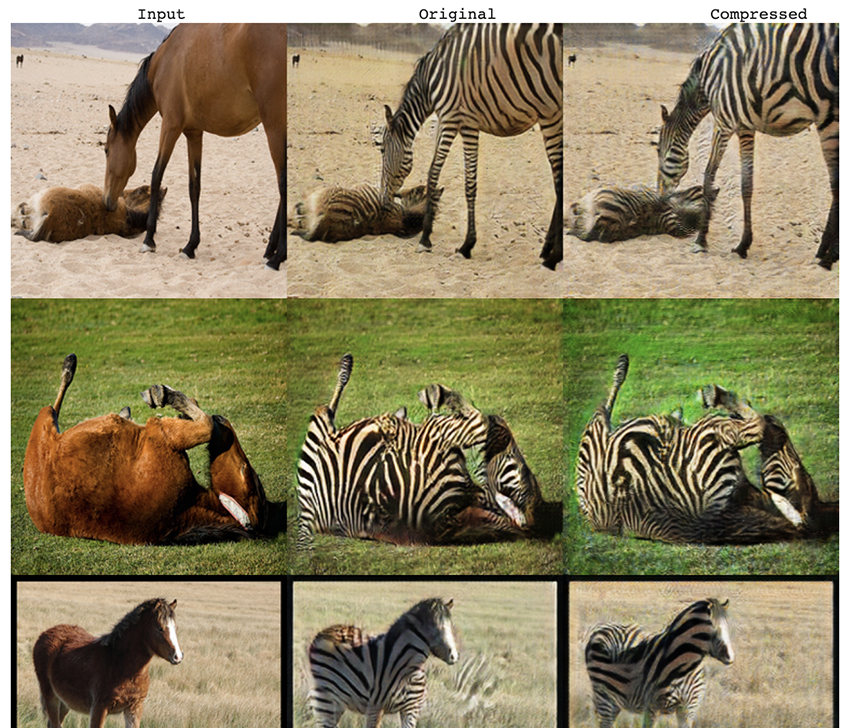

现在,GAN不仅能画出二次元妹子,还能精准调节五官、表情、姿势和绘画风格。

而且在调控某个因素的时候,其他条件能尽量保持不变。

这就是香港中文大学周博磊团队提出的SeFa(语义分解,Semantics Factorization),该论文最近入选了CVPR 2021(Oral)。

SeFa适用于PGGAN、StyleGAN、BigGAN和StyleGAN2等常见GAN模型,不仅对二次元妹子有效,甚至还能调控猫咪上下左右不同方向。

通过这种方法分离出映射矩阵的各个本征值,即可实现对不同图像元素的精准调控

更重要的是,SeFa无需对GAN生成的数据进行标注,它能自己找到这些元素变化对应的编码。也就说SeFa是一种无监督方法。

目前,SeFa相关代码已经开源。

周博磊教授团队的这一成果还得到了母校CSAIL实验室的转发。

无监督方法调节GAN

这些年,GAN在图像合成上取得了巨大的成功。如果想要更好的操控GAN,就需要正确识别其中语义。

但是,由于潜在空间的高维性以及图像语义的多样性,在潜在空间中寻找有效的语义非常具有挑战性。

现有一些基于监督学习的方法,通常首先对大量的潜在编码进行随机采样,然后合成大量图像,并使用一些预定义的标签对其进行注释,最后使用这些标记样本来学习潜在空间中的分离边界。

这种对大量GAN生成图片进行标注的方法,耗时耗力。

因此,作者没有直接利用合成样本作为中间步骤,而是直接研究了GAN的生成机制以解释其内部表示。

更具体地说,对于所有基于神经网络的GAN架构,都是将全连接层用作将输入潜在编码带入生成器的第一步。

这种变换实际上会滤除潜在空间中一些可忽略的因素,突显对于图像合成关键的因素。如果我们能够识别出这些重要的潜在方向,就可以控制图像生成过程。

SeFa对图像的操作,可以看做是将d维潜在空间中的对应向量z沿着n的方向进行移动。

而GAN还会将z映射到另一个m维空间的y。

最终,作者将这一问题转化为:

与其他方法对比

与现有的监督和无监督方法相比,SeFa方法能够更准确,更广泛地识别可解释的维度。而且该方法灵活通用,可适用于不同的GAN。

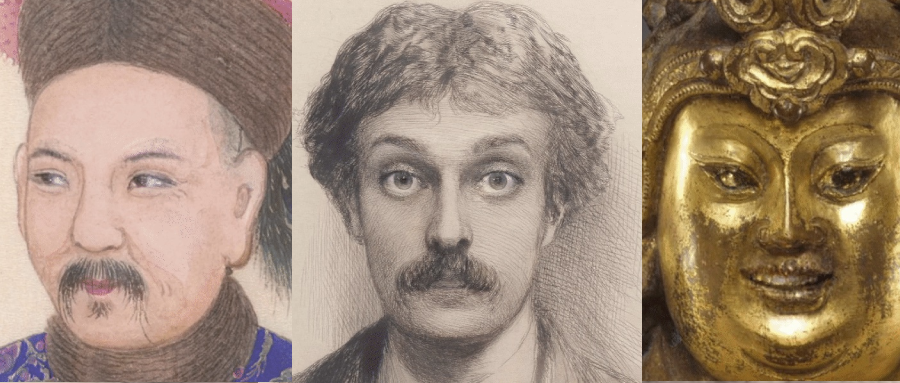

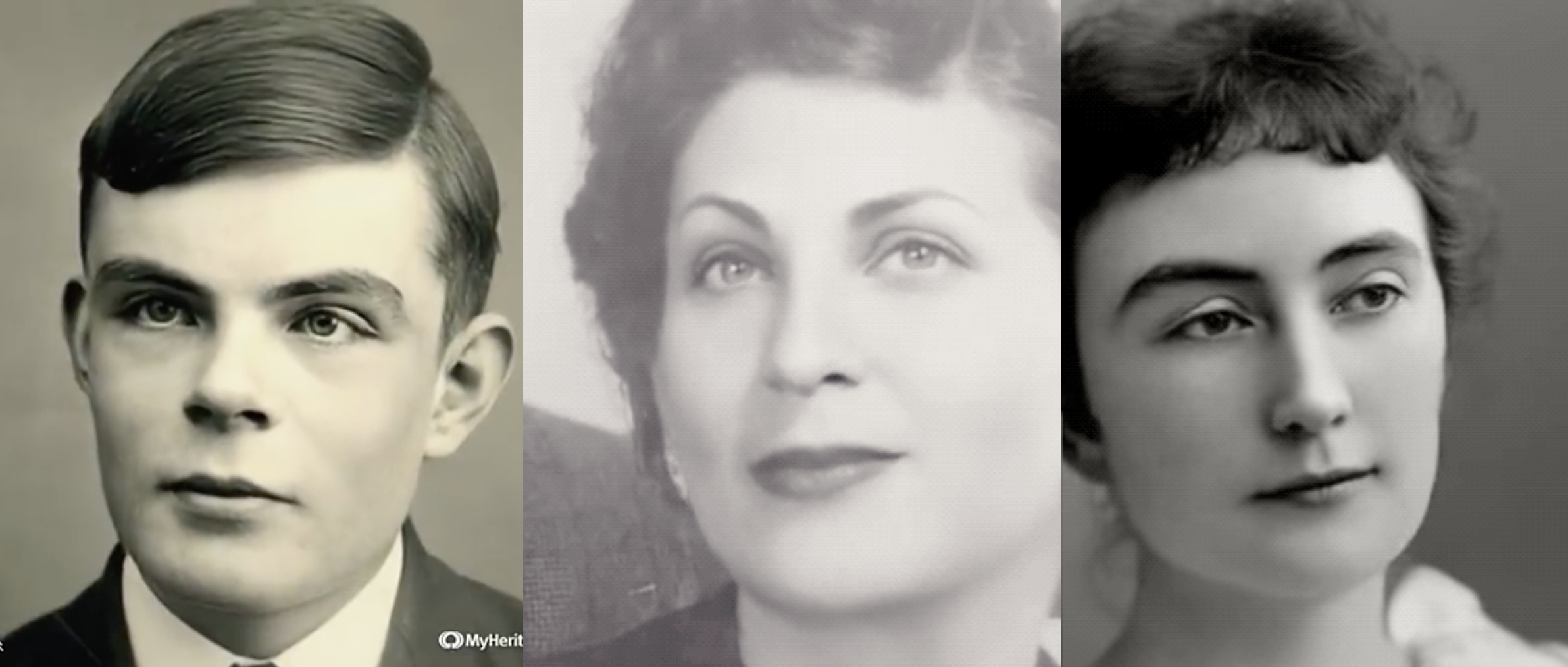

在下图中,SeFa(b)和无监督的GANSpace(a)、有监督的InterFaceGAN进行了定性对比。SeFa已经接近于有监督方法的效果。

和InfoGAN(a)对比发现,SeFa(b)对不同语义因素的分解程度更高,因为前者在变换人脸姿势时,发色发生了明显的变化。

SeFa不仅能处理GAN制造的图片,对真实照片也有效。利用之前周博磊团队提出的GAN反演方法,将真实照片反向投影到潜在空间,就能改变真实照片。

作者简介

这篇论文的第一作者是香港中文大学多媒体实验室的在读博士生Shen Yujun,本科毕业于清华大学。

他的研究方向是计算机视觉、深度学习、生成模型、网络解释、可解释人工智能(XAI)。

今年他已有3篇论文被CVPR 2021接收,其中两篇为Oral。之前他还在CVPR 2020上发表了2篇论文,在CVPR 2018上发表了1篇论文,总计发表了6篇CVPR。

论文的通讯作者是香港中文大学助理教授周博磊。

周博磊是MIT CSAIL实验室博士,他的研究涉及计算机视觉和机器学习,尤其是视觉场景理解和可解释AI系统。

论文地址: https://arxiv.org/abs/2007.06600

代码地址: https://github.com/genforce/sefa

Colab地址: https://colab.research.google.com/github/genforce/sefa/blob/master/docs/SeFa.ipynb

版权所有,未经授权不得以任何形式转载及使用,违者必究。

- 脑机接口走向现实,11张PPT看懂中国脑机接口产业现状|量子位智库2021-08-10

- 张朝阳开课手推E=mc²,李永乐现场狂做笔记2022-03-11

- 阿里数学竞赛可以报名了!奖金增加到400万元,题目面向大众公开征集2022-03-14

- 英伟达遭黑客最后通牒:今天必须开源GPU驱动,否则公布1TB机密数据2022-03-05