上交大找到「换脸」新方式:无惧死亡打光、直男视角 | 开源

现在的换脸范围已经拓宽到表情包了

博雯 发自 凹非寺

量子位 报道 | 公众号 QbitAI

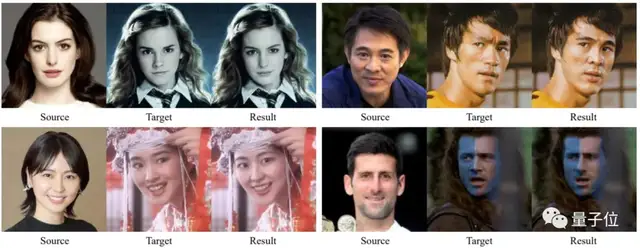

多么“平平无奇”的一个换脸视频:

DeepFakes等一众换脸神器对此纷纷表示:就这?

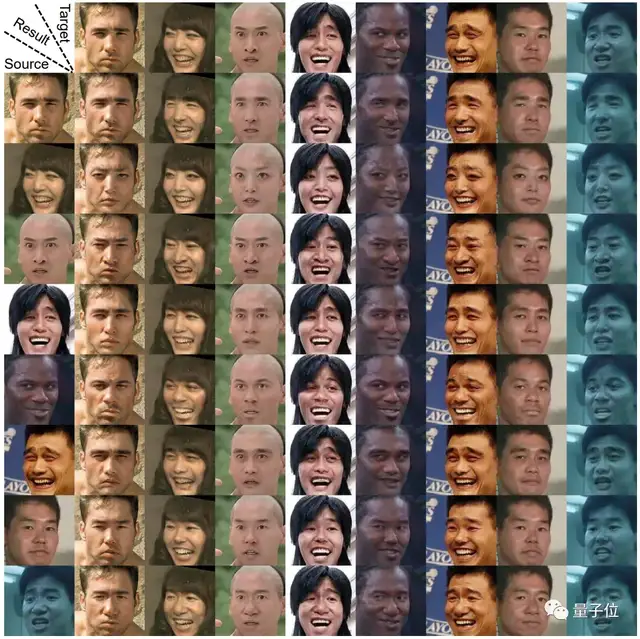

但要是从网上的电影场景中,随意抓一把人物图像丢进去呢?

如果要换的这张脸正好在死亡角度,还做了个特别夸张的表情(或者干脆就是个表情包)呢?

水就有点深了哈。

这时,由上交大和腾讯一起搞出来的换脸框架SimSwap表示:让我来,我把握得住!

任意人脸都能换

一直身居换脸界C位的DeepFakes是怎么换脸的呢?

对于同一人脸的大量图片进行分析并提取特征,然后将这种特征替换到目标图像上。

这意味着什么呢?我换一个新脸,就得训练一个新模型。

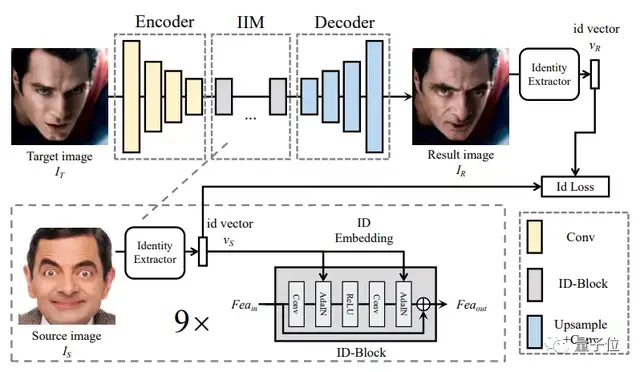

但SimSwap提出了一种ID注入模块(IIM),在特征层面将源脸的身份信息迁移到目标脸,消除了原图特征信息与解码器的权重之间的相关性。

这样,就将特定人脸互换算法的结构扩展到了任意人脸互换框架。

也就像我们在开头展示的那样,不用精挑细选“正脸”或“中性表情,直接从网上抓一把人物图片,也能够完美换脸。

这就大大节省了要反复建立新模型的时间和金钱。

死亡角度、夸张表情也不怕

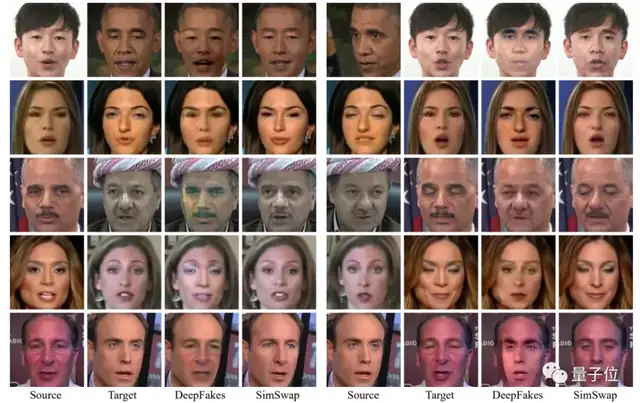

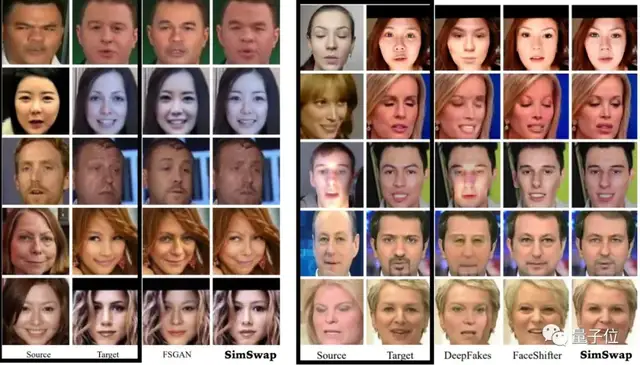

除了泛化到任意人脸变换之外,SimSwap也能更好地保存原图的脸部表情和角度。

不管是表情嘴巴嘟嘟,还是目标图和原图一侧一正两个角度,都能完美换脸。

就算是自下而上的死亡打光图(下图右边第三行),SimSwap也表现得更好。

其实,像这种目标脸属性(表情,姿势,灯光)比较复杂情况下造成的特征损失,一直是换脸面对的困难之一。

表情一夸张,或者处于极端角度和光线下时,就可能导致模糊和伪影。

这是因为在换脸任务中,常常要为了匹配原始特征而删除一些纹理信息,进而使图像的深层特征产生丢失。

此外,由于图像和它的属性在特征层面高度耦合,对于特征的直接修改也会造成图像属性性能的下降。

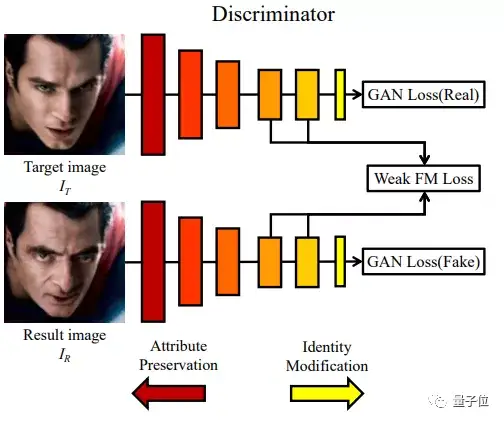

而SimSwap提出了一种弱特征匹配损失(Weak Feature Matching Loss),保证了输入目标和生成结果在高语义水平上的一致,并使判别器在最后几层计算特征匹配项。

这样,即使没有对特定属性做任何明确的约束,输入图像的属性也能被一种隐式的方式保留。

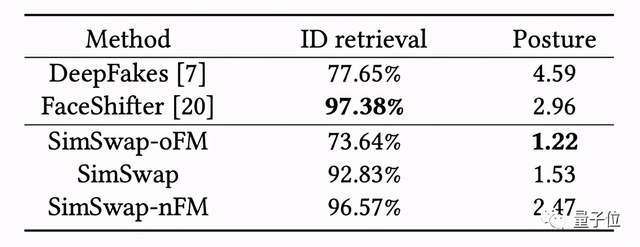

可以看到,虽然SimSwap在原特征表现上稍微落后,但涉及到脸部姿态这种复杂属性时,它的保存能力更好。

团队介绍

论文的两位共同一作都来自上海交通大学。

而通讯作者倪冰冰为新加坡国立大学博士,现任上海交通大学电子系的特别研究员和博导,主要研究方向是计算机视觉和多媒体计算。

论文地址:

https://arxiv.org/abs/2106.06340

下载地址:

https://github.com/neuralchen/SimSwap

- 有道智能学习灯发布,通过“桌面学习分析引擎”实现全球最快指尖查词2022-04-08

- 科学证明:狗勾真的懂你有多累,听到声音0.25秒后就知道你是谁,对人比对狗更亲近2022-04-14

- 华为员工泄密被判刑,马斯克遭推特股民起诉,阿里云被曝人事变动,今日更多大新闻在此2022-04-13

- 贝佐斯明抢马斯克太空生意:数十亿美元组卫星互联网,5年内发射3236颗卫星2022-04-07