ICML 2021杰出论文奖“临时更换”,上海交大校友田渊栋陆昱成等获提名

共有6篇论文获奖

萧箫 发自 凹非寺

量子位 报道 | 公众号 QbitAI

今天,ICML 2021论文奖项公布!

今年参与评选的共有1184篇论文,数量为往年最高,共有1篇论文获杰出论文奖,4篇论文获提名。

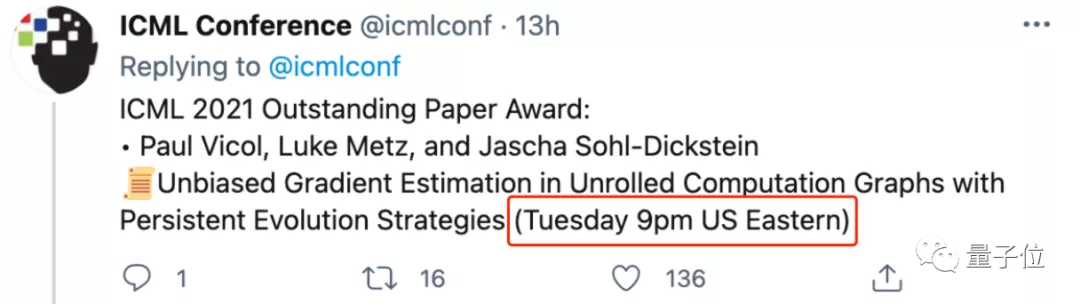

值得一提的是,今年的杰出论文奖可以说是“横空杀出”,于当天空降现场,作者来自多伦多大学、Google Brain。

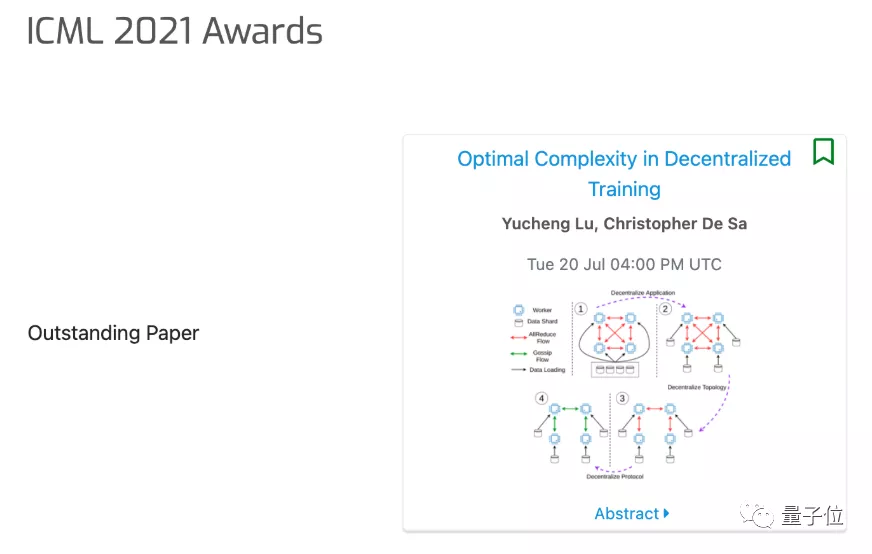

此前,在ICML 2021官网上po出的杰出论文奖,还是上交大校友、康奈尔博士生陆昱成(Yucheng Lu)一作的论文:

于当天改成了荣誉提名:

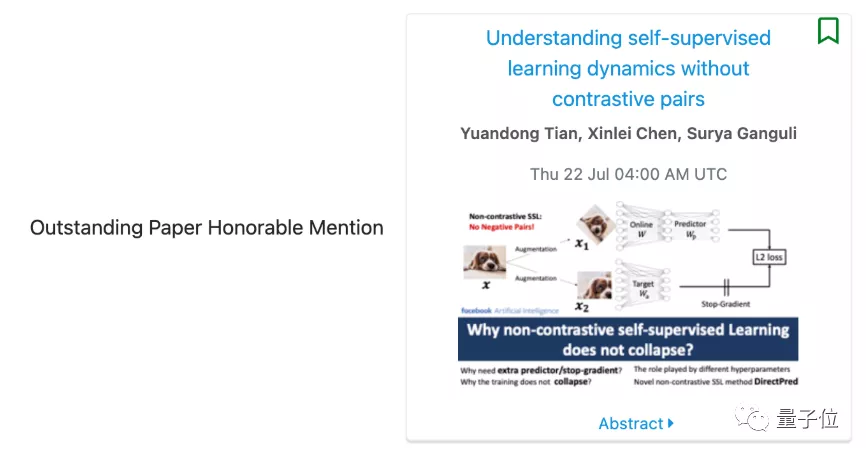

除此之外,同样来自上交大的校友、Facebook科学家田渊栋一作的论文,也获得了杰出论文奖荣誉提名。

值得一提的是,这篇论文原本只是获得Weak Accept,但经过田渊栋与评审之间经过“一番辩论”(rebuttal)后,评审最终将这篇论文改成了Accept。

今年ICML 2021的时间检验奖,则颁给了「Bayesian Learning via Stochastic Gradient Langevin Dynamics」,作者分别来自高通和牛津大学,其中一位还是Hinton的学生。

一起来看看。

杰出论文奖

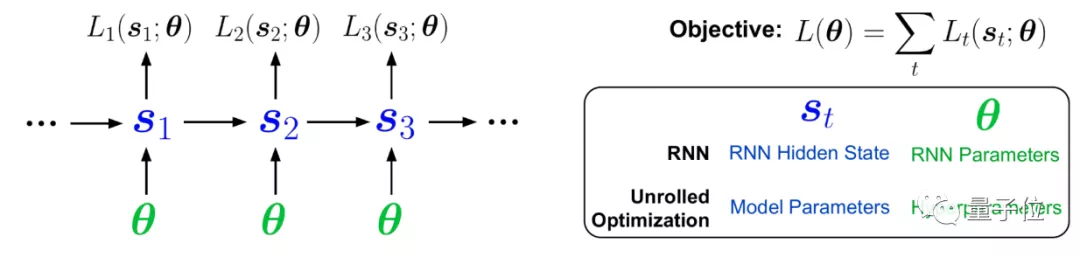

今年的杰出论文奖,题目是Unbiased Gradient Estimation in Unrolled Computation Graphs with Persistent Evolution Strategies,来自多伦多大学和Google Brain。

(作者分别为Paul Vicol, Luke Metz, Jascha Sohl-Dickstein)

△一作Paul Vicol

这篇论文指出,在一些计算图中优化参数的方法存在高方差梯度、偏差、更新缓慢或内存使用量大的问题。

作者引入了一种称为Persistent Evolution Strategies (PES) 的方法,将计算图划分为一系列截断的展开,并在每次展开后执行基于进化策略的更新步骤。PES可以让参数更新速度更快、内存使用率更低、无偏差并具有合理的方差特征。

杰出论文奖荣誉提名

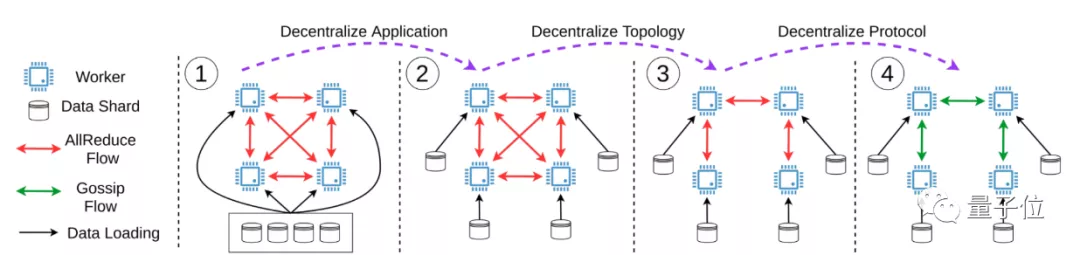

1、Optimal Complexity in Decentralized Training

来自康奈尔大学。

(作者陆昱成、Christopher De Sa)

这篇论文给出了去中心化在随机非凸环境下迭代复杂度的下界。结果表明,许多现有的分散训练算法如D-PSGD,在已知收敛速度上存在理论差距,但这个下界是可实现的。此外,论文还提出了一种名为DeTAG的算法,这是一种实用的去中心化算法,并在图像分类任务上与其他去中心化算法进行了比较。发现与Baseline相比,DeTAG在非缓冲数据和稀疏网络中具有更快的收敛速度。

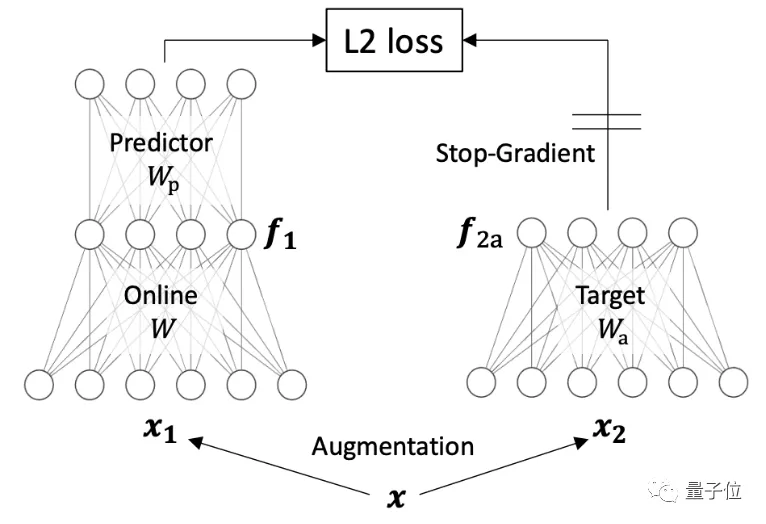

2、Understanding self-supervised learning dynamics without contrastive pairs

来自Facebook AI Research、斯坦福大学。

(作者田渊栋、Xinlei Chen、Surya Ganguli)

这篇论文提出了一种新的方法Direct Pred,无需梯度训练,可以直接根据输入的统计信息来设置线性预测。在ImageNet上,它与更复杂的BatchNorm预测器性能相似。这项研究提供了非对比SSL方法如何学习的概念性简介,以及预测网络、停止梯度、指数移动平均数和权重衰减等因素如何发挥作用。

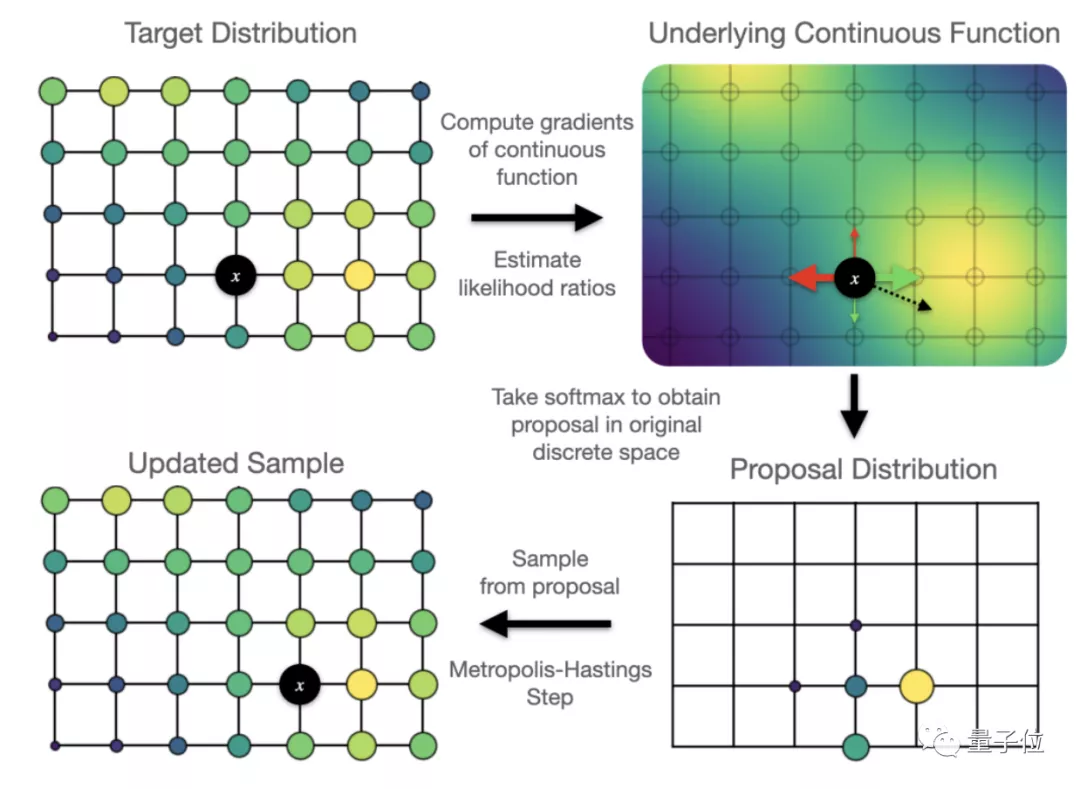

3、Oops I Took A Gradient: Scalable Sampling for Discrete Distributions

来自多伦多大学、Google Brain。

(作者Will Grathwohl, Kevin Swersky, Milad Hashemi, David Duvenaud, Chris Maddison)

这篇论文提出了一个可扩展的通用近似抽样策略,利用似然函数,对离散输入梯度进行Metropolis-Hastings采样更新。结果表明,这种策略较其他抽样方法如隐马尔科夫模型等在较复杂环境下更优。此外,这篇论文还对采样器进行了优化,用于训练基于高维离散图像数据的、基于能量的深度模型,较变分自动编码器和基于能量的模型更优。

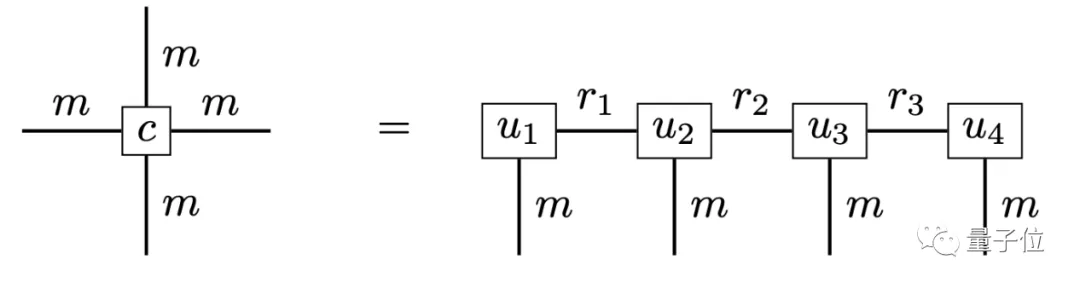

4、Solving high-dimensional parabolic PDEs using the tensor train format

来自德国柏林自由大学、波茨坦大学。

(作者Lorenz Richter 、Leon Sallandt、Nikolas Nüsken)

这篇论文认为,张量训练给抛物偏微分方程提供了一个更合理的近似框架,将随机微分方程和张量格式回归型方法结合,以利用潜在的低秩结构实现压缩和高校计算。论文提出了一种新的迭代方案,与最先进的神经网络相比,这种方法在精确度和计算效率间取得了良好的折中。

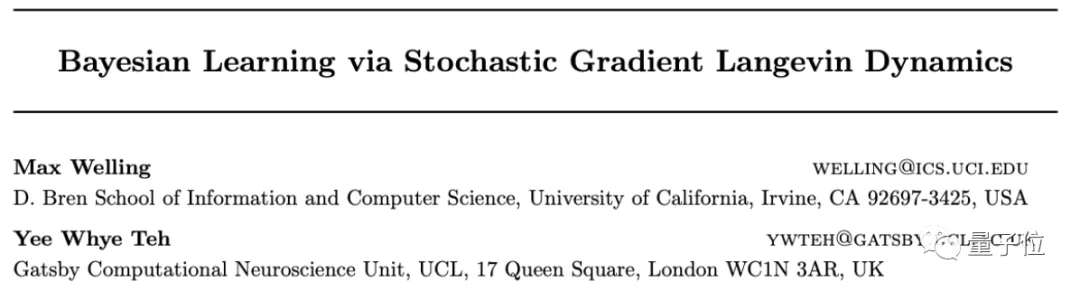

时间检验奖

今年的时间检验奖名为Bayesian Learning via Stochastic Gradient Langevin Dynamics。

作者分别是高通荷兰公司技术副总裁Max Welling、牛津大学教授Yee Whye Teh(郑宇怀),后者曾经是Hinton的学生。

论文主要介绍了一种基于大规模数据集的贝叶斯学习方法,并将之应用于高斯混合模型、逻辑回归模型和自然梯度的ICA模型。

这篇论文在Google学术上的引用量已经达到了1408次,是2011年的ICML入选论文。

ICML 2021奖项:

最佳论文奖:http://proceedings.mlr.press/v139/vicol21a/vicol21a.pdf

4篇荣誉提名:https://icml.cc/virtual/2021/awards_detail

时间检验奖:https://www.cse.iitk.ac.in/users/piyush/courses/tpmi_winter21/readings/sgld.pdf

参考链接:

[1]https://twitter.com/icmlconf/status/1417110371161317378

[2]https://www.cs.cornell.edu/~yucheng/

- 首个GPT-4驱动的人形机器人!无需编程+零样本学习,还可根据口头反馈调整行为2023-12-13

- IDC霍锦洁:AI PC将颠覆性变革PC产业2023-12-08

- AI视觉字谜爆火!梦露转180°秒变爱因斯坦,英伟达高级AI科学家:近期最酷的扩散模型2023-12-03

- 苹果大模型最大动作:开源M芯专用ML框架,能跑70亿大模型2023-12-07