ICLR要搞深度生成模型大讨论,Max Welling和AAAI百万美元大奖得主都来了,Bengio是组织者之一

MIT微软DeepMind等众多学者参与

萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

用深度生成模型搞科学发现,是不少AI大牛最近的研究新动向。

就在最新一届ICLR 2022上,包括Max Welling和Regina Barzilay等大牛,都将会参与一场关于深度生成模型的大讨论。

深度生成模型(Deep Generative Models),也就是深度神经网络结合生成模型,后者是利用计算机合成自然语言、图片等数据的模型。典型深度生成模型代表包括VAE、GAN等。

没错,这是最新ICLR 2022的Workshop,Yoshua Bengio也会作为组织者之一参与其中。

所以,这场讨论会究竟有哪些关于深度生成模型的讨论?

AI大牛们又会做什么样的最新研究分享?

一起来看看。

韦灵思和AAAI百万美元大奖得主都来了

今年的研讨会上,不少大牛都会发表与深度生成模型(DGM)相关的演讲。

如果仔细看的话就会发现,不少大牛的最新研究方向,都与DGM+自然科学发现相关。

例如著名AI大牛韦灵思(Max Welling)。

作为阿姆斯特丹大学的教授,Max Welling曾担任高通技术副总裁,在Google Scholar上的引用次数达到67000+,H指数80。

事实上,他正是著名深度生成模型变分自动编码器(VAE)的提出者之一。

就在去年,他宣布加入微软研究院(MSR),用AI的方法研究分子模拟。

在这次研讨会上,他也会做与深度生成模型在分子模拟方向上应用的主题演讲,介绍在微软的一些研究成果。

又例如来自MIT CSAIL的教授Regina Barzilay教授。

她开发了用来早期预警和防治乳腺癌、开发抗生素等药物的ML模型,并于2022年获得世界最大AI学会AAAI颁发的首届AAAI Squirrel AI奖 (官网称是“AI诺贝尔奖”),并获百万美元奖金。

Regina Barzilay曾在以色列内盖夫本古里安大学获得本科学位,随后前往哥伦比亚大学攻读计算机科学博士学位,并在康奈尔大学做了一年博士后研究。

在这次workshop上,她同样会做分子领域相关的研究报告。

此外,还有同样来自MIT CSAIL的Allen Zhong,最近就做了用深度生成模型解蛋白质结构的相关研究,这次的最新演讲,也会与此相关;

马里兰大学Pratyush Tiwary教授的研究与化学相关,这次演讲的内容则与用深度生成模型做分子动力学研究相关;

而来自DeepMind的Shakir Mohamed,最近则以通讯作者的身份,在Nature上发表了用深度生成模型做天气预测相关的论文。

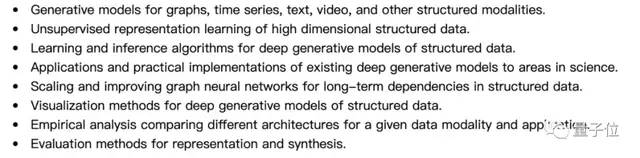

当然,除了这些主题演讲以外,这次的研讨话题也包括深度生成模型的理论和其他应用方向的探讨。

上一届有不少大牛投稿

与往年有所不同,今年Yoshua Bengio从特邀演讲嘉宾变成了组织者之一。

这次的组织者中,既有DGM+自然科学应用方向相关的,也有专注DGM自身理论研究的。

例如毕业于乔治梅森大学的杜沅岂,研究方向就与深度生成模型、蛋白质结构预测等生物方向相关;MIT助理教授Yoon Kim则更重视深度生成模型在NLP领域的应用……

在上一届ICLR 2019 Workshop上,同样有不少大牛参与投稿。

包括UC伯克利计算机教授Trevor Darrell (贾扬清曾经在团队中开发了Caffe),斯坦福教授Stefano Ermon和Michael S. Bernstein,MIT教授Antonio Torralba等,都在这次Workshop上提交了深度生成模型相关的论文。

研究方向也是五花八门,从GAN到自动编码器相关的理论研究,或是深度生成模型在各领域的应用等,都有涉及。

现在,最新一届的ICLR 2022研讨会,截至2月25日前都还可以提交论文。

对深度生成模型方向有兴趣的小伙伴们,可以戳下方地址投稿了~

投稿地址:

https://openreview.net/group?id=ICLR.cc/2022/Workshop/DGM4HSD

ICLR 2022 Workshop介绍:

https://deep-gen-struct.github.io/

参考链接:

[1]https://deep-gen-struct.github.io/iclr2019/papers.html

[2]https://en.wikipedia.org/wiki/Adji_Bousso_Dieng

[3]https://people.csail.mit.edu/zhonge/

[4]https://yuanqidu.github.io/

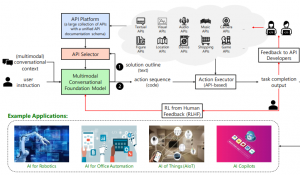

- 首个GPT-4驱动的人形机器人!无需编程+零样本学习,还可根据口头反馈调整行为2023-12-13

- IDC霍锦洁:AI PC将颠覆性变革PC产业2023-12-08

- AI视觉字谜爆火!梦露转180°秒变爱因斯坦,英伟达高级AI科学家:近期最酷的扩散模型2023-12-03

- 苹果大模型最大动作:开源M芯专用ML框架,能跑70亿大模型2023-12-07