10亿参数模型进手机!15秒即可出图,飞行模式也能用

下一步是100亿参数大模型

萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

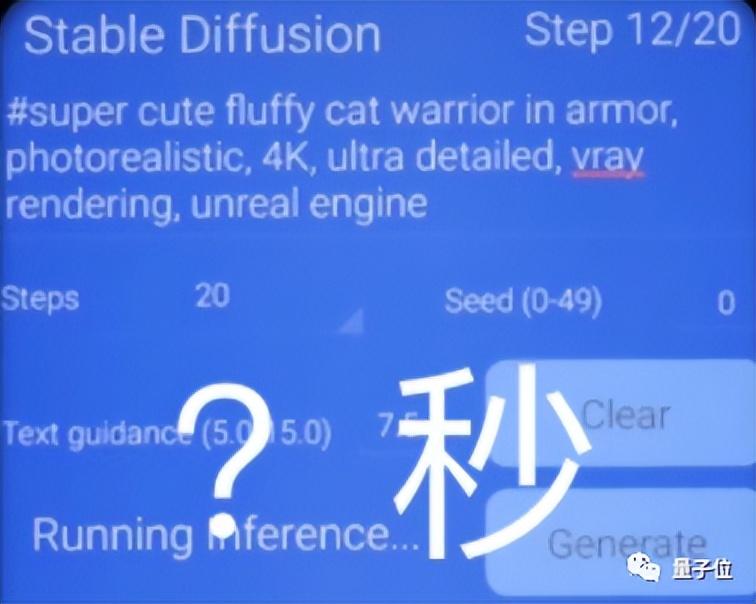

纯靠手机跑Stable Diffusion,出一张图需要多长时间?

答案是15秒以内。还是开飞行模式那种,完全不需要借助云服务器的算力!

不仅能生成动画版铠甲猫猫战士,真人版《龙珠》cosplay大合照,也能迅速想象出来:

△图源油管@TK Bay

当然,画个中国风兔型剪纸图像,也完全没问题:

△图源油管@TK Bay

此前,虽然已经有网友做出了一些能在手机上运行的Stable Diffusion项目,不过实际运行会发现,这些项目要么生成图片的时间长、内存占用高、耗电量大,要么生成的图像风格比较单一。

15秒内依靠手机算力出图,风格还是多变的那种,究竟是怎么做到的?

手机15秒跑亿级大模型

这个手机版15秒跑Stable Diffusion项目,是高通基于自己的手机芯片做的一个“演示”APP。

在前不久的MWC 2023上,高通现场展示了这个APP的生成效果,有不少线下参会的网友也体验了一波,例如尝试用它生成一群宝可梦:

△图源油管@NewGadgets.de

迭代步数达到了20步,可以生成分辨率512×512的图像。

据高通介绍,之所以相比其他项目,这个版本的Stable Diffusion能在手机上快速运行,是因为团队专门基于移动端AI软硬件技术,对开源模型进行了优化。

其中,Stable Diffusion模型选用的是在Hugging Face上开源的FP32 version1-5版本。

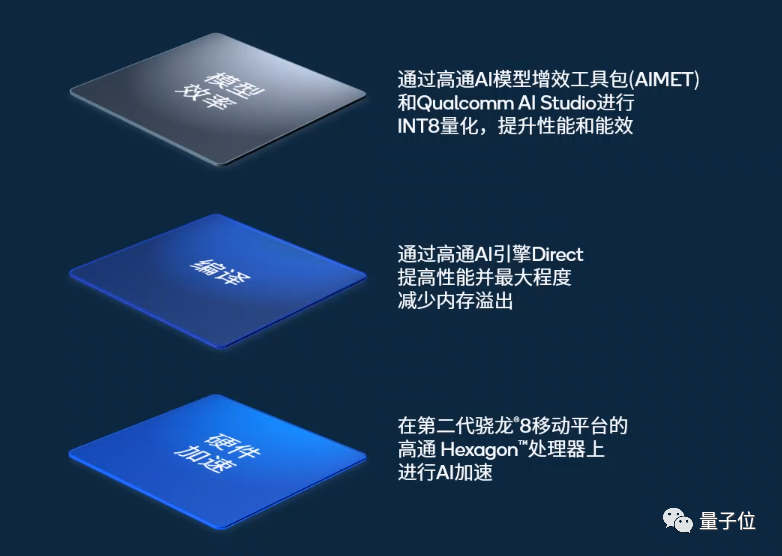

为了达到15秒“快速出图”的效果,研究人员从硬件、框架和AI压缩算法上入手,在确保出图效果的同时,对模型大小和端侧运行进行适配优化:

- 硬件:第二代骁龙8移动平台

- 框架:高通AI引擎Direct

- AI模型压缩工具:AI模型增效工具包AIMET

首先,基于高通AI模型增效工具包AIMET,对训练后的Stable Diffusion模型进行量化。AIMET中包括一些高通之前的量化研究算法如AdaRound等,能将模型精度从FP32压缩到INT8,降低功耗的同时确保模型运行效果;

接下来,团队基于高通的AI引擎Direct框架,对这一模型进行软硬件协同优化,让它能更好地运行在AI计算专用的Hexagon处理器上,提升性能的同时最小化内存溢出;

最后,高通也采用了最新发布的第二代骁龙8移动平台,支持一项名叫微切片推理(Micro Inferencing)的技术,能通过在时间轴上对网络层进行切分,从而让处理器始终处于高效运转状态,提升效率。

不止是Stable Diffusion,其他生成式AI算法同样如此。

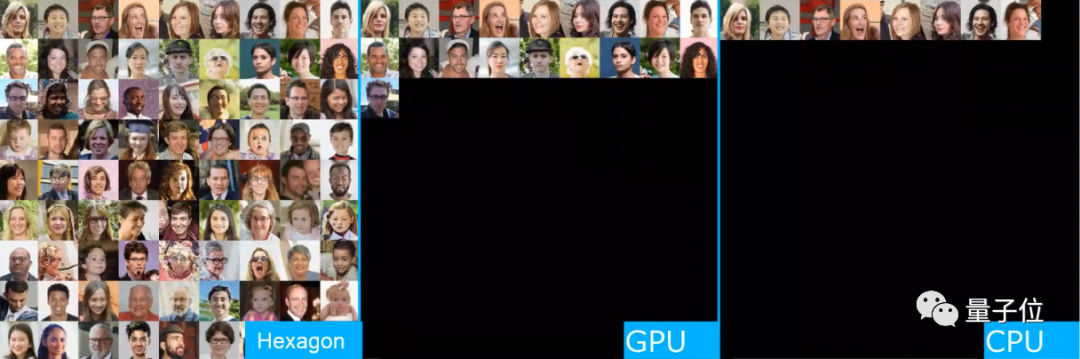

高通还展示了相比其他GPU和CPU,Hexagon处理器在移动端跑人脸生成算法的效率:

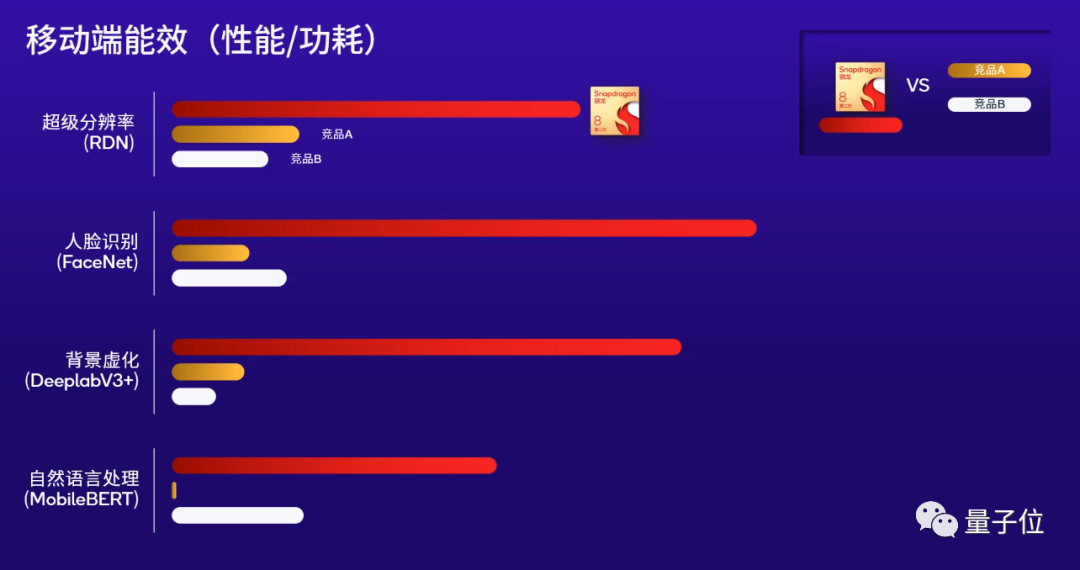

至于搭载Hexagon处理器的第二代骁龙8移动平台,跑超分辨率(RDN)、背景虚化(DeeplabV3+)、人脸识别(FaceNet)和自然语言处理(MobileBERT)等算法上,性能同样高出同行3~4倍:

而这也正是高通一直强调的“端侧AI算力”性能。

据高通介绍,在这波生成式AI浪潮下,相比单纯借助云端算力处理AI模型,端侧的计算能力也同样能被加以利用。

端侧算力加速生成式AI落地

随着这波大模型爆火,云端计算已经成为不少人受关注的技术。

然而,作为AI技术最直接的落地领域之一,同样能提供算力的移动端,是否同样会对这波生成式AI浪潮造成影响?

对此,高通技术公司产品管理高级副总裁兼AI负责人Ziad Asghar分享了他的看法。

Ziad Asghar认为,让大模型这类生成式AI纯粹在云端运行,存在几个问题。

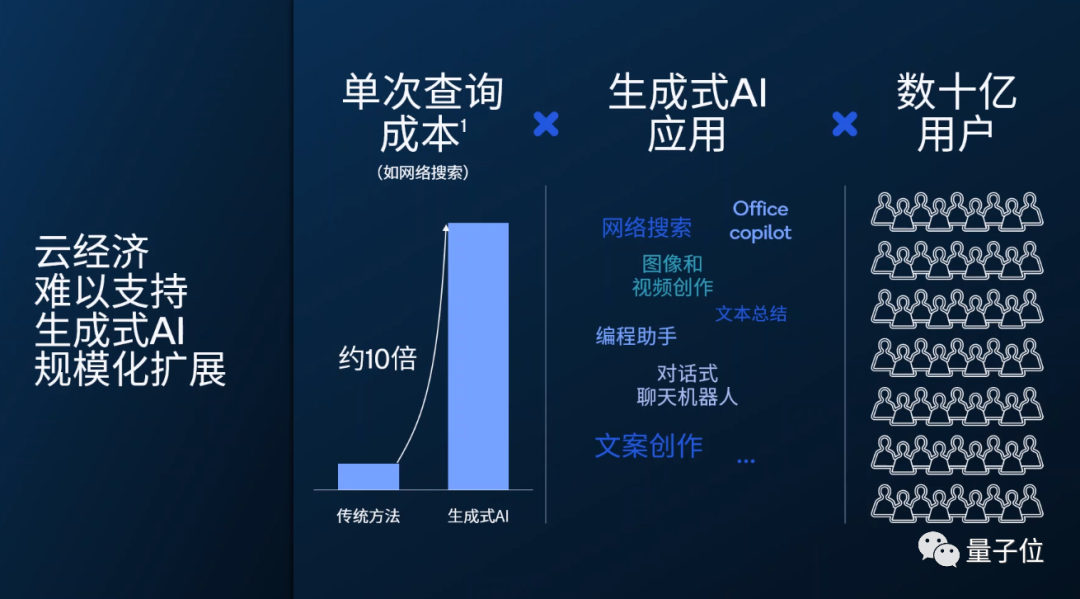

一方面,像网络搜索这样的算法,生成式AI的查询效果虽然比传统方法更好,但单次查询成本也会更高。

随着用户数量的不断增加,仅仅依靠云端算力,可能无法支持越来越多的生成式AI应用同时运行:

另一方面,虽然云端计算能力更大,但不少AI模型应用到端侧时,在推理时还会面对处理用户数据等涉及隐私安全方面的问题。

就拿个人搜索来说,要想使用AI算法更智能地搜索手机上的数据、同时又不上传到云端处理,那么模型最终就得部署到端侧,而非将用户数据“联网”上传。

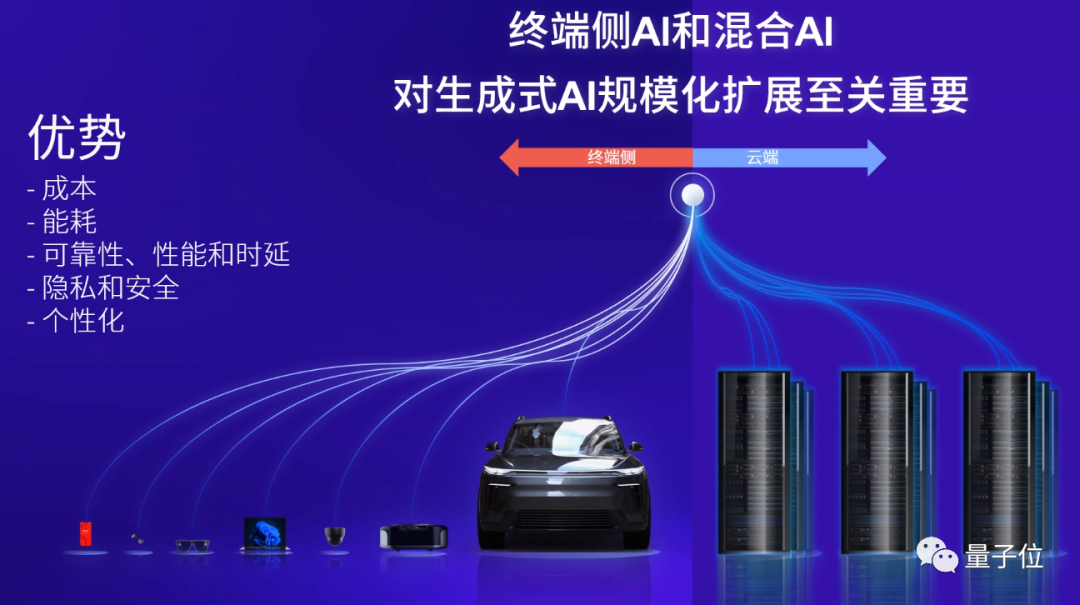

因此,要想让生成式AI规模化落地,移动端也要从计算方式和应用途径上作出对应的准备。

而这也是高通提出混合AI概念的原因,将一些AI模型放到终端侧进行处理。

Ziad Asghar还表示,随着移动端AI处理能力的不断提升,未来几个月内,我们就能看到100亿参数的大模型在移动端运行:

到那个时候,或许手机上的AI助手就真能做到“专人定制”了。

参考链接:

[1]https://mp.weixin.qq.com/s/Llqc6Elz1xY1ukN77EJFxw

[2]https://www.youtube.com/shorts/Dd8bfblL9H0

[3]https://www.youtube.com/watch?v=-pnHnlgcPfM

[4]https://www.youtube.com/watch?v=VJ_MBN2DavM

[5]https://mp.weixin.qq.com/s/J1RFNa0F1wpOvgqUxKc51w

— 完 —

- 首个GPT-4驱动的人形机器人!无需编程+零样本学习,还可根据口头反馈调整行为2023-12-13

- IDC霍锦洁:AI PC将颠覆性变革PC产业2023-12-08

- AI视觉字谜爆火!梦露转180°秒变爱因斯坦,英伟达高级AI科学家:近期最酷的扩散模型2023-12-03

- 苹果大模型最大动作:开源M芯专用ML框架,能跑70亿大模型2023-12-07