谷歌医疗大模型登Nature:准确率与人类医生「相差无几」

还推出了自创测试数据集

克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

能为患者答疑解惑的谷歌医疗大模型(Med-PaLM),它的详细测评数据终于披露了!

现在,这篇论文已经登上了Nature,来看看里面的具体细节吧。

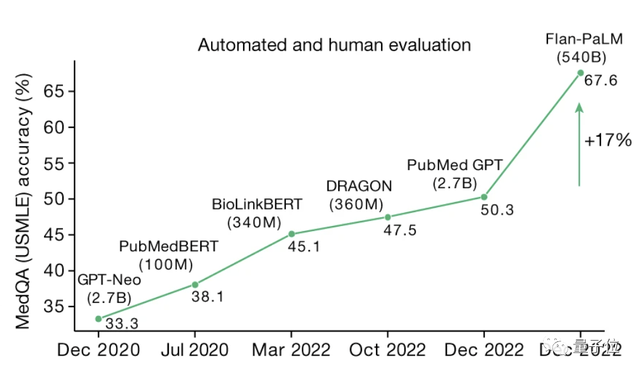

团队首先研制了Flan-PaLM,并在此基础之上,通过提示策略等方式调整得到了成品Med-PaLM。

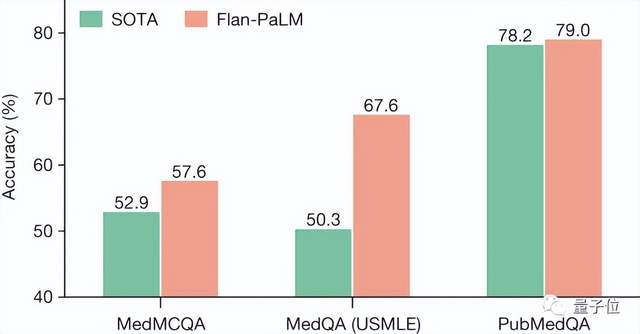

前者挑战了美国医学执照考试(USMLE),取得了67.6%的成绩,比此前最好的模型提高了17%。

Med-PaLM相比于Flan-PaLM,在实际问题上的表现有显著提升,而后者则显示出很大不足。

经过专业临床医生评判,Med-PaLM对实际问题的回答准确率与真人相差无几。

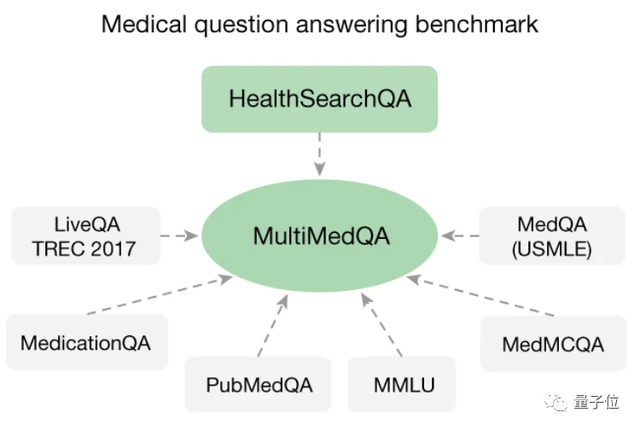

除了Med-PaLM模型,研究团队还推出了自建医疗模型测评数据集。

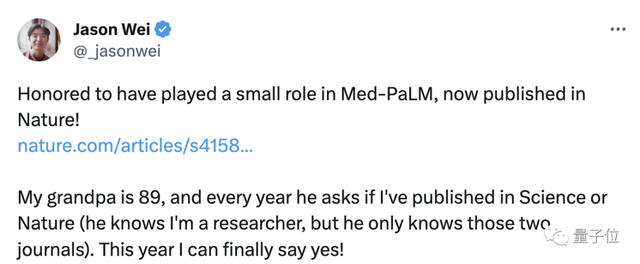

团队成员Jason Wei兴奋地在社交媒体表示,自己89岁的奶奶经常问他有没有发Science或Nature,现在终于可以回答是了。

多套测试数据共同认证

研究团队一共使用了七套测试数据集,从多个角度对Med-PaLM的表现进行了测评。

首先就是准确性。

Med-PaLM相比于其前体Flan-PaLM的主要改进不在于此,故这一步使用后者作为测试对象。

这部分一共使用了多个数据集,包括由USMLE题目构成的MedQA。

结果Flan-PaLM在其中两个数据集上的表现较此前的最佳产品均有显著提升。

而针对PubMedQA数据集,Flan-PaLM的成绩虽然只提高了0.8%,但真人在该数据集中取得的成绩也只有78%。

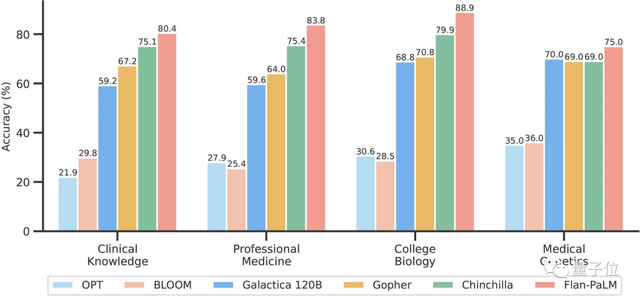

更为专业的数据集MMLU中包含来自多个临床知识、医学和生物学相关主题的多项选择题。

其中包括解剖学、临床知识、专业医学、人类遗传学、大学医学和大学生物学等方面。

结果Flan-PaLM的准确度超越了所有的已知模型。

前面的测评主要是针对模型的理论能力,接下来就要进入实战了。

这个过程中Med-PaLM本体和前体Flan-PaLM都是测试的对象。

研究团队从另外三个数据集中共选择了140个问题(HealthSearchQA中100个,另外两种各20个)。

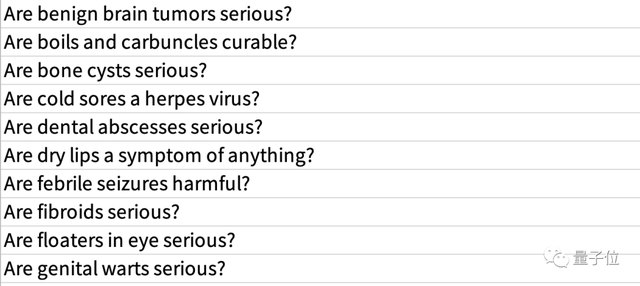

其中的HealthSearchQA是谷歌自建的,包含了3000多个问题。

这些问题既包括学术问题,也包括患者在就医时可能会向医生提出的疑问。

模型的表现则由9名来自不同国家的医生组成的专家小组进行人工评判。

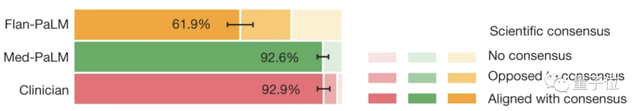

在科学共识方面,Med-PaLM的结果具有92.6%的一致性,远高于其前体,与真人医生相近。

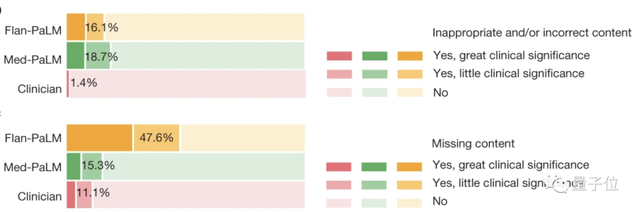

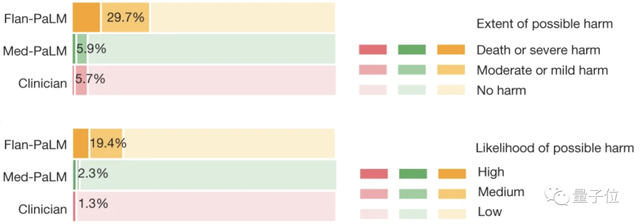

但和真人相比,Med-PaLM输出的错误或不准确信息还是比较高的,在信息缺失方面差距则小一些。

不过错误的信息不一定会真的带来伤害,经过专家评估,Med-PaLM造成伤害的可能性与严重性和人类相比并不大。

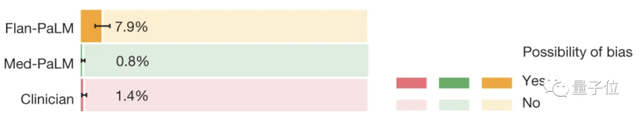

甚至出现偏见的概率比人类还要低。

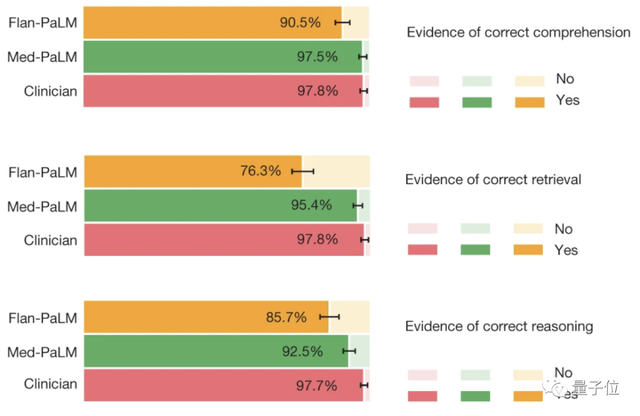

而从模型能力角度看,Med-PaLM在阅读理解、信息检索和逻辑推理能力上都表现出了接近真人的水平。

而作为一款面向不特定人群的语言模型,获得专业人士的认可是不够的,因此,研究团队还邀请了非专业人士对Med-PaLM进行评价。

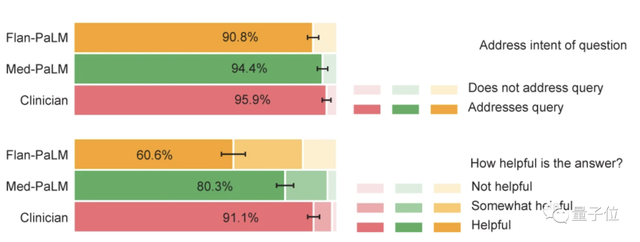

评价的标准有两条——「是不是所答所问」和「有没有帮助」。

结果在答案匹配度上,Med-PaLM和真人差了1.5%。

而对于「有没有帮助」这个问题,80.3%认为Med-PaLM是「有用」的。

这个数字和真人差距不小,但如果分别加上认为「比较有用」的人,区别就没有那么明显了。

从以上测试结果可以看出,Med-PaLM和真人之间还存在一定的差距,但已经是目前最好的医疗大模型。

论文地址:

https://www.nature.com/articles/s41586-023-06291-2

- “开源版贾维斯”一夜席卷硅谷!Mac mini因它卖爆2026-01-26

- 微软打包收购OpenAI?就差一点!2026-01-21

- MiniMax把自家“实习生”放出来了!2026-01-20

- 763亿港元,大模型公司最大规模IPO!MiniMax登陆港交所,开盘前大涨50%2026-01-09