用视觉来做Prompt!沈向洋展示IDEA研究院新模型,无需训练或微调,开箱即用

整场大会干货满满

白交 发自 凹非寺

量子位 | 公众号 QbitAI

用视觉来做Prompt,是种什么体验?

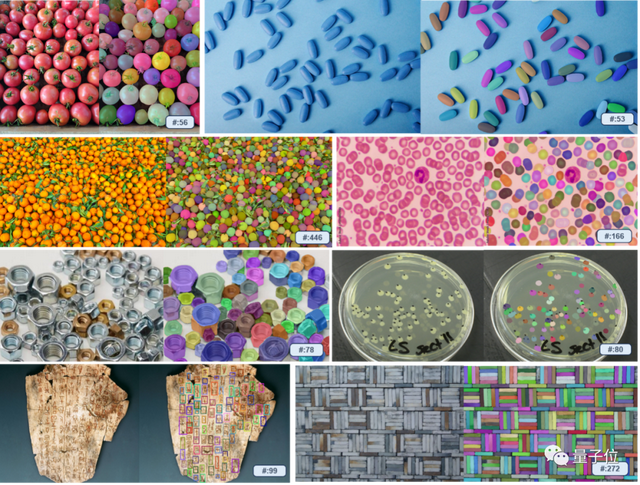

只需在图里随便框一下,结果秒秒钟圈出同一类别!

即便是那种GPT-4V都难搞定的数米粒的环节。只需要你手动拉一下框,就能找出所有米粒来。

新的目标检测范式,有了!

刚刚结束的IDEA年度大会上,IDEA研究院创院理事长、美国国家工程院外籍院士沈向洋展示了最新研究成果——

基于视觉提示(Visual Prompt)模型T-Rex。

整个流程交互,开箱即用,只需几步就可以完成。

此前,Meta开源的SAM分割一切模型,直接让CV领域迎来了GPT-3时刻,但仍是基于文本prompt的范式,在应对一些复杂、罕见场景就会比较难办。

现在以图换图的方式,就能轻松迎刃而解。

除此之外,整场大会也是干货满满,比如Think-on-Graph知识驱动大模型、开发者平台MoonBit月兔、AI科研神器ReadPaper更新2.0、SPU机密计算协处理器、可控人像视频生成平台HiveNet等等。

最后,沈向洋还分享了过去几年时间花时间最多的一个项目:低空经济。

我相信当低空经济发展到相对成熟时,同一个时间点,在深圳的天空中每天有10万架无人机,每天飞起来的有百万架无人机。

用视觉来做Prompt

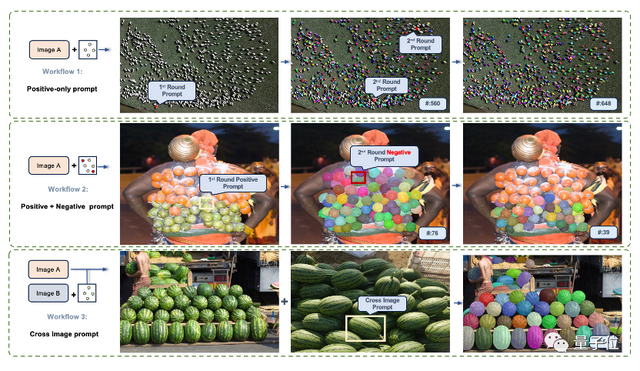

除了基础的单轮提示功能,T-Rex还支持三种进阶模式。

- 多轮正例模式

有点像多轮对话,以得出更为精确的结果,不至于出现漏检的情况。

- 正例+负例模式

适用于视觉提示带有二义性造成误检的场景。

* 跨图模式。

用单张参考图提示,来检测其他的图。

据介绍,T-Rex不会受到预定义类别限制,能够利用视觉示例指定检测目标,这样一来就克服有些物体难以用文字充分表达的问题,以提高提示效率。尤其像一些工业场景中的复杂组件等。

除此之外,通过与用户交互的方式,也可以随时快速地评估检测结果,并进行纠错等。

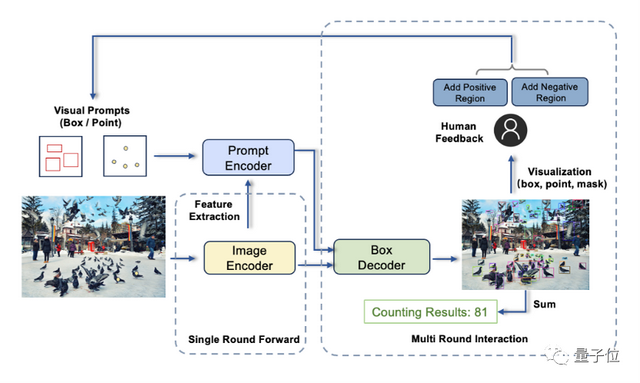

T-Rex主要由三个组件组成:图像编码器、提示编码器以及框解码器。

这项工作来自IDEA研究院计算机视觉与机器人研究中心。

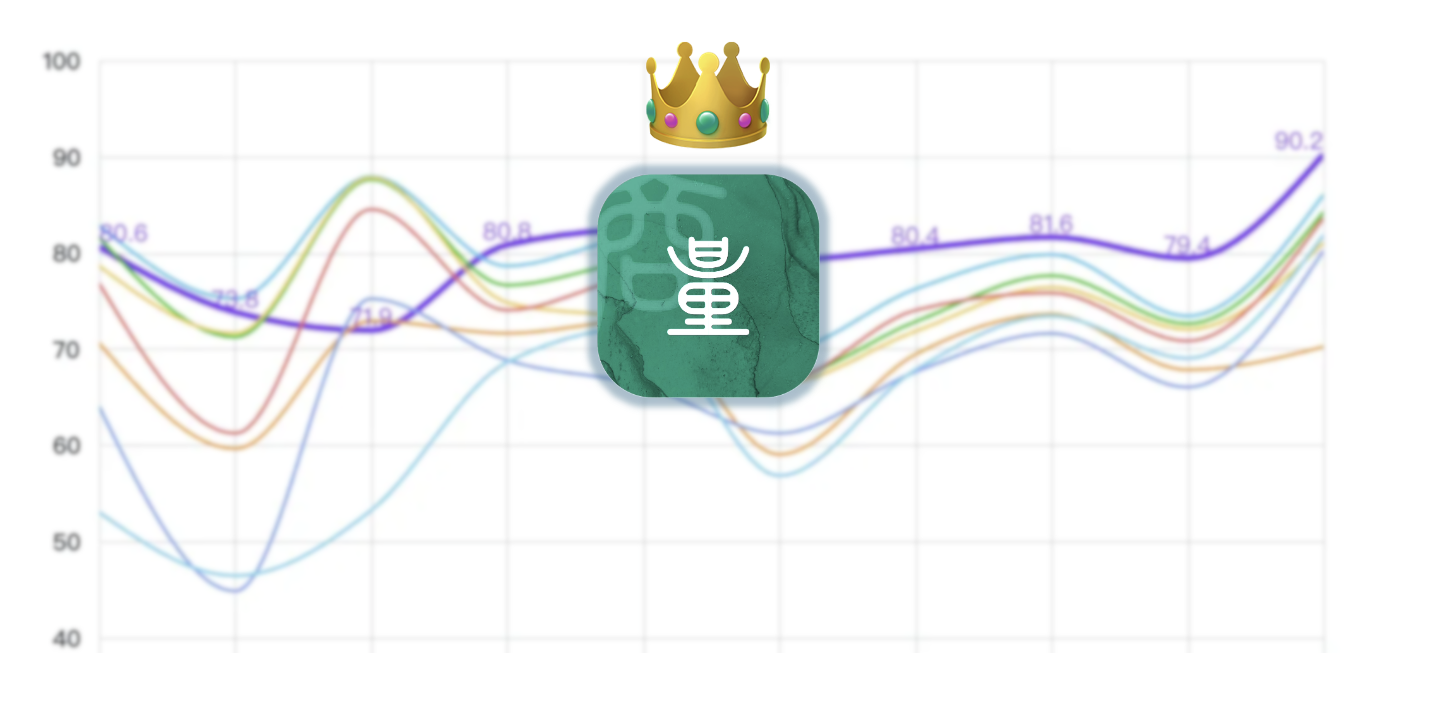

该团队此前开源的目标检测模型DINO是首个在COCO目标检测上取得榜单第一的DETR类模型;在Github上大火(至今狂揽11K星)的零样本检测器Grounding DINO与能够检测、分割一切的Grounded SAM。更多技术细节可戳文末链接。

整场大会干货满满

除此之外,IDEA大会上还重点分享了几个研究成果。

比如Think-on-Graph知识驱动大模型,简单来说就是将大模型与知识图谱结合。

大模型擅长意图理解和自主学习,而知识图谱因其结构化的知识存储方式,更擅长逻辑链条推理。

Think-on-Graph通过驱动大模型agent在知识图谱上“思考”,逐步搜索推理出最优答案(在知识图谱的关联实体上一步一步搜索推理)。每一步推理中,大模型都亲自参与,与知识图谱相互取长补短。

MoonBit月兔,这是由Wasm驱动,专为云计算与边缘计算设计的开发者平台。

它不仅提供通用程序语言设计,还整合了编译器、构建系统、集成开发环境(IDE)、部署工具等版块,来提升开发体验与效率。

此前发布的科研神器ReadPaper也更新至2.0,发布会现场演示了阅读copilot、润色copilot等新功能。

发布会最后,沈向洋发布《低空经济发展白皮书——深圳方案》,在其智能融合低空系统(Smart Integrated Lower Airspace System,SILAS)中,提出时空进程(Temporal Spatial Process)新概念。

T-Rex链接:

https://trex-counting.github.io/

- 这么哇塞的世界模型,竟然是开源的!2026-01-29

- 机器人看不清,蚂蚁给治好了2026-01-27

- 蚂蚁具身智能明牌了:做大脑,和宇树们错位竞争2026-01-28

- 曦望发布推理GPU S3:All-in推理的国产GPU,开始算单位Token成本2026-01-27