英伟达新显卡发布!笔记本AI画图提速14倍,轻薄本也能当AI工作站

AI PC门槛被打下去了~

金磊 西风 发自 凹非寺

量子位 | 公众号 QbitAI

黄院士的新核弹,来了!

全新消费级显卡,专为提速笔记本大模型应用而生。

就在这两天的MWC上,英伟达重磅推出了全新GPU——RTX 500和RTX 1000。

有多快?

根据官方的说法:

比起只使用CPU,全新RTX 500可以为Stable Diffusion等模型提供高达14倍的生成式AI性能!

不仅如此,搭载RTX 500后,用AI进行照片编辑的速度也将提高3倍,3D渲染图形的性能更是提高了10倍。

更重要的是,RTX 500和RTX 1000是用于轻薄笔记本电脑,属于英伟达Ada Generation系列的工作站显卡。

即便在性能上有了如此提升,英伟达还是将二者定位在了“入门级”,主打的就是让普通笔记本也有彪悍的AI能力。

总而言之,英伟达的此举就是要让:

- AIGC生产力,Up Up Up。

- AI PC门槛,Down Down Down。

据悉,全新RTX 500和1000 GPU将在今年春天上市,合作的笔记本电脑厂商包括戴尔、惠普和联想等。

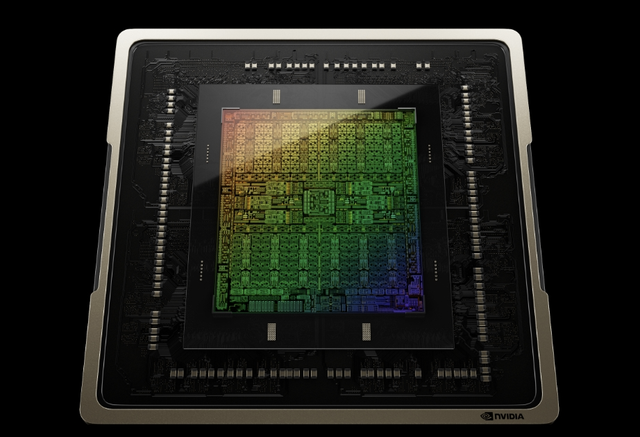

全新GPU长啥样?

全新RTX 500、RTX 1000基于英伟达第三代的RTX架构——Ada Lovelace,主打一个适合轻薄笔记本电脑处理AI任务。

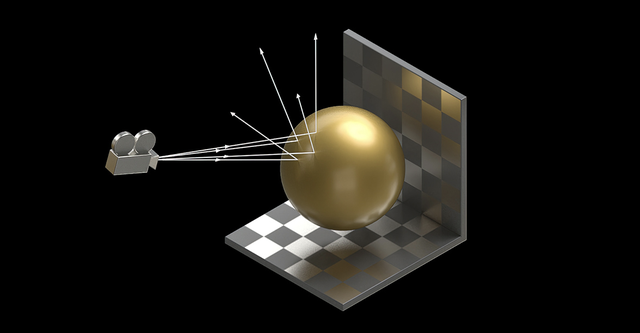

具体来说,采用第三代RT Core,配备全新Opacity Micromap(OMM)引擎和Displaced Micro-Mesh(DMM)引擎。

OMM引擎能够显著加快alpha测试纹理的光线追踪,RTX 500、RTX 1000光线追踪性能相比上一代提升2倍,可用于高保真逼真渲染。

DMM引擎能够将边界体积层次结构(BVH)的构建时间提高至10倍,同时BVH存储空间只有此前的二十分之一。

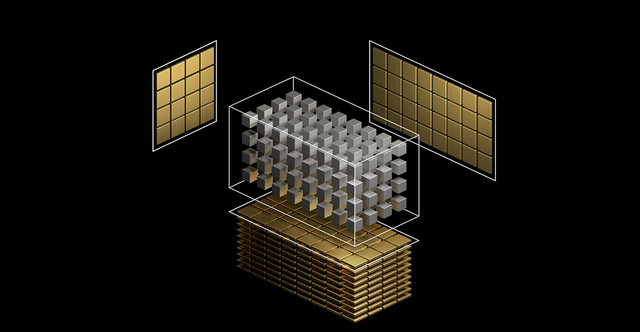

采用第四代Tensor Core,吞吐量是上一代的2倍,加速了深度学习训练、推理和基于AI工作负载。

RTX 500、RTX1000还搭载了最新Ada Generation CUDA内核,单精度浮点(FP32)吞吐量比上一代提高了30%,显著增强了图形处理和计算工作的性能。

此外,RTX 500 GPU配备4GB GPU专用内存、RTX 1000 GPU配备6GB GPU专用内存,支持用户运行3D和AI应用程序,及处理更大的项目、数据集和多应用程序工作流。

RTX 500、RTX1000配备的DLSS技术也已进化到了第三代——DLSS 3,除具代表性的超分辨率技术,还支持使用AI生成额外的高质量画面帧。

同时基于Ada架构,RTX 500、RTX1000采用了AV1编码的全新第八代 NVIDIA编码器(NVENC),比H.264效率高40%,允许在相同比特率和画质下,将1080p的流媒体分辨率提升至1440p。

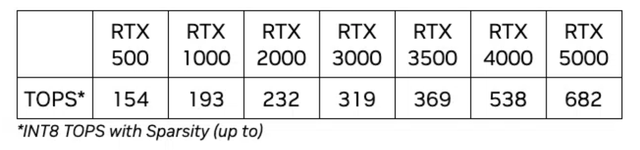

值得一提的是,RTX 500、RTX 1000被定位为移动工作站,并非为游戏而设计,内置NPU的RTX 500和1000 GPU芯片可提供154、193TOPS的AI性能。

如果用户需要构建性能更强大的工作站,比如用AI构建高级渲染、数据科学和深度学习工作,英伟达Ada Lovelace架构产品线还有2000~5000可选。

AIGC时代,芯片厂商也卷卷卷

自打ChatGPT引爆AIGC以来,不仅是上层应用的谷歌、OpenAI、微软等玩家一直处于“你追我赶”的状态,底层算力的各大玩家同样也是卷到不行。

尤其是从去年年底到现在持续升温的AI PC概念,使得PC产业迎来40年来最重大的变革。

由此,各大PC芯片厂商已然是一副磨刀霍霍准备大拼一把的状态。

早在去年年初,AMD发布了Ryzen 7040系列处理器,这是首次在x86处理器中集成独立的AI NPU,同时提出的Ryzen AI引擎技术,也可以提供更好的AI运算能力。

再如去年的9月份,老牌芯片巨头英特尔就预览了酷睿Ultra,史无前例地将NPU AI独立引擎集成了进来,意在让AI与PC结合,让消费者可以创造更大的生产力。

而继英特尔之后,高通在去年10月份也宣布了进入PC桌面处理器计划,并发布了首款集成了神经网络处理单元的X Elite处理器。

根据当时高通给出的说法,其性能可以支撑在本地运行130亿参数的大语言模型。

至于英伟达这边,除了此次发布的RTX 500和RTX 1000之外,在今年年初也曾发布过GeForce RTX 40 SUPER系列桌面端GPU,同样也是用于AI PC中,提供高性能的生成式AI功能。

值得一提的是,在这次最新的发布中,英伟达火药味十足地提及了“比起只使用CPU”,也是有点意思了。

由此可见,AI PC成为了各大芯片厂商在消费级芯片上的新战场。

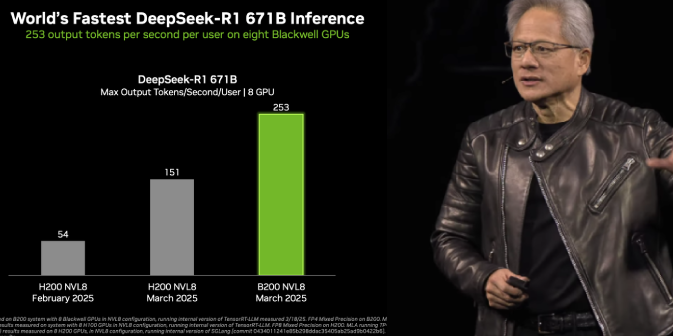

除此之外,在另一个维度上,推理(云端或数据中心),亦成为了各大芯片巨头们和新秀们抢占AIGC算力市场的新高地。

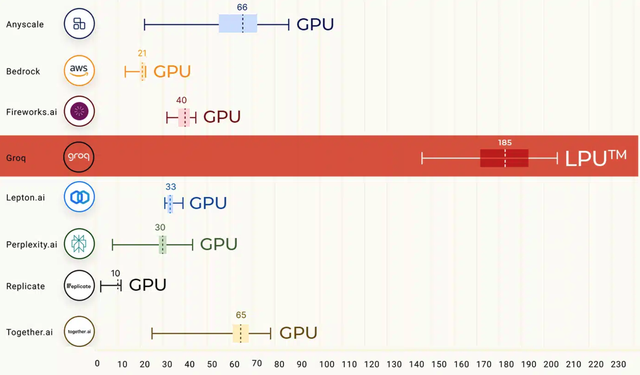

例如谷歌TPU原班人马创建的初创公司Groq,基于自研芯片推出的推理加速方案(LPU),就在前不久让“最快推理芯片”一夜易主。

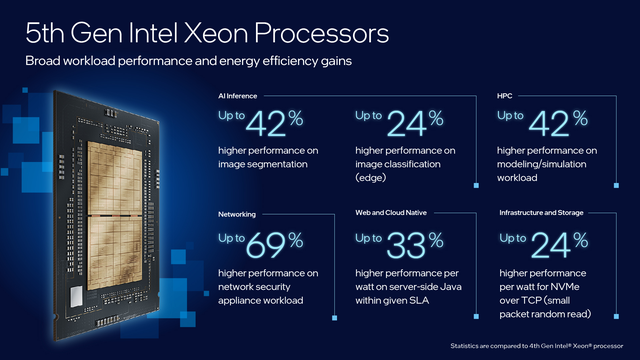

包括英特尔在去年年底发布的第五代至强系列,同样也是在数据中心侧发力用CPU跑AI。

据了解,国内各大云计算厂商也已经搭载了最新一代的至强,无论是医疗、电商或是短视频场景中,都将性能拉到了一个新高度。

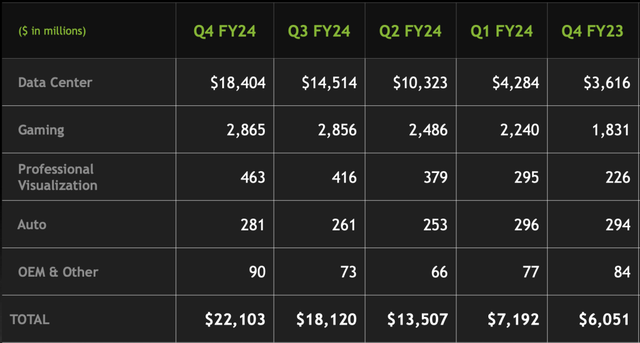

而这一趋势,从英伟达最新的财报中也能窥见一番。

根据英伟达公布2024财年第四季度财报显示,上季度180亿美元数据中心收入,大模型的推理场景已经占据英伟达数据中心40%的营收比例!

不得不说,芯片厂商们也在AIGC这波浪潮中也是有够卷的了。

One More Thing

就在这两天,一张英伟达和英特尔市值从2014年至今的十年变化图在网上疯传。

在英伟达最新一波股价大涨的分析上,这张图中的解释是:

ChatGPT的火爆推动了英伟达市值,因其对GPU的需求增加;加之英伟达在AI和机器学习上的领先地位,激发了投资者的信心。

那么站在AIGC时代的当下,芯片厂商们接下来还将有怎样的大动作,是值得期待一波了。

参考链接:

[1]https://blogs.nvidia.com/blog/rtx-ada-ai-workflows/

[2]https://venturebeat.com/ai/nvidia-launches-rtx-500-and-1000-ada-generation-laptop-gpus-for-ai-on-the-go/

- Moltbot作者被Claude刁难后:MiniMax M2.1是最优秀的开源模型2026-01-29

- 爆火Clawdbot被Claude公司强制要求改名2026-01-28

- 3D版Nano Banana来了!AI修模成为现实,3D生成进入可编辑时代2026-01-27

- 成立两年半登顶全球AI创作社区,背后是中国团队在“卖情绪”??2026-01-22