不依赖token,字节级模型来了!直接处理二进制数据

预测下一个byte

数字游民 投稿

量子位 | 公众号 QbitAI

最新GPT,不预测token了。

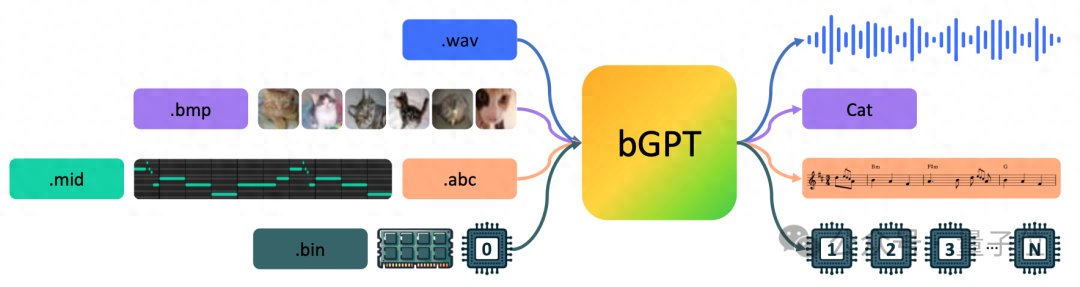

微软亚研院等发布bGPT,仍旧基于Transformer,但是模型预测的是下一个字节(byte)。

通过直接处理原生二进制数据,bGPT将所有输入内容都视为字节序列,从而可以不受限于任何特定的格式或任务。

能预测CPU行为,准确率超过99.99%;还能直接模拟MIDI——一种音乐传输和存储的标准格式。

研究团队认为,传统的深度学习往往忽视了字节——数字世界的构建基石。

不论是信息的形式还是操作,都是通过二进制格式编码和处理的。字节构成了所有数据、设备和软件的基础,从计算机处理器到我们日常使用的电子产品中的操作系统。

这篇论文的标题清晰地指出了其目标:

超越语言模型:将字节模型作为数字世界的模拟器。

模拟CPU行为准确率超99.99%

bGPT通过字节级处理,不仅能够应用于常规的AI生成和理解任务,还能处理更多非传统应用。

例如,它能够直接模拟MIDI——一种音乐传输和存储的标准格式,之前的研究由于MIDI的二进制本质而避免了直接对这类数据的建模。

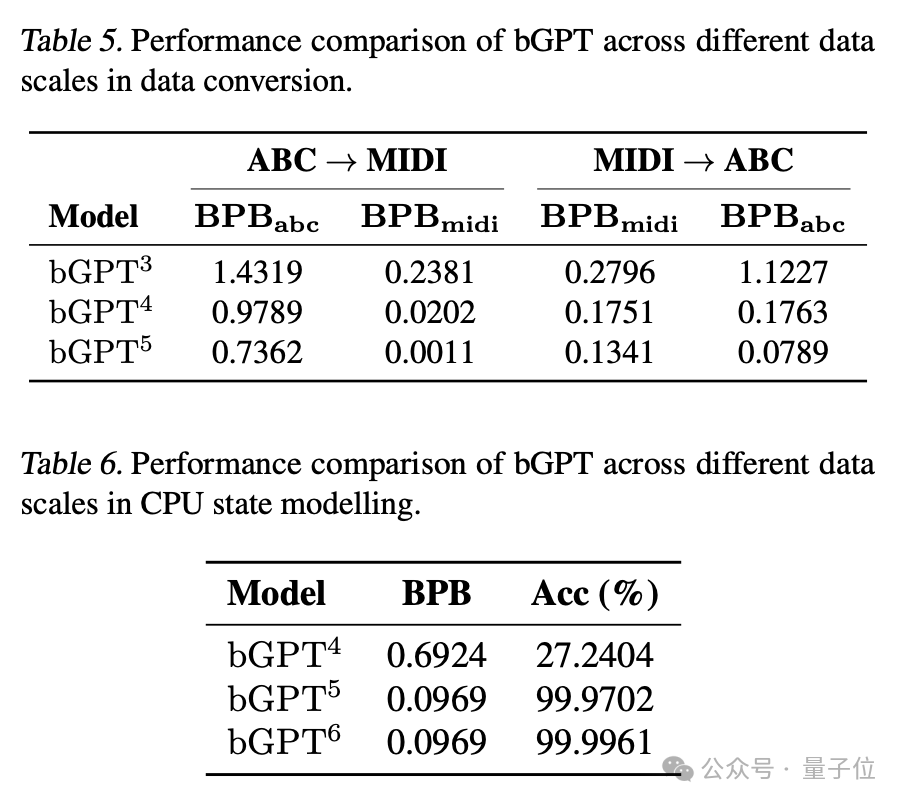

但bGPT天生适合此类任务。它能够准确模拟符号音乐数据转换算法,在将ABC记谱法转换为MIDI格式时,达到极低的错误率(0.0011 BPB)。

在模拟CPU行为方面,bGPT展现出超过99.99%的准确率。这些实验显示了bGPT在处理原生二进制数据方面的强大能力和可扩展性。

bGPT还展示了在处理诸如文本、图像和音频传统媒体文件的生成/分类任务上的潜力,而且不需要任何针对特定模态的定制。

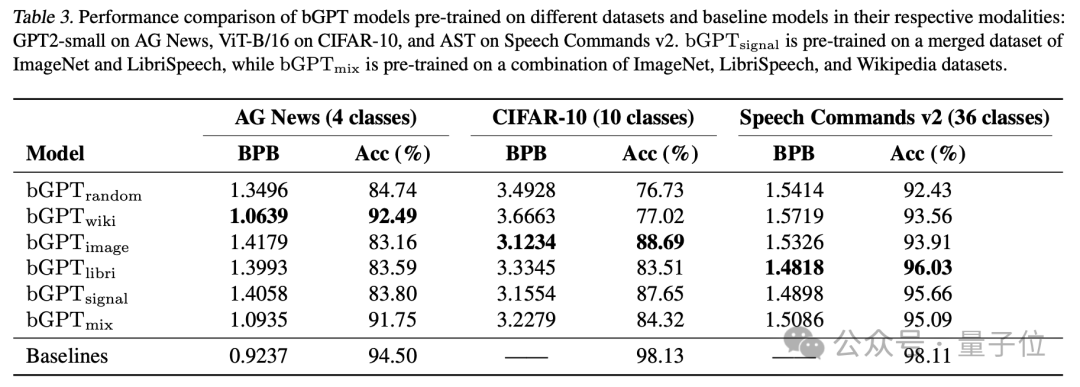

研究团队训练了一个大约有100M参数的bGPT,根据论文中的实验结果,bGPT可以与同样规模的文本模型(GPT-2)、视觉模型(ViT)和音频模型(AST)在各自的模态下有着可比的性能。

字节到块策略:拓展序列建模长度

在处理数字数据时,bGPT代表了一次重要的进步。

因为字节的粒度非常细,处理的字节序列通常较长,这对基于Transformer的传统模型来说是一个挑战。由于自注意机制的复杂度是二次方的,处理长序列的效率和可扩展性受到了限制。

bGPT的研发团队此前在音乐AI领域推出了CLaMP项目,并因此在ISMIR 2023上获得了最佳学生论文奖。

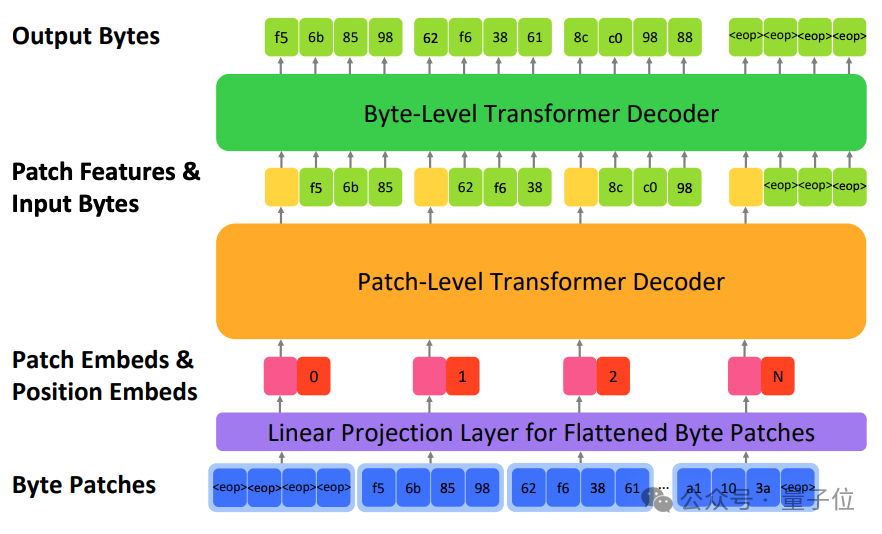

基于这项成果,bGPT采取了一种“字节到块(patch)”的转化方法。这个方法不仅极大提升了数据处理效率,还让长序列数据的处理和扩展变得更加简便。

bGPT包含三个关键组成部分:

- 线性投影层:通过线性投影将每个字节块转化为密集向量表示,既保留了关键信息,又降低了维度。

- 块级解码器:顺序处理块的embeddings以预测下一个块的特征,使用自回归机制学习字节序列的整体结构。

- 字节级解码器:根据块级解码器的预测特征来预测每个块内的字节序列,这一过程独立于每个块进行,依据当前块的特征表示。

bGPT提供了一种有前景的解决方案来应对传统模型在处理字节级数据时面临的挑战,显著提高了处理大规模数字数据序列的效率和可扩展性。

拓宽边界:bGPT与未来数字世界的无限潜力

尽管bGPT展现出巨大的潜力,但其也存在一定的局限性和改进空间。

目前,bGPT只能处理不超过8KB的数据序列,对于需要生成大量数据的现代应用来说,这一容量显然不够。这一局限主要由于训练和部署这类模型需要巨大的计算资源需求。

为了推进bGPT的实用性和适用范围,未来的研究将专注于开发更高效的算法和利用硬件进步以降低计算成本,使bGPT能够更加经济高效地处理更大规模的数据序列,从而拓宽其应用前景。

在探讨字节模型未来的话题中,来自世界各地的网友们已经提出了一系列脑洞。

他们探讨了在裸机上运行纯粹的神经网络,以取代操作系统执行命令的前景,或者利用网络修剪和自我学习来优化连接,使得超大规模网络具备自我重构的能力。

虽然实现这些目标需要时间,但bGPT有望实现将所有数据以字节形式输入,通过超大规模自我重构网络处理后再以字节形式输出的终极目标。

或许,在探索bGPT能力的边界时,想象力才是唯一的限制。

长期来看,bGPT展示的字节模型在推动人工智能进步方面展现了两大巨大潜能。

首先,它有望实现一个统一模型,将计算机中的所有数据整合起来,为实现真正的通用人工智能(AGI)迈出关键一步。

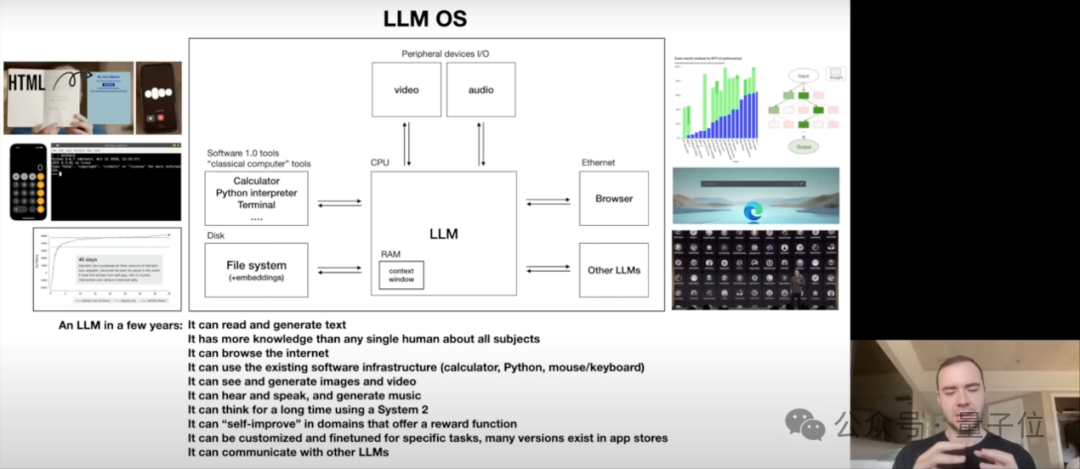

其次,bGPT推动了将AI作为操作系统(LLM OS)的概念,即利用这种字节模型作为核心,直接与文件、软件及底层硬件数据进行深度交互。

这不仅与Andrej Karpathy的AI愿景不谋而合,更重要的是,它开启了使用AI模拟数字世界各种层面的可能性——从精确模拟CPU操作到系统级软件的行为模拟,bGPT的能力远超传统界限。通过这种方式,bGPT有望成为数字世界的全面模拟器,探索和理解从基础硬件到复杂系统级软件操作的每一个角落。

单凭对计算机文本数据的深入建模,我们已经见证了ChatGPT如何引发社会的广泛关注。

然而,文本数据在数字世界中海量数据的宏观图景里,不过只是冰山一角而已。想象一下,如果我们能够利用计算机中存储的所有形式的数据——无论是文本、图像、音频,还包括更复杂的二进制数据,乃至软件、操作系统和硬件本身的信息——来训练模型,能否创造出一个更加深入理解和精确模拟数字世界各个层面的模型?

bGPT的代码和模型已开源,如果你对探索字节级模型感兴趣,可以尝试在自己的数据集上使用bGPT进行训练,大胆探索它的潜能。

论文:https://arxiv.org/abs/2402.19155

代码:https://github.com/sanderwood/bgpt

模型:https://huggingface.co/sander-wood/bgpt

项目主页:https://byte-gpt.github.io

- DeepSeek-V3.2-Exp第一时间上线华为云2025-09-29

- 你的AI助手更万能了!天禧合作字节扣子,解锁无限新功能2025-09-26

- 你的最快安卓芯片发布了!全面为Agent铺路2025-09-26

- 任少卿在中科大招生了!硕博都可,推免学生下周一紧急面试2025-09-20