今年TRAE写的代码:100000000000行!超50%程序员每天在按Tab键

TRAE年度产品报告

金磊 发自 凹非寺

量子位 | 公众号 QbitAI

2025年的最后几天,TRAE发布了个重磅的——

年度产品报告,正式出炉。

映入眼帘的一组吸睛数据,是这样的:

TRAE在一年里写了1000亿行代码!

什么概念?

如果按照一个程序员每天写100行有效代码计算,这相当于300万个程序员不吃不喝、没日没夜干了一整年。

而这也仅仅是《TRAE 2025年度产品报告》中的冰山一角,更多有意思的数据还包括:

- 超过50%的用户,每天都在高频使用Tab键(Cue行间补全功能)

- 全球用户超600万,月活突破160万,插旗近200个国家和地区

- 仅仅半年时间,Token消耗量暴涨700%

- 有6000名“肝帝”用户,全年写代码天数超过了200天

- 国际版付费用户周均活跃超6天,几乎是自然周全勤

- ……

数据不会撒谎。

当我们在争论AI会不会取代程序员时,TRAE已经悄悄在中国AI IDE赛道跑出了第一的身位。

带着这份报告,我们扒开了TRAE在AI Coding领域狂飙突进的底牌。

谁在用,怎么用?

在深入技术细节之前,我们先看一个最真实的现象。

如果你现在的开发环境里装了TRAE,你可能已经养成了这样一个习惯:

手指悬在Tab键上的时间,比放在其他任何键位都要长。

报告显示,Cue(行间补全)功能已经成为程序员最高频的肌肉记忆。

- 超过50%的用户每天主动使用Cue

- Cue累计推荐代码近10亿次,且采纳率提升了80%

这意味着什么?

在互联网产品方法论里,有一个著名的50%渗透率拐点:当一项AI功能的渗透率超过50%,且保持极高的日活粘性时,它就标志着整个行业已经跨过了尝鲜和辅助工具的初级门槛,正式进入了人机共生的阶段。

AI不再是那个偶尔帮你写个正则表达式的小助手,它开始懂你的意图,懂你的逻辑,甚至在你还没想好变量名的时候,就已经把函数体写好了。

但真正的质变,还得看TRAE的SOLO模式(Agent自主编程)。

如果说Cue是让你少打字,那么SOLO就是让你更省心。

报告披露了一个增长曲线:SOLO模式在中国版上线后,问答规模瞬间增长了7300%!

以前我们用AI来编程可能更像是打补丁,哪里不会点哪里:写个排序算法,查个API文档。但现在,AI编程工具则是全托管的姿态。

用户不再满足于让AI写两行代码,而是开始通过SOLO模式、通过MCP(Model Context Protocol,目前已支持1.1万个),以及各种Agent,让AI去操作浏览器、管理数据库、执行极其复杂的端到端任务。

由此,开发者本身的角色定位也在发生着改变:从写代码的人(Coder),变成了指挥写代码的人(Commander)。

这种变化在核心用户身上体现得尤为极致。

报告中特别提到了6000名全年写代码超200天的硬核用户。数据显示,超过半数的用户在使用过程中会主动进行上下文管理(使用 #file, #code 等标签)。

这说明什么?说明用户不再把AI当成一个只会回答百科全书的傻瓜,而是主动把项目的深层逻辑、业务文档、代码结构喂给AI。

一言蔽之,TRAE的核心用户正在把AI能力带入项目的核心地带。

那么接下来的一个问题就是:TRAE凭什么能接住这么复杂的需求?

从插件到自主Agent

回看TRAE的进化史,你会发现一条清晰的三阶段进化论。

第一阶段,TRAE 1.0(插件+IDE时代)。

这时候的TRAE,更多是像一个好用的插件。它深度集成了AI,提供了问答、代码生成、智能补全。这算是AI Coding的古典时代,解决了从无到有的问题。

第二阶段,TRAE 2.0(SOLO Beta时代)。

推出了SOLO模式的Beta版。这时候,TRAE开始像是有了独立人格,被称为The First Context Engineer。它集成了编辑器、终端、浏览器,试图打通从构思到落地的链路。

第三阶段,TRAE 3.0(SOLO 正式版)。

这是目前的完全体。TRAE把自己定义为The Responsive Coding Agent。

注意这个词:Responsive(响应式)。

它不仅仅是被动回答你的问题,而是以AI为主导,主动理解目标、承接上下文、调度工具,独立推进开发任务。

这种能力的底气,来自于硬核的技术指标。

在公认的AI编程能力评测榜单SWE-bench Verified中,TRAE拿下了全球第一。

但这还不是全部。

如果你以为TRAE只是字节跳动做的一个产品组装,那你就太小看这家公司的技术积淀了。

报告显示,2025年,TRAE在NeurIPS、ACL、ICSE、FSE、ASE等CCF-A类国际顶会上发表了10余篇AI Coding相关的学术论文,其中还有一篇入选了NeurIPS Spotlight。

除此之外,他们还把trae-agent开源了,在GitHub上斩获了10.2k Stars,合入社区PR 191个。

不只是快,还是“稳、准、省”

在AI编程的下半场,竞争的焦点正在发生转移。

上半场大家比的是能不能生成代码,看谁的模型参数大,看谁的Demo更炫酷。

下半场大家比的是能不能在低延迟、低内存下,稳定地生成代码。

对于每天要写很多行代码的工程师来说,延迟降低100毫秒,比模型参数多100亿更重要。

TRAE的年度报告里,罗列了一组极具含金量的工程指标:

- 补全延迟降低了60%+。

- 客户端首Token耗时降低了86%。

- 内存占用降低了43%(Windows设备评测)。

- 网络错误数减少60%,补全成功率达到了恐怖的99.93%。

这些数据或许不够有直接的体感,但却是支撑大规模复杂项目开发的生命线。

试想一下,如果你的IDE每写几行代码就卡顿一下,或者跑着跑着内存溢出崩了,模型再聪明你也会把它卸载。

谁能把SOTA模型塞进有限的内存里?谁能在弱网环境下保证代码补全的毫秒级响应?

这些看不见的内功,才是TRAE能留住600万用户的真正原因。

中国AI IDE领域领先者

最后,我们来聊聊格局。

2025年,注定是AI Coding历史上一个特殊的年份。它是一个拐点,标志着AI从工具迈向了协作者。

在这个节点上,TRAE的这份报告,实际上是无形中展示了一波领先地位。

它是中国AI IDE领域的领先者,这一点已经没有争议。

- 规模上:600万全球用户,160万月活。

- 速度上:一年迭代超过100次。

加之SWE-bench Verified全球第一的成绩,也是在侧面对其能力上的印证。

更重要的是路径的选择。

不同于海外GitHub Copilot早期的单点增强路线(即主要作为IDE的一个插件存在),TRAE一开始就走了一条更重的路:

以SOLO + MCP + 多智能体构建端到端AI开发操作系统。

它不满足于只做VScode里的一个插件,它想做的是下一代的开发环境本身。

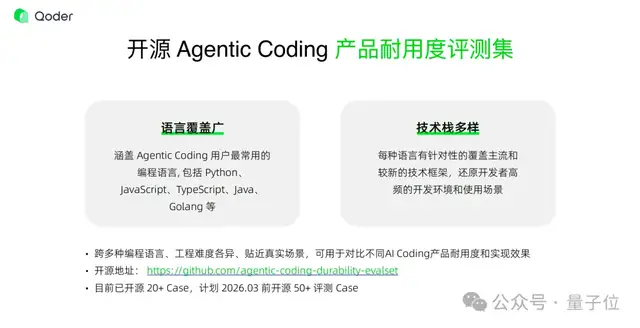

通过实用技术回馈社区,通过130+场线下活动和8个官方社群连接开发者,通过顶级学术会议输出技术标准。TRAE正在构建一个“开源+社区+学术”的三位一体生态。

这或许就是定义下一代开发者生态的标准模板。

当别人还在知乎上讨论“程序员会不会失业”时,全球600万TRAE用户已经用行动给出了回答。

他们发起了6000万个会话,发送了5亿条Query,消耗了无数的Token,最终产出了那1000亿行代码。

他们没有被AI取代,他们变得更强了。

正如报告最后所言:

我们一起,把代码写得更好。

TRAE年度产品报告地址:

https://mp.weixin.qq.com/s/8kdnWsxO3gKk8dzYJnqzJg

- 单卡2秒生成一个视频!清华联手生数开源TurboDiffusion,视频DeepSeek时刻来了2025-12-25

- 用编程大模型登顶开源第一后,智谱GLM团队被拷问了3小时2025-12-25

- 摩尔线程的野心,不藏了2025-12-21

- 行啊AI PC!现在都能隔空测血压、检测皮肤了2025-12-18