给GPT-2加上“人类偏好”补丁,它说的话就越来越有人情味了丨代码已开源

GPT-2文案工作室成立了,只要加65000个标签,甲方爸爸要啥写啥(滑稽)

郭一璞 发自 凹非寺

量子位 报道 | 公众号 QbitAI

OpenAI家的知名语言模型GPT-2,现在越来越“会说话”了。

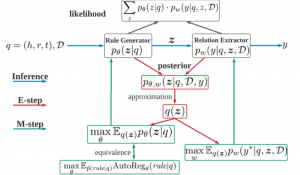

774M参数的GPT-2模型,学习了人类为它编制的一共有65000个带有人类偏好的标签,微调后,学会了两个“投其所好”的新技能:

一个是按照特定要求续写,甚至写出“神转折”的句子;

另一个是写文章的摘要。

这个更新受到热烈欢迎,有人已经迫不及待的想让GPT-2充当文案,开始接活写文章了。

甚至,还有人跟OpenAI打趣:

你这条公布更新的推特,是不是GPT-2自己写的?

续写

按照特定要求来续写,只需要补充5000个人类偏好标签。

一种是让GPT-2完成情绪上的要求,比如把原本严肃的文本,续写成积极的情绪。

比如这段文本,看起来是个老爹训孩子的场景:

“我是不是警告过他们了,欧文?”

“是的,爸爸,”欧文机械的回答。“我听到你警告他们了。”

“那格特鲁德和孩子们呢?”杰森追问不休。

文中这个叫杰森的爸爸,看起来实在是很凶的样子,要怎么把这么一段追问转折成一个积极的场景呢?

没有学习过人类偏好标签的原始GPT-2是这样子续写:

“我不知道。我只知道我们必须得走了,”欧文说。

好像欧文这个当儿子的还是一样机械冷静,一点都不积极啊?

再看学过人类偏好标签的升级版GPT-2,简直是个暖男:

“他们见到我很开心。我对他们很自豪。我们都这么觉得。”

前一秒好像还是老爹要找格特鲁德算账,下一秒就变成了亲密的一家人,顿时就积极向上、充满温情,简直神转折。

再看另一种,让GPT-2完成具体描述,比如针对物理实体进行描述,也就是语文老师说的“写实的手法”:

看这段对“菜地”的描述:

我们穿过了通往房顶的门道。这里,我们在一个非常潮湿的玻璃结构里。地板上有长长的木槽,里面种着很多健康的植物。我马上认出了西红柿、甜瓜、生菜、青豆和无数种其他植物。

没有学习过人类偏好标签的原始GPT-2是这样子续写:

我意识到储存在木槽中的食物都是以我能感到最远的距离收获的。

这个……算了,GPT-2一直都是这么抽象,不理他了,来看升级版:

空气中充满了泥土的芬芳,而且空气好像被冷却了一样。

“泥土的芬芳”、“冷却”都是对物理环境的详细描述,及格了。

前面的两个案例,无论是让GPT-2从情感维度还是从描述维度创作,用到的人类偏好标签都是同一波。

从结果上看,OpenAI给出的官方数据是学习过人类偏好标签的升级版GPT-2,在这两类任务上分别有88%和86%的次数比原始版给出的续写要好。

写摘要

另外的一个技能是写摘要,完整这个技能需要60000个人类偏好标签。

OpenAI用两种任务来考验这个升级版的GPT-2:

一个是给CNN和《每日邮报》这种正经媒体的文章写摘要;

另一个是给Reddit的文本片段写摘要。

先来看给正经媒体写出来的摘要,原文写的是关于让人开心/不开心因素,列举了让主角Janet Street-Porter不开心的一些要素。

Zero-Shot和有监督两种情况下,未经过微调和经过微调的摘要分别如下:

可以看出,Zero-Shot baseline给出的结果离题万里,借助人类偏好标签微调后效果好一些;有监督的baseline相对好一些,经过微调后看起来就很正儿八经了。

而Reddit的原文,描述的是说服朋友空气阻力对物体下降速度的影响。

四种情况的摘要分别如下:

Baseline依然非常离谱,而加了人类标签偏好微调后,基本就把前面那段话的意义表述出来了。

最后,为了从数据上说明,OpenAI还找这些文本的原作者,来评价AI们生成的摘要是否准确。

从原作者评价来看,经过微调后的模型生成效果让原作者们更为认可。

传送门

OpenAI官方介绍博客:

https://openai.com/blog/fine-tuning-gpt-2/

论文:

Fine-Tuning Language Models from Human Preferences

Daniel M. Ziegler, Nisan Stiennon, Jeffrey Wu, Tom B. Brown, Alec Radford, Dario Amodei, Paul Christiano, Geoffrey Irving

https://arxiv.org/abs/1909.08593

GitHub:

https://github.com/openai/lm-human-preferences

- MEET2020 | 百度景鲲:AI交互正在吃掉旧产品边界,触达移动互联网盲区用户2019-12-10

- MEET2020 | 王砚峰揭秘搜狗AI技术体系:自然交互在左,知识计算在右,核心是语言2019-12-16

- MEET2020 | 旷视唐文斌:你到底给谁创造了什么样的价值?这是AI产品的灵魂拷问2019-12-17

- MEET2020 | 快手刘霁:AI基础能力决定每个公司AI的迭代和落地效率2019-12-20