这个人什么时候才能拿图灵奖?

十三 发自 凹非寺

量子位 报道 | 公众号 QbitAI

Jürgen Schmidhuber配不上一个图灵奖?

△LSTM之父,Jürgen Schmidhuber

图灵奖进入“提名期”,一个被多年争论的话题再次被抛出。

Jürgen Schmidhuber,LSTM之父,同样对如今AI复兴和发展意义深远。甚至最新论文引用数已经超过了——反向传播。

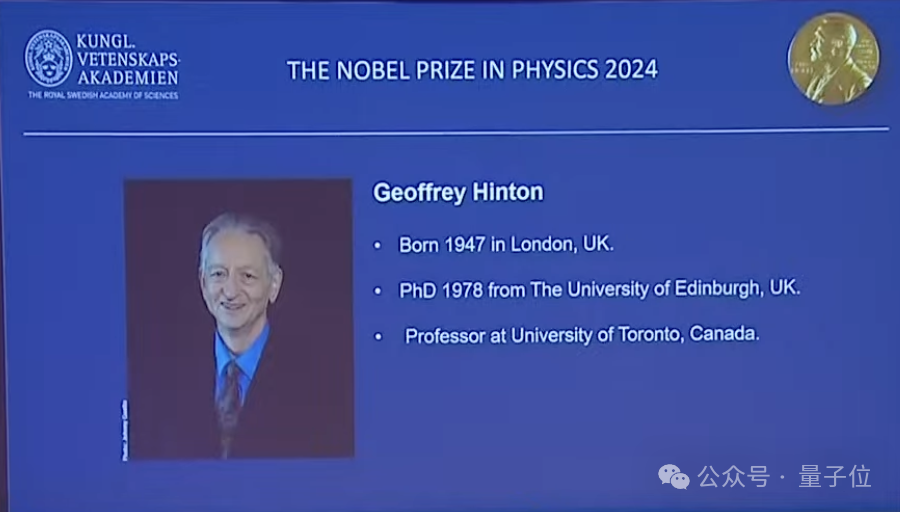

没错,就是去年斩获图灵奖的深度学习三巨头——Yoshua Bengio、Geoffrey Hinton、Yann LeCun——的核心理论成果。

ACM主席Cherri M. Pancake还评价说:

人工智能的发展很大程度上归功于这三人奠定基础的深度学习的新进展。

其实就在当时,就有人质疑,为啥LSTM之父Jürgen Schmidhuber没有得到同样嘉奖?

为什么图灵奖没有颁给LSTM之父Jürgen Schmidhuber?

而再过3个月,即将迎来一年一度的图灵奖颁奖时刻。

今天,这一话题又被炒了起来。

Reddit网友发帖称,建议今年的图灵奖颁给Jürgen Schmidhuber。

话题一出,便引起了网友们的热烈讨论。

有人持赞同观点,有人却觉得不配。

那么,到底是怎么一回事呢?

Jürgen Schmidhuber配得上图灵奖?

正方观点

许多人认为图灵奖委员会在去年犯了一个错误——没有提名Jürgen Schmidhuber。

即使在有关“三巨头获得图灵奖”最火的Reddit帖子里,评论最多的还是与Jürgen相关的内容。

https://www.reddit.com/r/MachineLearning/comments/b63l98/n_hinton_lecun_bengio_receive_acm_turing_award/

为此,“忿不平”的网友为了给他加油打气,写了一首LSTM之歌。

网友断定,2020年的图灵奖会让他更加兴奋。

2019年没有获得图灵奖,有可能是因为没有足够好的人脉,也有人说他是局外人。我们应该做些草根运动,呼吁那些“社会公认的成员”为他提名。

还列举了Jürgen不少该拿奖的“证据”。

1、Jürgen Schmidhuber在1990年真的创造了GAN,但当时他将其称之为curiosity。这其实是一个非常著名的研究,GAN只是其中的一个简单应用。而Yoshua因为一个Jürgen早他几十年发明的理论而获得了图灵奖,这真是可笑又悲哀。

2、Jürgen Schmidhuber团队的DanNet在 AlexNet之前赢得了4次图像识别挑战,以及还赢得了 ICDAR 2011中文手写、IJCNN 2011交通标志、ISBI 2012大脑分割、ICPR 2012癌症检测等挑战。DanNet 可以说是2011年的“超人 CNN”。

3、Geoff Hinton 主要的5篇深度学习论文没有引用Jürgen Schmidhuber早期的类似工作。

反方观点

当然,帖子下方评论中持反对观点的网友也有不少。

他确实值得拥有一个奖项。但不能因为同一个贡献而再拿图灵奖。

还有拿这件事开玩笑的网友。

老实说,在这个节骨眼上,我们应该开设一个Schmidhuber奖。我是半开玩笑的。读了这位老兄的论文和笔记,我觉得他不是一个有远见的人。

想象一下,Hinton、Bengio和LeCun获得了第一个Schmidhuber奖。

开创Schmidhuber奖,奖励那些在自己领域做出开创性贡献,但从未获奖或被他人抢走奖项的人。

“是我的开创性工作”

其实,Jürgen Schmidhuber本人也是有些愤愤不平。

近些年,他常常因为“自己的开创性工作没得到足够的尊重”这类激烈的表达,引起世界的瞩目。

所以,这里先描述一下,LSTM是怎样一项开创性的工作。

就像歌里唱的那样,LSTM是长短期记忆的简称,和人脑的记忆有些类似。

它是一种特殊的循环神经网络 (RNN) ,最初在1997年发表。那么,特殊在哪里呢?

普通RNN是能把先前学到的信息,用到现下的任务里;但距离越远的信息,就越难关联起来。引用Christopher Colah博客里的例子:

预测“the clouds are in the sky”里最后一个词“sky”的话,不太需要联系上下文;

如果要预测“I grew up in France… I speak fluent French”里的“French”,普通RNN知道该填一种语言,但不太容易联系到“France”这个遥远信息了。

而LSTM就是为了解决这个问题而生的。它和普通RNN的区别是:

普通RNN的循环部分只有一层 (tanh) ,只依状态h的改变而改变,所以对短期的输入敏感:

△普通RNN,来自Colah博客

而LSTM的循环部分,又加入了c状态,保存长期状态。于是,循环部分变成了4层,来决定短期状态到底对长期剧情产生多大的影响。

△LSTM,来自Colah博客

这样,LSTM就可以学习更长的序列了。一个长期困扰学界的问题,便是这样解决的。

1997年发表的那篇论文,作者是Schmidhuber和他的学生Hochreiter 。

后来,LSTM被多方发扬光大,如今已是机器学习领域不可缺少的方法了。

可这门技术越是重要,Schmidhuber越是觉得,自己没有得到足够的重视。

毕竟,机器学习三巨头早已名满天下,而他的名号远不及这几位的响亮。

远离宇宙中心的他,在瑞士南部提契诺州卢加诺区曼诺的达勒·莫尔AI研究所 (IDSIA) ,担任联合主任。

2015年,为了纪念人工智能60周年,三巨头合写了一篇深度学习综述,发表在Nature上。

正当大家仔细品读的时候,这篇文章收到了来自Schmidhuber的反对:

他列出了九条问题,批评三巨头的综述没有足够尊重前人的成果。

比如,没有提到Alexey Ivakhnenko,他和小伙伴们在1965年发表了世界上第一个有效的深度学习网络。

比如,写到反向传播 (BP) 的时候,只引用他们自己的论文,和少数几篇其他论文,忽略了60年代早期Bryson等人的论文,后来的BP就是从那时的成果发展来的。

比如,没有提及Schmidhuber本人在RNN上面的工作。

很快,三巨头中的LeCun回怼了远在欧洲的同行。主要理由是,比起那些给出想法的人,更大的功勋应该属于把想法用到机器学习上的人:

1986年以前,有很多人早就用过链式法则了,也有很多人发现,multi-step function里可以把雅可比矩阵反向乘在一起。

但能不能说高斯、莱布尼茨、牛顿、拉格朗日都发明了反向传播?

不!他们并没有把这个想法用到机器学习上,没有实现。

LeCun说,很多人也想过用链式法则训练一台机器,但反向传播直到80年代才真正发明出来。

他还说:

Juergen太想得到认可了,把各种东西都说成是他的功劳,好多并不是他该得的。

这就导致每场talk之后他都要站出来,把别人刚刚展示的东西说成他自己的,提出的方式还常常不太礼貌。

LSTM之父与三巨头的对立面,就形成了。

当三巨头一起拿下图灵奖,吃瓜的众人又想起了这场有趣的战斗,盖起了一座楼,又一座楼。

LSTM登顶20世纪AI论文高引No.1

然而,就在前不久,一件有趣的事情发生了——经典被经典超越。

20世纪深度学习研究中,引用最多的论文不再是反向传播。

而正是Hochreiter和Schmidhuber发表的LSTM。

而反向传播,相关的论文虽然不少,但都不再比LSTM高:

如果只算一年,比如刚刚结束的2019年,根据Google Scholar的结果,DE Rumelhart、GE Hinton、RJ Williams三人组的两篇反向传播论文,去年一整年的引用量加起来足足有3085次。

但新宠LSTM被引用了6750次。

超过前者的两倍。

那么问题来了。

你觉得LSTM之父——Jürgen Schmidhuber,今年有望获得图灵奖吗?

One More Thing

Jürgen Schmidhuber徒子徒孙众多,其中较为出名的还是与其合作LSTM的Sepp Hochreiter。

△Sepp Hochreiter

Sepp Hochreiter,原名Josef Hochreiter,是一位德国计算机科学家。2006年至2018年领导奥地利林茨大学 生物信息学研究所,之后又领导了机器学习研究所。

2017年,他成为林茨理工学院人工智能实验室的负责人,该实验室致力于推进人工智能的研究。此前,他曾在柏林工业大学、科罗拉多大学博尔德分校和慕尼黑工业大学工作。

他和Jürgen Schmidhuber共同完成的LSTM被认为是机器学习中的一个里程碑。

传送门

Reddit讨论:

https://www.reddit.com/r/MachineLearning/comments/eivtmq/d_nominate_jurgen_schmidhuber_for_the_2020_turing/

https://www.reddit.com/r/MachineLearning/comments/eg8mmn/d_the_1997_lstm_paper_by_hochreiter_schmidhuber/

参考链接

Colah的博客:

http://colah.github.io/posts/2015-08-Understanding-LSTMs/

维基百科

https://en.wikipedia.org/wiki/Sepp_Hochreiter

- 这么哇塞的世界模型,竟然是开源的!2026-01-29

- 机器人看不清,蚂蚁给治好了2026-01-27

- 蚂蚁具身智能明牌了:做大脑,和宇树们错位竞争2026-01-28

- 曦望发布推理GPU S3:All-in推理的国产GPU,开始算单位Token成本2026-01-27