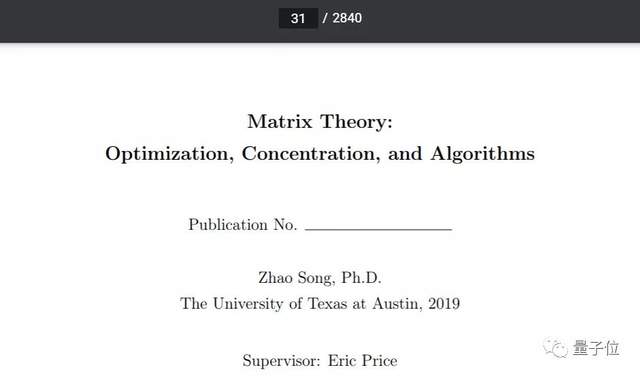

2840页的计算机毕业论文,德州奥斯汀华人博士究竟写了啥

目录就有31页

萧箫 发自 凹非寺

量子位 报道 | 公众号 QbitAI

单是目录就有31页,以及论文共有2840页。

你没看错,这就是来自德克萨斯大学奥斯汀分校的一篇计算机科学系博士毕业论文。

说实话,计算机系的教材都没有编写得这么厚……

那么,这篇毕业论文到底都写了啥?

3个角度,研究矩阵理论

这篇论文,主要从三个角度,对机器学习、理论计算科学中的矩阵理论进行了研究。

其中,包括矩阵在优化算法中的作用、随机矩阵中的集中不等式(Concentration inequality)、以及针对矩阵开发的新算法。

首先,是针对优化算法的研究。作者介绍了自己在线性规划中,对现有矩阵乘法理论进行研究后,提出的一种新算法。

这种算法突破了停滞三十年的研究,可以被应用于经验风险最小化等优化问题上。

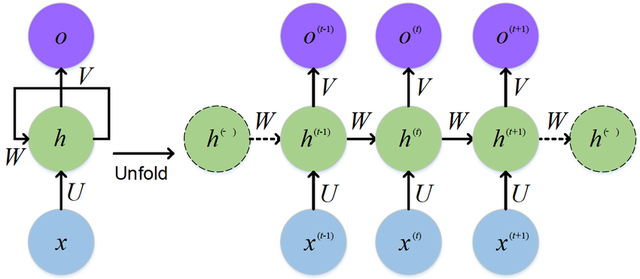

算法以外,作者还对深度神经网络中的优化算法进行了研究,证明了为什么随机梯度下降(SGD)可以在多项式时间内神经网络的训练目标上找到全局最小值。

而这项理论研究的成果,同样适用于递归神经网络(RNN)。

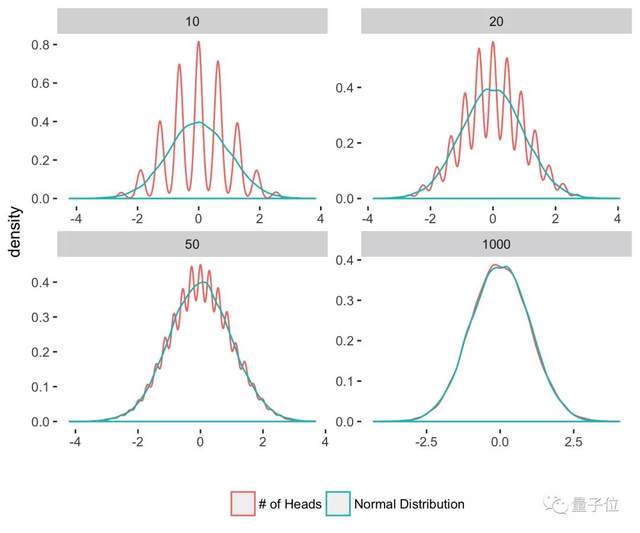

其次,是针对随机矩阵中的集中不等式的研究。

事实上,随机矩阵也是陶哲轩当年做出代表性研究的领域之一,在压缩感知上有着重要应用。

作者主要研究了随机矩阵中的切尔诺夫边界,进一步给出了许多关于它的新应用。

此外,作者还研究了差异定理(Discrepancy theory)中的斯宾塞理论(Spencer’s theorem),并将研究成果推广到了卡迪森-辛格问题中。

最后,作者针对矩阵问题提出了一些新的算法。

这些问题,大致可以分成矩阵分解问题、和结构重建问题两类。第一类算法,主要是关于低秩矩阵分解的问题;第二类算法,则主要针对结构化矩阵提出的一些重构问题。

例如,作者针对压缩感知算法设计了相应的矩阵、算法,并给出了针对傅里叶变换的快速算法。

“有输入才会有输出”

理论研究之外,作者还腾出了1页附录,给刚开始读博的小伙伴写了一点话。

他表示,自己曾经多次想退出读博生涯,但最后还是坚持下来了,积累了一些经验。

例如,每次开会时,他都习惯用LaTeX记下各种观点、理论,进行复盘。

复盘时如果发现错误,就找出错误的原因,并记录细节。他认为,记录探索中遇到的问题,能为做出真正的成果提供灵感。

此外,作者还表示,自己一开始曾经抱着“解决某个问题”的心态去写论文,结果三个月后,不但问题没解决,心态还崩了。

他的朋友建议他选修一些课程,在里面找论文灵感。果然,在上完课后,他的第一篇博士论文也出来了,心态也恢复了平静。

因此,他现在仍然保持着多看论文、持续输入的状态。如果有顶会论文放出,他会将每篇都快速过一遍,筛选有用的论文仔细阅读。

最后,作者表示,不要放弃和任何领域的人交流的机会。对于协作者想要研究的领域,他也愿意一同进行探索。

关于这篇博士论文

论文作者Zhao Song,博士毕业于德克萨斯大学奥斯汀分校计算机科学系,本科毕业于西蒙菲沙大学。此前,他曾经是哈佛大学的访问学者,也在IBM研究中心实习过。

在读博期间,他的研究方向是机器学习、理论计算科学和数学,感兴趣的方向包括深度学习理论、对抗样本、傅里叶变换等。

当然,之所以这些研究成果,能写成2840页的论文,也离不开在Zhao Song在读博期间一起进行研究的合作者。

这里面,加上与他讨论观点、交流理论的学者,名字列表就几乎有5页:

而且这里面,还不完全包括那些,在他读博生涯中帮助过他的人。

例如,在他写毕业论文期间,曾经受到过好些朋友的帮助。不过,这些朋友不愿意加入作者名单,他便一同写进了致谢。

网友:就当编教材了

论文出来后,有网友调侃,如果想将论文写长点,还可以试试拆词。例如“Don’t”,就可以拆分为“Do not”……

也有网友表示,这篇论文的长度,已经快赶上编教材了。(说不定整理一下,真能出书)

不过,既然论文这么长,肯定也写了不少时间。估计校对一遍都不容易……

也有网友表示,想看看这篇2840页的论文,就当读书了。

(需要论文的同学,可以通过下方地址直接下载)

论文地址:

https://repositories.lib.utexas.edu/bitstream/handle/2152/80715/SONG-DISSERTATION-2019.pdf

参考链接:

https://m.weibo.cn/status/4596597743167116

https://www.ias.edu/scholars/zhao-song

https://simons.berkeley.edu/people/zhao-song

- 首个GPT-4驱动的人形机器人!无需编程+零样本学习,还可根据口头反馈调整行为2023-12-13

- IDC霍锦洁:AI PC将颠覆性变革PC产业2023-12-08

- AI视觉字谜爆火!梦露转180°秒变爱因斯坦,英伟达高级AI科学家:近期最酷的扩散模型2023-12-03

- 苹果大模型最大动作:开源M芯专用ML框架,能跑70亿大模型2023-12-07