如何让机器说话更像人?清华和京东的三位大牛给出答案 | CCF C³

CCF第一期C³活动

金磊 梦晨 发自 凹非寺

量子位 报道 | 公众号 QbitA

顾客:“我想给父母买一台电视。”

客服:“您好,这一款可能会适合您的需求(附带商品链接)。”

顾客:“看着不错,但价格好贵啊。”

客服:“因为如果是老年人的话,更加推荐4K超清大屏。”

顾客:“感谢推荐。”

客服:“感谢询问,若有问题随时找我。”

……

随着电商、网购的普及,诸如上述的场景,相信大多数人都或多或少地经历过。

能够根据客户的问题,如此熟练作答的背后,却很可能不是人,而是AI。

然而,当问题变得复杂、棘手之时,这种对话AI有时却显得不够智能,往往也因此被客户诟病。

近日,由中国计算机学会(CCF)主办、京东承办的第一期CCF C3活动,在京东集团总部如期举行。

近30位CCF CTO Club成员和特邀嘉宾参与了此次活动,就“智能客服”这一主题进行了分享和讨论。

那么针对这一话题,学界和产业界的大牛,又会擦出怎样的火花?

下一代的对话系统,又该何去何从?

何晓冬:不仅要响应请求,还要做到情感陪护

对于产业界来讲,智能对话机器人或系统,发展现状又是如何?

针对这一问题,京东集团副总裁何晓冬带来了《多模态智能交互技术打造有温暖的智能客服体验》的主题演讲。

△CCF企工委副主任、TF主席、京东集团副总裁,何晓冬

何晓冬介绍道,近几年,在特定领域对话与交互系统中,出现了许多应用,例如京东智能客服、微软小冰、亚马逊智能音箱等等。

而早在2018年,谷歌发布的Duplex电话AI,一度被认为通过了图灵测试。

但后来却被外媒曝光25%是由人工打出;而在通过自动系统打的电话中,约有15%会需要人工干预。

对此,何晓冬直言道:

对话AI距离通过图灵测试还有一段距离。

若是要达到这一“理想状态”,难点和挑战又是什么?

何晓冬认为:

对话机器人不仅需要响应用户的请求,完成任务,还需要满足用户对沟通和情感的需求,与用户建立情感联系。

为此,何晓冬提出了“多模态人机对话与交互技术”。

具体而言,包括三大层:

- 基础技术层:词法句法分析、语义分析、知识构建、知识推理等;

- 核心能力层:语言理解、NLP、多伦对话和跨模态交互;

- 应用层:交互式主动营销导购、智能情感客服、机器阅读理解与问答等。

在这种模式下,以“情感分析”为例,基于迁移学习、反向翻译、噪声处理等技术,AI可以在与客户对话过程中,识别客户的情绪变化,使得满意度提升了58%。

但与此同时,何晓冬也对“多模态智能对话与交互”提出了五大难点,包括复杂场景下的多轮对话与决策技术、知识获取与推理、深度语义理解、对话内容生成和多模态交互技术。

……

这便是智能对话系统在产业界的现状与痛点,那么在学界,又有哪些进步与难点呢?

黄民烈:下一代对话系统

△清华大学计算机系长聘副教授,黄民烈

接下来,来自清华大学智能技术与系统实验室的黄民烈教授,从研究的角度分享了对话系统的现状、挑战和未来趋势。

黄民烈将下一代对话系统定义为“社交聊天机器人”。他认为,传统对话系统有三大问题。

- 对语义的理解不准确,经常答非所问。

- 在对话中展现的身份、个性不一致,难以获得人类用户的信任。

- 与人类交互中会有社会伦理方面的问题,无法理解其给出的答复中存在的道理、伦理风险,对可能产生的风险视而不见。

针对以上问题,下一代对话系统应该结合任务导向型对话系统中的强语义方法,与弱语义的开放域对话系统中端到端框架,使之能够scalable,并且做到有知识、有个性、有温度。

对话系统要与结构化的知识相结合,把知识加入到对自然语言的编码和解码过程中,在对话交互中做到言之有物。

与此同时,赋予对话系统固定的外在的身份特征,和内在的性格特征,在对话中展现出一致性。并根据这些特征选择适合的语言风格,做到拟人化,体现出人性化的特征。

还提出情绪对话生成模型,可以让对话系统能表达喜怒哀乐。同时又借鉴了心理咨询的理论和方法,使对话系统有情感、有温度,能进行情绪支持和社交支持。

最后,黄民烈提到现在以GPT3为代表的语言模型,训练参数和使用的非结构化数据已达到千亿规模,但仅以大模型和大数据还不能做好对话系统。未来下一代的对话系统一定是在一个scalable的框架中融合强语义方法,才能做到有知识、有个性、有温度。

刘知远:知识指导的预训练语言模型

△清华大学计算机系副教授,刘知远

来自清华大学的刘知远教授的报告聚焦于技术层面,具体介绍了如何将语义化的知识引入预训练语言模型,解决智能客服技术中存在的问题。

预训练语言模型是2018年左右NLP领域的出现的新突破。

其优势是突破了人工标记的数据难以大量获取的限制。可充分利用大量互联网上不断产生的为标记数据进行预训练,再辅以少量有标记数据进行微调。

预训练语言模型虽在GLUE测试中的表现已超过人类基准,但对语言的理解还停留在浅层。刘知远老师认为,预训练语言模型的进一步发展需要将知识图谱与深度学习两大技术相结合。

具体做法有:

知识增强:将知识引入到预训练模型的输入阶段,与文本的输入相配合

知识支撑:用多个知识适配器将不同类型的知识(如语言学层面的知识和事实层面的知识)统合到模型中。

知识约束:在输出阶段加入知识有关的任务,优化目标的同时,将抽取出来的知识返哺到知识图谱中。

刘知远表示未来的研究方向之一将是深化知识的层级,从实体知识中抽象出概念性的知识。

最后,刘知远介绍了与黄民烈老师及多方团队合作在北京智源研究院算力支持下开发的中文预训练语言模型“清源CPM”。该项目已在GitHub上开源,感兴趣的话可以扫描下图二维码获取。

刘知远老师还将研究其研究成果整理出版成中英文书籍,其中《Representation Learning》这本书可以免费获取!传送门在文章末尾。

关于CCF CTO Club和C3活动

CCF C3活动是CCF CTO Club发起的,面向企业技术专家的热门技术和战略分享会。

在此次活动中,CCF副理事长周明在开场致辞过程中,官宣了C3活动的LOGO及其含义:

- CCF CTO Club首字母:覆盖领域(Computer, Communication and Control);

- 目标:Connection, Culture and Continuum;

- 怎么搞好:Capability,Creativity and Colorfulness。

△ CCF副理事长、 创新工场首席科学家,周明

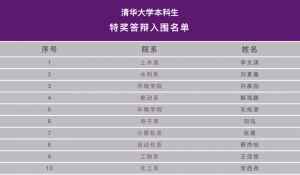

周明希望第一期的C3活动,在10年20年后,也为计算产业发展培养国之栋梁,为我们计算机产业更好更强做出贡献。

传送门:

[1]清源CPM:https://cpm.baai.ac.cn

[2]《Representation Learning》:https://arxiv.org/pdf/2102.03732.pdf

- 这么哇塞的世界模型,竟然是开源的!2026-01-29

- 机器人看不清,蚂蚁给治好了2026-01-27

- 蚂蚁具身智能明牌了:做大脑,和宇树们错位竞争2026-01-28

- 曦望发布推理GPU S3:All-in推理的国产GPU,开始算单位Token成本2026-01-27