替换一下同义词,AI就把句子意思弄反了|华人研究者揭示NLP模型脆弱性

赖可 发自 凹非寺

量子位 报道 | 公众号 QbitAI

骗过AI如此简单。

换了一个同义词,自然语言处理模型就读不对句子的意思了。

麻省理工和香港大学的研究生们开发了一个算法,让AI在文本分类和推理问题上的正确率从80%下降到10%。

测试原理

这个模型的名字叫Textfooler,通过生经过微调的句子,来对自然语言文本分类和推理进行攻击。

比如在著名的分类任务影评判断中,AI的任务是去判断一句影评是肯定性的还是否定性的。

像这句:

The characters, cast in impossibly contrived situations, are totally estranged from reality.(剧中的人物,被安排在不可能情境之中,与现实完全脱节。)

Textfooler模型生成的对应句子是:

The characters, cast in impossibly engineered circumstances, are fully estranged from reality.

将contrived situation改为了engineered circumstance,totally 改为fully。

结果AI将第一个句子标记为“负面”,第二个句子标记为“正面“。

在推理任务中,AI需要判断在一个句子和情境之间的关系,是蕴含,中立,还是矛盾。

比如给定一个前提:

Two small boys in blue soccer uniforms use a wooden set of steps to wash their hands.

两个穿着蓝色足球服的小男孩借助一套木制的台阶洗手。

需要判断这句话“The boys are in band uniforms.”(男孩们穿着乐队制服)和前提的关系。

AI会把这个句子判断为”矛盾”。

当把uniforms这个单词改为garments以后:The boys are in band garments。

AI 就会把句子判断为“蕴含”。

此外,研究团队还请人类被试阅读这些句子,以确认它新生成的句子和原句接近。

他们从进行实验的两个数据集MR dataset和WordLSTM中各挑100个例子,请被试行进行打分。相似为1,有歧义为0.5,不同为0,最后得到的分数分别为0.91和0.86。

这说明,调整后的句子对人类阅读影响很小。

各模型测试结果

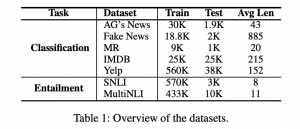

研究团队使用了三个模型,七个数据集来进行测试。

三个模型为:BERT,WordCNN,WordLSTM。

数据集:

△5个为分类数据集,2个为蕴含推理数据集

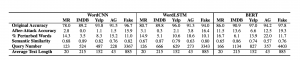

分类任务的测试结果如下:

所有的模型的原来的精确度都在78%以上,像BERT则表现更优秀,在两个数据集上都能达到97%的精确度。

但是经过Textfooler的攻击,精确度全部降到了20%以下。

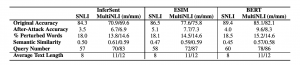

再来蕴含推理任务表现如何:

精确度从原来的80%降到了10%以下。

在实际应用中可能产生影响

处理文本的AI越来越多地被用来判断应聘者,评估医疗报销,处理法律文件。因此,研究者认为,AI的这一缺陷要引起重视。

如果用于金融或医疗保健中的自动化系统,即使是文本上微小变化,也可能造成很多麻烦。

加州大学欧文分校的助理教授Sameer Singh说,这个调整文本的方法“确实非常有效地为AI系统生成了良好的对手” 。

但是他又表示,这个方法在实践中很难实施,因为它涉及反复探测AI系统,这可能会引起怀疑。

加州大学伯克利分校的教授Dawn Song专门研究AI和安全性。她说,这一研究是不断发展的工作的一部分,该工作表明如何欺骗语言算法,并且各种商业系统可能容易受到某种形式的攻击。

看来,想读懂人话,AI还需继续努力呀。

研究团队

这项研究由清华大学、香港大学、新加坡科技研究院的研究员共同完成。通讯作者有两位:

△Di Jin

Di Jin,本科毕业于清华大学计算机学院。2020年获得MIT计算机科学博士学位。目前是MIT的计算机科学与人工智能实验室的助理研究员。

△金致静

金致静,高中毕业于上海华东师大二附,本科毕业于香港大学,目前正在申请博士学位。已经在顶级会议NAACL,EMNLP,AAHPM,AAAI上发表了4篇NLP论文。

github地址:

https://github.com/jind11/TextFooler

论文地址:

https://arxiv.org/pdf/1907.11932.pdf

参考链接:

https://www.wired.com/story/technique-uses-ai-fool-other-ais/

- 看「菊纹」,知疾病,这个智能马桶,知道你下半身的所有秘密2020-04-12

- 这拖拉机你能开算我输:美国少女“揭秘”现代拖拉机驾驶室2020-05-05

- 史上最大“云办公”实验开始,你参加了吗?2020-02-04

- 英伟达上线游戏云服务平台GeForce Now,每月4.99美元2020-02-05